Hugging Face 每周速递: 扩散模型课程完成中文翻译,有个据说可以教 ChatGPT 看图的模型开源了... |

您所在的位置:网站首页 › 1l柴油多少吨二氧化碳含量 › Hugging Face 每周速递: 扩散模型课程完成中文翻译,有个据说可以教 ChatGPT 看图的模型开源了... |

Hugging Face 每周速递: 扩散模型课程完成中文翻译,有个据说可以教 ChatGPT 看图的模型开源了...

|

每一周,我们的同事都会向社区的成员们发布一些关于 Hugging Face 相关的更新,包括我们的产品和平台更新、社区活动、学习资源和内容更新、开源库和模型更新等,我们将其称之为「Hugging News」。 产品更新 享用由 A100 GPU 强力支持的超快速机器学习推理

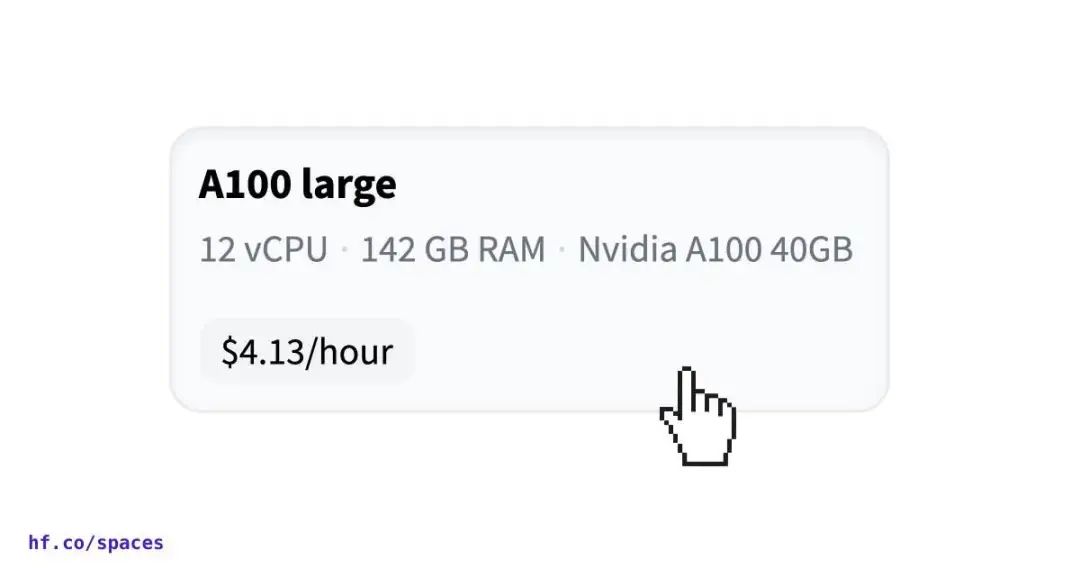

Hugging Face Spaces 现已支持使用 A100 GPU,用户享受超快速机器学习推理,自助开通的价格为每小时 4.13 美元,企业客户更可以享受更低的价格。此外,未来几个月,Spaces 还将提供更多用于机器学习的超酷硬件,如果您有特定的需求,可以给我们留言。 macOS 上的 Diffusers 应用现已发布 (而且还开源了)

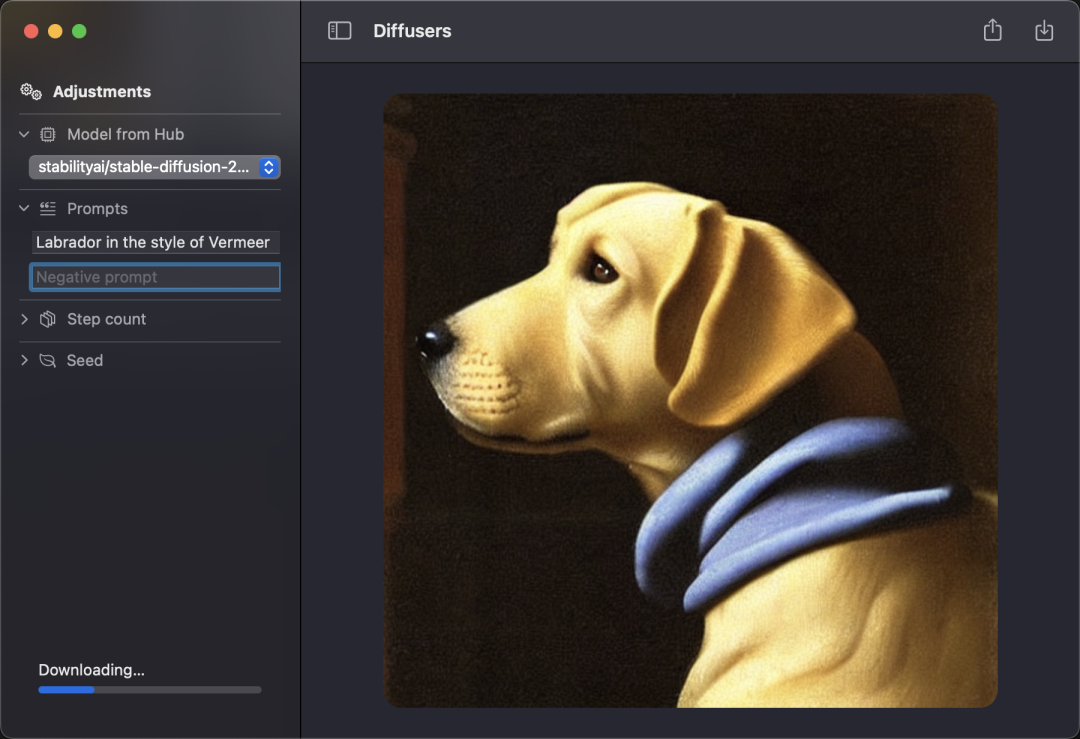

基于隐私保障设计,所有的图片都不联网而是在本地生成;可下载模型,这些模型都基于 CPU、GPU 和 Apple 的神经计算引擎 (ANE) 进行优化。 应用商店地址:https://apps.apple.com/app/diffusers/id1666309574 开源地址:https://github.com/huggingface/swift-coreml-diffusers 开源库更新 Transformers 大更新

Transformer 4.25 引入了 ImageProcessor,让用户能够利用更为强大的图像处理能力。同时,部分 API 也更加统一,参数配置项也改为使用 dict,更直观也更方便。 示例地址:https://github.com/huggingface/transformers/tree/main/examples/pytorch/image-classification 提名道德意识良好的 Space 应用

机器学习技术在今天的社会中发挥着越来越重要的作用,可以应用于各种领域,包括医疗、金融、社交媒体、自动驾驶等。然而,这些技术的应用也可能带来许多潜在的伦理和道德问题,比如数据隐私、算法歧视、社会影响等。因此,有必要关注和鼓励那些采用了伦理意识的机器学习项目,以确保这些项目符合社会的伦理标准和价值观。 为了展示和鼓励更好的机器学习实践,我们正在请社区的成员们提交提名那些在这方面做的很好的 Space 应用,我们正在找寻如下相关的项目: 🤝 征求同意: 有意识地征求相关方的同意,并尽可能提供透明度和选择权。 🌎 可持续的: 考虑其对环境和社会的影响,并采取措施减少其负面影响。 🗨️ 社会责任感: 考虑对社会的影响,并采取措施以最大程度地提高其社会价值。 🧑🤝🧑 具有包容性: 确保多元、平等与包容,采取措施确保其对不同背景和群体的用户和利益相关者具有包容性。 ✍️ 严谨性: 采用严谨的方法和流程,以确保项目的质量和有效性。 🤔 探索精神: 不断追求新的想法和解决方案,并持续优化和改进项目。 你可以在这里提名:http://hf.co/spaces/society-ethics/featured-spaces-submissions AI 与 AI 对抗赛

🤗 我们正在举办首场 AI 对阵 AI 的虚拟足球赛,你可以将自己的模型提交到 Hugging Face Hub 中,然后与其他队伍的作品展开一张 2v2 的足球较量赛。 首场挑战赛由 MLAgents 团队基于 Unity 引擎提供,我们会基于大家的反馈举办更多精彩的比赛。 快来加入我们的课程,并与来自世界各地的同学们踢一场精彩的 AI 球赛吧! 演示地址:https://hf.co/spaces/unity/ML-Agents-SoccerTwosA Deep RL 课程地址:https://hf.co/deep-rl-course/unit7/introduction 🤗 Accelerate 0.16.0 发布

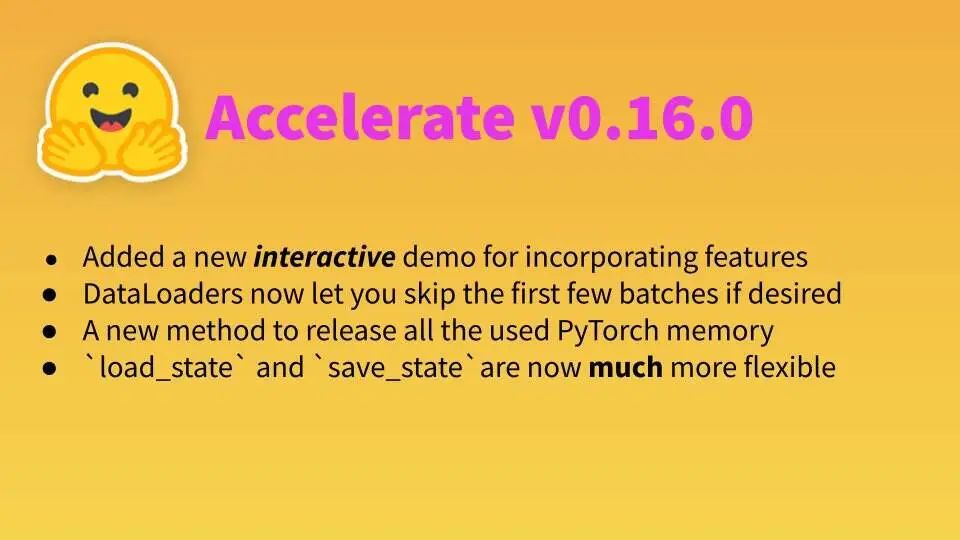

在这个版本中,我们提供了一款交互式配置 🤗 Accelerate 的在线小工具,帮助你快速上手。同时,当你在训练中需要跳过前几个批次的数据时,DataLoaders 现在提供了函数来直接实现。此外,我们还提供了 release_memory 函数辅助释放 PyTorch 占用的内存,以及更灵活的 load_state 与 save_state API。 交互式体验 🤗 Accelerate 文档链接:https://hf.co/docs/accelerate/usage_guides/explore 详细更新内容:https://github.com/huggingface/accelerate/releases/tag/v0.16.0 🤗 Hugging Face Hub 更易用了

现在,我们在模型查找页面增加了一个库 (library) 筛选的标签,这样你就能更快找到跟自己感兴趣的库相关的各种模型了! 模型页面地址:https://hf.co/models Tune-A-Video: 一镜成片的文字转语音模型

我们在 🤗 Hugging Face Spaces 汇总了不少优秀的 Tune-A-Video 模型,帮你轻松实现「一句话,让模型给我拍个片」。 🤗 Hugging Face Spaces 网址:https://hf.co/spaces/Tune-A-Video-library/Tune-A-Video-Training-UI 演示项目地址:https://hf.co/Tune-A-Video-library/a-man-is-surfing Tune-A-Video 库地址:https://hf.co/Tune-A-Video-library 学习资源 & 内容更新 扩散模型的最后一课已经发布!

Hugging Face 扩散模型课程的第四单元: 深入研究扩散模型已经发布,这是本课程的最后一个单元,在这个单元中,我们将探讨最新研究中出现的扩散模型的许多改进和扩展。它将比以往的单元代码更少,旨在为您提供进一步研究的起点。 在此前的推文里,我们发布了本课程的第一单元的 第一部分 和 第二部分。我们很高兴地通知大家,我们的抱抱脸本地化小组已经完成了这个课程的全部内容!我们也即将在随后的推文中陆续发布,欢迎关注我们。 Hugging Face ❤️ 计算机视觉

只是因为在人群中多看了你一眼,我们在计算机视觉上的投入只是从 21 年的这个 PR 开始 (huggingface/transformers#10950)。 但自去年开始,我们开始投入大量的精力投入到计算机视觉上。现如今,Hugging Face Hub 上已经有 8 个核心的计算机视觉任务、3000 多个模型和 100 多个数据集了! 我们写了篇博客介绍这些内容,不过你可以等等,我们的本地化小组的译者 AIboy1993 已经完成了这篇博客的中文版,下周就发推送 (争取不鸽)! 只是因为在人群中多看了你一眼 (PR 链接):https://github.com/huggingface/transformers/pull/10950 博客文章: The State of Computer Vision at Hugging Face 🤗:https://hf.co/blog/cv_state 除此之外,还有一篇关于计算机视觉和语言预训练的研究进展的博客文章 A Dive into Vision-Language Models,也已由我们本地化小组的 Matrix 同学完成了本地化,下周也将推送给大家。 博客文章: A Dive into Vision-Language Models:https://hf.co/blog/vision_language_pretraining 文字生成音频的 AudioLM 模型

现在,你可以在 🤗 Hugging Face Spaces 上体验 AudioLM 模型用文字描述生成相应音效的能力了。你只需要提供足够详细的描述,然后提交给模型进行处理即可。快去体验专属于你的独家音效吧! 🤗 Hugging Face Spaces:https://hf.co/spaces/haoheliu/audioldm-text-to-audio-generation 项目仓库:https://github.com/haoheliu/AudioLDM 可视化三种模型输出的结果

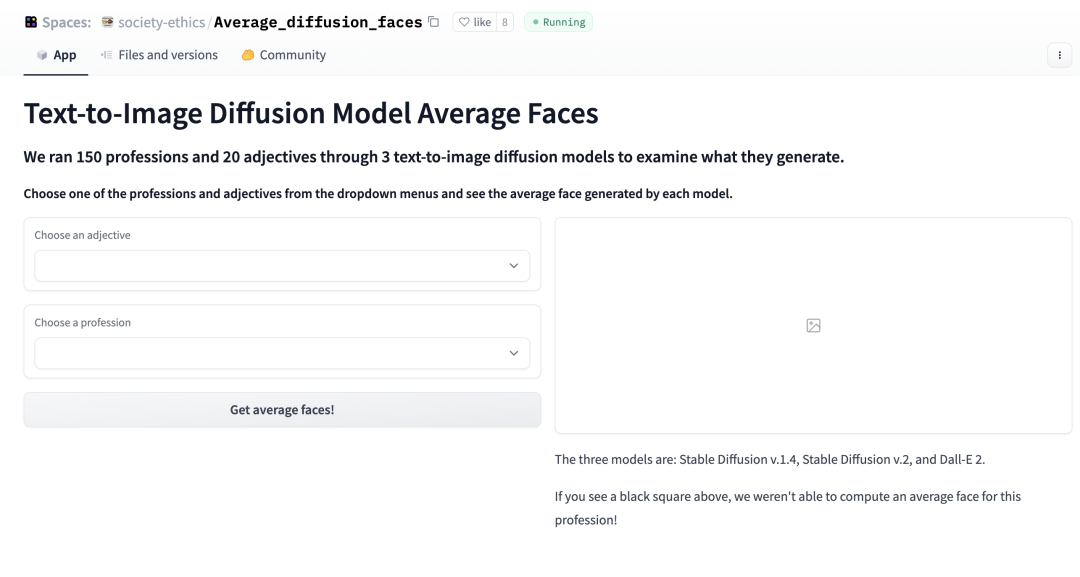

我们为大家提供了一款比较 Stable Diffusion v1.4、v2 和 Dall-E 2 执行文字生成图片结果的工具。你可以选择一个职业,及相应的形容词,然后对比它们三者生成的图片。 体验地址:https://hf.co/spaces/society-ethics/Average_diffusion_faces 看图对话的模型 BLIP-2 开源!

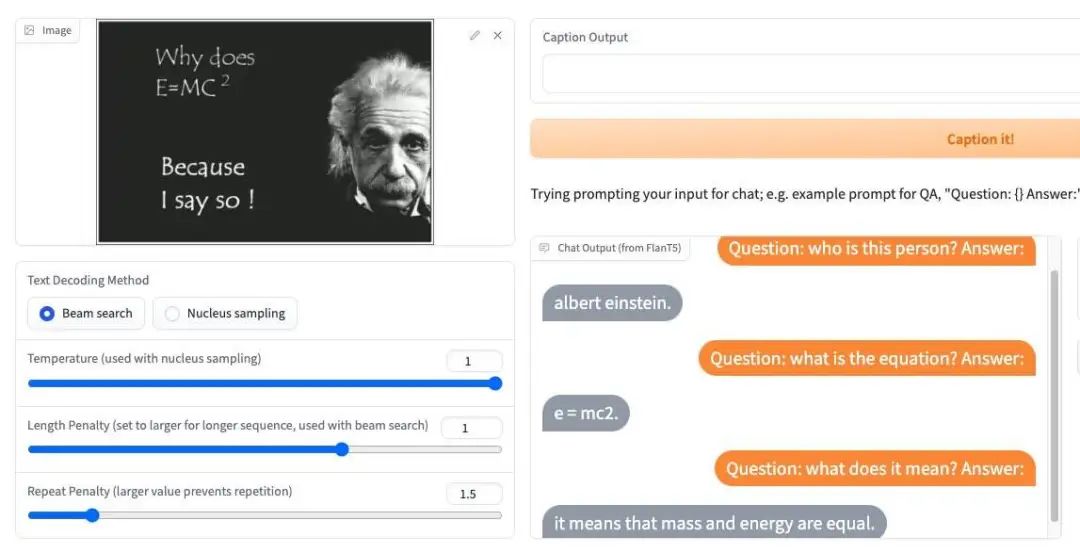

据说这可能是一个可以教 ChatGPT 看懂图片的大语言模型,BLIP-2 由 Salesforce Research 团队发布,你可以给他一张图片,然后针对图片里的内容跟 AI 进行对话。小编看了一些报道提到说 BLIP-2 可以「教会」让 ChatGPT 学会看图,真的有这么神奇吗? 快来官方的 Space 应用上试玩,找找灵感吧 (或许下一个爆火的就是它呢),点击阅读原文直达:https://hf.co/spaces/Salesforce/BLIP2BLIP-2 开源地址:https://github.com/salesforce/LAVIS/tree/main/projects/blip2 |

【本文地址】

今日新闻 |

推荐新闻 |