基于Swin transformer的蚊虫种类识别模型 |

您所在的位置:网站首页 › 蚊虫分类图片 › 基于Swin transformer的蚊虫种类识别模型 |

基于Swin transformer的蚊虫种类识别模型

|

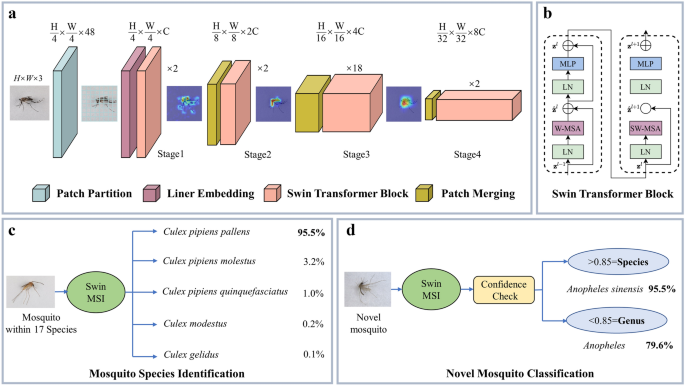

Swin MSI的框架

利用自构建的图像数据集和多次调整试验,建立了第一个基于Swin transformer的蚊种识别模型(Swin MSI)。使用梯度加权类激活映射来可视化识别过程(图2)。1a).关键的Swin Transformer块如图所示。1b.根据实际需要,增设Swin MSI,在亚种水平上对库蚊复合物进行鉴定(图。1c)和新型蚊子(在我们的数据集中定义为17种以上的蚊子)分类归因(图;1d).详细结果如下所示。 图1

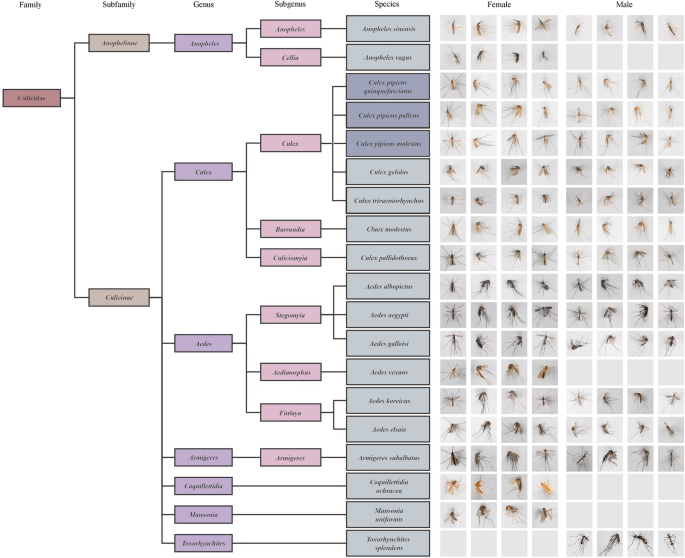

Swin MSI的框架。(一个蚊类特征提取与识别的基本体系结构。展示了每一层过滤器生成的注意力可视化。(b) Swin变压器块的详细信息。(c)在我们的数据集中17种蚊子中,输出的是前5个可信物种。(d)对于超过17种(定义为新种)的蚊子,通过与置信阈值比较来决定输出是种还是属。 全尺寸图像 蚊子的数据集我们建立了迄今为止最高清晰度和最平衡的蚊子图像数据集。蚊类图像集涵盖7属17种(包括3个形态相似的亚种)残雪。侵害其中涵盖了全球范围内最常见和最重要的传播疾病的蚊子,总共有9,900张蚊子图像。图像分辨率为4464 × 2976像素。具体的分类状态和对应的图像如图所示。2.由于野外采集的局限性,Ae。vexans,Coquillettidia ochracea,Mansonia均匀化,一个。迷走神经而且巨蚊splendens只有女性或者只有男性。此外,为了平衡训练集的容量和种类,每一种蚊子都包含了300张两性的图像,这对于每一种蚊子来说都足够大,数量相同。 图2

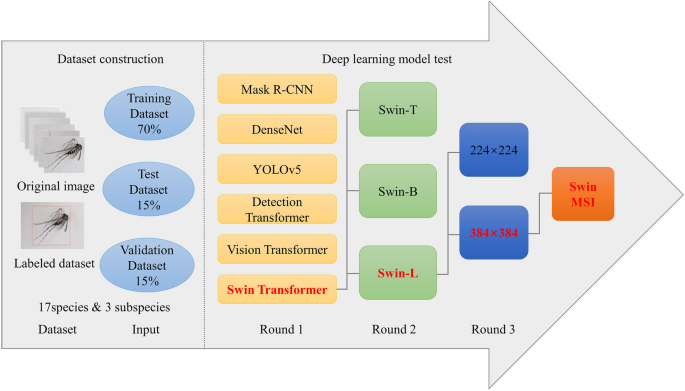

本研究蚊虫种类分类状况及指数对雄蚊和雌蚊分别从背侧、左侧、右侧、腹侧等不同角度进行拍摄。除5种蚊子外,每只蚊子包含300张两性图像,蚊子照片分辨率为4464 × 2976。残雪。这种致倦侵害,残雪。侵害pallens,残雪。侵害molestus(亚种水平,在深灰色背景)中有3个亚种残雪。侵害复杂(物种级)。 全尺寸图像 蚊种鉴定工作流程采用构建最佳深度学习模型以识别蚊虫种类模型的三阶段流程图(图2)。3.).第一个学习阶段由三个cnn (Mask R-CNN、DenseNet和YOLOv5)和三个变压器模型(Detection transformer、Vision transformer和Swin transformer)进行。在第一阶段模型的性能和真实蚊子标签的基础上,第二阶段学习调整三种Swin Transformer变体(T, B, L)的模型参数,比较它们的性能。第三个学习阶段包括测试输入不同大小的图像(384 × 384和224 × 224)到Swin Transformer-L模型的效果;最后,我们提出了一种用于蚊子种类识别的深度学习模型(Swin MSI)来测试不同蚊子种类的识别效果。该模型在不同蚊种上进行了验证,重点研究了三种亚种的识别精度残雪。侵害新型蚊种的检测效果与复配。 图3

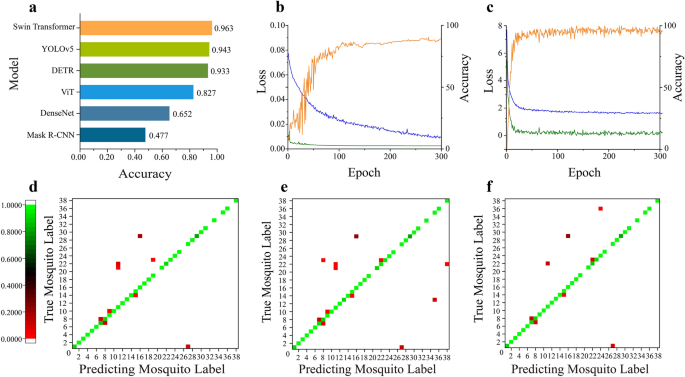

蚊种智能识别深度学习模型测试流程图。 全尺寸图像 CNN模型与Transformer模型结果比较(第一轮学习)数字4A显示了在蚊子图片测试集上测试的六种不同计算机视觉网络模型所获得的准确性。实验结果表明,变压器网络模型比CNN具有更高的蚊虫种类识别能力。 图4

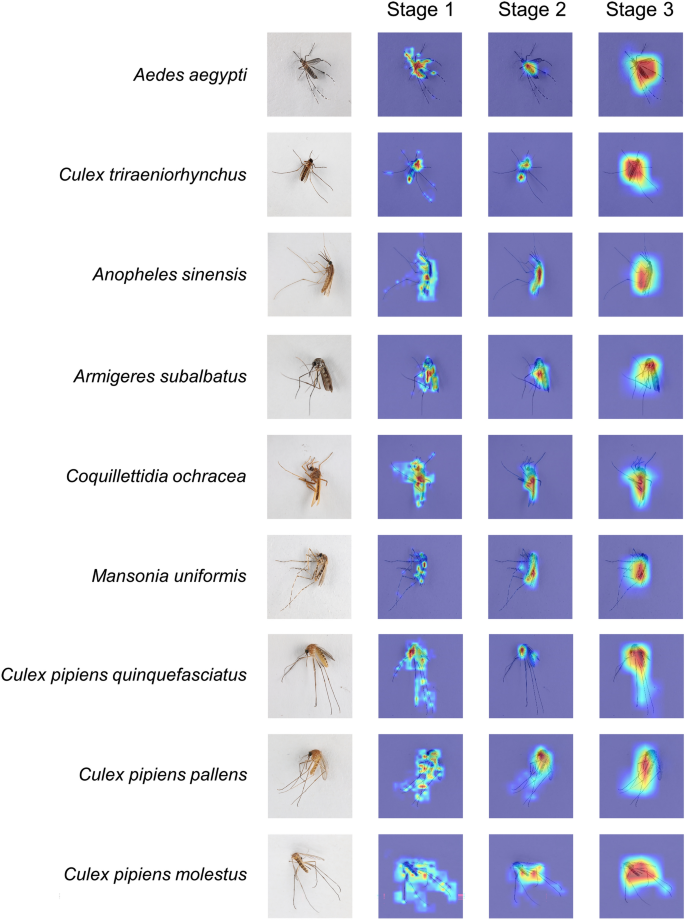

计算机视觉网络模型与变异体蚊虫识别效果比较。(一个) 3个cnn与3个Transformer蚊虫识别准确率的比较;(b)最佳效果CNN (YOLOv5)训练集损失曲线(蓝色)、验证集损失曲线(绿色)和验证集精度曲线(橙色);(c)最佳效果变压器(Swin Transformer)训练集损耗曲线、验证集损耗曲线和验证集精度曲线。(d) Swin-MSI-T测试结果混淆矩阵;(e) Swin-MSI -B测试结果混淆矩阵;(f) Swin-MSI -L测试结果混淆矩阵。蚊子标签的混淆矩阵,其中奇数代表雌性,偶数代表雄性。混淆矩阵中的小方块表示识别就绪率,从红色到绿色,识别就绪率越来越高一个。中国: 1、2;残雪。这种致倦侵害: 3,4;残雪。侵害pallens: 5,6;残雪。侵害molestus: 7、8残雪。modestus: 9、10;Ae。蚊: 11、12Ae。蚊: 13,14;残雪。pallidothorax: 15,16Ae。galloisi: 17日18Ae。vexans: 19,20;Ae。koreicus: 21、22骑士的扈从subalbatus: 23, 24;Coquillettidia ochracea: 25,26残雪。gelidus: 27,28残雪。triraeniorhynchus: 29、30Mansonia均匀化: 31,32一个。迷走神经: 33,34Ae。elsaie: 35、36巨蚊splendens: 37, 38。 全尺寸图像在CNN训练过程中(应用于YOLOv5),验证精度需要超过110个epoch才能增长到0.9,验证损失需要110个epoch才能下降到平坦区间;相比之下,在训练步骤中,这些损失是一个不断减少的过程。这些结果表明,基于Swin Transformer算法推导出的深度学习模型在迭代过程中比CNN的快速收敛能力在更短的时间内获得更高的识别精度(图2)。4b)。 Swin Transformer模型的测试精度最高,达到96.3%。在训练过程中,该模型的损失在30个epoch后趋于稳定,在20个epoch后验证精度提高到0.9;在验证步骤中,损失在20个epoch后可以下降到0.36,之后损失曲线波动,但没有产生不利影响(图。4c).基于Swin Transformer模型的优异性能,以该模型为基准进行后续分析。 Swin Transformer模型变体调整(第二轮学习)在进行测试以明确Swin Transformer算法的优越性能之后,我们选择了不同的Drop_path_rate、Embed_dim和depth参数设置,并将参数集标记为Swin Transformer- t、Swin Transformer- b和Swin Transformer- l变体。Drop_path是一种高效的正则化方法,当使用图像分类任务和Transformer架构时,非对称Drop_path_rate有利于监督表示学习。Embed_dim参数表示输入的红-绿-蓝(RGB)图像由阶段1中的Swin Transformer块计算后得到的图像尺寸。深度参数是四个阶段中使用的Swin Transformer块的数量。参数信息及试验结果见表1.由于阶段3中Swin Transformer块和Embed_dim参数的增加,三个变体的识别准确率分别为95.8%、96.3%和98.2%,对应的f1分数分别为96.2%、96.7%和98.3%;因此,这些变体可以以类似于CNN的方式有效提高蚊子种类的识别能力,增加卷积通道的数量,提取更多的特征,提高整体分类能力。在本研究中,Swin Transformer-L变体表现出最高的精度,被选为下一步工作的基线。 表1三种型号Swin变压器的参数及试验精度。 全尺寸表通过绘制使用三个Swin Transformer变体得到的测试集结果的混淆矩阵,我们清楚地获得了每个类别中正确和错误识别的比例,以直观地反映蚊子的物种识别能力(图2)。4d-f)。在矩阵中,对角线颜色越深,对应蚊子类别的识别率准确率越高。其中,有五种蚊子失踪Ae。vexans,Coquillettidia ochracea,Mansonia均匀化,一个。迷走神经而且巨蚊splendens数据集中的物种仅由雌性或雄性代表。图C所示的混淆矩阵列出了每个类别中蚊种识别误差点的最低数量和最低精度水平,表明Swin Transformer-L模型的分类性能优于Swin Transformer-T和Swin Transformer-B模型。 输入图像大小对辨别能力的影响(第三轮学习)为了研究输入图像尺寸与蚊虫种类识别性能之间的关系,本研究基于Swin Transformer-L模型,对尺寸为224 × 224和384 × 384的输入图像进行了对比测试,识别出8类蚊虫种类识别精度的差异。试验结果如表所示2.当使用图像大小为224 × 224像素时,batch_size参数设置为16,当使用图像大小为384 × 384像素时,batch_size参数设置为4;在此条件下,显存利用率为67%,如式。4,这与Swin Transformer模型在使用384 × 384像素图像时,自注意操作大小之间的关系描述一致。Transformer-L模型完成所有训练会话所需的时间过多,达到了126小时,甚至超过了YOLOv5模型所需的124小时,在本工作中发现YOLOv5模型在训练过程中需要的计算时间最高。长期的训练过程可以更充分地反映模型之间的性能差异。幸运的是,模型的响应速度并不会受到训练时间的影响。基于Swin Transformer-L模型的384 × 384输入图像尺寸的蚊种识别准确率为99.04%,与224 × 224输入图像尺寸的98.2%相比,提高了0.84%。 $ $ \ω({\文本{W}} -{\文本{MSA}}) = 4{\文本{中国}}^{2}+ 2{\文本{M}} ^{2}{\文本{中国}}$ $ (1) 表2不同输入图像大小的识别精度比较。 全尺寸表 可视化和理解Swin MSI模型为了研究Swin MSI和分类学家用于蚊子种类识别的注意特征的差异,我们应用梯度- cam方法对不同阶段的Swin MSI注意区域进行可视化。由于Swin Transformer在不同阶段的多头自注意步骤中有不同的注意范围,在不同的蚊子位置上可以发现不同的注意权重。在阶段1中,每个patch的特征维数为4 × 4 × C,使得Swin Transformer的多头自注意机制能够更多地关注蚊子的腿部、翅膀、触角和pronota等细节部位。在阶段2中,每个patch的特征维数为8 × 8 × 2C,使得Swin Transformer的多头自注意机制能够聚焦于蚊子的头部、胸部和腹部等身体。在阶段3中,当每个patch的特征维数为16 × 16 × 4C时,Swin Transformer的多头自注意机制可以聚焦蚊虫的大部分区域,从而形成每个蚊虫的全局整体注意机制(图3)。5).这种注意力集中的过程本质上与分类学家在对蚊子形态进行分类时所使用的过程相同,从细节到位置再到整个蚊子。 图5

注意该属代表性蚊的可视化Ae。,残雪。,一个。,骑士的扈从,Coquillettidia而且Mansonia.这是用于识别图像中可以解释分类过程的区域的可视化。的图片巨蚊只含雄性,形态特征差异明显,未显示。 全尺寸图像Ae。蚊广泛分布于全球热带和亚热带地区,可传播寨卡病毒、登革热和黄热病。本种最重要的形态识别特征是中胚层肩背两侧有一对长柄镰刀状白斑,并有一对纵条纹贯穿整个中胚层。该特征是注意力可视化中最深的部分,表明Swin MSI模型也将其视为主要的区分特征。此外,腹部的背牙龈埃及伊蚊为黑色,节段II-VII侧面有银白色斑点和基部白色条带;该模型也关注这些领域。 残雪。triraeniorhynchus是日本脑炎的主要病媒;这种蚊子的体型很小,喙上有一个独特的白色环(它最独特的形态特征),全身呈胡椒色。同样,本文所构建的模型同时关注该物种的头部和腹部区域。 一个。中国是中国疟疾的主要媒介,在其前翼缘有不超过3个白点,在其边缘V5.2边缘有一个明显的白点;这一特征在阶段2中观察到,此时模型强烈聚焦于相应的区域。 的最明显的特征骑士的扈从subalbatus是其喙部的横向扁平和略微向下弯曲;注意可视化观察表明,所构建的模型集中在阶段1到阶段3的这些区域。与长鼻相比,腹膜和腹膜不重要,对识别的重要性较小,注意力可视化结果相应地表明,神经网络对这些特征的关注较少。 Coquillettidia ochracea属于Coquillettidia属,全身金黄,腹部最明显。该模型显示该物种在腹部具有一致的形态学分类重点。 Mansonia均匀化是马来丝虫病的传播媒介。腹背为深褐色,腹节II-VII段末端带黄色,侧边有白色斑点,比吻部的深褐色特征更为明显。通过注意可视化,我们确定Swin MSI模型更关注腹部区域特征而不是长鼻特征。 蚊虫亚种级鉴定试验尖音库蚊复杂的细粒度图像分类一直是计算机视觉领域广泛研究的焦点25,26.基于本文构建的三个亚种的测试集(包含270张图像)残雪。侵害采用Swin MSI模型时,亚种和性别鉴定准确率均为100%。 形态特征残雪。这种致倦侵害,残雪。侵害pallens,残雪。侵害molestus在残雪。侵害复合体几乎难以区分,但它们的寄主偏好、自育性、繁殖环境和停滞越冬策略都非常不同27.在现有的可用于形态分类的特征中,腹背上的条纹残雪。这种致倦侵害通常是倒三角形,与胸骨不相连,而残雪。侵害pallens矩形,与胸骨相连。残雪。侵害molestus形态上更相似吗残雪。侵害pallens作为一种生态亚种残雪。侵害复杂。然而,分类学家不建议使用上述不稳定特征作为主要的分类学特征进行分化。通过分析这三个亚种的注意可视化结果(图的最后三行)。5),我们发现的神经网络残雪。这种致倦侵害,残雪。侵害pallens,残雪。侵害molestus仍然集中在腹部区域,如暗红色所示。这些神经网络的焦点区域与人眼不同,本研究的结果表明,Swin MSI模型可以检测到这三种蚊子亚种之间肉眼无法区分的细颗粒状特征。 新型蚊子分类归因在我们对数据集中成功识别的蚊子图像进行置信度检查后,发现最低置信度值为85%。置信度阈值越高,评价标准越严格,越能反映模型的强大性能。因此,将0.85作为判定新蚊的置信阈值。在鉴定10种未知蚊种时,最高衍生种置信度低于85%;当结果输出到属水平时(图;1d),获得正确判断的平均概率为96.26%的准确率和98.09%的F1-score(表3.).这些图像经过测试是新颖的Ae。,残雪。而且一个。蚊子来自Minakshi和Couret等人。28,29. 表3新物种正确归属概率。 全尺寸表 |

【本文地址】

今日新闻 |

推荐新闻 |