全网最细图解知识蒸馏(涉及知识点:知识蒸馏实现代码,知识蒸馏训练过程,推理过程,蒸馏温度,蒸馏损失函数) |

您所在的位置:网站首页 › 物理3-4知识框架怎么画图解图片 › 全网最细图解知识蒸馏(涉及知识点:知识蒸馏实现代码,知识蒸馏训练过程,推理过程,蒸馏温度,蒸馏损失函数) |

全网最细图解知识蒸馏(涉及知识点:知识蒸馏实现代码,知识蒸馏训练过程,推理过程,蒸馏温度,蒸馏损失函数)

|

目录

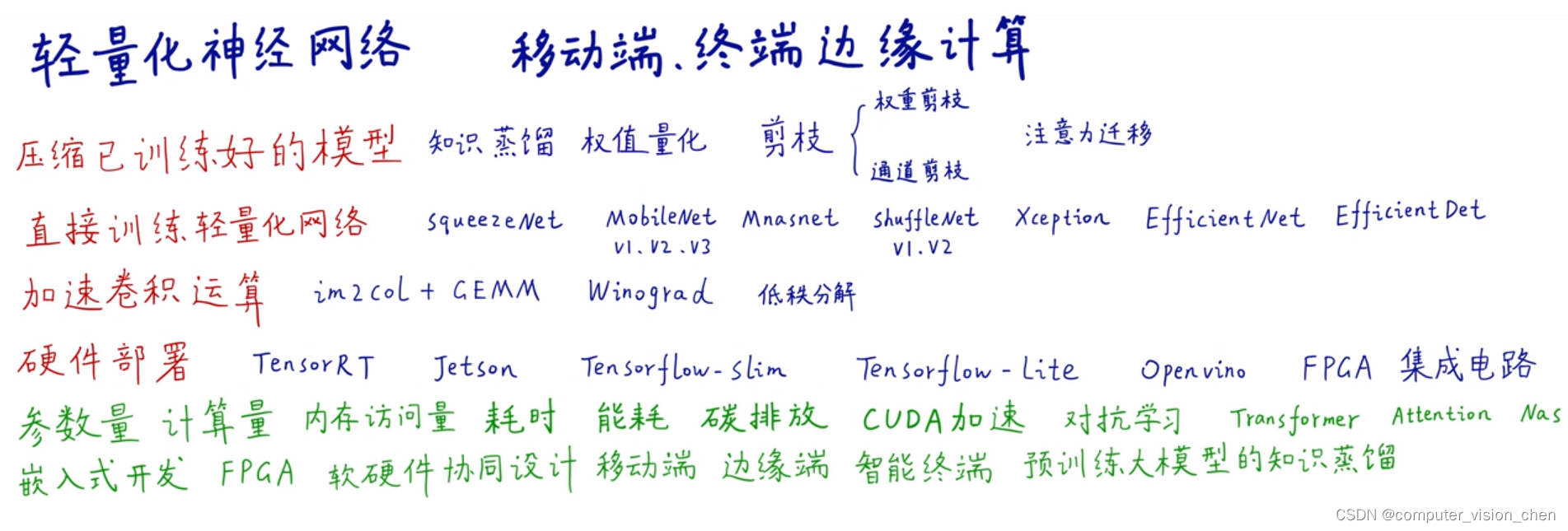

一.是什么?二.为什么要用知识蒸馏把大模型学习到的东西迁移到小模型呢呢?2.1 轻量化网络的方向

三.用蒸馏温度处理学生网络的标签3.1 soft target3.2 用教师网络预测出的soft target作为学生网络的标签。3.3 蒸馏温度3.4为什么要加入蒸馏温度T让softmax的结果更平滑?

四.知识蒸馏训练过程4.1 图示知识蒸馏训练过程4.2 损失函数4.3 图解损失函数计算过程

五.推理过程六.最终效果:1.零样本识别2.使用soft target训练而不是hard target,减少了过拟合

七.迁移学习和知识蒸馏的区别八.知识蒸馏实现代码九.参考视频

一.是什么?

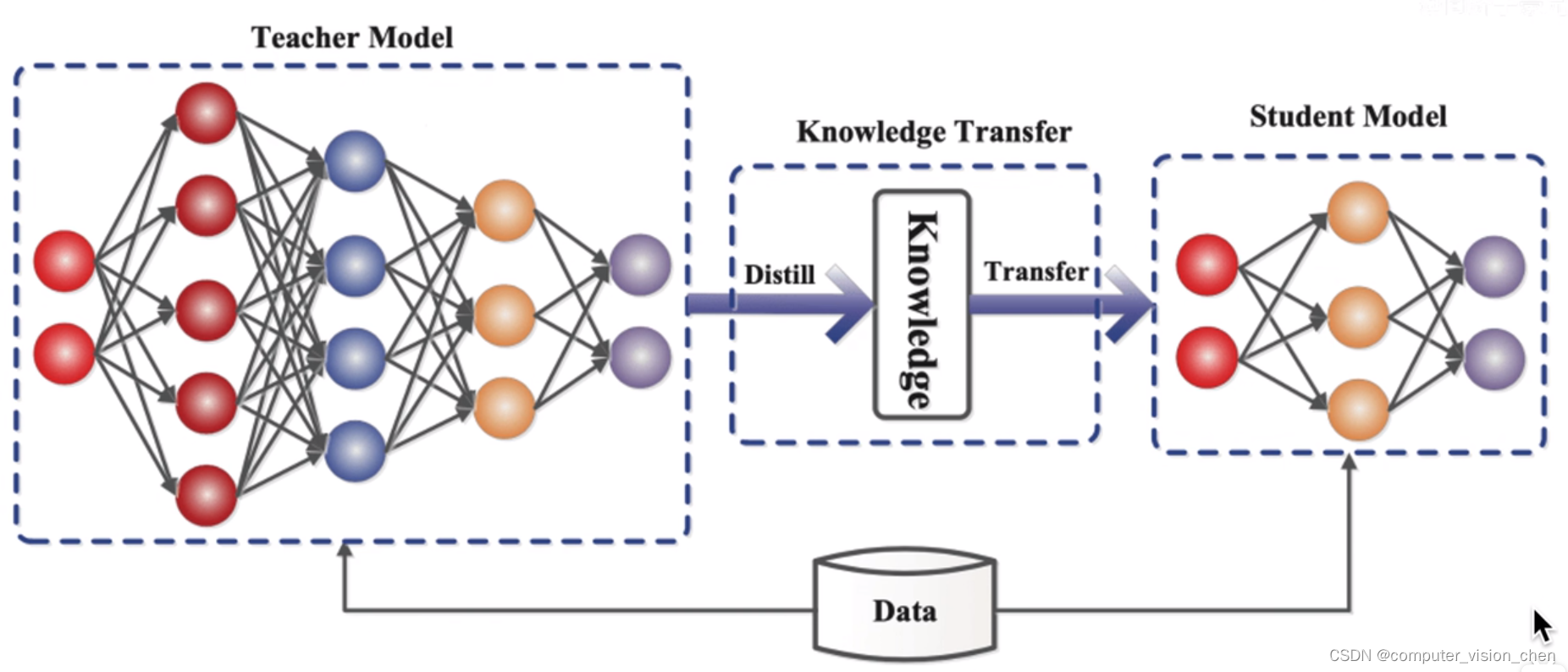

把一个大的模型(定义为教师模型)萃取,蒸馏,把它浓缩到小的模型(定义为学生模型)。

即:大的神经网络把他的知识教给了小的神经网络。

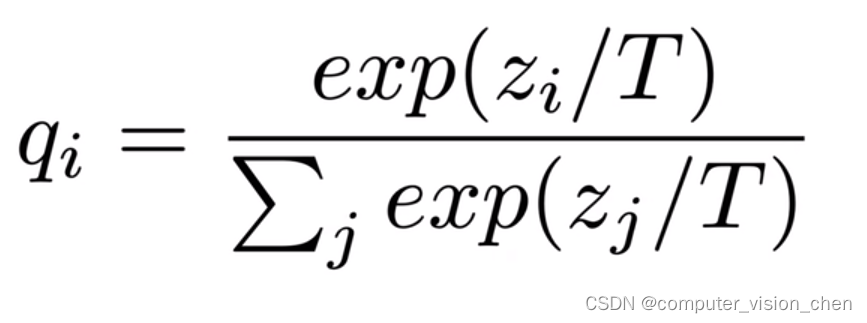

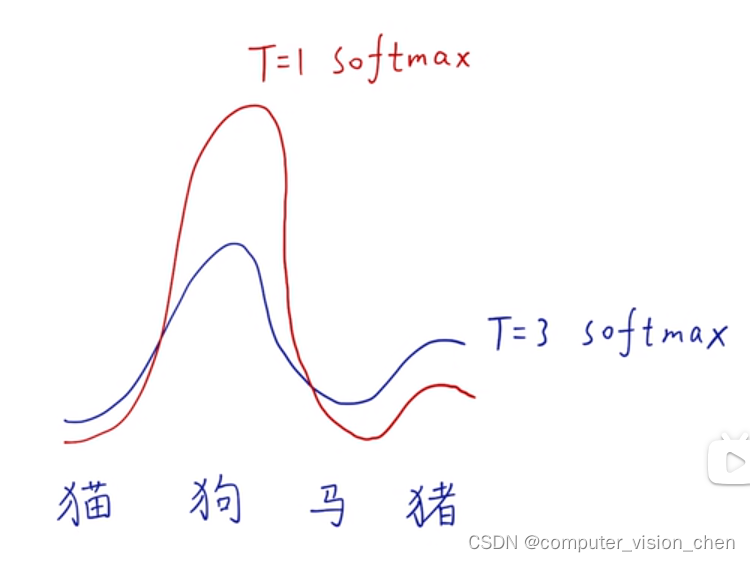

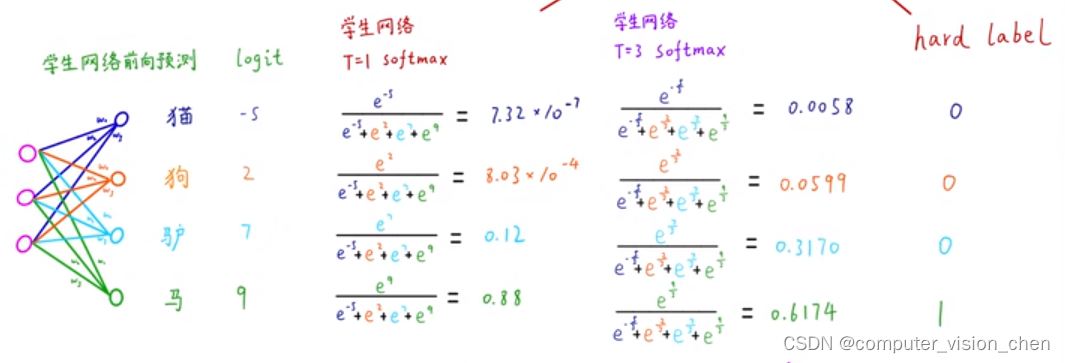

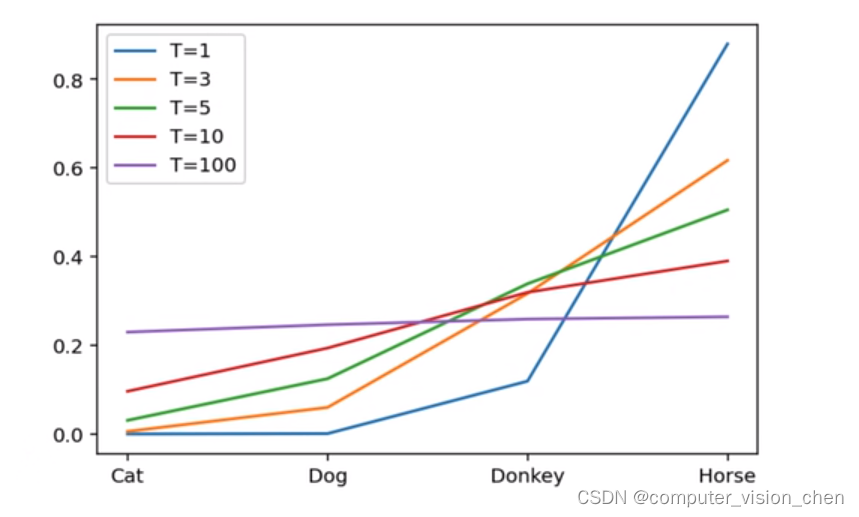

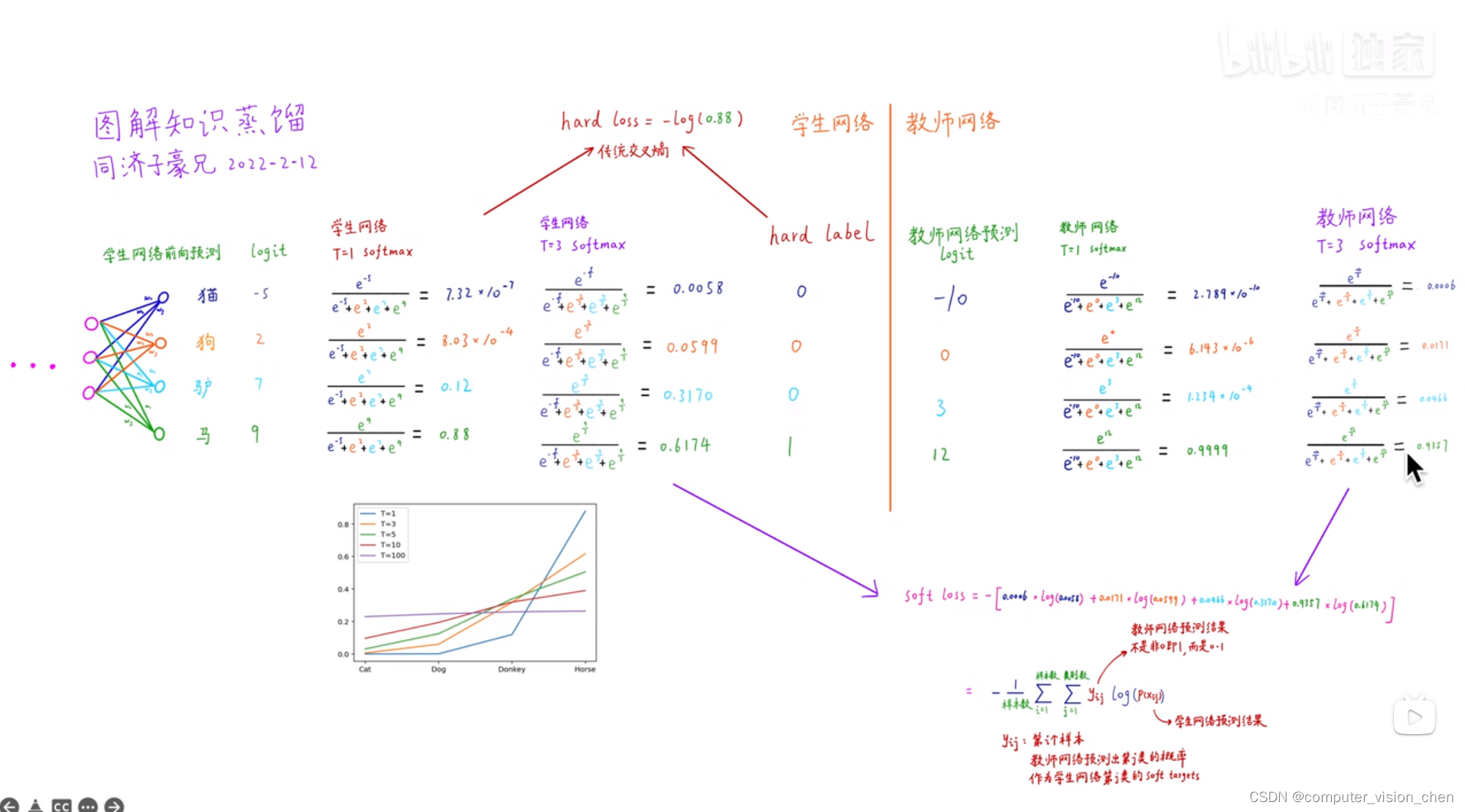

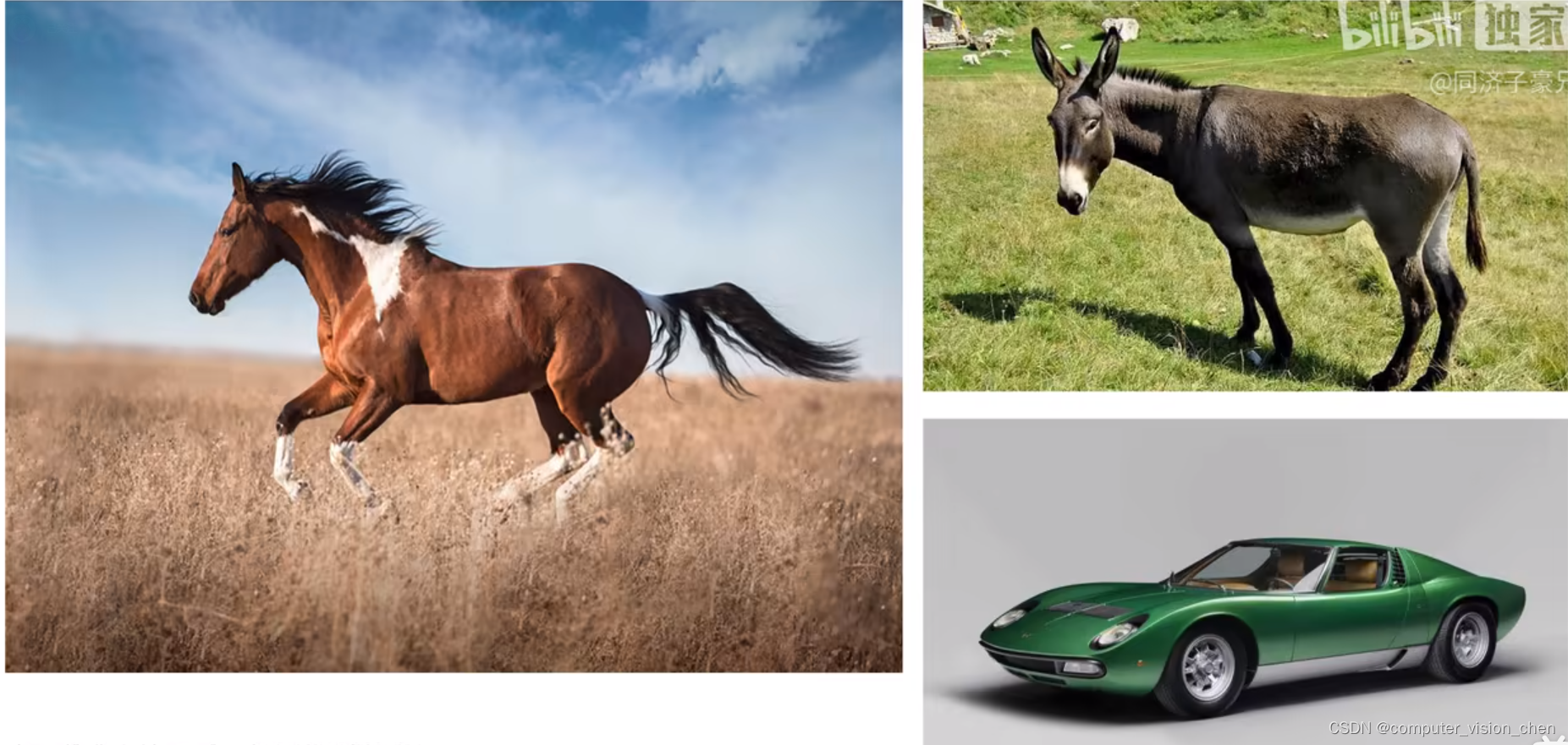

学生网络有两种标签: 一种是教师网络的输出, 一种是真实的标签。 3.1 soft targetsoft target使我们常用的概率版的标签值。比如输入下面的图片预测。 教师网络预测出的soft target具有很多信息。 3.3 蒸馏温度 softmax有放大差异的功能。 如果值高那么一点点,经过softmax的放大就会变得很高。 如果想让soft target更加平缓,高的降低,低的升高。 这时就要对soft target使用蒸馏温度。 让soft target更soft。 实现方法是在softmax的分母处加个T。

抑制过拟合: 高蒸馏温度下的软目标概率分布更平滑,相比硬目标更容忍学生模型的小误差。这有助于防止学生模型在训练过程中对教师模型的一些噪声或细微差异过度拟合,提高了模型的泛化能力。 降低标签噪声的影响: 在训练数据中存在标签噪声或不确定性时,平滑的软目标可以减少这些噪声的影响。学生模型更倾向于关注教师模型输出的分布,而不是过于依赖单一的硬目标。 提高模型鲁棒性: 平滑的软目标有助于提高模型的鲁棒性,使其对输入数据的小变化更加稳定。这对于在实际应用中面对不同环境和数据分布时的模型性能至关重要。 需要注意的是,过高的蒸馏温度也可能导致学生模型过于平滑化,失去了对数据细节的敏感性,因此需要在实践中进行调优。 四.知识蒸馏训练过程 4.1 图示知识蒸馏训练过程

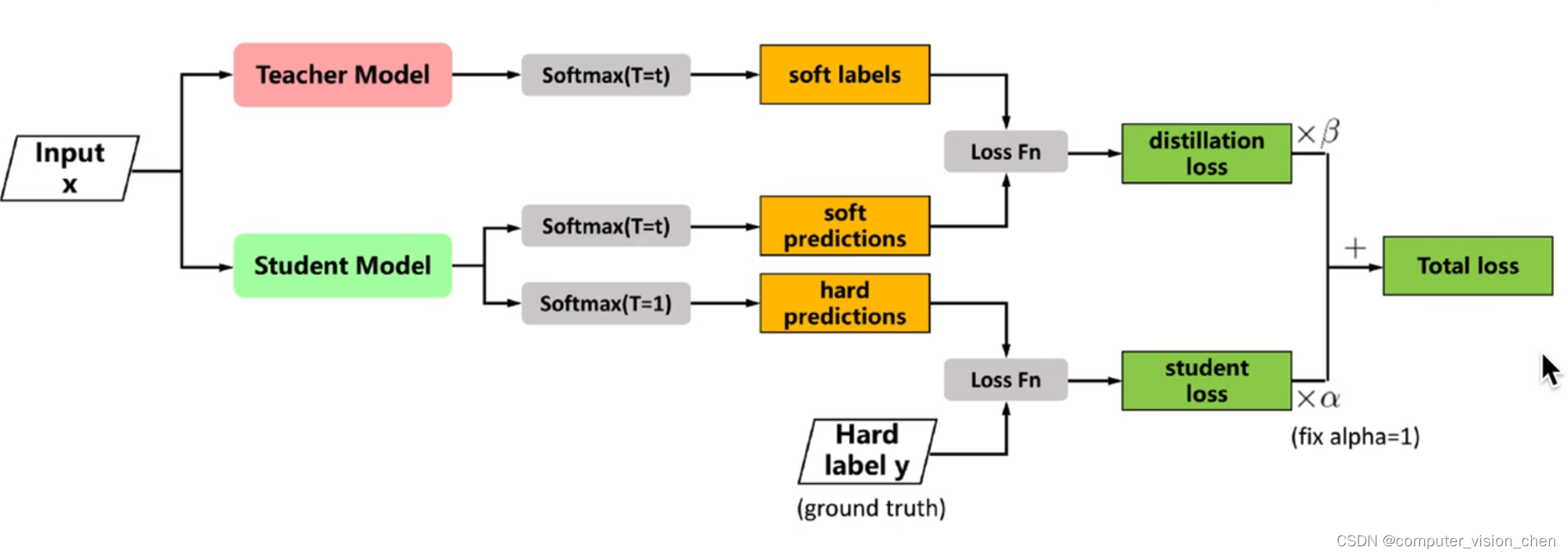

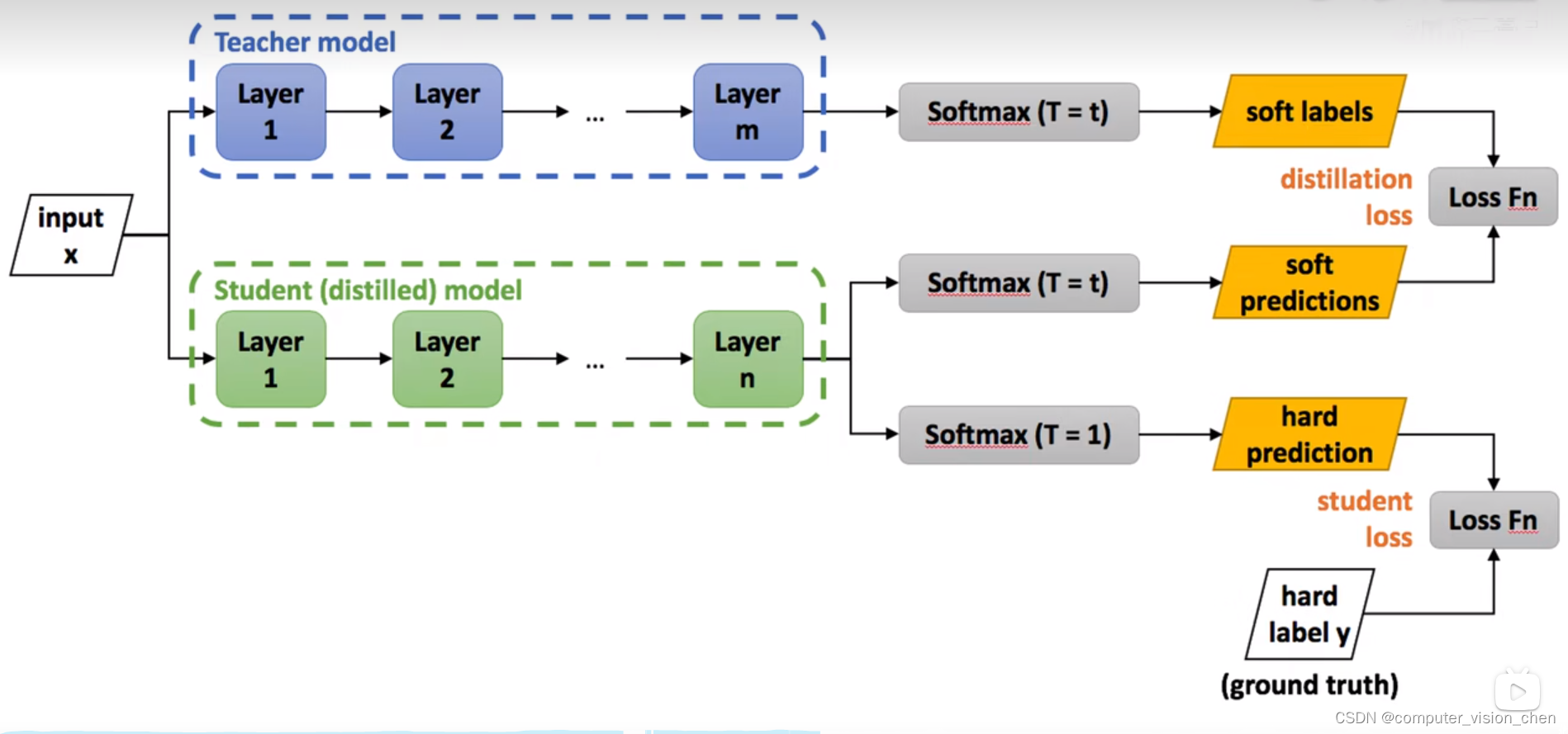

蒸馏损失: 把教师网络使用蒸馏温度为t的输出结果 与 学生网络蒸馏温度为t的输出结果做损失。 让这个损失越小越好。学生损失: 学生网络蒸馏温度为1(即不使用蒸馏网络)时的预测结果和真实的标签做loss.最后对这两项加权求和。 4.3 图解损失函数计算过程 红色线条指向的是学生损失。 紫色线条指向的是蒸馏损失。

此时学生网络已经训练好,把X输入到学生网络得到结果。 学生网络可以接近教师网络的识别效果,并且附加如下两个特点: 1.零样本识别 论文里面说:以手写体数字数据集为例,假如在训练学生网络时把标签为3的类别全部去掉, 但是教师网络学过3。当使用知识蒸馏将教师网络学到的东西迁移到学生网络时,学生网络虽然没有见过3,但是却能识别3,即达到了零样本的效果。 2.使用soft target训练而不是hard target,减少了过拟合

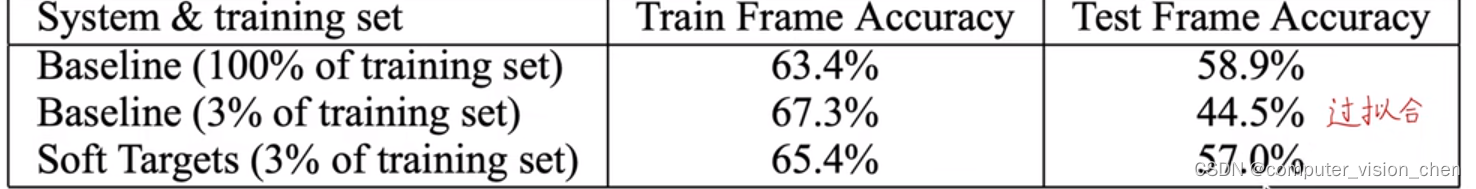

第二行和第三行是使用百分之3的训练样本并分别用hard target和soft target,结果显示 使用3%的训练样本 + hard target : 训练集的准确率为 67.3%, 测试集的准确率为44.5%。 使用3%的训练样本 + soft target : 训练集的准确率为 65.4%, 测试集的准确率为57.5%。 七.迁移学习和知识蒸馏的区别 迁移学习是把一个模型学习的领域泛化到另一个领域,比如把猫狗这些动物域迁移到医疗域。 知识蒸馏是把一个模型的知识迁移到另一个模型上。 八.知识蒸馏实现代码https://blog.csdn.net/qq_42864343/article/details/134722507?csdn_share_tail=%7B%22type%22%3A%22blog%22%2C%22rType%22%3A%22article%22%2C%22rId%22%3A%22134722507%22%2C%22source%22%3A%22qq_42864343%22%7D 九.参考视频B站UP主,同济子豪兄的视频: 【精读AI论文】知识蒸馏 https://www.bilibili.com/video/BV1gS4y1k7vj/?spm_id_from=333.788&vd_source=ebc47f36e62b223817b8e0edff181613 |

【本文地址】

今日新闻 |

推荐新闻 |

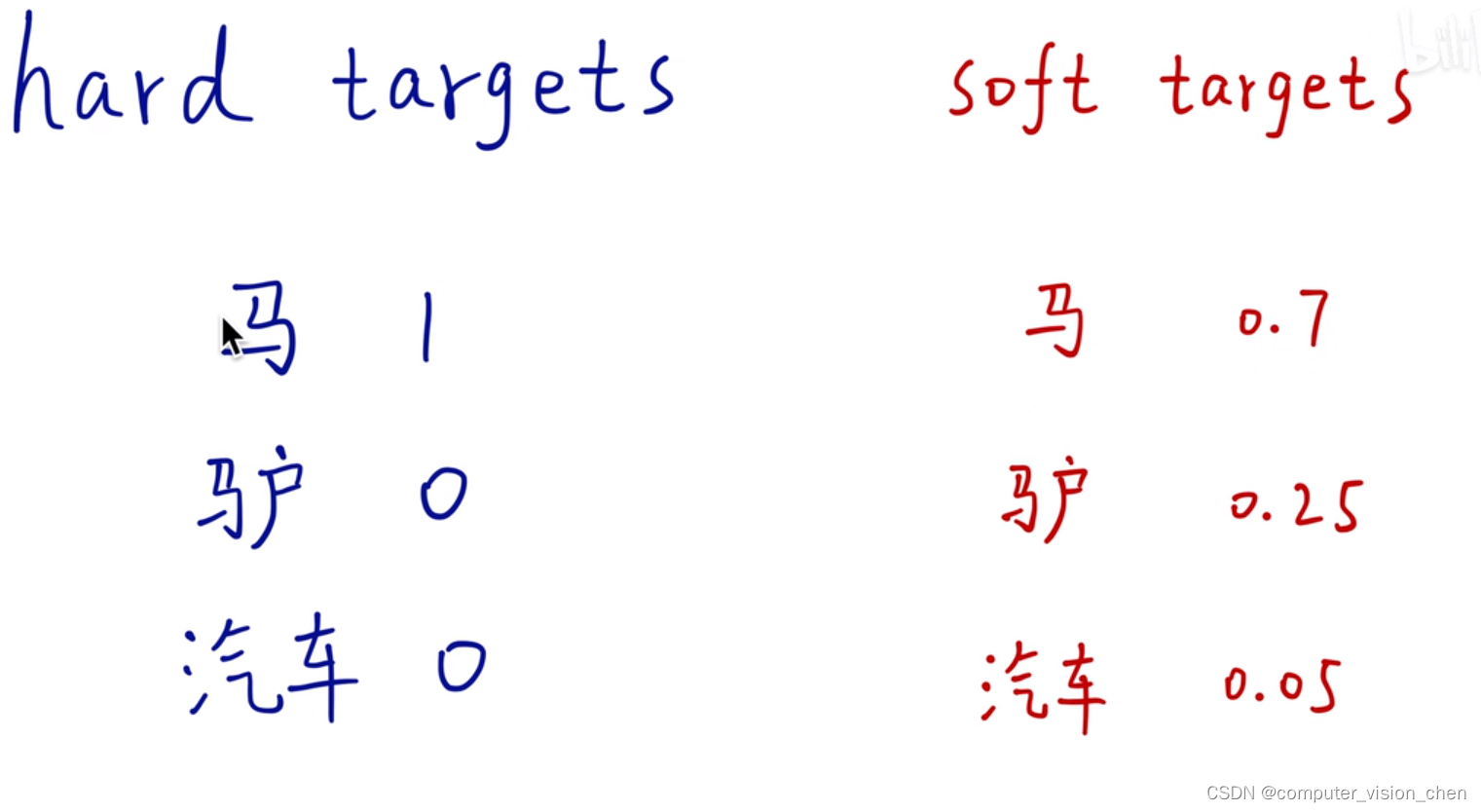

hard targets和soft targets的预测概率如下:

hard targets和soft targets的预测概率如下:  hard targets的预测结果不科学,因为马和驴比马和汽车相似的多。所以驴和汽车都是0,没有表现出这个信息,所以要用soft targets.

hard targets的预测结果不科学,因为马和驴比马和汽车相似的多。所以驴和汽车都是0,没有表现出这个信息,所以要用soft targets.