面部表情识别2:Pytorch实现表情识别(含表情识别数据集和训练代码) |

您所在的位置:网站首页 › 动态摄像头表情包下载安装手机 › 面部表情识别2:Pytorch实现表情识别(含表情识别数据集和训练代码) |

面部表情识别2:Pytorch实现表情识别(含表情识别数据集和训练代码)

|

面部表情识别2:Pytorch实现表情识别(含表情识别数据集和训练代码)

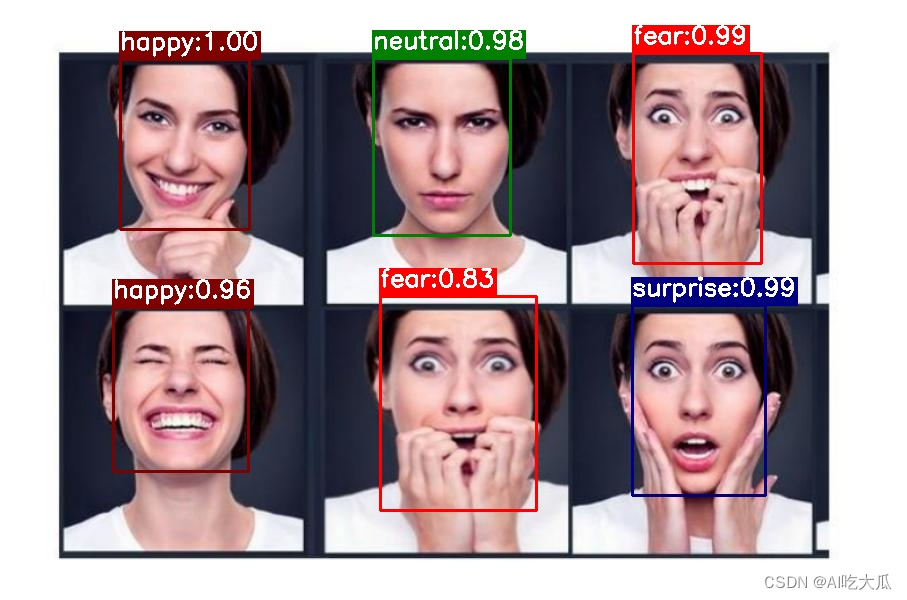

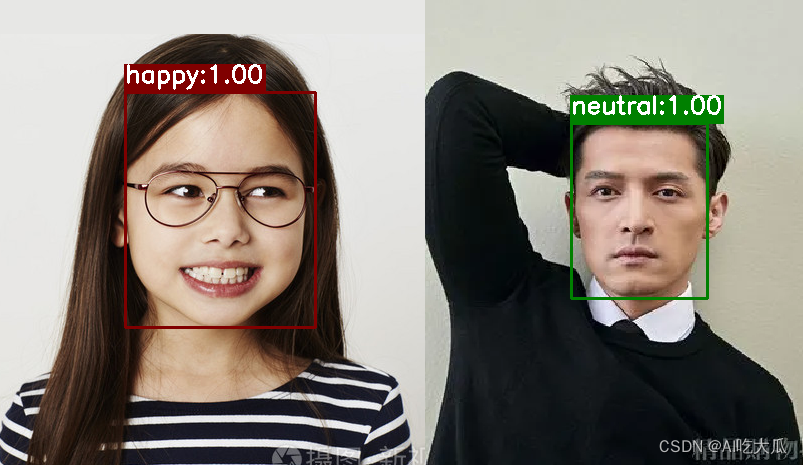

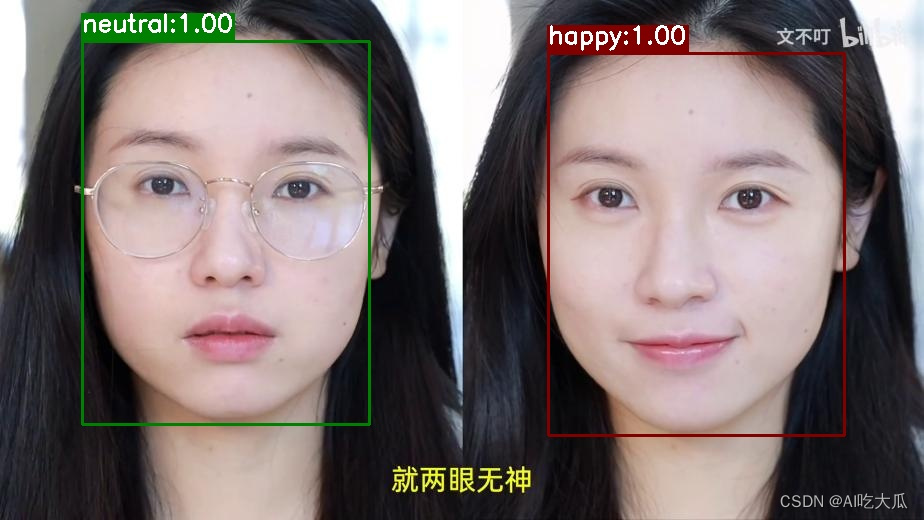

目录 面部表情识别2:Pytorch实现表情识别(含表情识别数据集和训练代码) 1.面部表情识别方法 2.面部表情识别数据集 (1)表情识别数据集说明 (2)自定义数据集 3.人脸检测模型 4.面部表情识别分类模型训练 (1)项目安装 (2)准备数据 (3)面部表情识别分类模型训练(Pytorch) (4) 可视化训练过程 (5) 面部表情识别效果 (6) 一些优化建议 (7) 一些运行错误处理方法 5.项目源码下载(Python版) 6.项目源码下载(C++版) 7.项目源码下载(Android版) 这是项目《面部表情识别》系列之《Pytorch实现表情识别(含表情识别数据集和训练代码)》;项目基于深度学习框架Pytorch开发一个高精度,可实时的面部表情识别算法( Facial Expression Recognition);项目源码支持模型有resnet18,resnet34,resnet50, mobilenet_v2以及googlenet等常见的深度学习模型,用户可自定义进行训练;准确率还挺高的,采用轻量级mobilenet_v2模型的面部表情识别准确率也可以高达94.72%左右,满足业务性能需求。 模型input sizeTest准确率mobilenet_v2112×11294.72%googlenet112×11294.28%resnet18112×11294.818%先展示一下,Python版本的面部表情识别Demo效果(不同表情用不同的颜色框标注了)

【尊重原创,转载请注明出处】https://blog.csdn.net/guyuealian/article/details/129505205 更多项目《面部表情识别》系列文章请参考: 面部表情识别1:表情识别数据集(含下载链接)面部表情识别2:Pytorch实现表情识别(含表情识别数据集和训练代码)面部表情识别3:Android实现表情识别(含源码,可实时检测)面部表情识别4:C++实现表情识别(含源码,可实时检测)

面部表情识别方法有多种实现方案,这里采用最常规的方法:基于人脸检测+面部表情分类识别方法,即先采用通用的人脸检测模型,进行人脸检测,然后裁剪人脸区域,再训练一个面部表情分类器,完成对面部表情识别; 这样做的好处,是可以利用现有的人脸检测模型,而无需重新训练人脸检测模型,可减少人工标注成本低;而人脸数据相对而言比较容易采集,分类模型可针对性进行优化。 2.面部表情识别数据集 (1)表情识别数据集说明本项目主要使用两个表情识别数据集:Emotion-Domestic国内(亚洲)表情识别数据集+MMAFEDB表情识别数据集,总共超过15万张人脸图片,数据面部表情丰富多样,包含angry(生气), disgust (厌恶), fear(害怕), happy(快乐), neutral (中性), sad(悲伤), surprise(惊奇)等多种表情。 关于表情识别数据的使用说明请参考我的一篇博客:面部表情识别1:表情识别数据集(含下载链接)

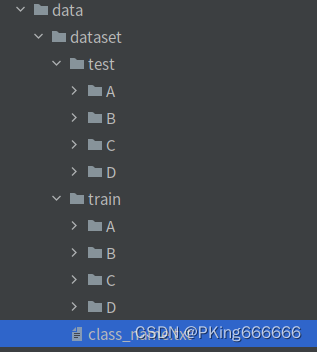

如果需要新增类别数据,或者需要自定数据集进行训练,可参考如下进行处理: 建立Train和Test数据集,要求相同类别的图片,放在同一个文件夹下;且子目录文件夹命名为类别名称,如

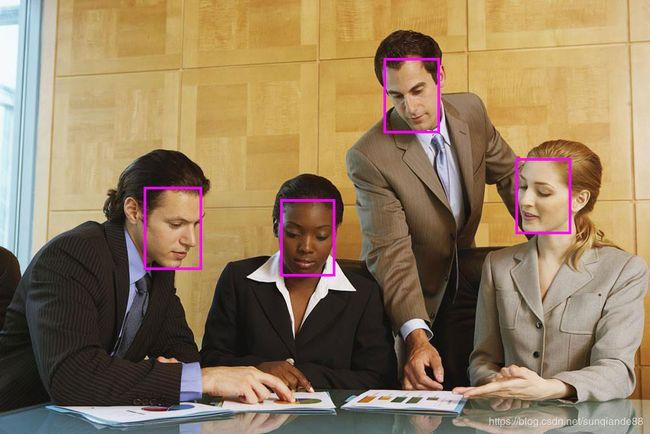

本项目人脸检测训练代码请参考:https://github.com/Linzaer/Ultra-Light-Fast-Generic-Face-Detector-1MB 这是一个基于SSD改进且轻量化后人脸检测模型,很slim,整个模型仅仅1.7M左右,在普通Android手机都可以实时检测。人脸检测方法在网上有一大堆现成的方法可以使用,完全可以不局限我这个方法。

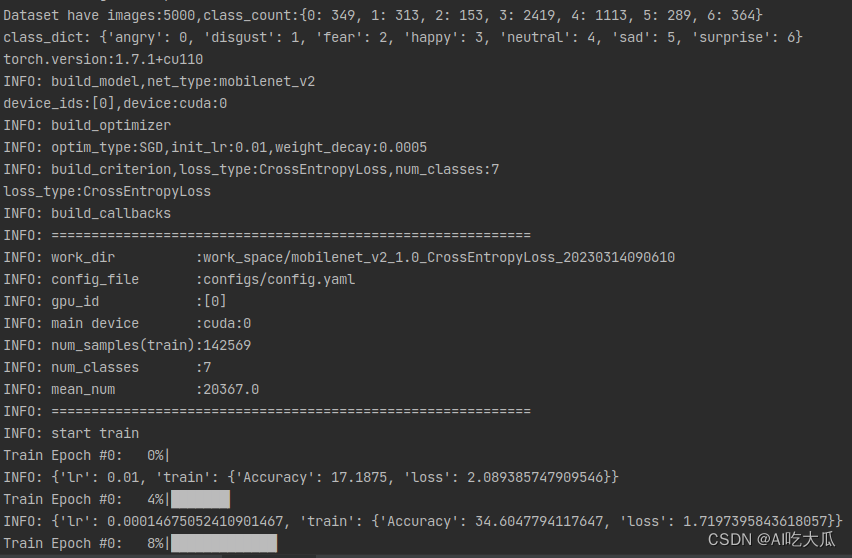

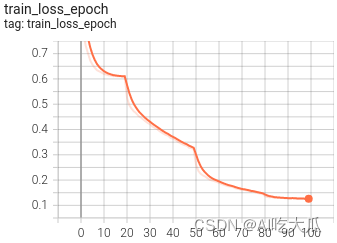

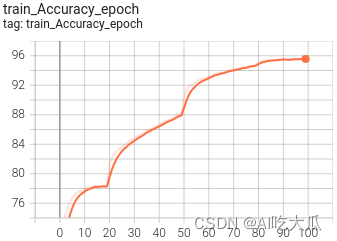

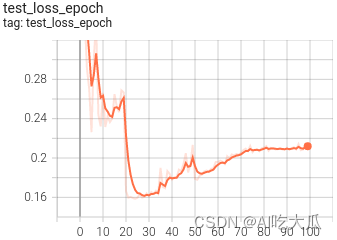

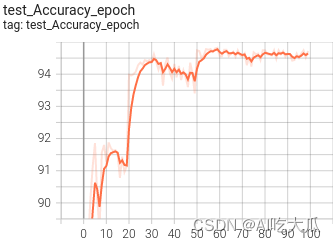

准备好表情识别数据后,接下来就可以开始训练表情识别分类模型了;项目模型支持resnet18,resnet34,resnet50, mobilenet_v2以及googlenet等常见的深度学习模型,考虑到后续我们需要将表情识别模型部署到Android平台中,因此项目选择计算量比较小的轻量化模型mobilenet_v2;如果不用端上部署,完全可以使用参数量更大的模型,如resnet50等模型。 整套工程项目基本结构如下: . ├── classifier # 训练模型相关工具 ├── configs # 训练配置文件 ├── data # 训练数据 ├── libs │ ├── convert # 将模型转换为ONNX工具 │ ├── light_detector # 人脸检测 │ ├── detector.py # 人脸检测demo │ └── README.md ├── demo.py # demo ├── README.md # 项目工程说明文档 ├── requirements.txt # 项目相关依赖包 └── train.py # 训练文件 (1)项目安装推荐使用Python3.8或Python3.7,更高版本可能存在版本差异问题,项目依赖python包请参考requirements.txt,使用pip安装即可: numpy==1.16.3 matplotlib==3.1.0 Pillow==6.0.0 easydict==1.9 opencv-contrib-python==4.5.2.52 opencv-python==4.5.1.48 pandas==1.1.5 PyYAML==5.3.1 scikit-image==0.17.2 scikit-learn==0.24.0 scipy==1.5.4 seaborn==0.11.2 tensorboard==2.5.0 tensorboardX==2.1 torch==1.7.1+cu110 torchvision==0.8.2+cu110 tqdm==4.55.1 xmltodict==0.12.0 basetrainer pybaseutils==0.6.5项目安装教程请参考(初学者入门,麻烦先看完下面教程,配置好开发环境): 项目开发使用教程和常见问题和解决方法视频教程:1 手把手教你安装CUDA和cuDNN(1)视频教程:2 手把手教你安装CUDA和cuDNN(2)视频教程:3 如何用Anaconda创建pycharm环境视频教程:4 如何在pycharm中使用Anaconda创建的python环境推荐使用Python3.8或Python3.7,更高版本可能存在版本差异问题 (2)准备数据下载表情识别数据集:Emotion-Domestic国内(亚洲)表情识别数据集+MMAFEDB表情识别数据集,关于表情识别数据的使用说明请参考我的一篇博客:面部表情识别1:表情识别数据集(含下载链接) (3)面部表情识别分类模型训练(Pytorch)项目在《Pytorch基础训练库Pytorch-Base-Trainer(支持模型剪枝 分布式训练)》基础上实现了面部表情识别分类模型训练和测试,整套训练代码非常简单操作,用户只需要将相同类别的图片数据放在同一个目录下,并填写好对应的数据路径,即可开始训练了。 训练框架采用Pytorch,整套训练代码支持的内容主要有: 目前支持的backbone有:googlenet,resnet[18,34,50], ,mobilenet_v2等, 其他backbone可以自定义添加训练参数可以通过(configs/config.yaml)配置文件进行设置修改配置文件的数据路径:configs/config.yaml: train_data和test_data修改为自己的数据路径注意数据路径分隔符使用【/】,不是【\】项目不要出现含有中文字符的目录文件或路径,否则会出现很多异常! # 训练数据集,可支持多个数据集(不要出现中文路径) train_data: - 'path/to/emotion/emotion-domestic/train' - 'path/to/emotion/MMAFEDB/train' # 测试数据集(不要出现中文路径) test_data: - 'path/to/motion/emotion-domestic/test' # 类别文件 class_name: 'data/class_name.txt' train_transform: "train" # 训练使用的数据增强方法 test_transform: "val" # 测试使用的数据增强方法 work_dir: "work_space/" # 保存输出模型的目录 net_type: "mobilenet_v2" # 骨干网络,支持:resnet18/50,mobilenet_v2,googlenet,inception_v3 width_mult: 1.0 # 模型宽度因子 input_size: [ 112,112 ] # 模型输入大小 rgb_mean: [ 0.5, 0.5, 0.5 ] # for normalize inputs to [-1, 1],Sequence of means for each channel. rgb_std: [ 0.5, 0.5, 0.5 ] # for normalize,Sequence of standard deviations for each channel. batch_size: 128 # batch_size lr: 0.01 # 初始学习率 optim_type: "SGD" # 选择优化器,SGD,Adam loss_type: "CrossEntropyLoss" # 选择损失函数:支持CrossEntropyLoss,LabelSmoothing momentum: 0.9 # SGD momentum num_epochs: 100 # 训练循环次数 num_warn_up: 3 # warn-up次数 num_workers: 8 # 加载数据工作进程数 weight_decay: 0.0005 # weight_decay,默认5e-4 scheduler: "multi-step" # 学习率调整策略 milestones: [ 20,50,80 ] # 下调学习率方式 gpu_id: [ 0 ] # GPU ID log_freq: 50 # LOG打印频率 progress: True # 是否显示进度条 pretrained: True # 是否使用pretrained模型 finetune: False # 是否进行finetune开始训练,在终端输入: python train.py -c configs/config.yaml 训练完成后,训练集的Accuracy在95.5%以上,测试集的Accuracy在94.5%左右 (4) 可视化训练过程 训练过程可视化工具是使用Tensorboard,在终端(Terminal)输入命令:使用教程,请参考:项目开发使用教程和常见问题和解决方法 # 需要安装tensorboard==2.5.0和tensorboardX==2.1 # 基本方法 tensorboard --logdir=path/to/log/ # 例如 tensorboard --logdir=work_space/mobilenet_v2_1.0_CrossEntropyLoss_20230313090258/log可视化效果

训练完成后,训练集的Accuracy在95.5%以上,测试集的Accuracy在94.5%左右,下表给出已经训练好的三个模型,其中mobilenet_v2的准确率可以达到94.72%,googlenet的准确率可以达到94.28%,resnet18的准确率可以达到94.81% 模型input sizeTest准确率mobilenet_v2112×11294.72%googlenet112×11294.28%resnet18112×11294.818% 测试图片文件 # 测试图片(Linux系统) image_dir='data/test_image' # 测试图片的目录 model_file="data/pretrained/mobilenet_v2_1.0_CrossEntropyLoss_20230313090258/model/latest_model_099_94.7200.pth" # 模型文件 out_dir="output/" # 保存检测结果 python demo.py --image_dir $image_dir --model_file $model_file --out_dir $out_dirWindows系统,请将$image_dir, $model_file ,$out_dir等变量代替为对应的变量值即可,如 # 测试图片(Windows系统) python demo.py --image_dir data/test_image --model_file data/pretrained/mobilenet_v2_1.0_CrossEntropyLoss_20230313090258/model/latest_model_099_94.7200.pth --out_dir output/ 测试视频文件 # 测试视频文件(Linux系统) video_file="data/video-test.mp4" # 测试视频文件,如*.mp4,*.avi等 model_file="data/pretrained/mobilenet_v2_1.0_CrossEntropyLoss_20230313090258/model/latest_model_099_94.7200.pth" # 模型文件 out_dir="output/" # 保存检测结果 python demo.py --video_file $video_file --model_file $model_file --out_dir $out_dir # 测试视频文件(Windows系统) python demo.py --video_file data/video-test.mp4 --model_file data/pretrained/mobilenet_v2_1.0_CrossEntropyLoss_20230313090258/model/latest_model_099_94.7200.pth --out_dir output/ 测试摄像头 # 测试摄像头(Linux系统) video_file=0 # 测试摄像头ID model_file="data/pretrained/mobilenet_v2_1.0_CrossEntropyLoss_20230313090258/model/latest_model_099_94.7200.pth" # 模型文件 out_dir="output/" # 保存检测结果 python demo.py --video_file $video_file --model_file $model_file --out_dir $out_dir # 测试摄像头(Windows系统) python demo.py --video_file 0 --model_file data/pretrained/mobilenet_v2_1.0_CrossEntropyLoss_20230313090258/model/latest_model_099_94.7200.pth --out_dir output/下面是面部表情识别效果展示(其中不同表情用不同颜色表示了)

如果想进一步提高模型的性能,可以尝试: 清洗数据集(最重要):尽管鄙人已经清洗一部分了,但还是建议你,训练前,再次清洗数据集,不然会影响模型的识别的准确率。增加训练的样本数据: 建议根据自己的业务场景,采集相关数据,提高模型泛化能力使用参数量更大的模型: 本教程使用的是mobilenet_v2模型,属于比较轻量级的分类模型,采用更大的模型(如resnet50),理论上其精度更高,但推理速度也较慢。尝试不同数据增强的组合进行训练增加数据增强: 已经支持: 随机裁剪,随机翻转,随机旋转,颜色变换等数据增强方式,可以尝试诸如mixup,CutMix等更复杂的数据增强方式样本均衡: 原始数据表情识别类别数据并不均衡,类别happy和neutral的数据偏多,而disgust和fear的数据偏少,这会导致训练的模型会偏向于样本数较多的类别。建议进行样本均衡处理。调超参: 比如学习率调整策略,优化器(SGD,Adam等)损失函数: 目前训练代码已经支持:交叉熵,LabelSmoothing,可以尝试FocalLoss等损失函数 (7) 一些运行错误处理方法项目不要出现含有中文字符的目录文件或路径,否则会出现很多异常!!!!!!!! cannot import name 'load_state_dict_from_url' 由于一些版本升级,会导致部分接口函数不能使用,请确保版本对应 torch==1.7.1 torchvision==0.8.2 或者将对应python文件将 from torchvision.models.resnet import model_urls, load_state_dict_from_url修改为: from torch.hub import load_state_dict_from_url model_urls = { 'mobilenet_v2': 'https://download.pytorch.org/models/mobilenet_v2-b0353104.pth', 'resnet18': 'https://download.pytorch.org/models/resnet18-5c106cde.pth', 'resnet34': 'https://download.pytorch.org/models/resnet34-333f7ec4.pth', 'resnet50': 'https://download.pytorch.org/models/resnet50-19c8e357.pth', 'resnet101': 'https://download.pytorch.org/models/resnet101-5d3b4d8f.pth', 'resnet152': 'https://download.pytorch.org/models/resnet152-b121ed2d.pth', 'resnext50_32x4d': 'https://download.pytorch.org/models/resnext50_32x4d-7cdf4587.pth', 'resnext101_32x8d': 'https://download.pytorch.org/models/resnext101_32x8d-8ba56ff5.pth', 'wide_resnet50_2': 'https://download.pytorch.org/models/wide_resnet50_2-95faca4d.pth', 'wide_resnet101_2': 'https://download.pytorch.org/models/wide_resnet101_2-32ee1156.pth', } 5.项目源码下载(Python版)项目源码下载地址:面部表情识别2:Pytorch实现表情识别(含表情识别数据集和训练代码) 整套项目源码内容包含: 提供面部表情识别数据集:本项目主要使用两个表情识别数据集:Emotion-Domestic国内(亚洲)表情识别数据集+MMAFEDB表情识别数据集,总共超过15万张人脸图片,数据面部表情丰富多样,包含angry(生气), disgust (厌恶), fear(害怕), happy(快乐), neutral (中性), sad(悲伤), surprise(惊奇)等多种表情。提供面部表情识别分类模型训练代码:train.py提供面部表情识别分类模型测试代码:demo.pyDemo支持图片,视频和摄像头测试支持自定义数据集进行训练项目支持模型:resnet18,resnet34,resnet50, mobilenet_v2以及googlenet等常见的深度学习模型项目源码自带训练好的模型文件,可直接运行测试: python demo.py在普通电脑CPU/GPU上可以实时检测和识别 6.项目源码下载(C++版)面部表情识别4:C++实现表情识别(含源码,可实时检测) 7.项目源码下载(Android版)目前已经实现Android版本的面部表情识别,详细项目请参考:面部表情识别3:Android实现面部表情识别(含源码,可实时检测):https://blog.csdn.net/guyuealian/article/details/129467015 Android面部表情识别APP Demo体验:https://download.csdn.net/download/guyuealian/87575425

|

【本文地址】