使用BiLSTM神经网络+PyTorch实现汉语分词模型的训练 |

您所在的位置:网站首页 › 中文分词模型的领域适用性方法是什么类型 › 使用BiLSTM神经网络+PyTorch实现汉语分词模型的训练 |

使用BiLSTM神经网络+PyTorch实现汉语分词模型的训练

|

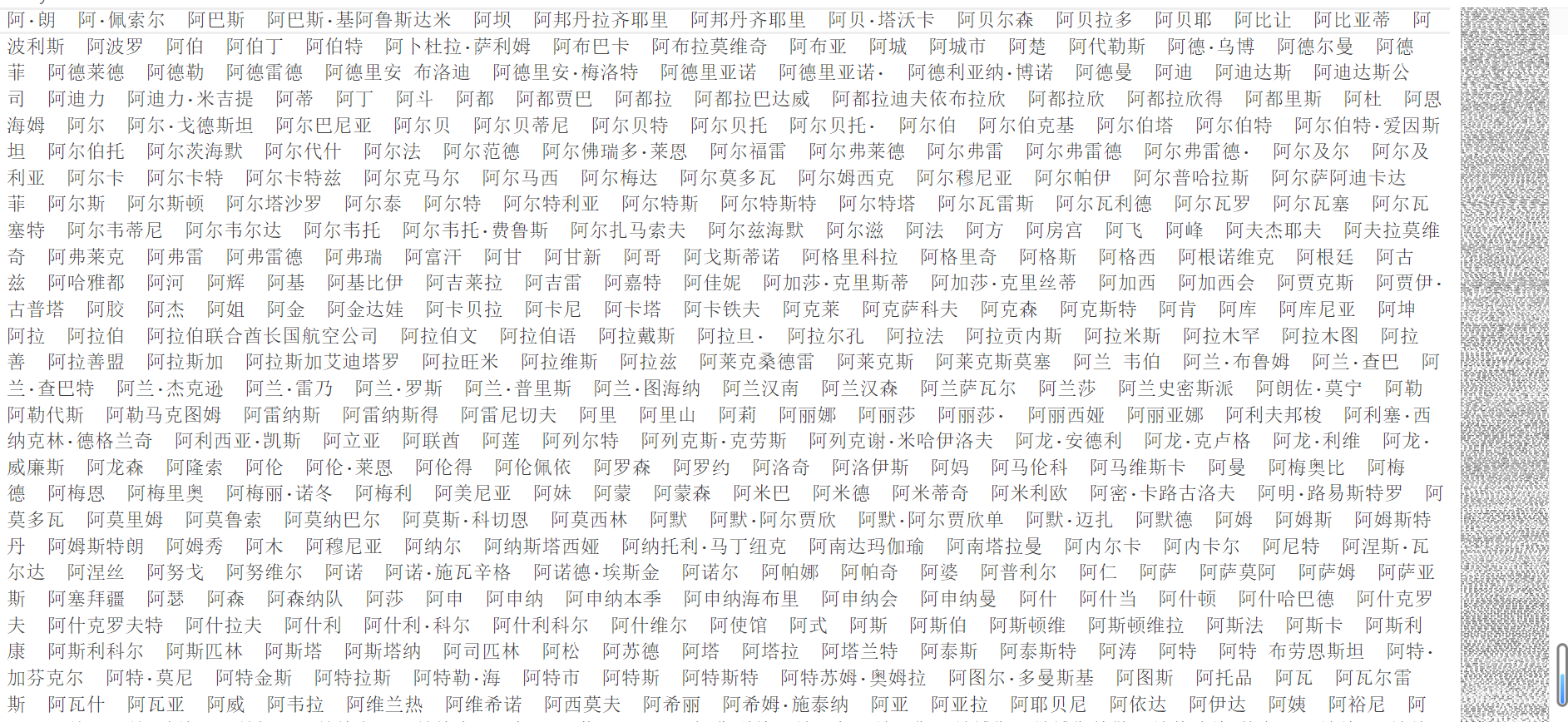

使用BiLSTM神经网络+PyTorch实现汉语分词模型的训练 本次实验源码及数据集已上传到Github,有需要自行下载。 第一部分:实验分析与设计一、实验内容描述此次实验主要是为了深入比较和评估不同中文分词方法的性能,以便于更全面地理解它们的优点和局限性。在此次实验中我将使用两种主要方法来实现中文分词:一种是基于词典的正向匹配算法,另一种是基于神经网络的双层双向长短时记忆网络(LSTM)模型。 方法一:基于词典的正向匹配算法 这种方法比较简单,在这种方法中,我们将利用一个包含大部分常用中文词汇的词典。然后,使用正向匹配算法,将待分词的文本与词典中的词汇逐一匹配。匹配成功的部分将被输出作为分词结果。这种方法的优势在于其简单性和速度,但它可能无法处理未知词汇或歧义情况。相较于神经网络非常容易实现,也不需要麻烦的数据预处理,还不需要修改数据格式,主要算法就是字符串匹配。 方法二:基于神经网络的双层双向LSTM模型 在这个方法中,我们将使用pyTorch构建一个神经网络来实现中文词语分词算法。首先,我们将准备一个中规模的中文语料文件,作为训练数据集。我们将使用PyTorch框架构建一个双层双向LSTM模型,该模型能够学习如何分词。在训练过程中,模型将学习词汇和上下文之间的关系,以便更准确地分词。 数据集 为了评估两种方法的性能,我们将使用以下数据集: 语料文件:一个包含大量中文文本的语料文件,用于神经网络的训练。该语料文件将包括各种文本类型和难度级别的文本。其中使用空格分开每一个词语,如下其中一句所示: 代码语言:javascript复制1. 迈向 充满 希望 的 新 世纪 —— 一九九八年 新年 讲话 ( 附 图片 1 张 )测试数据:一个用于评估两种分词方法的测试数据集,包括中文文本。这些测试数据将用于比较方法的性能。其中数据为一句句话,但是没有使用空格进行分割。 测试数据结果:测试数据对应的结果,每一行都和 测试数据相对应,不过每个词语之间有空格间隔。测试数据和测试数据结果如下: 代码语言:javascript复制1. 测试数据:共同创造美好的新世纪——二○○一年新年贺词 2. 测试数据结果:共同 创造 美好 的 新 世纪 —— 二○○一年 新年 贺词数据预处理:准备词典、对语料文件进行分词和标记化,以及创建神经网络模型的输入数据。 模型训练:使用语料文件进行神经网络模型的训练。模型将学习如何分词。 模型评估:使用测试数据集来评估两种分词方法的性能,包括准确率、召回率、F1分数等指标。 结果分析:比较基于词典的正向匹配算法和基于神经网络的方法的性能,讨论它们的优势和不足之处。 实验验证:重复实验,以确保结果的稳定性和一致性。 通过这个实验,我们希望得出关于不同中文分词方法的性能比较,并为选择最适合特定任务的分词方法提供有力依据。 二、实验内容与设计思想在第一种方法中,首先,我们使用简单的正向匹配算法,对于字符串中的每个字符串进行匹配。从文本的开头开始,每次匹配最长的词语,直到文本被分完为止。如果当前位置没有匹配到任何词语,则将当前位置的字符作为一个单独的词语。 具体来说,该算法的实现过程如下: 初始化一个空的词语列表tokens,以及文本的长度text_len和词典中最长词语的长度max_word_len。从文本的开头开始,依次匹配最长的词语。具体地,从max_word_len开始,依次尝试匹配长度为max_word_len、max_word_len-1、…、1的词语,直到匹配到一个词语为止。如果匹配到了一个词语,则将该词语添加到tokens列表中,并将当前位置i移动到词语的末尾。如果没有匹配到任何词语,则将当前位置的字符作为一个单独的词语,并将当前位置i移动到下一个位置。重复步骤2到步骤4,直到文本被分完为止。该算法的时间复杂度为O(n^2),其中n为文本的长度。在实际应用中,该算法的效率较低,但是实现简单,可以作为其他分词算法的基础。 第二种方法主要需要使用pytorch,所以比较麻烦,首先我们需要对于所有句子进行预处理,由于模型无法直接输入文字,所以我们得将其进行编码,编码这里我选择的是每个字出现的频率,按照从小到大排序进行编码,这样一方面可以实现我们的编码功能,另一方面还有一部分字频特征,比较直接。通过这种方式将其转换为数字列表后,再将结果进行处理,通过上网查阅资料可知,在这种模型我们的结果需要使用编码进行标识是否是一个词语或者单独的字。编码规则如下: 代码语言:javascript复制1. target_dict = {'B': 0, # begin 2. 'M': 1, # middle 3. 'E': 2, # end 4. 'S': 3, # single 5. 'N': 4} # null编码成功后,我们的每个句子转换为了数字类型,除此之外,如果有需要我们还需要将其转换为one-Hot编码,不过在torch模型中不是很需要,所以这里我们就不转换了。 数据预处理后,我们就需要创建模型了,为了模型更加贴合我们的实验,我选择了双层双向LSTM。双向LSTM(Bidirectional LSTM)是一种常用的循环神经网络模型,它可以同时考虑输入序列的前向和后向信息,从而更好地捕捉序列中的上下文信息。在分词模型中,双向LSTM可以很好地处理中文分词中的歧义问题,提高分词的准确性。 具体来说,双向LSTM可以将输入序列分别从前向后和从后向前进行处理,得到两个输出序列。这两个输出序列可以分别表示输入序列中当前位置之前和之后的上下文信息。然后,这两个输出序列可以被合并起来,得到一个综合的上下文表示,用于进行下一步的分类或预测。 在分词模型中,双向LSTM可以很好地处理中文分词中的歧义问题。例如,在中文分词中,一个汉字可能既可以作为一个词语的开始,也可以作为另一个词语的中间部分。这种歧义问题可以通过双向LSTM来解决,因为双向LSTM可以同时考虑当前位置之前和之后的上下文信息,从而更好地判断当前位置的标记。 然后,我选择了交叉熵作为损失函数,并且定义了优化器,然后将数据上传到GPU上进行运算,现在整个项目就比较清晰了。 三、实验使用环境系统:Windows 11专业版 22H2 22621.2361 软件:Visual Studio Code 环境:Anaconda3(base):Python 3.9.13 PyTorch 2.0.1+cu118 硬件:LEGION R9000P 2021H CPU:R7-5800H GPU:RTX 3060 Laptop 第二部分:实验调试与结果分析一、调试过程首先我们实现第一种正向最大匹配分词实现汉字分词,我们的词典中有若干词汇,并且按照首字母顺序进行排序,如下图所示:  dirctory.txt dirctory.txt我们所需要实现的功能就是,遍历一串句子的每一个字,使用这个字及后面的若干字组成临时词汇,在列表中搜索对应的词汇,如果有这个词汇,分词,并进行下一句话的分词,如果没有,单独成词,并继续遍历下一个词汇。实现代码如下: 代码语言:javascript复制# 定义正向最大匹配分词函数 def forward_max_match(text): tokens = [] text_len = len(text) max_word_len = max(len(word) for word in dictionary_data) i = 0 while i < text_len: matched = False for j in range(max_word_len, 0, -1): if i + j |

【本文地址】

今日新闻 |

推荐新闻 |