特征选择 特征抽取(提取) 特征表示 的区别 |

您所在的位置:网站首页 › swing组件的特征是什么 › 特征选择 特征抽取(提取) 特征表示 的区别 |

特征选择 特征抽取(提取) 特征表示 的区别

|

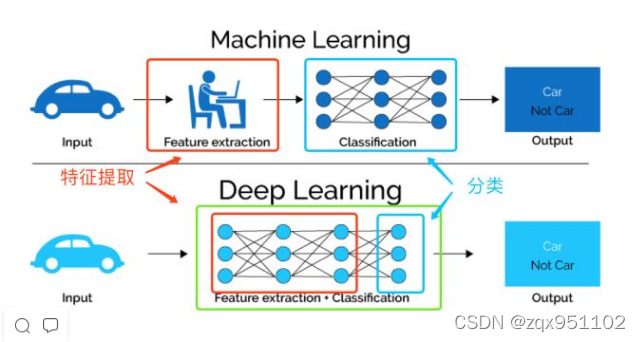

特征选择和特征抽取: 特征选择和特征抽取是DimensionalityReduction(降维)的两种方法,针对于the curse of dimensionality(维灾难),都可以达到降维的目的。但是这两个有所不同。 1.区别 特征选择(Feature Selection):choosing a subset of all the features(the ones more informative)。也就是说,特征选择后的特征是原来特征的一个子集。 特征抽取(Feature Extraction):Creatting a subset of new features by combinations of the exsiting features.也就是说,特征抽取后的新特征是原来特征的一个映射。(相当于发生了化学变化) 2. PCA V.S LDA 主成分分析(Principle Components Analysis ,PCA)和线性评判分析(Linear Discriminant Analysis,LDA)是特征抽取的两种主要经典方法。 对于特征抽取,有两种类别: (1)Signal representation(信号表示): The goal of the feature extraction mapping is to represent the samples accurately in a low-dimensional space. 也就是说,特征抽取后的特征要能够精确地表示样本信息,使得信息丢失很小。对应的方法是PCA. (2)Signal classification(信号分类): The goal of the feature extraction mapping is toenhance the class-discriminatory information in a low-dimensional space. 也就是说,特征抽取后的特征,要使得分类后的准确率很高,不能比原来特征进行分类的准确率低。对与线性来说,对应的方法是LDA . 非线性这里暂时不考虑。 可见, PCA和LDA两种方法的目标不一样,因此导致他们的方法也不一样。PCA得到的投影空间是协方差矩阵的特征向量,而LDA则是通过求得一个变换W,使得 变换之后的新均值之差最大、方差最大(也就是最大化类间距离和最小化类内距离),变换W就是特征的投影方向。 特征提取的方法主要是通过属性间的关系,如组合不同的属性得到新的属性,这样就改变了原来的特征空间。 特征选择的方法是从原始特征数据集中选择出子集,是一种包含的关系,没有更改原始的特征空间。 表示学习: 表示学习的基本思路,是找到对于原始数据更好的表达,以方便后续任务(比如分类)。机器学习中,同样的数据的不同表达,会直接决定后续任务的难易程度(换言之,表示方法的选择通常依赖于后续任务的需求),因此找到好的数据表示往往是机器学习的核心任务。 特征工程与表示学习 机器学习一般有两种思路来提升原始数据的表达[1]: 特征学习(feature learning),又叫表示学习(representation learning)或者表征学习,一般指模型自动从数据中抽取特征或者表示的方法,是模型自动学习的过程; 特征工程(feature engineering),主要指对于数据的人为处理提取,得到我们认为的适合后续模型使用的样式,是人工提取的工程 (狭义的特征工程指的是“洗数据”:处理缺失值,特征选择,维度压缩等各种预处理手段,但从更广义的角度看,这些处理是为了使得数据有更好的表达以便后续应用) 传统的机器学习方法主要依赖人工特征处理与提取,而深度学习则依赖模型自身去学习数据的表示(自动抽取有效特征)。 |

【本文地址】

今日新闻 |

推荐新闻 |