路侧3D感知算法 |

您所在的位置:网站首页 › paddlepaddle2 › 路侧3D感知算法 |

路侧3D感知算法

|

一、背景及意义 自动驾驶在帮助减少交通事故、提高交通效率方面发挥着至关重要的作用。而当前的感知系统主要为移动车辆配备激光雷达或车载摄像机传感器。自动驾驶车在行驶的过程中,车辆的感知系统不能长时间观察周围环境。此外,由于安装的传感器高度相对较低(通常在车辆顶部),感知范围相对有限,容易受到遮挡的影响。相反,从路边摄像头捕获的数据在遮挡鲁棒性和长时间大范围的预测方面具有其固有的优势,因为它们是从安装在距离地面几米高的杆子上的相机收集的。 路侧感知的重要性如下: (1)协同车载自动驾驶,实现车路协同。由于存在视野盲区,车载感知仍然面临安全挑战和不受控制的威胁。相反,路侧视图可以覆盖盲点,与车载视角相比有额外的优势:远距离全局视角,可在空间和时间上扩展车辆的感知场,并进行全局轨迹预测以确保安全。例如,在某个静止车辆后面行走的行人可能会突然撞上正在行驶的车辆,因为车辆传感器由于感知范围有限或严重遮挡而无法检测到环境的突然变化。相反,路侧视角能够及时进行行为预测。 (2)全局感知。现有视图数据集中更近的物体会遮挡更多物体(即使使用环视传感器),从而导致视野盲区。现在有了安装在头顶的路侧摄像头,可以看到不可见的区域。此外,由于路侧视图是全局感知的,因此当队列中有一辆死车时,可以通知自动驾驶汽车选择更快的车道。 (3) 具有绿色低成本效益。在成本方面,通过协作感知和成本效益来确保安全是值得的,因为来自路边摄像头的信息可以广播到所有周围的自动驾驶车。 (4)智能交通控制。路侧感知还有助于智能交通控制和流量管理。

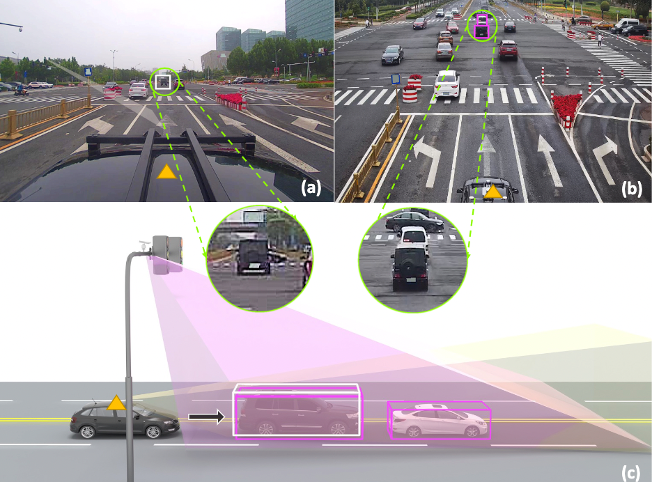

路侧单目3D检测与传统自动驾驶3D检测任务相比,本任务需要解决3个难点。首先,由于每个路侧相机具有不同的配置,例如相机内参数、俯仰角、安装高度,因此存在歧义性,这在很大程度上增加了单目3D检测任务的难度。其次,由于路侧相机安装在杆子上,而不在车顶的正上方,因此相机光轴与地面平行的假设不再成立,无法直接应用具有此先验的单目3D检测方法。第三,由于路侧视角下的感知范围更大,能观察到更多的物体,增加了感知系统的密度和难度。所有这些差异都表明了直接应用大多数现有的3D检测方法不可行。因此,需要将现有的单目3D检测方法改进后适配到路侧应用,提升感知精度。 图 1 相机视图 图1. (a) 车载相机前视图和 (b) 路侧相机俯视图。车端视角着重关注正面区域,而路侧相机拥有更大的观察范围。车辆在前视图中很容易被附近的物体遮挡,在路侧视图中可以缓解这种风险。例如,对于车端视图 (a),白色货车被黑色吉普车遮挡,而在路侧视图 (b) 中,它们都是可见的,对应于 (c) 中的白色和粉红色 3D 框。三角形标记表示同一辆安装激光雷达的车。 二、算法目标描述 提高算法在路端测试集上的单目3D目标检测精度。 三、算法输入输出需求 输入:图像输入:路端数据(图像),以及标定文件。 输出:路侧感兴趣区域内的障碍物目标类别、2D框、3D位置、长宽高、朝向等。

图 2 3D真值标签 四、参赛要求 本次比赛严格要求train from scratch,单纯比较算法能力,比赛要求如下: 1、本竞赛仅可使用比赛主办方提供的数据,其他任何数据,如公开数据集、合成数据、私有数据等不可参与模型训练,亦不可使用由其他数据训练出的网络参数 2、比赛阶段,每支队伍每天可在磅单上提交固定限制次数的评测,排名每天刷新,排名取各队伍历史最佳的成绩进行排序给出 3、进入决赛的队伍,需要向主办方提供完整的训练与测试代码、模型参数以及详细的训练流程说明进行官方复现与测试,并能在合理的时间内完成复现。在主办方进行代码测试和复现过程中,相关的队伍有义务配合主办方进行代码复现,无法提供代码进行测试及复现的队伍、或不配合进行代码测试及复现的队伍,将被取消获奖资格,其他队伍顺延 4、若发现有队伍存在违规作弊行为,违规作弊行为包括但不限于模型代码与文档描述不符、提交代码无法复现出评测结果、违规使用第三方数据进行训练、其它存在违反本次比赛规则的行为,决赛名额以及最终排名依照综合性能指标顺延 五、软硬件要求1、软件要求 Centos7.6、Jittor1.3.4.15、DTK21.10.1、Python3.8.3 CentOS7.6、PytTorch1.10.0、DTK22.04.1、Python3.7 CentOS7.6、PaddlePaddle2.2.2、 DTK22.04.1、Python 3.7 2、硬件要求 DCU 卡*1 CPU 8核 24G 内存 基于jittor 框架曙光相关配置说明: 1.配置环境变量 export HIP_VISIBLE_DEVICES=0 2.配置是否使用GPU 加速 jittor.flags.use_cuda=1

关于此次大赛使用服务器说明: 此次大赛采用国产算力作为平台支持资源,其宗旨是为了推广国产软硬件生态,所有选手将在同一起跑线出发,共同构建未来国产算法生态。如出现不熟悉算力环境的情况,可参阅参赛必读中的相关技术文档,也可查阅其他资料,大赛相关技术人员也会尽力解答所有问题,共同进步共同探索,也期待有大牛能分享相关经验。 另外,百度赛题推荐使用飞桨框架,如果使用其他框架可能会涉及到算子适配问题,需要选手自行与硬件驱动层适配,可能难度较大,我们技术人员也会提供一些协助。但是涉及比赛公平性问题,技术协助不会过多。 经过举办方测试,仅使用基础OP搭建网络即可完成比赛的研发工作,无需编译和安装第三方依赖库,另外本赛要求不能使用预训练权重和其他第三方数据,如果发现安装第三方依赖举办方审核无法复现即取消比赛成绩,请大家专注算法本身的技术研发(技术参考SMOKE,M3DRPN,RTM3D等单目3D检测方向的文章) 六、数据集说明 1、采集设备 路侧数据采集传感器有两种,一种是安装在路灯杆上或红绿灯杆上的路侧相机,另一种是安装在停放或者行驶的车辆上的LiDAR,用于获取同一场景的3D点云。对于传感器同步,我们采用最近时间匹配策略找到图像和点云对,时间误差控制在5毫秒内。

lidar: (1) HESAI Pandar 40P 40线激光雷达,采样帧率为10/20Hz,探测距离精度 |

【本文地址】