基于ROS的机器人建图与导航仿真全过程 |

您所在的位置:网站首页 › 3d模型仿真机器人图片 › 基于ROS的机器人建图与导航仿真全过程 |

基于ROS的机器人建图与导航仿真全过程

|

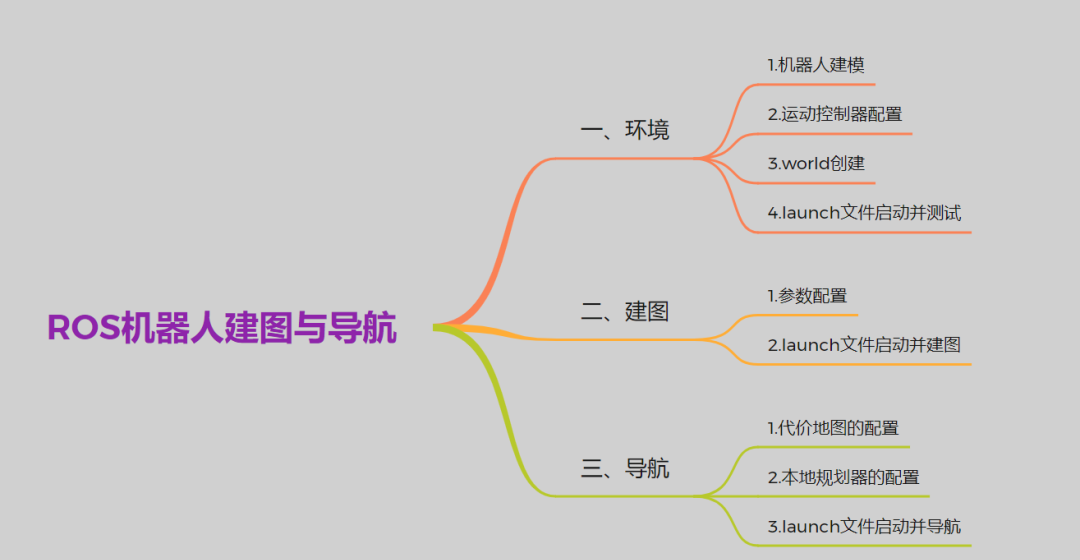

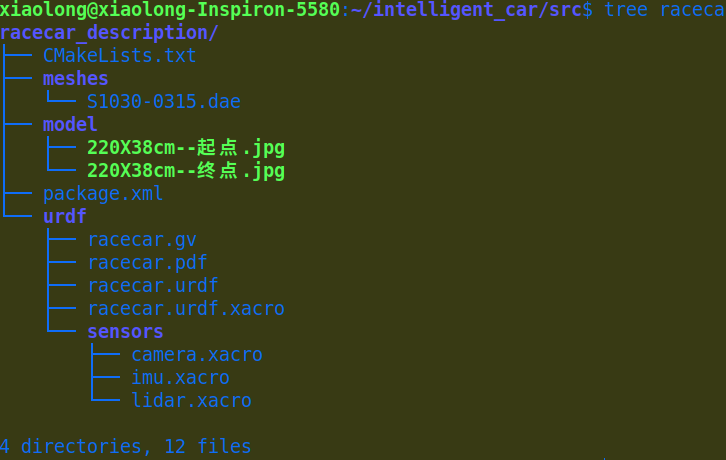

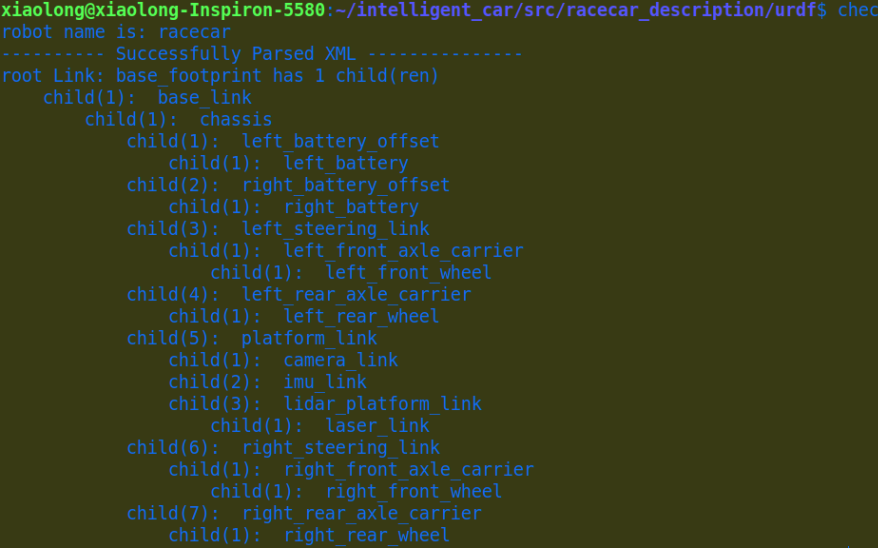

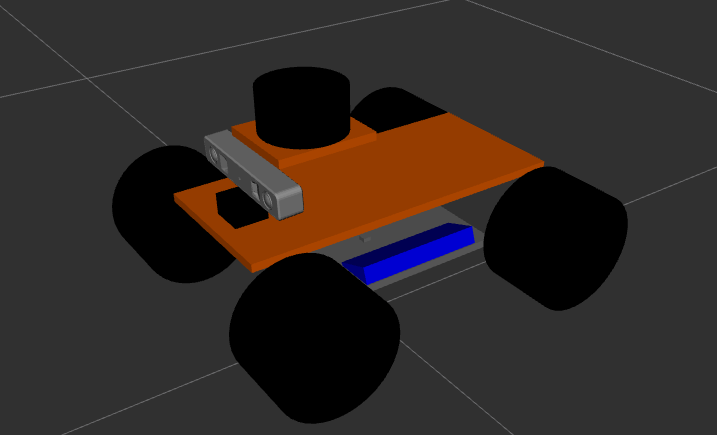

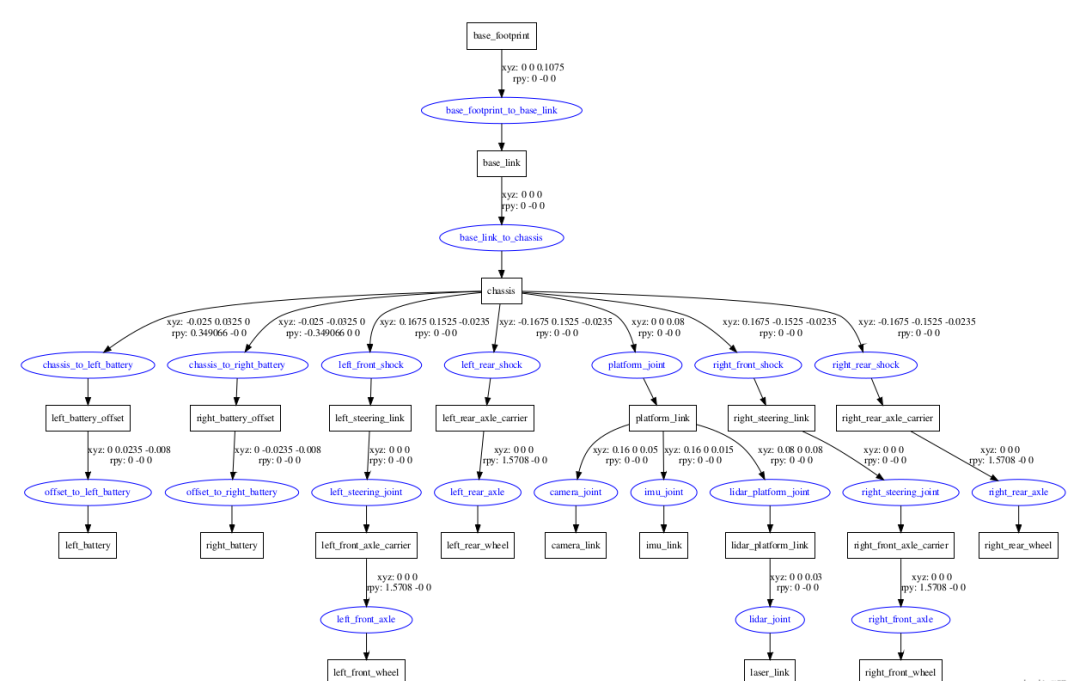

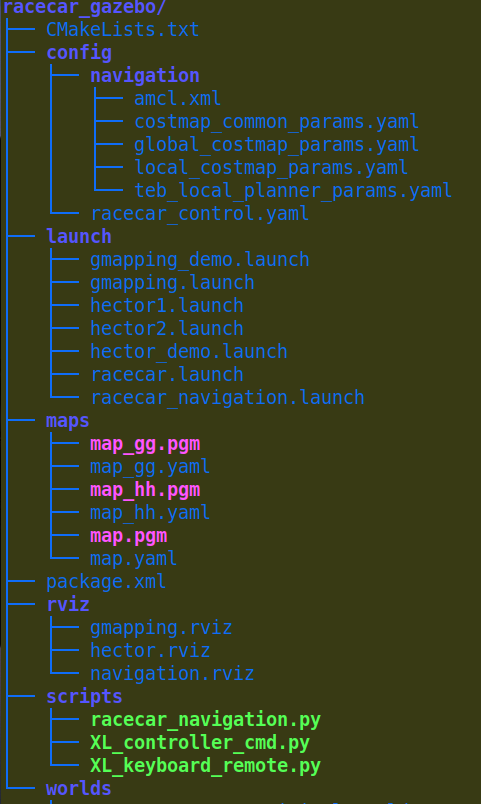

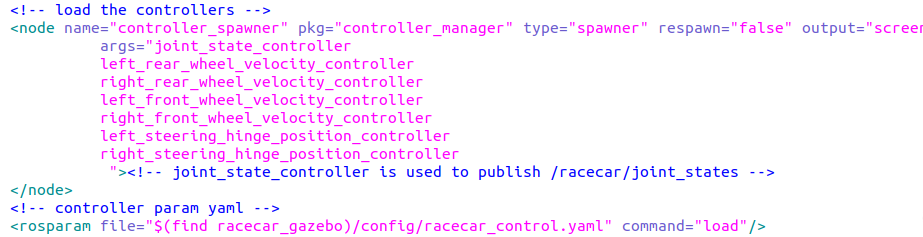

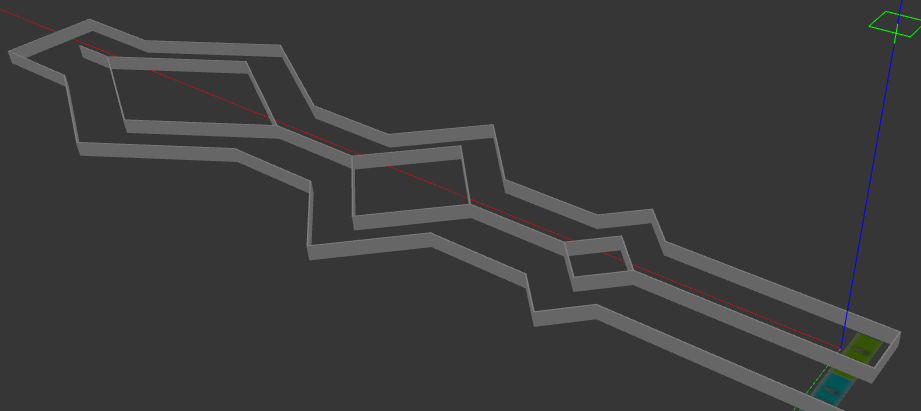

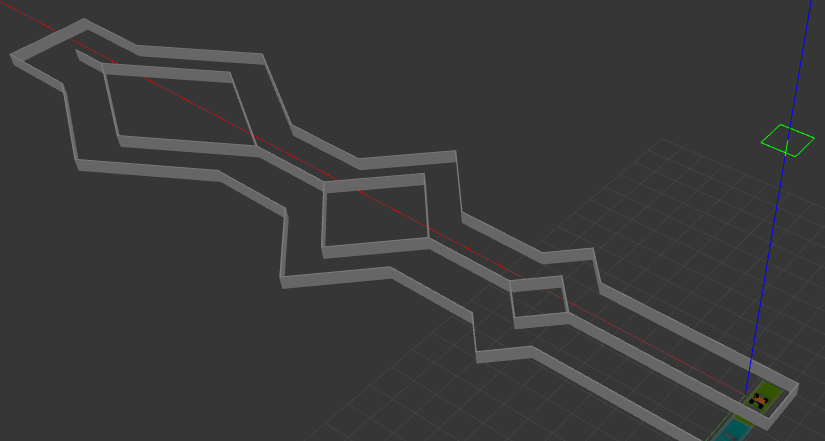

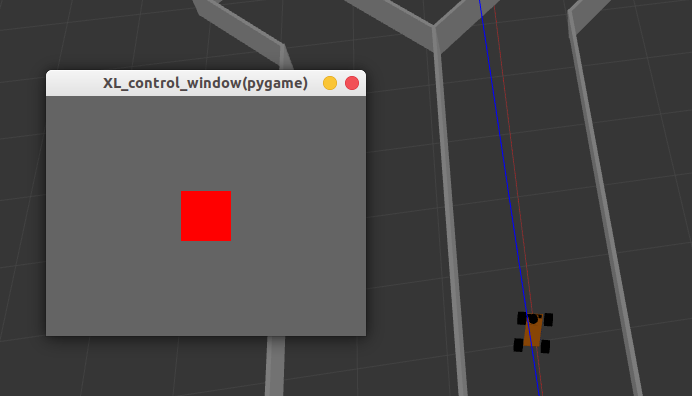

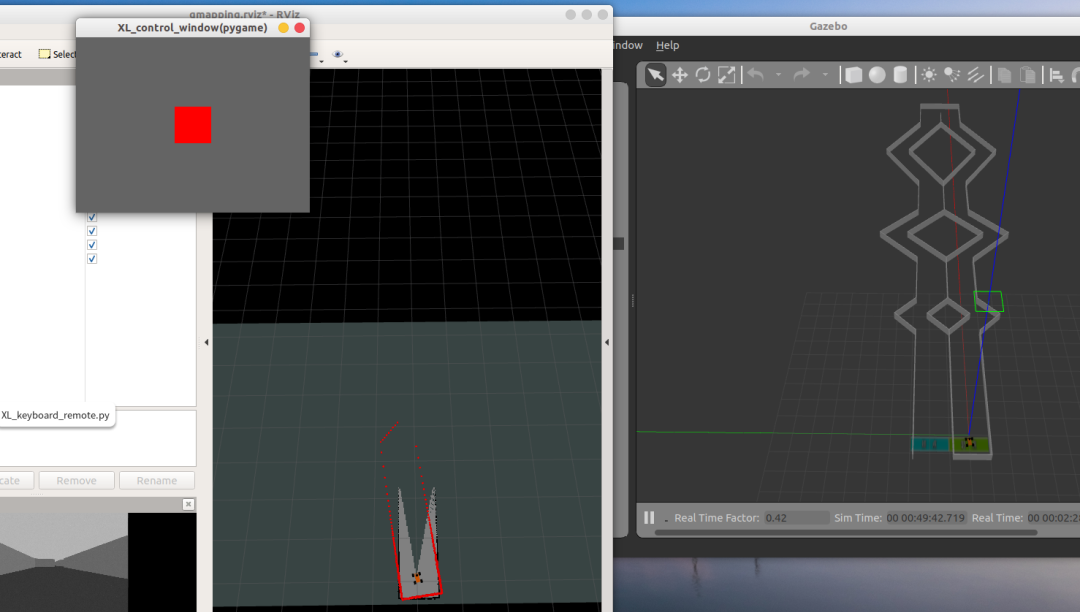

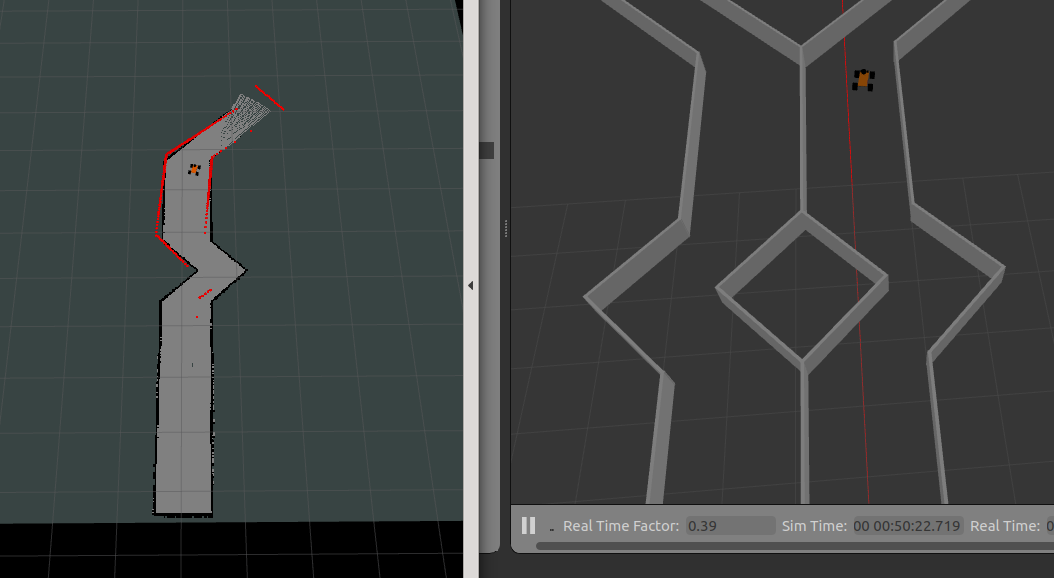

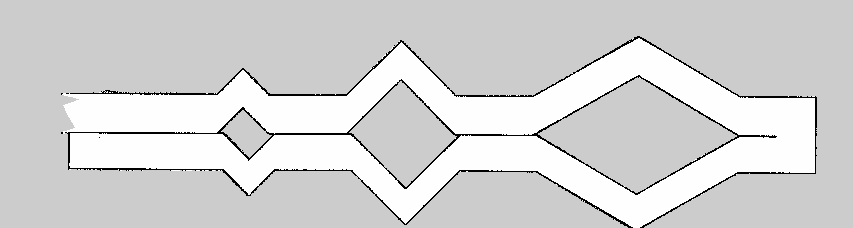

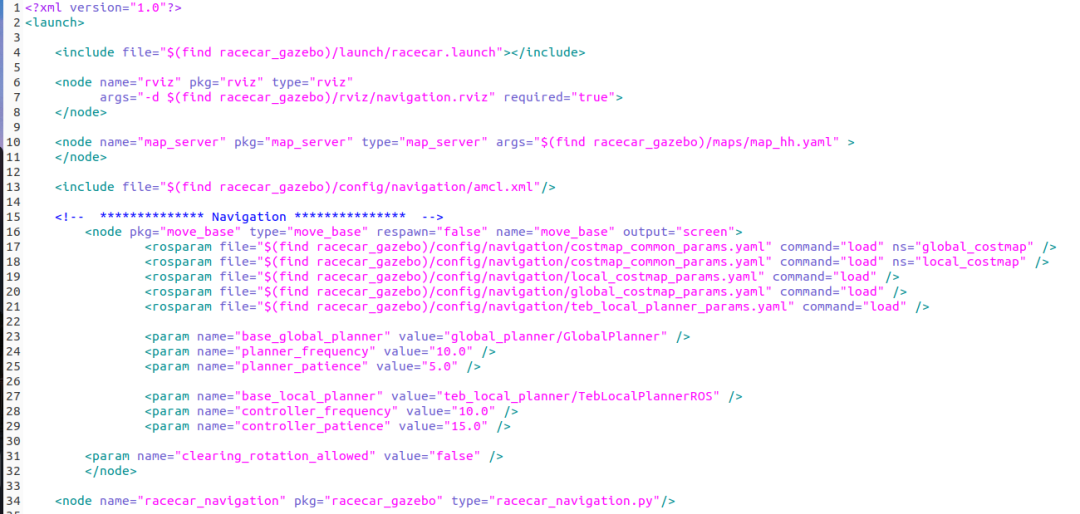

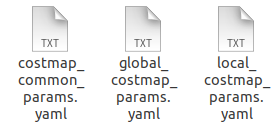

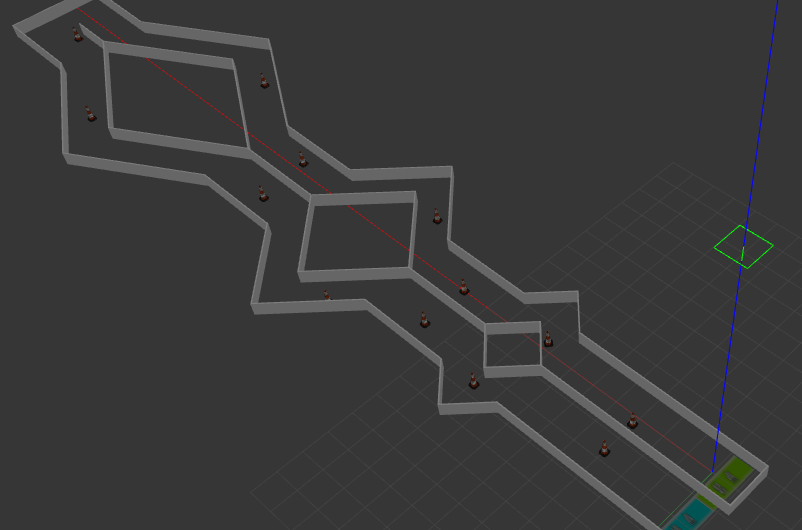

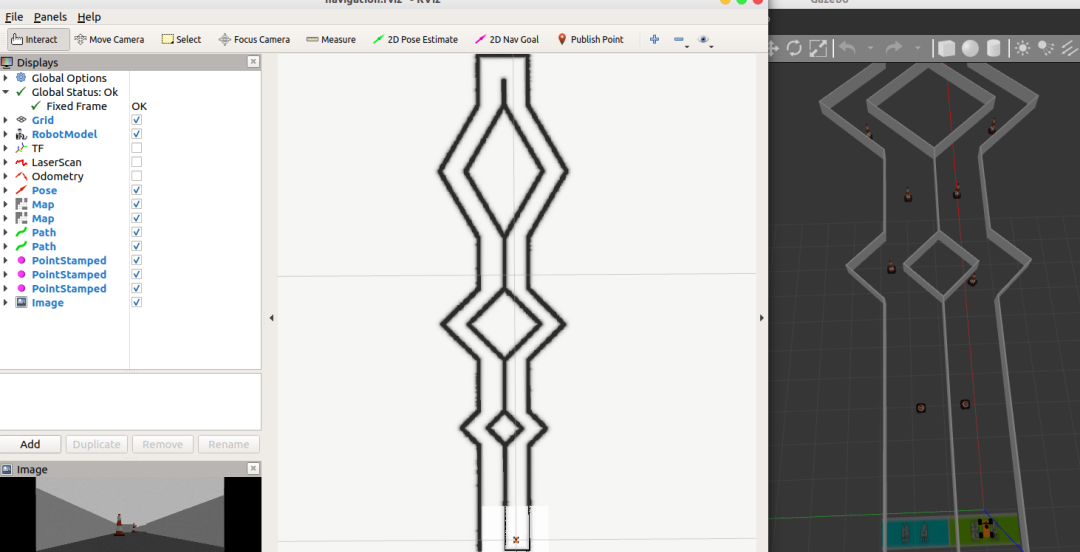

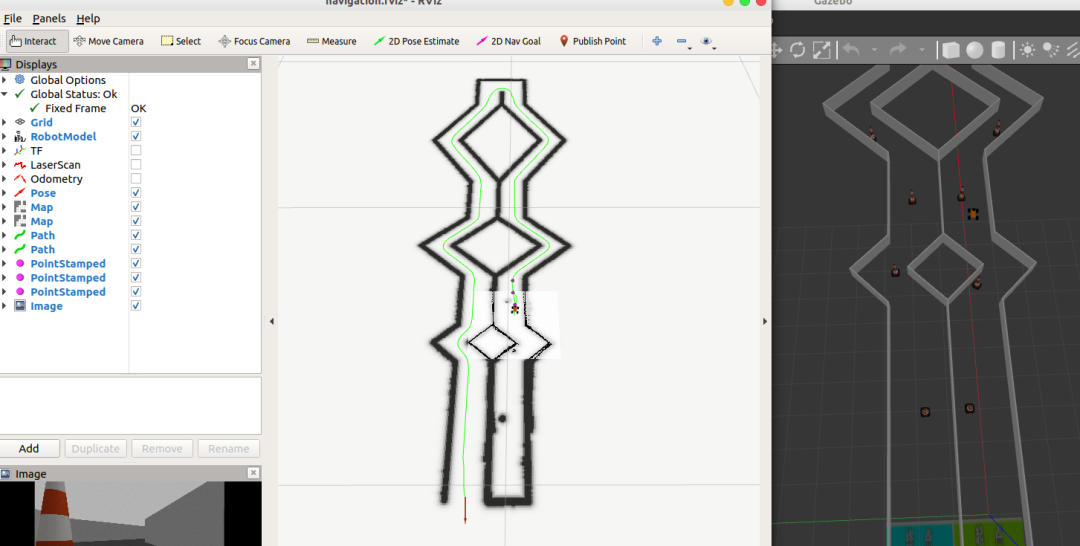

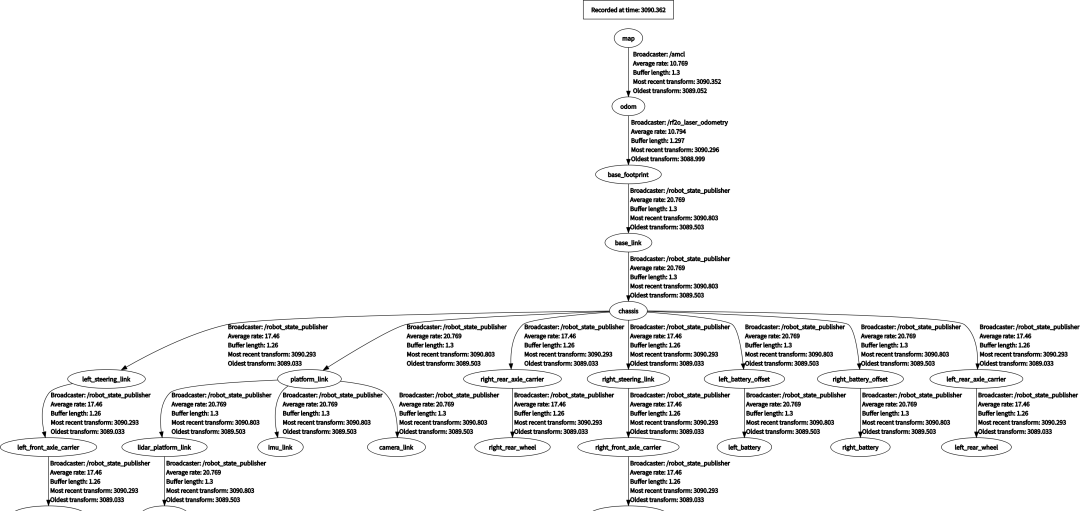

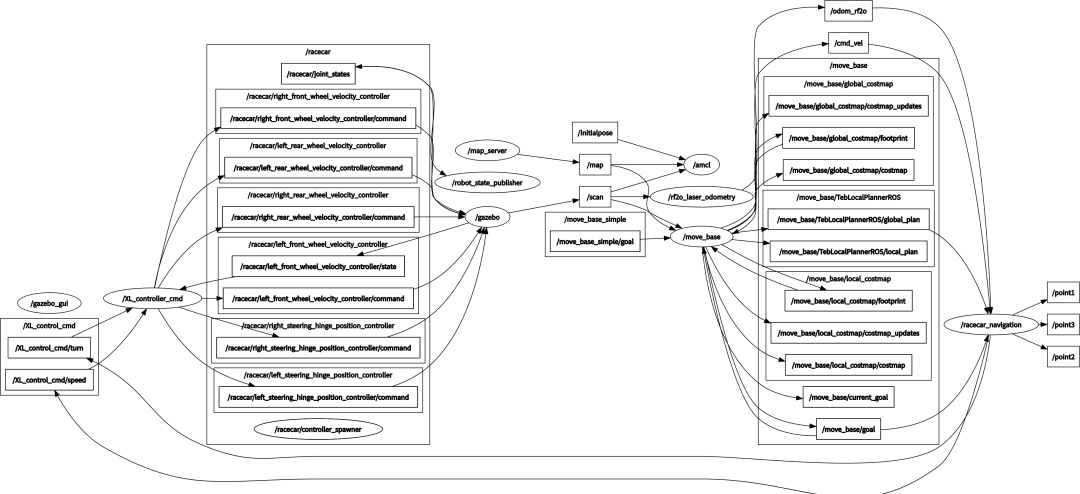

作者:☆下山☆@CSDN 原文:https://blog.csdn.net/qq_45152498/article/details/124296963 原文:基于ROS的机器人建图与导航仿真全过程 01 引言之前一直想写一篇关于ROS机器人建图与导航仿真全过程的教程,终于有时间来做这个事啦,本人也拿过吉林省高校机器人大赛—ROS竞速组的冠军,第十六届全国智能车比赛—讯飞餐厅组线上赛二等奖,我想这个教程对接下来的一些参赛者多多少少也会有一些贡献。 当然我觉得你已经会ROS的一些基本操作了,本文章只是简单扼要的介绍这个过程,其中细节部分难免可能不会太详细还请见谅,当人后续也会有更多这方面的文章,也会传授一些ROS机器人建图与导航方面的经验,当然我也在学习的过程,难免一些不足之处,话不多说啦,让我先把这个全过程的思维导图放在下面。  图片02 环境2.1 机器人建模 图片02 环境2.1 机器人建模我个人习惯把机器人本体放在单独的一个package下,让我们先看看里面的所有东西。  图片 图片可以看到这个机器人的URDF模型还有它所拥有的传感器,相机、惯性测量单元、激光雷达。 我们对URDF文件进行检查,check_urdf命令会解析URDF文件,并且显示解析过程中发现的错误,如果一切正常,就会显示如下信息:  图片 图片当然我们也可以在rviz中查看这个模型:  图片 图片也可以看看机器人的TF关系:  图片2.2 运动控制器配置 图片2.2 运动控制器配置接下来我们主要在gazebo环境下操作,我们再创建一个单独的package,同样我们先看看完整的内容:  图片 图片我们在config下可以看到一个racecar_control.yaml文件: 代码语言:python代码运行次数:0复制racecar: left_rear_wheel_velocity_controller: type: effort_controllers/JointVelocityController joint: left_rear_axle pid: {p: 1000.0, i: 0.00, d: 0.0} right_rear_wheel_velocity_controller: type: effort_controllers/JointVelocityController joint: right_rear_axle pid: {p: 1000.0, i: 0.00, d: 0.0} left_front_wheel_velocity_controller: type: effort_controllers/JointVelocityController joint: left_front_axle pid: {p: 1000.0, i: 0.00, d: 0.0} right_front_wheel_velocity_controller: type: effort_controllers/JointVelocityController joint: right_front_axle pid: {p: 1000.0, i: 0.00, d: 0.0} left_steering_hinge_position_controller: type: effort_controllers/JointPositionController joint: left_steering_joint pid: {p: 10000.0, i: 0.1, d: 500.0} right_steering_hinge_position_controller: type: effort_controllers/JointPositionController joint: right_steering_joint pid: {p: 10000.0, i: 0.1, d: 500.0} joint_state_controller: type: joint_state_controller/JointStateController publish_rate: 50这个文件便定义了机器人所有的运动控制器以及参数,我们通过launch文件添加以下内容便可以加载这些控制器:  图片2.3 world创建 图片2.3 world创建world的创建方法有很多了,你可以自己画一个世界,也可以导入,这里可以给大家安利另外一个仿真神器:Webots,你会发现不一样的东西。 给大家看看比赛的官方赛道吧,使用gazebo racecar_runway_original.world 打开:  图片2.4 launch文件启动并测试 图片2.4 launch文件启动并测试我们先通过roslaunch racecar_gazebo racecar.launch 来打开小车所在的仿真环境:  图片 图片我们可以看到racecar_gazebo/scripts下有一个XL_keyboard_remote.py的,我们可以通过rosrun racecar_gazebo XL_keyboard_remote.py运行它,然后我们的机器人就可以前后左右移动并且转向啦(注意运行之后弹出来的窗口需要鼠标点击一下再控制机器人)。  图片03 建图 图片03 建图建图的话我们以Gmapping算法功能包为例子进行地图构建,当然可以用其它的算法,比如:hector,cartographer等。 3.1 参数配置 首先我们创建一个gmapping.launch,这个主要是负责配置参数的: 代码语言:python代码运行次数:0复制然后我们需要创建一个gmapping_demo.launch用来打开gazebo,rviz等并建图: 代码语言:python代码运行次数:0复制代码第一块就是建图参数的配置,第二块就是打开之前的gazebo环境等,第三块是打开键盘控制,第四块是打开一个已经配置好的rviz(配置的方法很简单的,就是添加一些东西)。 3.2 launch文件启动并建图之所以创建一个gmapping_demo.launch是想直接启动一个launch就可以开始建图,我们直接在终端输入roslaunch racecar_gazebo racecar.launch就可以开始建图啦:  图片 图片建图过程需要有耐心,最好速度不要太快,当然不同的算法适应性也不太一样,我们可以看看建图效果还是可以的:  图片 图片最后建成的地图我们需要及时保存。保存的地图一共有两个文件,map.pgm和map.yaml。 让我们看一下建好的地图效果还是蛮不错的:  图片04 导航 图片04 导航我们先来看一下导航的launch启动文件,第4行就是启动之前的launch文件;第6~8行是加载配置好的rviz;第10行是加载地图;注意第13行,我们加载了一个amcl.xml文件,这个是我们配置的定位方法参数。 自主定位即机器人在任意状态下都可以推算出自己在地图中所处的位置,ROS为开发者提供了一种自适应(或kld采样)的蒙特卡罗定位方法(amcl),这是一种概率统计方法,针对已有地图使用粒子滤波器跟踪一个机器人的姿态;第16~32行是导航需要的配置文件;第34行是一个导航脚本(自定义的一个ROS节点),初学者可以不用深究其内容。  图片4.1 代价地图的配置 图片4.1 代价地图的配置导航功能包使用两种代价地图存储周围环境中的障碍信息:一种用于全局路径规划(global_costmap),一种用于本地路径规划和实时避障(local_costmap)。 两种代价地图需要使用一些共用的或独立的配置文件:通用配置文件、全局规划配置文件和本地规划配置文件。config/navigation下这三个文件分别与之对应。  图片 图片代价地图用来存储周围环境的障碍信息,其中需要声明地图关注的机器人传感器消息,以便于地图信息的更新。 针对两种代价地图通用的配置选项,创建名为costmap_common_params.yaml的配置文件。全局规划配置文件用于存储配置全局代价地图的参数,命名为global_costmap_params.yaml,本地规划配置文件用来存储本地代价地图的配置参数,命名为local_costmap_params.yaml。 4.2 本地规划器的配置比赛一般都需要实时避障的,我们导航所用的地图都是加上锥桶的,当然我们在建图的时候是不允许扫描锥桶的信息的,所以我们需要配置本地规划器,我们通过gazebo racecar_runway.world 打开环境如下:  图片 图片常用的本地规划算法有TEB算法和DWA算法,这篇教程主要用的TEB算法,本地规划器当然也是用的TEB算法的参数,具体可以查看最后一个配置文件teb_local_planner_params.yaml。 4.3 launch文件启动并导航我们通过roslaunch racecar_gazebo racecar_navigation.launch来开始导航前所有准备工作:  图片 图片通过rviz上2D Nav Goal来给机器人发布导航终点信息,可以看出机器人已经开始实时扫描信息并规划路径向着终点出发啦:  图片 图片我们可以通过rosrun rqt_tf_tree rqt_tf_tree来查看导航过程中的TF树:  图片 图片也可以通过rosrun rqt_graph rqt_graph来查看导航过程中的各节点:  图片 图片1. 书籍推荐-《机器人编程:使用树莓派3和Python构建和控制自主机器人》 2. 书籍推荐-《机器人感知与认知中的深度学习》 3. 从ChatGPT思考自动驾驶将如何前行 4. 一文带你了解机器人是如何通过视觉实现目标跟踪的! 5. 激光雷达中是如何做到和GPS时间同步的? 6. BEV感知中的视觉-毫米波雷达融合综述 |

【本文地址】

今日新闻 |

推荐新闻 |