全浸没式液冷集群?没错,这东西被阿里搞成了 |

您所在的位置:网站首页 › 阿里巴巴服务器 › 全浸没式液冷集群?没错,这东西被阿里搞成了 |

全浸没式液冷集群?没错,这东西被阿里搞成了

|

2012年,我受邀去美国德州TACC超算中心参观当时位居全球TOP10的一台超级计算机。在参观的间隙,我偷喵了一眼隔壁房间,发现了一个神奇的存在——全浸没式液冷。 德州超算的全浸没式液冷集群 话说,虽然早就知道有这么一种散热方式,但第一次看到的时候我还是懵X的,毕竟这个东西还只是“传说中”的产品,还是概念机。 后来参加超算大会多了,从德国的ISC到美国的SC大会,每年都有几家厂商展示全浸没式液冷。虽然这些产品大多基于单机设计,这样的散热方式依然是阳春白雪,但至少意味着它已经走下“神坛”,开始进入大众的视野。 直到前年,在SC15上,大量服务器厂商展示浸没液冷概念机,我才真正觉得全浸没的时代已经可以看得到了。不过又是两年时间过去了,如今绝大部分数据中心还在使用风冷散热,部分高端的设备虽然采用了冷板式的液冷,但是全浸没的方式距离应用还有很长一段时间。 PUE逼近1.0 阿里巴巴全浸没液冷集群现身 直到我看到一篇报道,说是阿里巴巴已经开始了这方面的小规模集群应用。

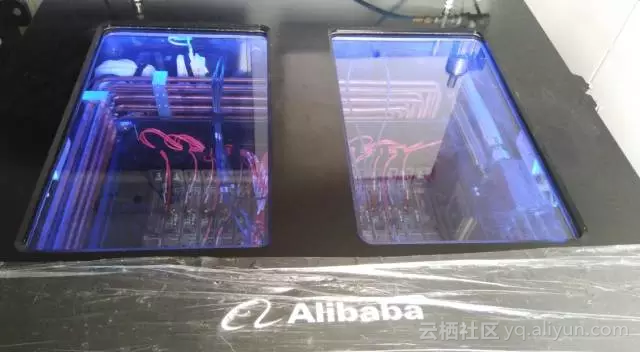

阿里技术官方微博全浸没液冷集群照片 日前,一条全浸没液冷的消息引爆了大嘴哥的朋友圈,许多圈内的朋友纷纷转发了阿里巴巴构建全浸没液冷集装箱数据中心的消息。据报道,这是阿里巴巴应对未来高密度、高能耗的大规模计算的一种尝试,也代表了未来数据中心行业发展的大趋势。 刚看到这则消息的时候,我有点震惊:莫非这种传说中的黑科技真的被阿里投入商用了?但是转念一想,如果说中国真正能够将黑科技转化为商用的,恐怕也只有阿里这样级别的企业了。 在过去的18年中,阿里在电商取得的成绩,离不开技术的支持,由此才有“阿里巴巴也许是一家被电商才华掩盖的科技公司”这种说法。。就在前不久,阿里启动了一项内部代号为“NASA”的计划,组建强大的独立研发部门,为服务20亿人的新经济体储备核心科技。这些核心技术包含了人工智能、量子计算与通信、生物识别、区块链、金融级数据库等。就像马爸爸说的那样,“我们必须突破、必须创新”。就这样,阿里把技术跟着业务走的模式,转变为真正的技术驱动模式,以“解决10年20年后的困难” 。 全浸没式液冷服务器作为支撑“NASA”行动计划的基础架构正在其中。有数据显示,仅在2015年,全国数据中心的耗电量就高达1000亿度,年耗电量超过全社会用电量的1.5%,相当于整个三峡水电站一年的发电量。因此,如何降低数据中心的能耗已经成为全行业关注的问题,而全浸没模式液冷的出现也为数据中心创造了新的发展前景。 带着太多的疑惑与期待,凭借着对全浸没液冷的认知与兴趣,我有幸采访到了该项目负责人:阿里巴巴服务器产品高级专家钟杨帆(花名“炽平”)。 事情还要从4月5日说起。当天,阿里技术官方微博发布了一条消息并配图3张,称这是一款黑科技产品,会创造多个业界记录,并将支撑阿里巴巴的“NASA”行动计划。

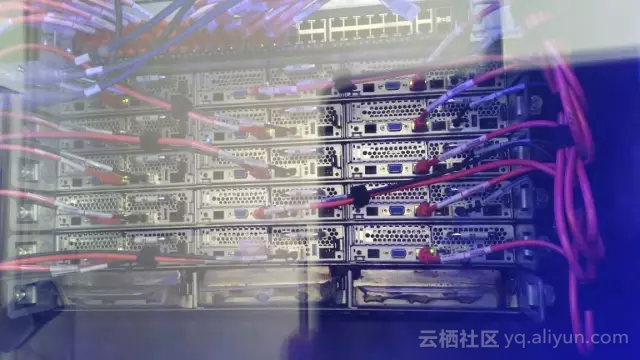

阿里巴巴全浸没液冷服务器集群 “你们怎么想到做这个产品?在许多人看来,全浸没只是一种未来的概念而已”,我问炽平。 “你知道的,如今数据中心的能耗已经成为了大家关心的问题,不仅仅是服务器、存储、网络设备的功耗,包括空调、供电等等系统的散热都是大家关心的问题。我们正处于从IT时代到DT时代的转变,可以预见的是未来能耗问题将会越来越突出。我们这个项目就是希望前瞻性的解决能耗的问题。” 说起来容易做起来难。就像开头我曾经提到的,虽然全浸没式液冷已经不算是什么“黑科技”,但是真正应用还是非常遥远。受限于技术实现的难度,目前参与浸没液冷服务器设计的企业,对浸没液冷的应用也仅局限于单机测试、单机展示阶段,从目前公开的信息看,并无服务器集群部署先例,更别提搭建数据中心了。按照炽平的说法,他和他的团队成为了“第一个吃螃蟹的人”。 其实,炽平这个想法由来已久。早在2015年年初,炽平和团队就意识到了能耗制约的关键性问题,并且积极尝试解决的办法。为此,他多次与供货商沟通,按照全浸没式液冷的应用需求定制主板、线缆和机箱设备。就这样,这个不到20人的团队忙了足足两年时间,才有了我们今天看到的成绩。 起初,我以为炽平他们采用集装箱的方式或许是迎合未来发展的需求,或者是出于应用的考虑。后来我才知道,对于这样前瞻性的项目来说,如何搭建数据中心是一个悬而未决的问题,作为业界的先行者,项目组也没有成熟的案例可供参考。”集装箱简单嘛,不需要太多的设计,方便快捷“,炽平说。 阿里巴巴全浸没液冷服务器集群近照 就这样,经过2年时间的努力,炽平在阿里巴巴西溪园区的楼顶部署了这款世界第一个服务器集群。集群中的服务器全部是定制化产品。经过测试,全浸没式集群的散热效果相比传统风冷实现了飞跃式的提升, 系统PUE逼近理论极限值1.0 “我们的系统PUE逼近理论极限值1.0,说起这件事的时候,炽平表现得很自豪。PUE是Power Usage Effectiveness的缩写,是评价数据中心能源效率的指标,也是数据中心消耗的所有能源与IT负载使用的能源之比。一般情况下,PUE的基准是2,越接近1表明能效水平越好,IT系统的运行更高效。 如今,业内采用风冷模式的数据中心大概都在1.8-1.9的水平,PUE低于1.6的数据中心就已经算是“节能高效”的代表了。那么逼近理论极限值1.0是什么概念呢?就相当于所有的散热设备功耗都已经可以忽略不计了。 这的确是一项了不起的成就。虽然现在IT系统的计算性能已经非常强劲,咱们家里的电脑早就已经没有性能上的更新需求,但是对于许多企业级应用来说,IT基础设施提供的性能还是远远不够的,比如在超算领域。

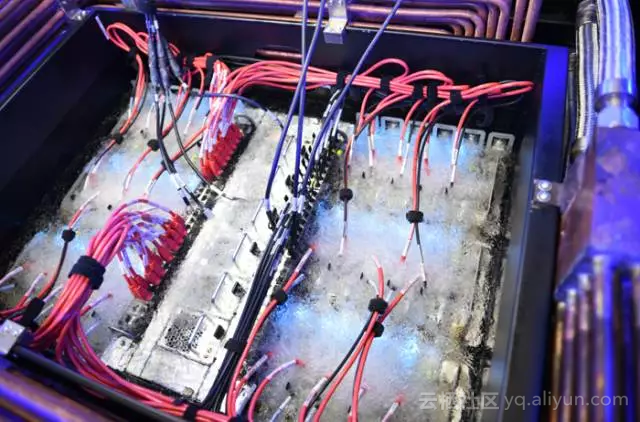

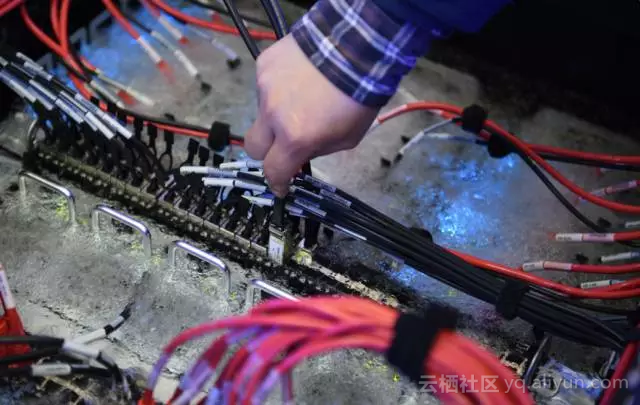

阿里巴巴全浸没液冷服务器集群液体达到沸点的样子 大家或许知道,从天河一号A开始,中国在国际超算的舞台上就频频夺冠,天河二号超级计算机曾经六次荣膺全球超算TOP500榜单的第一名,如今的神威太湖之光也已经梅开二度。但是它们的计算性能还远没有满足人类的需求。在实现百亿亿次计算的道路上,人类面临了许多的问题,无论国内还是国外,一堵”能耗墙“就已经挡住了整个业界前进的脚步。能否解决能耗问题,成为了人类能否迈向E级时代的关键因素之一。 如今,阿里巴巴找到了通过”能耗墙“的金钥匙——全浸没式液冷。据炽平透露,虽然看起来全浸没式液冷需要重新定制特殊规格的服务器,需要重新设计供电与散热模式,还要考虑到冷却液如何循环运行,但是从总体拥有成本来说,全浸没式液冷可以大大节省用户的投资。 不仅如此,面对这样飞跃式的发展,阿里巴巴甚至打算重新定义“PUE”的内涵,也正在酝酿全新的公式法则。或许很快将成为新一代全浸没液冷的新型计算标准,实现更精准化的绿色节能。 全浸没液冷的三大门槛 除了硬件外,阿里巴巴还同期设计了一套适合浸没液冷的监控管理系统,这样管理起来也更加高效。当然,炽平也没有一味的夸奖全浸没式产品的优点。事实上,也并非每个公司或数据中心都有能力采用这样的技术,全浸没式液冷的准入门槛也很高。 首先是硬件基础设备的定制——不仅仅是服务器产品,未来包括存储、网络等其他IT基础设施都要为全浸没式液冷实现专门的定制化。 其次是高效的管理和运维——在全浸没式液冷系统中,原有的风冷环境管理软件已经完全不适用了,从系统监控到维护,都需要有单独开发的软件。因为全浸没式系统是密封结构,所以对于系统内部的液体温度、气压也都需要重新监控,要依赖专门开发的软件来实现。 最后是数据中心的建设——全浸没式液冷的特性在于散热效果好,系统密度高,延迟低。而要实现这些特性,就需要单台系统中尽可能容纳更多的计算、存储节点,进而需要机房承重、供电系统的同步配套。 阿里巴巴工作人员正在作业 由此看来,全浸没式液冷虽然更安静、更省钱、更高效,但是对于应用者的设计能力、技术能力和自建机房的能力也都提出了更高的要求,非大型公司、有技术实力的客户不能应用。就当下的态势来说,也就是这几家互联网巨头可以实现全浸没式液冷。 炽平表示,目前阿里巴巴已经在整机柜服务器技术规范上形成了原创设计思想积累,在结合自身需求以及在自研数据中心的积累后,也将快速设计出符合自己需求的浸没液冷服务器整套解决方案,并进行集群化实践。 当然,这也并非是凭借阿里巴巴一己之力就能够实现的,阿里更多是站在未来发展视角,整合产业资源去实现前瞻性的创新,再通过阿里云等业务平台让更多人享受到液冷的收益。而对整个产业来说,更需要开放的标准来推动产业的发展,也需要更多人的加入让整个产业实现普惠效果,进而影响到更多的人,让更多的企业参与其中,从而实现行业的变革。 阿里巴巴工作人员将手伸进沸腾的液体中 “阿里巴巴进行了浸没液冷的新材料技术研究,液冷服务器架构设计以及液冷数据中心整体方案重构”。据炽平介绍,在看到全浸没式液冷如此高效的运行能力之后,阿里巴巴准备在未来几年内大规模的采用这种技术,预计可能在张北数据中心内部署上千个节点用来运行实际业务。 “我们目前完全是摸着石头过河,但是我们坚信这条路是正确的,而且是应对未来DT时代数据大爆发的最佳方式。当然,全浸没式液冷系统还需要整个产业链的支持,我们也希望联合包括BAT在内的其他企业和供应商,从硬件设计到平台管理到机房设计打造行业应用标准,实现产业联盟”,炽平说。 写在最后的话 尽管对于炽平的采访只有半小时的时间,但是给我留下的印象却非常深刻,特别是我早已经了解这项技术的情况下。做一台系统可能不难,做十台系统可能也简单,但是一百台、一千台、一万台呢?数量的增长可能带来的是几何倍数的问题,或许也只有阿里巴巴这样高科技的企业能够应对巨大未知的挑战。 我们处在一个技术创新的临界点,(发展方向)将从工程技术到核心科技——阿里巴巴集团首席技术官张建锋 近年来,阿里巴巴一直致力于绿色数据中心的技术创新,实现对能源的节约。2015年投入运营的华东某数据中心采用深层湖水制冷,年均PUE低于1.3。近日由阿里云对外开放服务的华北3数据中心则充分利用环境优势,大面积采用新风自然冷和水侧自然冷技术,年均PUE低于1.25。此次的浸没液冷,更是将PUE推向理论极限值1.0。有些人可能担心全浸没式液冷的安全问题,事实上这种来自于3M的氟化液已经成为了业内许多企业和玩家的最佳选择,并且经受了事实的检验。 在我看来,全浸没式液冷的大规模商用会为全国数据中心乃至全球打开一扇全新的大门。就像我们之前提到的,这种商用模式被证实可行,将对现有的数据中心运营模式、数据中心基础设施造成毁灭式的冲击,会带来摧枯拉朽式的行业变革,我们也必然会迎来全新的液冷应用时代。 如果能耗的问题可以得到遏制乃至解决,现有的计算能力将会实现大幅度的飞跃。可能到时候不仅仅是省下几个三峡大坝的电量,而是计算力得到解放,更高主频、更多核心处理器、更大规模的超级计算机将会出现,从而带来科技飞速发展,乃至于人类社会的大踏步前进。 你好,全浸没式液冷时代。原文转自IT大嘴巴 |

【本文地址】