Aerial Vision |

您所在的位置:网站首页 › 轨迹mp3 › Aerial Vision |

Aerial Vision

|

Aerial Vision-and-Dialog Navigation

本次报告,包含以下部分:1摘要,2数据集/模拟器,3AVDN任务,4模型,5实验结果。重点介绍第2/3部分相关主页:Aerial Vision-and-Dialog Navigation (google.com) 包含,code,paper,dataset

一,摘要

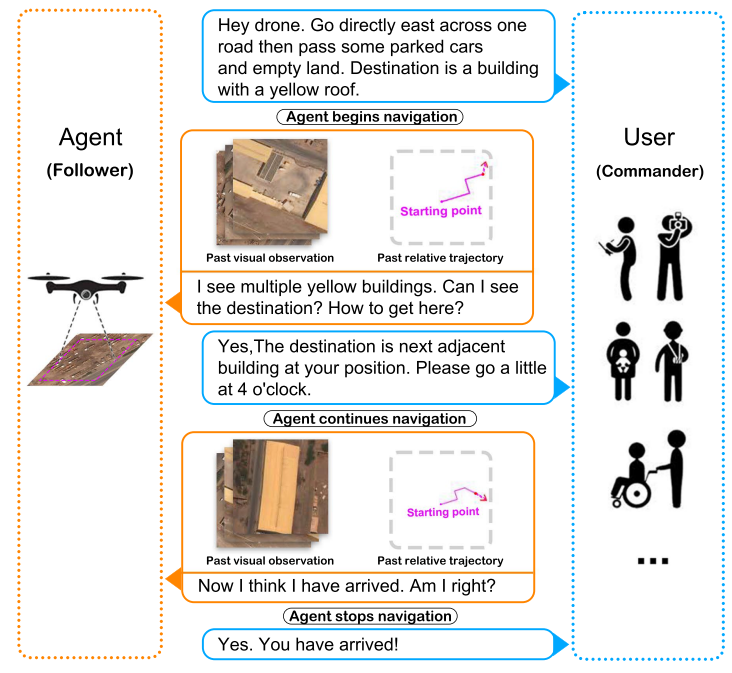

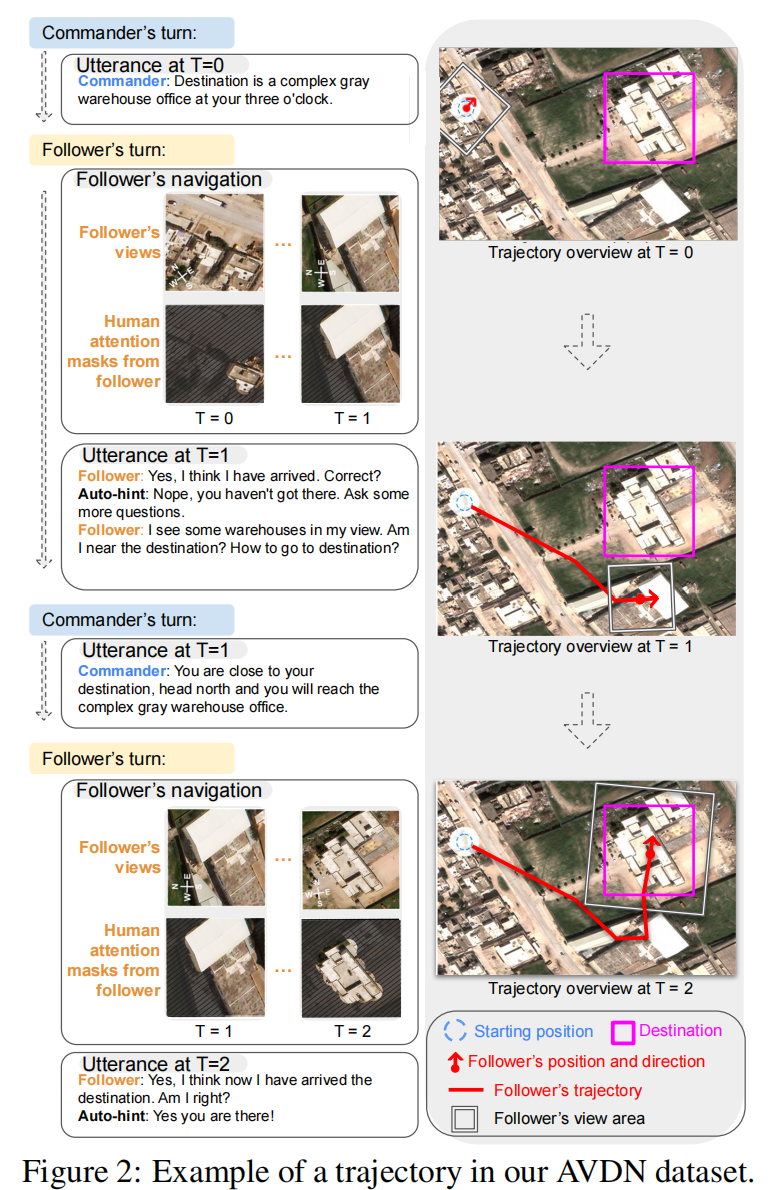

这一部分将论文中的摘要,引言,相关工作,合并介绍 本文提出了一个空中/对话/导航任务,其目的是解放双手来控制无人机。为了完成这个任务,作者创建了一个来自真实图片的 连续场景的 无人机模拟器 和 一个具有3064条条轨迹的对话数据集。在对话的过程中,commander(用户角色)提供初始的导航指令和进一步的指导。fellower(无人机角色)在必要的时候提问。在此基础上,作者提出了两种空中导航任务,一种是ANDH,另一种是AVDN-Full,区别是AVDN-Full是直接给出所有的完整的对话历史预测到达目的地的导航轨迹,AVDN是使用逐轮对话进行子轨迹的导航,从而完成导航到最终目的地的完整任务。作者还提出了一种结合人类注意力预测的transformer-based模型来预测waypoints。 图一简单介绍了一个AVDN任务的例子 数据集/模拟器是 任务 的基础,提出的任务不能超过数据集/模拟器的能力范围 figure 2 AVDN 和R2R任务相似,模拟器的构建需要基于一个开源的大规模3D数据集。 而AVDN任务需要的模拟器,是基于 xView数据集 构建的 (一个开源的,大规模的卫星图像目标检测数据集) Response for Q1: 模拟器能够提供那些功能 模拟器提供的是一个自上而下的视角,模拟环境是一个连续的环境,无人机可以移动到环境中的任何点,所以模拟器提供的是具有丰富视觉内容的连续帧。无人机还可以通过键盘控制,无人机观察到的视觉内容可以被实时展示。控制过程中,用户还可以通过点击他们关注的区域来关注界面显示的图像。除此之外,如图2展示的那样,我们的模拟器能够生成commander视图,观察到起始点,目标区域,当前的视图,过去的行动轨迹。 2.2 数据集 2.2.1 数据集结构Response for Q1: 数据集有哪些信息 数据集包含了导航轨迹 (time step(T)= 0, 1, 2……M): T=0时,commander提供一个初始指令。相邻的时间步之间存在对应的导航子轨迹。在中间的每一个时间步(0 \hat{u}_0, \hat{u}_1,, , ,\hat{u}_{j-1}> u^0,u^1,,,,u^j−1>, 目标区域和当前的导航time step有关, 3.2 AVDN-Full

3.2 AVDN-Full

和AVDN的区别是,AVDN-Full的输入是整个导航对话和视觉内容,agent需要预测一个完整的(从起始点 u 0 0 u_0^0 u00到目标区域Des)轨迹, 所以,AVDN-Full为agent提供完整的监督,包括了更精确的目的地描述,更长的表达,更复杂的视觉grounding挑战。 3.3 评估指标SR成功率和SPL(导航轨迹和导航路径长度加权)都是最基本的导航指标。 GOAL progress是对话导航独有的评估指标,用来评估通往目的地进展的距离,其实就是轨迹的欧拉距离减去预测中心到目标区域的距离。 四,模型不细讲模态的编码方法,重点在于讲解模型预测的输入输出流程,阅读时请结合模型流程图

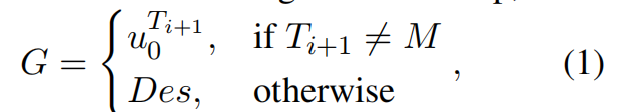

输入来自三个模态,无人机接收到的方向,图像和历史对话。 起始的时候,接收整个对话历史,包含question和指令。 在每个时间步,之前的方向和图像都被输入到模型中。其中,使用一种卫星图像的预训练模型提取图像编码,整个模型总体上和ET(21年提出的室内导航方法)类似。 多模态的总体输入输出可以表示为 { z 1 : L l , z 1 : t v , z 1 : t x } = F M T ( { z 1 : L l , z 1 : t v , z 1 : t x } ) \{z_{1:L}^l, z_{1:t}^v, z_{1:t}^x \} = F_{MT}(\{ z_{1:L}^l, z_{1:t}^v, z_{1:t}^x\}) {z1:Ll,z1:tv,z1:tx}=FMT({z1:Ll,z1:tv,z1:tx}) 这里的输出不是最终的预测结果,而是一种融合跨模态特征表示。 至于导航进度 g ^ \hat{g} g^,用于决定何时停止。如果导航进度大于阈值,无人机将结束导航,不执行预测waypoint的动作 导航预测和waypoint控制导航输出是 ( w ^ , g ^ ) = F N D ( { z 1 : L l , z 1 : t v , z 1 : t x } ) (\hat{w},\hat{g})=F_{ND}(\{z_{1:L}^l, z_{1:t}^v, z_{1:t}^x \}) (w^,g^)=FND({z1:Ll,z1:tv,z1:tx}) 其中, w ^ \hat{w} w^是一个3D坐标(x,y,h)x,y表示位置,h表示高度。 预测的waypoint也控制着无人机的方向,方向朝着移动的方向。因此, w ^ \hat{w} w^也控制着无人机的移动,下一个视图中心,宽度和旋转由 w ^ \hat{w} w^决定。 人类注意力预测(human attention predication)Q 6:人类注意力是怎么得到的?怎么使用的? 使用 z 1 : t v z_{1:t}^v z1:tv作为输入,编码后预测一个和图像维度大小相同的mask,值越大表示越关注该区域。 Training首先训练AVDN任务,再训练AVDN-Full任务 waypoint( w ^ \hat{w} w^)和导航进程( g ^ \hat{g} g^)预测使用下面公式训练 人类注意力预测使用下面公式训练: 其中,P是预测的human attention mask,Q是ground truth mask 五,实验结果在AVDN和AVDN-Full上的预测结果

Q 6:任务的局限性是什么? 文中指出的任务局限性在于隐私泄露 |

【本文地址】

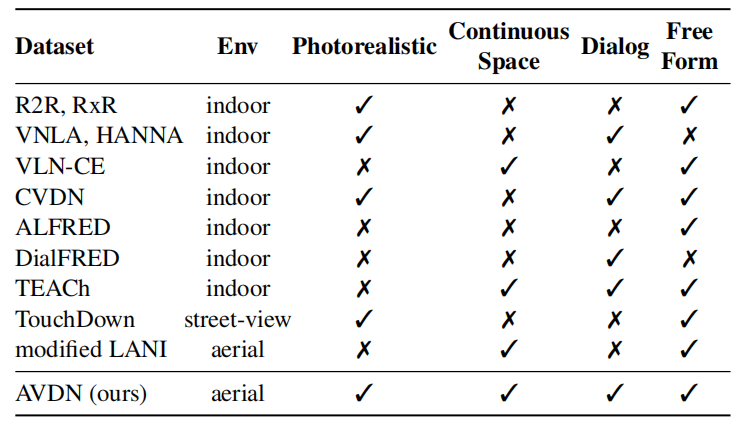

表一中,本文提出的数据集AVDN跟其他VLN数据集进行了比较:

表一中,本文提出的数据集AVDN跟其他VLN数据集进行了比较:

Response for Q1: 模型的流程,输入输出是什么

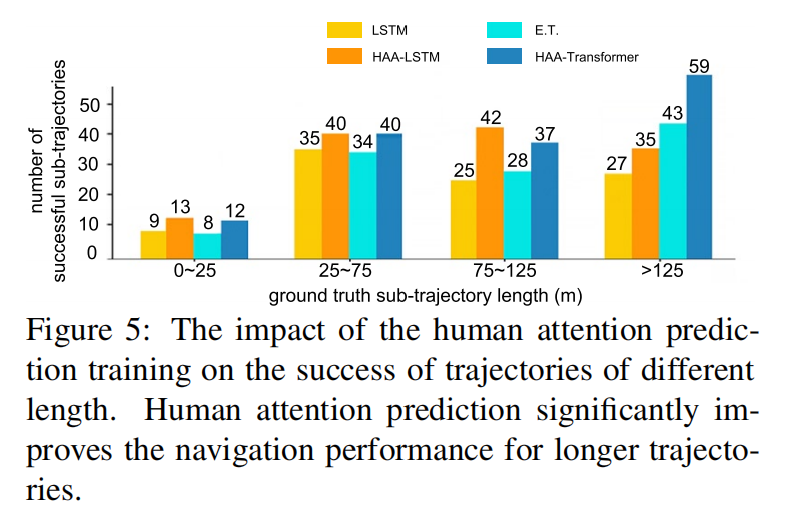

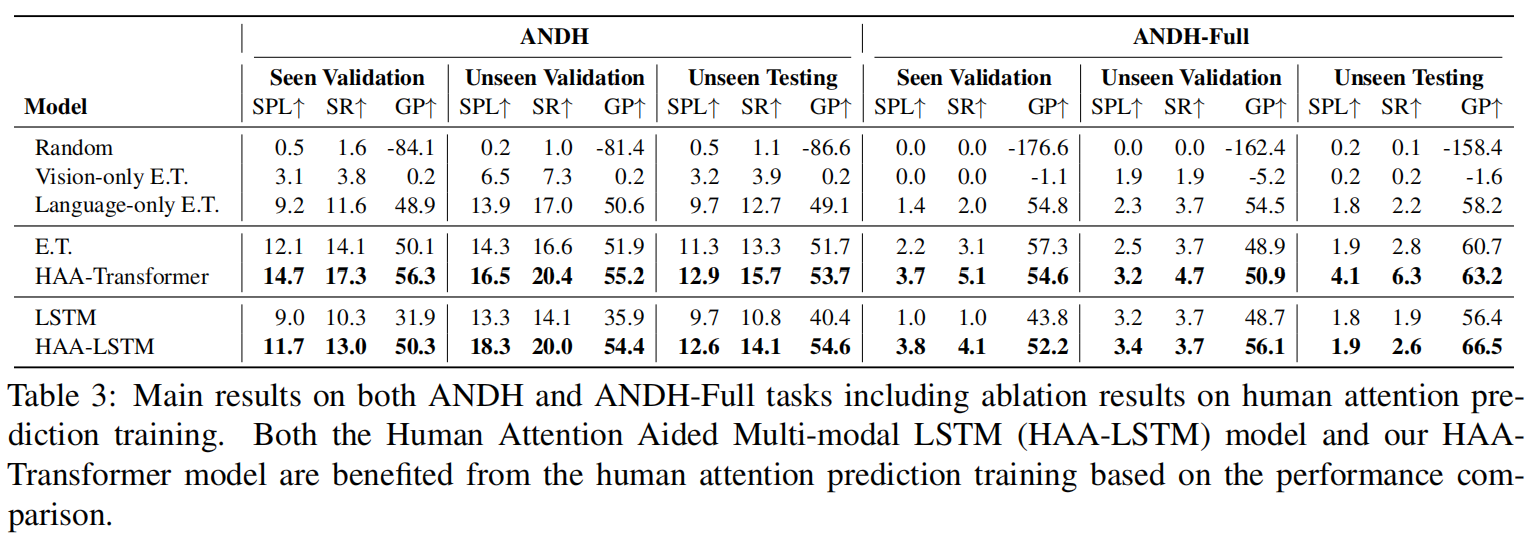

Response for Q1: 模型的流程,输入输出是什么 实验还证明了,注意力预测有助于最终的导航成功率

实验还证明了,注意力预测有助于最终的导航成功率