❀论文篇 ❀ 2010 |

您所在的位置:网站首页 › 苹果下载不了115网盘怎么回事 › ❀论文篇 ❀ 2010 |

❀论文篇 ❀ 2010

|

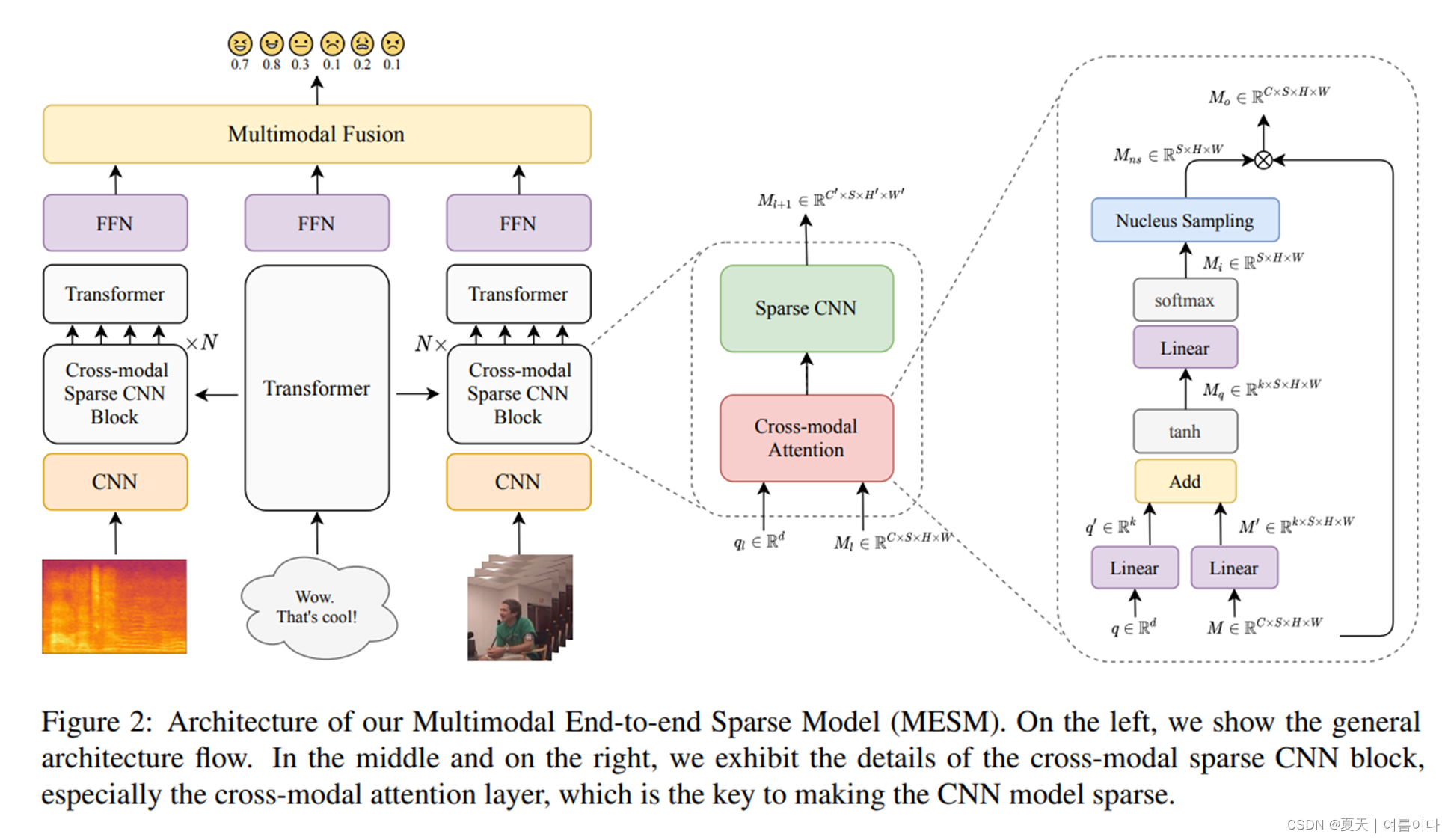

情绪识别目前我所了解的有,基于人脸的情绪识别,基于声音的情绪识别,基于身体特征的情绪识别,基于脑电波的情绪识别,基于时空的情绪识别等。 这篇博客主要是人脸表情/情绪识别(Face expression recognition/emotion recognition)/一般人脸情绪识别我自己把它分为image FER和 动态FER 。有的虽然是实时检测人脸识别,因为输入是图片(image),如果输入的是视频为基础,或者带时间维度参数则属于动态人脸情绪识别。(仅表达自己分类标准,有问题可以指出) ************************************************************************************************************** 1.情绪识别概述论文************************************************************************************************************** 1.1A survey of multimodal sentiment analysis,2017 下载地址:https://reader.elsevier.com/reader/sd/pii/S0262885617301191?token=5BF20B95A96A872066288B54ADCC85546CA4FE8E90C155934C1164AB5C38F2976B703485DF31D133EF7E0485989977E8&originRegion=us-east-1&originCreation=20220405111700 1.2.Distinguishing between facts and opinions for sentiment analysis: Survey and challenges,2018 下载地址:Elsevier Enhanced Reader 1.3.Facial Emotion Recognition: A Survey and Real-World User Experiences in Mixed Reality,2018 下载地址:https://www.mdpi.com/1424-8220/18/2/416 1.4.Deep Facial Expression Recognition: A Survey,2020 下载地址:https://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=9039580 1.5.EEG-Based BCI Emotion Recognition: A Survey,2020 下载地址:Sensors | Free Full-Text | EEG-Based BCI Emotion Recognition: A Survey 1.6.Emotion Recognition and Detection Methods: A Comprehensive Survey,2020 下载地址:https://iecscience.org/uploads/jpapers/202003/dnQToaqdF8IRjhE62pfIovCkDJ2jXAcZdK6KHRzM.pdf 1.7.A survey on: Facial Emotion Recognition and Classification,2021 下载地址:https://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=9418349 1.8.Macro- and Micro-Expressions Facial Datasets: A Survey ,2022 下载地址:Sensors | Free Full-Text | Macro- and Micro-Expressions Facial Datasets: A Survey ************************************************************************************************************** 2.静态FER 论文************************************************************************************************************** 2.1.Peak-Piloted Deep Network for Facial Expression Recognition,2016 下载地址:https://link.springer.com/content/pdf/10.1007/978-3-319-46475-6_27.pdf 2.2.Deeper cascaded peak-piloted network for weak expression recognition, 2017 下载地址:https://www.researchgate.net/profile/Zhenbo-Yu-2/publication/319989401_Deeper_cascaded_peak-piloted_network_for_weak_expression_recognition/links/5a264aafa6fdcc8e866bcf1b/Deeper-cascaded-peak-piloted-network-for-weak-expression-recognition.pdf 2.3.Emotion recognition using facial expressions ,2017 下载地址:Elsevier Enhanced Reader 2.4.Efficient Facial Expression Recognition Algorithm Based on Hierarchical Deep Neural Network Structure ,2019 下载地址:https://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=8673885 2.5.Deep-Emotion: Facial Expression Recognition Using Attentional Convolutional Network ,2019 下载地址:https://arxiv.org/pdf/1902.01019.pdf 2.6.Facial expression recognition using human machine interaction and multi-modal visualization analysis for healthcare applications,2020 下载地址:Elsevier Enhanced Reader 2.7.Meta Auxiliary Learning for Facial Action Unit Detection,2021 下载地址:Meta Auxiliary Learning for Facial Action Unit Detection | IEEE Journals & Magazine | IEEE Xplore ************************************************************************************************************** 3.动态的人脸情绪识别论文************************************************************************************************************** 3.1.Facial Expression Recognition Based on Deep Evolutional Spatial-Temporal Networks,2017 下载地址:https://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=7890464 3.2.Spatio-temporal convolutional features with nested LSTM for facial expression recognition,2018 下载地址:Elsevier Enhanced Reader 3.3.Learning Unseen Emotions from Gestures via Semantically-Conditioned Zero-Shot Perception with Adversarial Autoencoders,2020 下载地址:https://arxiv.org/pdf/2009.08906.pdf 3.4.A Spatio-temporal Approach for Apathy Classification ,2021 下载地址:https://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=9438658 ************************************************************************************************************** 4.视听情绪识别论文************************************************************************************************************** 4.1.Audio-Visual Emotion Recognition using Deep Transfer Learning and Multiple Temporal Models,2018 下载地址:Audio-visual emotion recognition using deep transfer learning and multiple temporal models | Proceedings of the 19th ACM International Conference on Multimodal Interaction 4.2.Audio-Visual Emotion Recognition in Video Clips,2019 下载地址:Audio-Visual Emotion Recognition in Video Clips | IEEE Journals & Magazine | IEEE Xplore ************************************************************************************************************** 5.多模态的情绪识别论文************************************************************************************************************** 5.1.Fuzzy commonsense reasoning for multimodal sentiment analysis,2019 下载地址:Elsevier Enhanced Reader 5.2.Multitask Emotion Recognition with Incomplete Labels,2020 下载地址:https://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=9320257 5.3.Memory Based Fusion for Multi-modal Deep Learning,2020 下载地址:Elsevier Enhanced Reader 5.4.Facial Expression Recognition and Image Description Generation in Vietnamese,2021 下载地址: https://ebooks.iospress.nl/pdf/doi/10.3233/FAIA210176 5.5.Multimodal End-to-End Sparse Model for Emotion Recognition ,2021 论文地址:2103.09666.pdf (arxiv.org)

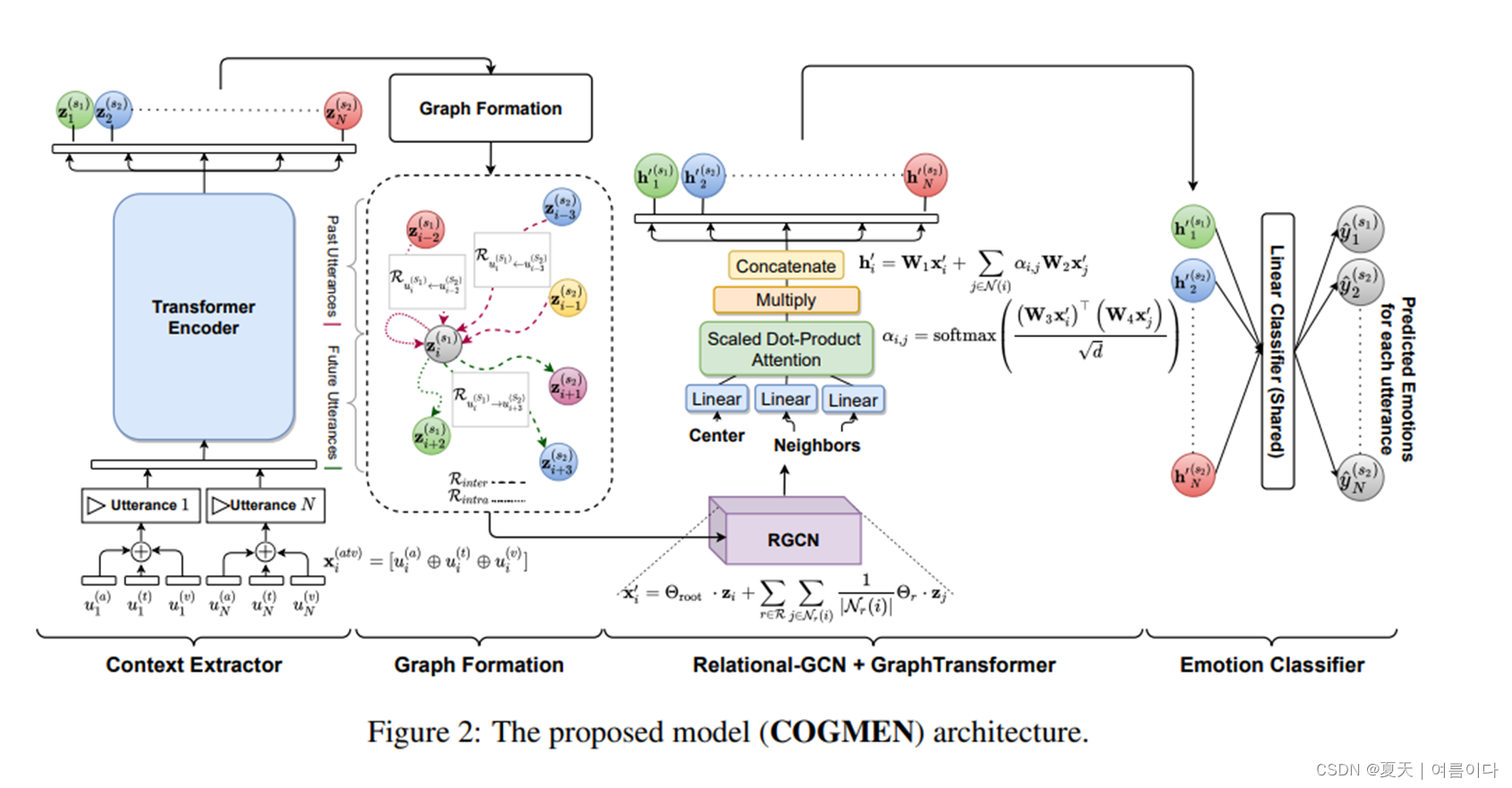

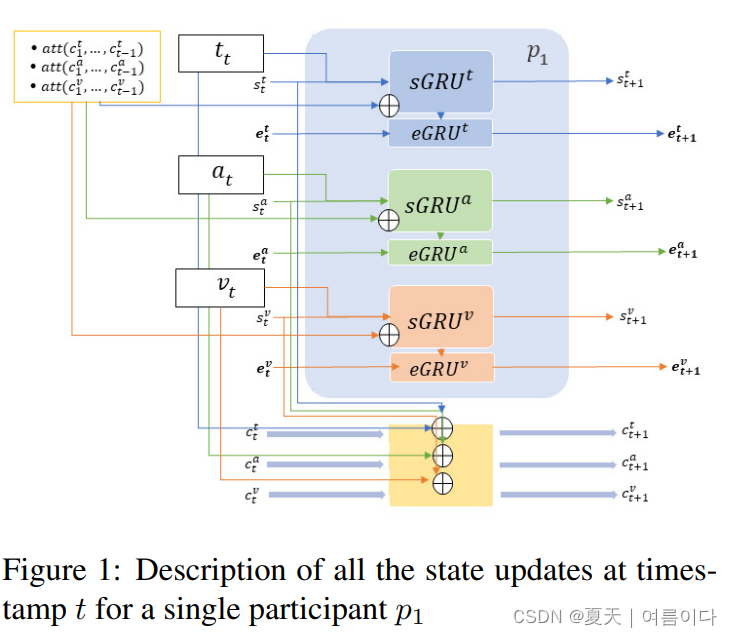

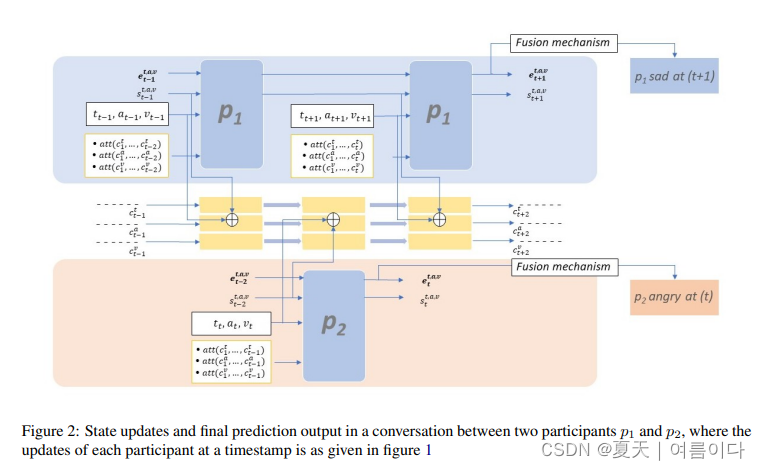

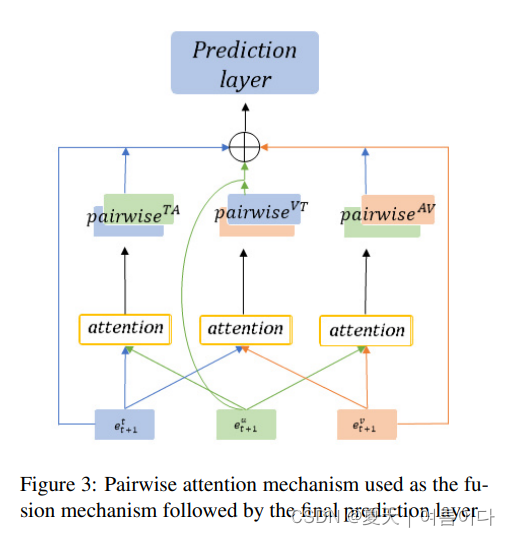

5.6.COGMEN: COntextualized GNN based Multimodal Emotion recognitioN,2022 论文地址:2205.02455.pdf (arxiv.org) 论文中文翻译:多模态 |COGMEN: COntextualized GNN based Multimodal Emotion recognitioN论文详解_夏天|여름이다的博客-CSDN博客 论文代码实现:多模态 | 基于GNN的多模态情感识别技术COGMEN项目复现_夏天|여름이다的博客-CSDN博客 ************************************************************************************************************** 6.基于上下文的情绪识别论文************************************************************************************************************** 6.1.Multilogue-Net: A Context Aware RNN for Multi-modal Emotion Detection and Sentiment Analysis in Conversation.2020. 下载地址:https://arxiv.org/pdf/2002.08267.pdf 项目地址: https://github.com/amanshenoy/multilogue-net?utm_source=catalyzex.com (LSTM为基础)摘要:对话中的情感分析和情绪检测在一些现实世界的应用中是很关键的,随着可用模式的增加,有助于更好地理解潜在的情感。多模式的情感检测和情绪分析可能特别有用,因为应用程序将能够根据可用的数据,使用可用模式的特定子集。目前处理多模态功能的系统未能利用和捕获--通过所有模态的对话背景、听者和说话者情绪状态之间的依赖性,以及可用模态之间的相关性和关系。在本文中,我们提出了一个端到端的RNN架构,试图考虑到上述所有的缺点。在撰写本文时,我们提出的模型在各种准确性和回归指标上,在基准数据集上的表现优于现有技术水平。

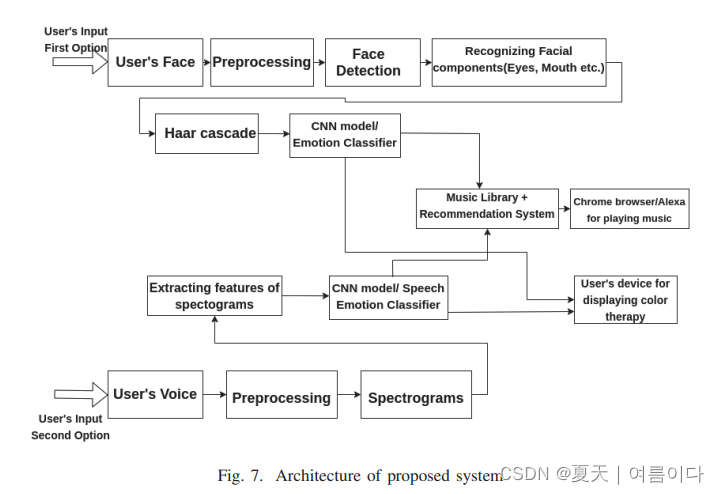

6.2.Smart and Context-Aware System employing Emotions Recognition 下载地址:Smart and Context-Aware System employing Emotions Recognition | IEEE Conference Publication | IEEE Xplore (在家居智能上的应用)摘要: 人们有能力通过同情心对他人的情绪状态做出合理的假设。通过同情心对他人的情绪状态做出判断,因为我们对知识的常识和能力和视觉上的思考。多年来,人们在以下方面进行了大量研究。为机器提供检测人类情绪的能力并开发自动化的情感智能系统。实验结果显示:计算机检测人类情绪的能力在创建敏感系统方面越来越受欢迎。在创建敏感的系统,如学习环境,健康护理系统和现实世界。改善人们的健康一直是许多研究的主题。本文描述了形成情感获取和控制的概念性证据。在智能健康环境中的控制。本文的作者旨在用一种非常规的方法,以友好的眼光来获取从系统中获得情感情景,以建立一个功能性的、非侵入性的和情感敏感的系统。可以自然地进行他们的正常活动,只有在收到愉快的情绪激活服务时才会看到这个程序。情境敏感系统与用户互动,通过面部表情或语音识别来检测和区分情绪,以做出音乐推荐和情绪色彩处理,在他们物联网设备上的服务。

6.3.X-AWARE: ConteXt-AWARE Human-Environment Attention Fusion for Driver Gaze Prediction in the Wild.2020. 论文地址:X-AWARE: ConteXt-AWARE Human-Environment Attention Fusion for Driver Gaze Prediction in the Wild | Proceedings of the 2020 International Conference on Multimodal Interaction (主要在意人机交互) 摘要:用于自动估计驾驶员注视的可靠系统对于减少交通死亡人数以及许多旨在开发智能车辆-乘客系统的新兴研究领域至关重要。凝视估计是一项具有挑战性的任务,尤其是在具有不同照明和反射特性的环境中。此外,驾驶员面部的外观在遮挡(例如助视器)和文化/种族背景方面存在很大差异。出于这个原因,分析面部以及上下文信息(例如,车厢环境)为设计用于乘客注视估计的稳健系统增加了另一个不太主观的信号。在本文中,我们提出了一种集成方法来为该任务联合建模不同的特征。尤其是,为了提高视觉捕捉环境与驾驶员面部的融合,我们开发了一种上下文注意机制 X-AWARE,直接连接到 InceptionResNetV2 网络的输出卷积层。为了展示我们方法的有效性,我们使用了 Wild 数据集中的 Driver Gaze,该数据集最近作为野外挑战中的第八个情绪识别 (EmotiW) 挑战的一部分发布。我们最好的模型在验证集上的准确率绝对优于基线 15.03%,并且在测试集上将之前报告的最佳结果提高了 8.72%。为了展示我们方法的有效性,我们使用了 Wild 数据集中的 Driver Gaze,该数据集最近作为野外挑战中的第八个情绪识别 (EmotiW) 挑战的一部分发布。我们最好的模型在验证集上的准确率绝对优于基线 15.03%,并且在测试集上将之前报告的最佳结果提高了 8.72%。为了展示我们方法的有效性,我们使用了 Wild 数据集中的 Driver Gaze,该数据集最近作为野外挑战中的第八个情绪识别 (EmotiW) 挑战的一部分发布。我们最好的模型在验证集上的准确率绝对优于基线 15.03%,并且在测试集上将之前报告的最佳结果提高了 8.72%。

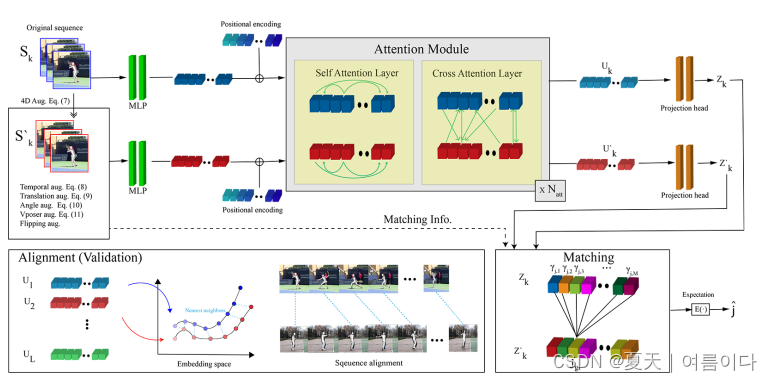

6.4.Context-Aware Sequence Alignment using 4D Skeletal Augmentation 论文地址:https://arxiv.org/pdf/2204.12223.pdf 摘要:视频中精细的人类行为的时间对齐对于计算机视觉、机器人和混合现实中的许多应用都很重要。最先进的方法通过利用强大的深度卷积神经网络直接学习基于图像的嵌入空间。虽然简单明了,但他们的结果却远远不能令人满意,在没有额外的后处理步骤的情况下,对齐的视频表现出严重的时间不连续性。最近在人体和手部姿势估计方面的进展,为解决视频中人类动作对齐的任务提供了新的方法。在这项工作中,基于现成的人体姿势估计器,我们提出了一个新的上下文感知的自监督学习架构来对齐动作序列。我们将其命名为CASA。具体来说,CASA采用了自我注意和交叉注意机制,以纳入人类行动的空间和时间背景,这可以解决时间上的不连续问题。此外,我们引入了一个自我监督的学习方案,该方案得到了三维骨架表征的新型4D增强技术的支持。我们系统地评估了我们方法的关键组成部分。我们在三个公共数据集上的实验表明,CASA比以前最先进的方法明显提高了相位进度和Kendall's Tau分数。 概述。所提出的框架将一个骨架序列Sk和它的时空增强版本S作为输入。扩增的版本S′k. 两个序列都是由时间位置编码的。在时间位置编码的帮助下,自我和交叉注意力层学习序列内和跨序列的上下文信息。我们采用一个投影头来提高我们的表征质量 [7] 。我们使用对比性回归损失,将姿势序列与其4D增强版本相匹配。对于下游的任务和对齐,我们使用投影头阶段之前的嵌入。 ************************************************************************************************************** 7.主要基于视觉上下文的情绪识别论文************************************************************************************************************** 7.1.2017.EMOTIC: Emotions in Context Dataset 发表在CVPR,提出EMOTIC数据集,并提供一个Resnet网络的基础识别分类框架。 论文地址:EMOTIC: Emotions in Context Dataset (thecvf.com) 7.2.2019.Context Based Emotion Recognition Using EMOTIC Dataset 发表在IEEE,是EMOTIC数据集的补充论文,比2017年的论文增加了一些照片。 论文地址:IEEE Xplore Full-Text PDF: 论文翻译请参考这篇博客: ❀论文篇❀Context Based Emotion Recognition Using EMOTIC Dataset论文翻译_夏天|여름이다的博客-CSDN博客 项目地址: GitHub - Tandon-A/emotic: PyTorch implementation of Emotic CNN methodology to recognize emotions in images using context information. 论文项目复现请参考这篇博客: ❀项目复现❀基于ContextBasedEmotionRecognitionUsingEMOTICDataset论文项目实现_夏天|여름이다的博客-CSDN博客 7.3.2019.Context-Aware Emotion Recognition Networks 发表在ICCV, 论文地址:Context-Aware Emotion Recognition Networks (thecvf.com) 项目地址: GitHub - ankurbhatia24/MULTIMODAL-EMOTION-RECOGNITION: Human Emotion Understanding using multimodal dataset.

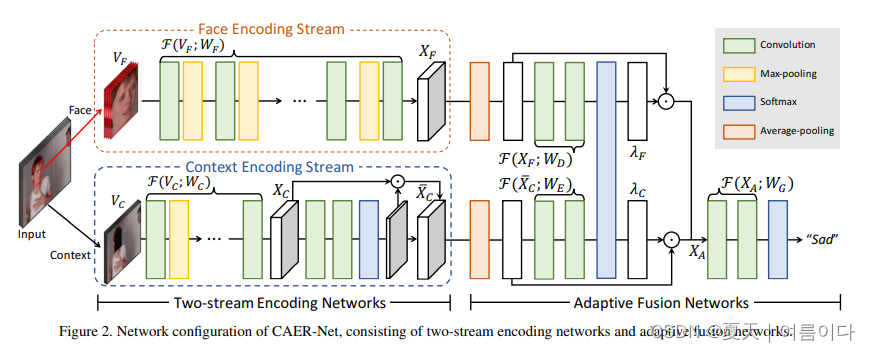

摘要:传统的情绪识别技术只关注面部表情分析,因此对全面代表情绪反应的背景编码能力有限。我们提出了用于情境感知情感识别的深度网络,称为CAER-Net,它不仅利用人类的面部表情,而且还以联合和提升的方式利用情境信息。其关键思想是将人脸隐藏在视觉场景中,并根据注意力机制寻找其他背景。我们的网络由两个子网络组成,包括分别提取人脸和背景区域特征的双流编码网络,以及以自适应方式融合这些特征的自适应融合网络。我们还为情境感知情感识别引入了一个新的基准,称为CAER,它在质量和数量上都比现有的基准要合适。在一些基准上,CAER-Net证明了情境对情感识别的影响。我们的数据集可在http://caer-dataset.github.io 7.4.2019.Context-Aware Affective Graph Reasoning for Emotion Recognition 发表于IEEE.论文地址:IEEE Xplore Full-Text PDF:

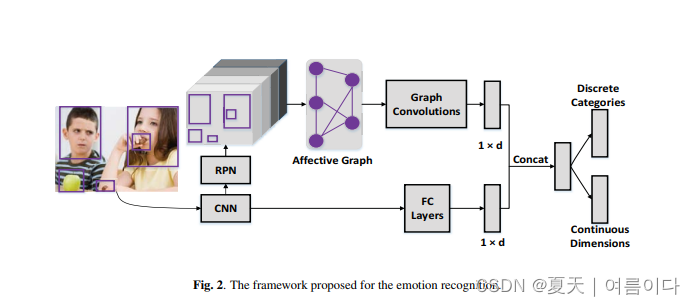

项目地址: 未开源 7.5.2020.EmotiCon: Context-Aware Multimodal Emotion Recognition using Frege’s Principle 论文地址: https://arxiv.org/pdf/2003.06692.pdf 论文翻译请参考这篇博客: ❀论文篇❀EmotiCon: Context-Aware Multimodal Emotion Recognition using Frege’s Principle论文翻译_夏天|여름이다的博客-CSDN博客 项目地址: 未开源 7.6.2021.Multimodal and Context-Aware Emotion Perception Model With Multiplicative Fusion 发表于IEEE.是EmotiCon的扩展论文。 论文地址:IEEE Xplore Full-Text PDF: 项目地址: 未开源 7.7.2021.Multi-label, multi-task CNN approach for context-based emotion recognition 发表于ScienceDirect,论文地址:Multi-label, multi-task CNN approach for context-based emotion recognition | Elsevier Enhanced Reader

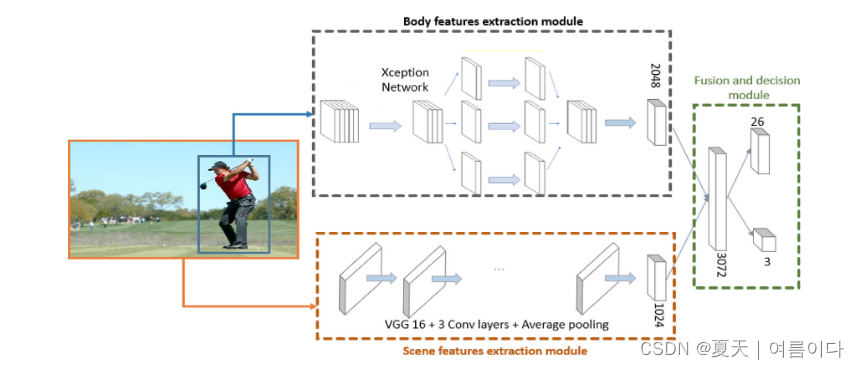

项目地址: 未开源 摘要:本文提出了一种新的深度学习架构,用于基于情境的多标签多任务情感识别。该架构由三个主要模块组成:(1)身体特征提取模块,这是一个预先训练好的Xception网络。(2)一个场景特征提取模块,基于一个改进的VGG16网络。和(3)融合决策模块。此外,还比较了三种分类损失函数和三种连续损失函数。以指出在多任务学习中,损失函数之间协同作用的重要性。然后,我们提出了一个新的损失函数,多标签焦点损失(MFL),基于焦点损失来处理不平衡的数据。EMOTIC数据集上的实验结果表明,MFL与Huber损失的结果比其他任何组合都好,并且在不太频繁的标签上优于目前的技术水平。 |

【本文地址】

今日新闻 |

推荐新闻 |

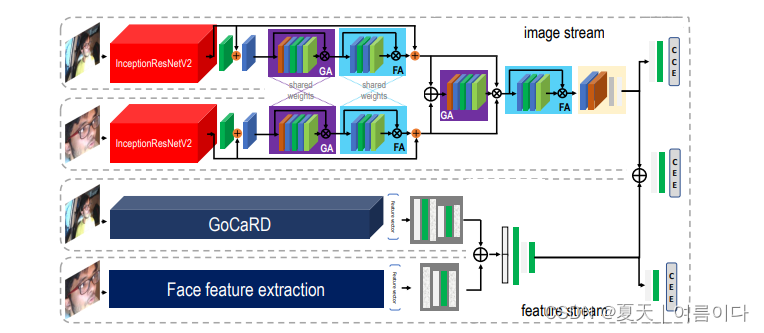

图结构:使用论文第4节中介绍的模块的最复杂的例子配置。一个完整的架构有4个主要部分。 一个InceptionResNetV2,用于从全图和人脸图像中提取特征;在全图上提取的GoCaRD特征;以及一些手工制作的人脸特征。全图上提取的GoCaRD特征;以及一些手工制作的人脸特征。首先对InceptionResNetV2的输出进行融合,例如,使用多个网格(GA)和特征(FA)注意块、剩余连接和辅助层。同时,提取的特征被增强并以更简单的方式组合。两个融合的数据流都使用(辅助的)CCE(分类的交叉熵)损失进行专门微调,同时也结合起来进行最终的预测输出。

图结构:使用论文第4节中介绍的模块的最复杂的例子配置。一个完整的架构有4个主要部分。 一个InceptionResNetV2,用于从全图和人脸图像中提取特征;在全图上提取的GoCaRD特征;以及一些手工制作的人脸特征。全图上提取的GoCaRD特征;以及一些手工制作的人脸特征。首先对InceptionResNetV2的输出进行融合,例如,使用多个网格(GA)和特征(FA)注意块、剩余连接和辅助层。同时,提取的特征被增强并以更简单的方式组合。两个融合的数据流都使用(辅助的)CCE(分类的交叉熵)损失进行专门微调,同时也结合起来进行最终的预测输出。