Selenium 屏蔽 webdriver被识别出来 的一些解决办法 |

您所在的位置:网站首页 › 网页机器人验证加载不出来 › Selenium 屏蔽 webdriver被识别出来 的一些解决办法 |

Selenium 屏蔽 webdriver被识别出来 的一些解决办法

|

问题描述

使用 selenium 模拟浏览器进行数据抓取是目前最通用的爬虫方案,所见即所得。通吃各种数据加载方式,能绕过JS加密、爬虫检测、签名机制。 但是Selenium依然能被检测到,它在运行时会暴露出一些预定义的JavaScript变量(特征字符串),如"window.navigator.webdriver",在非Selenium环境下为undefined,在Selenium环境下为true 1. 使用Firefox Selenium文档称: 在使用Selenium时,避免被检测的最好方法是使用最新版本的Firefox,另外,Safari和Opera也值得一试。 显然,并不行。。。。我自己就用了火狐浏览器最新版本,不行

Chrome 测试通过,但网站屏蔽仍存在 还出现屏蔽依旧存在是因为虽然webdriver:undefined,但是在后续的操作中webdriver里面的代码被识别了出来,但是放心,大部分网站都不会做到这么深,很少有网站会做识别后续操作的反爬虫,所以放心大胆的用 其实用这种办法大部分的网站都可以了,比如访问“企查查”就没问题。。。我已经测试了

runBotDetection = function () { var documentDetectionKeys = [ “__webdriver_evaluate”, “__selenium_evaluate”, “__webdriver_script_function”, “__webdriver_script_func”, “__webdriver_script_fn”, “__fxdriver_evaluate”, “__driver_unwrapped”, “__webdriver_unwrapped”, “__driver_evaluate”, “__selenium_unwrapped”, “__fxdriver_unwrapped”, ]; 方法是没什么问题的,只是对面做的防护太严谨了。这里可以使用接方法4继续 4.使用mitmproxy或fiddler做代码注入 使用方法就是ubuntu环境下使用mitmproxy代理服务器 #proxy.py def response(flow): if 'webdriver' in flow.response.text: print('*' * 100) print('find web_driver key') flow.response.text = flow.response.text.replace("webdriver", "fuck_that_1") if 'Webdriver' in flow.response.text: print('*' * 100) print('find web_driver key') flow.response.text = flow.response.text.replace("Webdriver", "fuck_that_2") if 'WEBDRIVER' in flow.response.text: print('*' * 100) print('find web_driver key') flow.response.text = flow.response.text.replace("WEBDRIVER", "fuck_that_3") //在上面py文件文件夹内终端运行 mitmdump -s proxys.py from selenium import webdriver from selenium.webdriver import ChromeOptions from lxml import etree import requests import html import re option = webdriver.ChromeOptions() PROXY = "127.0.0.1:8080" option.add_argument('--proxy-server=%s'%PROXY) option.add_experimental_option('excludeSwitches', ['enable-automation']) #打开浏览器 brower = webdriver.Chrome(options = option) #让浏览器对指定url发起访问 brower.get('https://maoyan.com/films/1190122') #获取浏览器当前打开页面的页面源码数据(可见即可得) page_text = brower.page_source #print(page_text) if "验证中心" in page_text: print("美团验证") else: tree = etree.HTML(page_text) score = tree.xpath('//div[@class="movie-index-content score normal-score"]/span[1]/span[1]/text()')[0] ASCll = str(score) utfs = str(ASCll.encode('unicode_escape')).replace("b","").replace("'","").replace("\\\\u",";&#x").split('.') unicode = utfs[0][1:]+";."+utfs[1][1:]+";" print(unicode)最后实现爬取。 |

【本文地址】

今日新闻 |

推荐新闻 |

检测Selenium 检测 Selenium 的 JavaScript 代码 webdriver = window.navigator.webdriver;

检测Selenium 检测 Selenium 的 JavaScript 代码 webdriver = window.navigator.webdriver; 2.使用pyppeteer

2.使用pyppeteer 3.Chrome开发工具协议

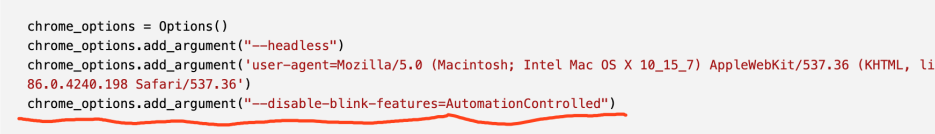

3.Chrome开发工具协议 88版的谷歌浏览器更新以后出现了问题好像这段代码已经无法正确隐藏window.navigator.webdriver了 解决方法很简单,只需要增加一个配置参数:chrome_options.add_argument("--disable-blink-features=AutomationControlled")就可以再次隐藏 window.navigator.webdriver ,你学废了吗。

88版的谷歌浏览器更新以后出现了问题好像这段代码已经无法正确隐藏window.navigator.webdriver了 解决方法很简单,只需要增加一个配置参数:chrome_options.add_argument("--disable-blink-features=AutomationControlled")就可以再次隐藏 window.navigator.webdriver ,你学废了吗。