机器学习 |

您所在的位置:网站首页 › 线性代数公式 › 机器学习 |

机器学习

|

矩阵

文章目录

矩阵直观理解特殊矩阵矩阵的基本运算矩阵(

A

A

A)乘向量(

x

x

x)的本质:改变空间位置矩阵:空间映射关系矮胖矩阵对空间的降维压缩高瘦矩阵无法覆盖目标空间方阵映射矩阵的秩

直观理解

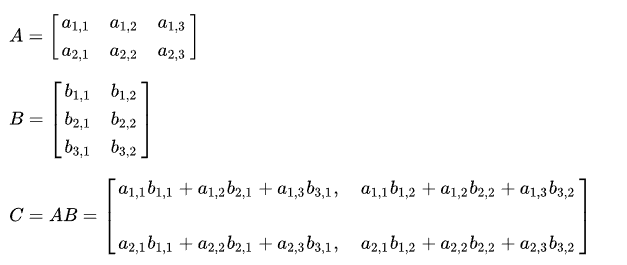

一个 m × n m \times n m×n的大小矩阵,直观上看是 m × n m \times n m×n的数字按矩阵排列。 从向量的角度看,看做是 n n n个 m m m维列向量从左到右的排列,也可以看做 m m m个 n n n维行向量从上到下的叠放。 特殊矩阵方阵:行数等于列数 对称矩阵:原矩阵与其转置矩阵相等: A = A T A = A^T A=AT 转置:原始矩阵行列互换后得到的新矩阵,称为原矩阵 A A A的转置矩阵,记作: A T A^T AT 行矩阵和列矩阵可以看做是向量 零矩阵:元素全为0,记作: O m × n O_{m \times n} Om×n 对角矩阵:非对角元素全部为0的方阵 单位矩阵:对角元素全为1的对角矩阵 矩阵的基本运算 矩阵加法:两个同等规模的矩阵之间,对应行列元素相加即可矩阵的数量乘法:将矩阵中每个元素都乘数乘的数可见矩阵的运算系统中也包含线性运算 矩阵与矩阵相乘,举例: A A A, B B B两个矩阵 首先如果想要得到 A × B A \times B A×B的合法条件是, A A A的列数等于 B B B的行数 左边矩阵决定了目标矩阵的行数 右边矩阵决定了目标矩阵的列数 具体运算:乘积C的第m行第n列的元素等于矩阵A的第m行的元素与矩阵B的第n列对应元素乘积之和。

矩阵乘向量的具体运算可以看成是矩阵相乘的特殊情况,不做过多介绍。 从矩阵列的角度 假设 A = [ c o l 1 c o l 2 . . . . . . c o l n ] A = [col_1~col_2~......~col_n] A=[col1 col2 ...... coln],其中 c o l col col表示矩阵列表示的向量 A x = [ c o l 1 c o l 2 . . . . . . c o l n ] [ x 1 x 2 . . . x n ] T = x 1 c o l 1 + x 2 c o l 2 + . . . + x n c o l n Ax = [col_1~col_2~......~col_n] [x_1~x_2~...~x_n]^T = x_1col_1 + x_2col_2 + ...+x_ncol_n Ax=[col1 col2 ...... coln][x1 x2 ... xn]T=x1col1+x2col2+...+xncoln 可以看出:矩阵和向量相乘的过程就是对原矩阵的各列向量进行线性组合的过程,而线性组合的各系数就是向量的对应各成分。 进一步引申:变换向量的基底 x = [ x 1 x 2 . . . x n ] = x 1 [ 1 0 . . . 0 ] + x 2 [ 0 1 . . . 0 ] + . . . + x n [ 0 0 . . . 1 ] x = \ \left [ \begin{matrix} x_1 \\ x_2 \\... \\x_n \\ \end{matrix} \right ] = x_1\ \left [ \begin{matrix} 1 \\ 0 \\... \\0 \\ \end{matrix} \right ] + x_2\ \left [ \begin{matrix} 0 \\ 1 \\... \\0 \\ \end{matrix} \right ] + ...+ x_n\ \left [ \begin{matrix} 0 \\ 0 \\... \\1 \\ \end{matrix} \right ] x= x1x2...xn =x1 10...0 +x2 01...0 +...+xn 00...1 ,向量 x x x表示为在基底为 ( [ 1 0 . . . 0 ] , [ 0 1 . . . 0 ] , . . . , [ 0 0 . . . 1 ] ) (\left [ \begin{matrix} 1 \\ 0 \\... \\0 \\ \end{matrix} \right ], \left [ \begin{matrix} 0 \\ 1 \\... \\0 \\ \end{matrix} \right ],...,\left [ \begin{matrix} 0 \\ 0 \\... \\1 \\ \end{matrix} \right ]) ( 10...0 , 01...0 ,..., 00...1 )的坐标。 我们来看一下在矩阵的作用下会发生怎样的变化。 A x = [ a 11 … a 1 n ⋱ ⋮ a m 1 a m n ] m × n [ x 1 x 2 . . . x n ] = x 1 [ a 11 a 21 . . . x m 1 ] + x 2 [ a 12 a 22 . . . x m 2 ] + . . . + x n [ a 1 n a 2 n . . . x m n ] Ax=\begin{bmatrix} a_{11} & \dots & a_{1n}\\ & \ddots & \vdots\\ a_{m1} & & a_{mn} \end{bmatrix}_{m \times n}\ \left [ \begin{matrix} x_1 \\ x_2 \\... \\x_n \\ \end{matrix} \right ] = x_1\ \left [ \begin{matrix} a_{11} \\ a_{21} \\... \\x_{m1} \\ \end{matrix} \right ] + x_2\ \left [ \begin{matrix} a_{12} \\ a_{22} \\... \\x_{m2} \\ \end{matrix} \right ] + ...+x_n\ \left [ \begin{matrix} a_{1n} \\ a_{2n} \\... \\x_{mn} \\ \end{matrix} \right ] Ax= a11am1…⋱a1n⋮amn m×n x1x2...xn =x1 a11a21...xm1 +x2 a12a22...xm2 +...+xn a1na2n...xmn 可以看出矩阵对于向量的作用相当于对其基底做了映射转换,由旧基底转换为“新基底”。 映射后向量维数取决于矩阵的行数。 至于为啥”新基底“加引号,请往下看。 特殊情况 对于 m × n m \times n m×n的矩阵 A A A和 n n n维列向量 x x x, x x x的 n n n个 n n n维默认基向量构成的基底被转换成了 n n n个 m m m维的目标向量。 当 n > m n > m n>m时,这 n n n个新向量线性相关,因此不能构成基底。当 n < m n < m n n m > n m>n这种情况,我们称之为"高瘦"矩阵。 x x x的 n n n个基向量 e e e,分别被矩阵 A A A映射成了 n n n个 m m m维向量,由于 m > n m > n m>n,看上去 x x x映射后的目标向量的维数提高了,变成了 m m m维。那我们能不能说:经过矩阵 A A A的映射,原始向量 x x x构成的空间 R n R^n Rn变成了维数更高的空间 R m R^m Rm呢?答案是否定的,哲学点说,一个事物无中生有,那是不可能的,平白无故的一个向量携带的信息怎么能增加呢? 方阵映射假设方阵 A n × n A_{n\times n} An×n 当方阵 A A A中 n n n个列向量线性无关时,意味着原始向量的基被映射成新向量后,仍然可以构成 R n R^n Rn空间里的一组基底。当方阵 A A A中 n n n个列向量线性相关时,方阵则退化成了矮胖矩阵,参考前面所述即可。 矩阵的秩我们把一个空间经过矩阵映射后得到的新空间称之为他的像空间。我们发现,一个原始空间,经过几个形状相同的矩阵进行映射,像空间的维数可能不同;经过几个不同形状的矩阵进行映射,又有可能得到维数相同的像空间。那么决定因素是什么? 决定因素就是空间映射矩阵的列向量,列向量张成空间的维数就是原始空间映射后的像空间维数。我们给矩阵列向量的张成空间维数取了一个名字,就叫作:矩阵的秩。从另一方面看,秩也可以说是该矩阵线性无关的列的个数。 间的维数可能不同;经过几个不同形状的矩阵进行映射,又有可能得到维数相同的像空间。那么决定因素是什么? 决定因素就是空间映射矩阵的列向量,列向量张成空间的维数就是原始空间映射后的像空间维数。我们给矩阵列向量的张成空间维数取了一个名字,就叫作:矩阵的秩。从另一方面看,秩也可以说是该矩阵线性无关的列的个数。 |

【本文地址】