红外视频图像行人检测算法综述 |

您所在的位置:网站首页 › 红外热像仪大全 › 红外视频图像行人检测算法综述 |

红外视频图像行人检测算法综述

|

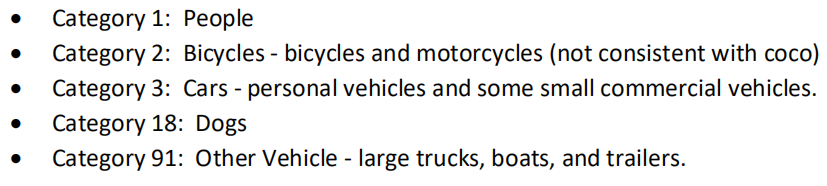

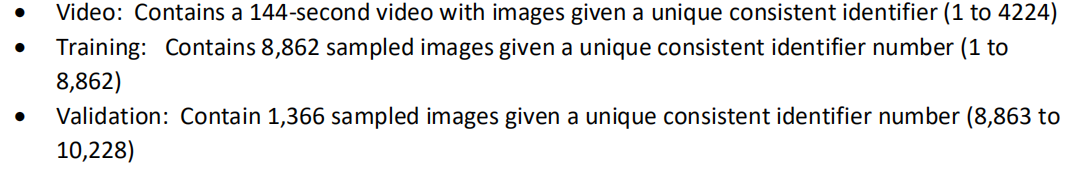

http://www.doc88.com/p-1137822192539.html 2018年西安邮电大学学报 《改进的YOLOv3红外视频图像行人检测算法》 对于红外视频图像行人检测算法方面进行一个小小的认知和了解 说明:当下用红外视频做自动驾驶方面的比较多,auto-drive,所以数据集基本是车载的。还有双光结合的,这类数据集的较多。如在行人检测(3)——数据集中提到的:自动驾驶类的数据集 KAIST多光谱行人数据集:640×480,手动标记了所有的行人、骑自行车的人等SCUT南方科技大学红外行人数据集:FLIR-ADAS红外数据集 1.《改进的YOLOv3红外视频图像行人检测算法》使用的数据集为CVC公司的CVC-09数据集,还有CVC-14的数据集。YOLOv3在检测红外视频图像行人时存在准确率低、漏检率高的问题。行人在红外图像中呈现宽高比相对固定的特点,利用k-means聚类方法选取目标候选框个数和宽高比维度,调整网络参数并提高输入图像分辨率,最后进行多尺度训练得到最优检测模型。在CV-09数据集上,改进后的网络的准确率达到90.63%,明显优于Faster-rcnn和YOLOv3。 常用的红外行人检测技术主要分为: 基于特征分类的方法——依赖于人工设计特征提取器,然后训练分类器进行行人检测,如HOG和SVM 人工设计的特征泛化能力差基于深度学习的方法——利用CNN从图像像素中学习行人特征,通过特征训练得到行人检测模型,如CNN、局域CNN和端到端的方法 CNN不需要人为选择行人特征,但针对不同场景检测需要单独训练模型局域CNN:将特征提取和分类融合进一个分类框架,提高了训练速度和检测的准确率,但由于加入了SVM而繁琐端到端,如SSD-single shot multibox detector,可以解决在特征提取过程中由于图像像素过多导致的维度灾难问题,但SSD对小尺寸和模糊目标的检测效果较差,且检测速度较慢YOLO-you look only once在检测速度上远超过SSD,在YOLO在检测相互重叠或者相邻很近的目标时漏检率过高,且泛化能力偏弱。 2. FLIR-ADAS数据集 双光图像-红外图像带注释,可见光图像不带注释。车载数据。总共有14452张图像,其中10228张是短视频(帧率为2fps),4224为144s的视频。少部分图像在目标稀少的地区是帧率1fps采集的。FLIR Thermal Starter数据集提供了带注释的热图像和非带注释的RGB图像集,用于训练和验证目标检测神经网络。通过安装在车辆上的RGB和热像仪获取数据集。数据集总共包含14452张带注释的热图像,其中10228张图像是从短视频中采样的,4224张图像是从连续144秒视频中采样的。所有视频均于11月至5月在美国加利福尼亚州圣塔芭芭拉的街道和高速公路上拍摄。在白天和晚上,在一般晴朗的天空条件下拍摄视频。 用FLIR Tau2(13mm f / 1.0、45-degree HFOV垂直视角和37-degreeVFOV水平视角)获取热图像。 RGB图像是通过FLIR BlackFly在1280 X 512m(4-8 mm f / 1.4-16百万像素镜头,且FOV设置为与Tua2匹配)上获取的。两个摄像机均在默认模式下运行。摄像机位于一个彼此隔开1.9 +/- 0.1英寸的外壳中。使用FLIR专有软件通过USB3视频捕获图像。 10228张热图像中的大多数以每秒两张图像的速度采样(native视频是每秒30帧)。在对象较少的环境中采集的少数图像以每秒一帧的速率采样。 人类注释者标记并在五类对象周围放置边框。在可能的情况下,使用了coco编号方案来编号类别ID。类别ID也记录在“ catids.json”文件中,该文件同时出现在训练和验证文件夹中。

五类目标:人、自行车与摩托车、汽车(私家车和小型商业车)、狗、其他机动车(大卡车、船等) 注释使边界框尽可能紧密。紧凑的边框忽略目标的小部分(例如四肢)的紧定边界框比宽边界框更受青睐。个人附件未包含在人的边框中。发生遮挡时,仅注释对象的未遮挡部分。头和肩膀比人和狗的身体其他部位更受人欢迎。当遮挡只允许肢体的一部分或对象的其他较小部分可见时,则不会对其进行注释。车轮是“自行车”类别的重要组成部分。边界盒中未包括通常被骑手挡住的自行车零件,例如车把。骑自行车的人与自行车分开注释。当对象被遮挡分割时,将为对象的两个可见部分提供两个单独的注释。 注释仅针对热图像创建。热像仪和RGB热像仪在车辆上的位置不同,因此具有不同的观察几何形状,因此热注释不能代表RGB图像中对象的位置。 文件夹结构由三个文件夹组成,每个文件夹都有五个子文件夹。对于采样的图像,已通过两个子文件夹(标记为“ training”和“ validation”)创建了建议的训练和验证集。将整个视频分配到建议的训练或验证集中。 紧凑的边框比宽边界的边框更好存在遮挡时,仅注释目标的未遮挡部分 存在遮挡时,人或狗的头和肩膀比身体的其他部位更重要。 严重遮挡时,如只剩下一部分肢体时,不进行标注。 骑自行车的人与自行车分开注释 目标被遮挡时,两个目标是分开标注的。

Baseline的accuracy对于Training和Validation数据是使用为512*512的图像设计的RefineDetect512的神经网络,且在MSCOCO数据集上预训练过的。(https://arxiv.org/pdf/1711.06897.pdf and https://github.com/sfzhang15/RefineDet)。base神经网络实在8-bit红外图像上训练的,training folder中有标记数据。Test data没有用于训练。实现了所有类别的 mAP IoU(0.5) of 0.587。使用的accuracy测试网址为如下,mAP分数如下。

文件结构中使用了以下子文件夹: AnnotationsPreviewData:该文件夹包含“预览数据”中的8位热数据,该数据已处理为将批注文件夹中的批注边界框覆盖在其上。注释:此文件夹包含详细说明边界框和类别信息的json文件。此json文件为标准可可格式。与注释相关的json文件被格式化为python数据字典。字典中的第一个键是“注释”。键返回图像内的注释列表。批注列表中的每个项目均包括以像素为单位的批注区域,边框尺寸,批注ID的类别(请参见“ catids.json”),批注的ID号(在每张图片中,第一张图片都有ID)数字1,第二个具有ID号2,依此类推),与注释关联的图像ID,注释是否用于人群以及分段坐标。边界框尺寸将左上角像素设置为(0,0)。向下移动会增加y像素数。向右移动可增加x像素数。第二个键是“图像”。该键返回有关图像的基本元数据和相关注释。数据:由FLIR Tau2摄像机获取的14位640 X 512热图像,未应用自动增益控制(AGC)。图像采用16位.tiff格式。一个可以查看16位图像的工具集可从以下网址获得:https://imagej.netPreviewData:8位,应用AGC,.jpeg格式的图像,否则与“数据”文件夹中的图像相同。 RGB:8位RGB(三通道)图像。请注意,训练中的499张图像,验证中的109张图像和视频中的29张图像没有RGB对应图像。图像分辨率通常为1600 X 1800,但是某些图像的分辨率不同,包括480 X 720、1536 X 2048和1024 X 1280。 2.1jason格式注释COCO数据集的 标签文件.json解读、理解 跟COCO数据集的标签文件很类似。COCO数据集标注信息 https://blog.csdn.net/fkk921912333/article/details/79129952?utm_medium=distribute.pc_relevant.none-task-blog-baidujs-1 image_idid是每张图像里面不止一个目标,这个是每一个目标的id。它有一个bbox表示它的位置,然后category_id为标记分类,person?car?等。image_id为帧号

2.2 jason格式为COCO数据集格式,标注读取和

2.2 jason格式为COCO数据集格式,标注读取和

https://blog.csdn.net/u012435142/article/details/102156018

|

【本文地址】

今日新闻 |

推荐新闻 |