如何更好的使用LLMs:类比推理 |

您所在的位置:网站首页 › 类比推理的事例 › 如何更好的使用LLMs:类比推理 |

如何更好的使用LLMs:类比推理

|

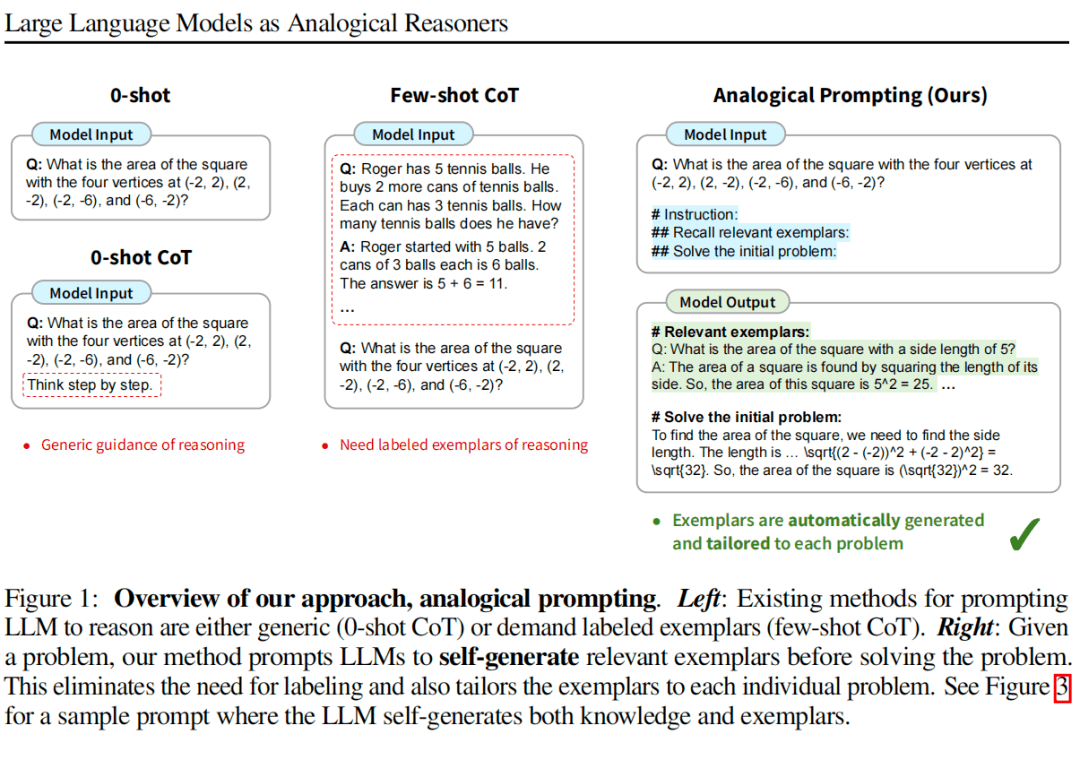

Chain of Thought 是 LLMs 在解决 NLP 任务上最经典的方法了,可以很好的激发 LLMs 的解决复杂问题的能力,比如数学题。 其核心是生成推理的路径——这是非常关键的核心。现在比较常见的有 few-shot CoT 和 zero-shot CoT,还有一些其它的,后面有时间再唠。 其中,zero-shot CoT 不需要例子,可以神奇的做一些推理,是有隐含的推理路径。但对于稍微复杂的,就非常考验模型的基座能力了。few-shot CoT 需要给定一些例子,这是人工进行的,这样推理能力就会得到一定的增强。 那么?如何以最小的成本得到这些例子呢? 类比推理就是解决这个问题的。让 LLMs 自己生成和当前问题相关的例子,并且解决。然后将这个例子和解决过程,统一加到 Prompt 里,辅助最初问题的推理。 核心思想其实很简单,看看论文中的图,更直观一些:

大家注意在做这些论文复现的时候,一定要注意使用的模型,或者模型版本。不然我们会发现,zero-shot 就已经可以了。 我们看下具体的Prompt

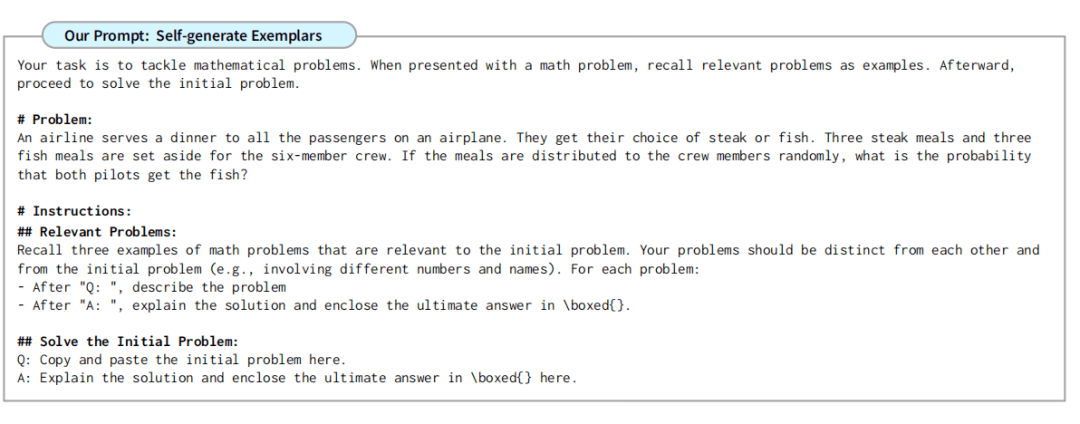

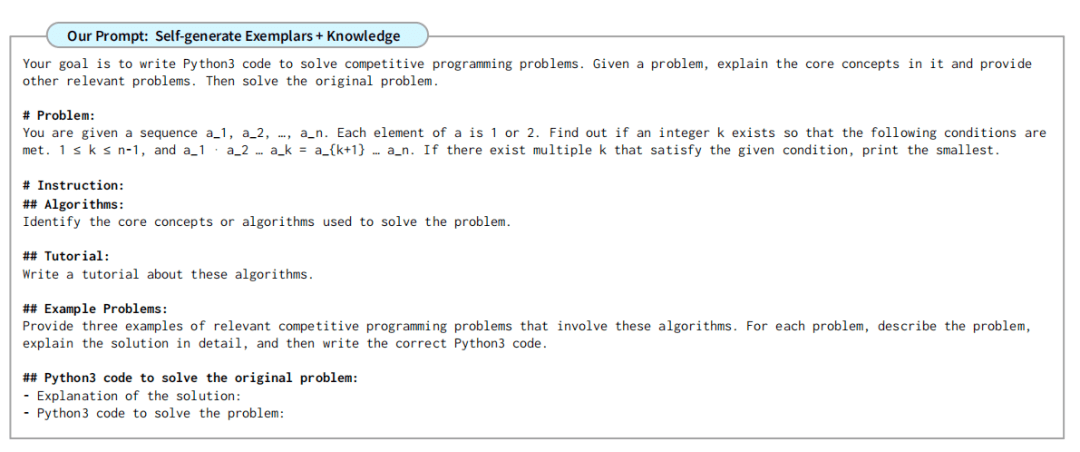

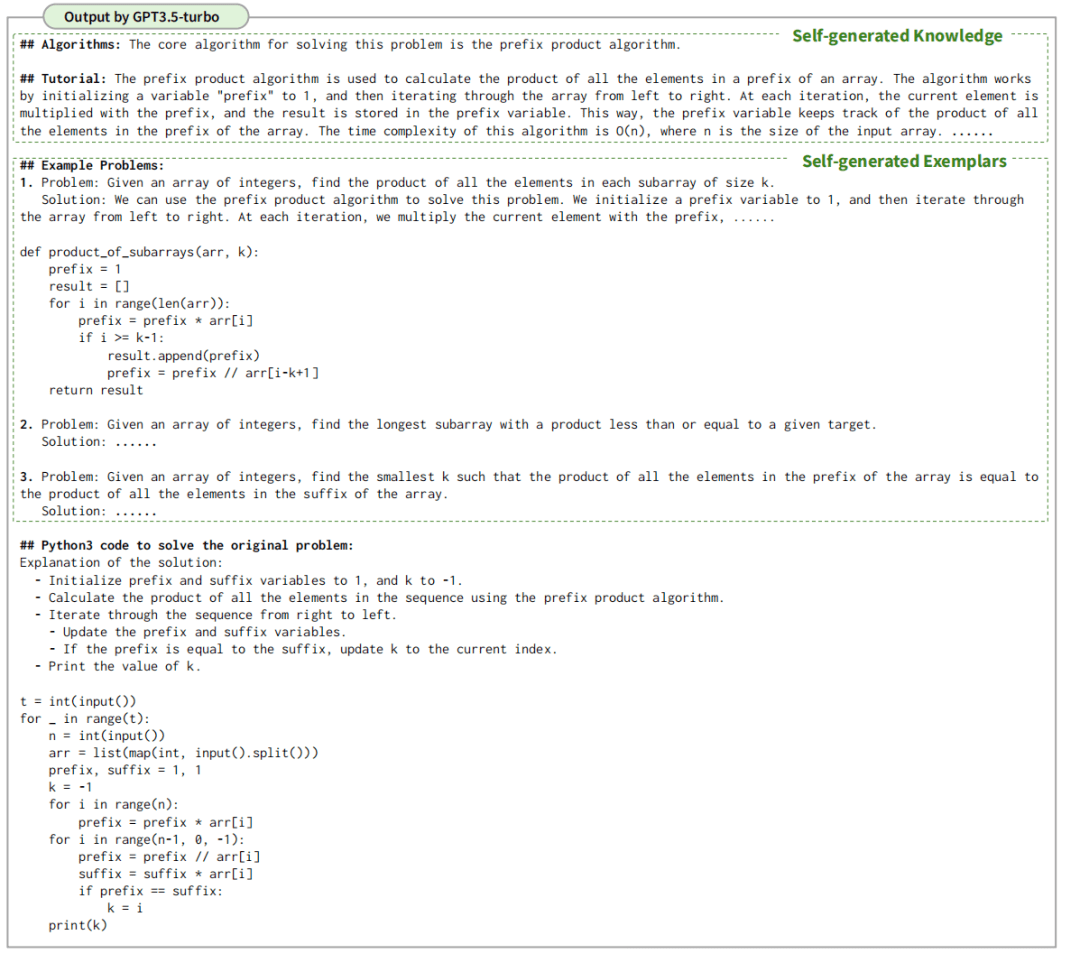

这是生成相关例子的Prompt。下面是输出:

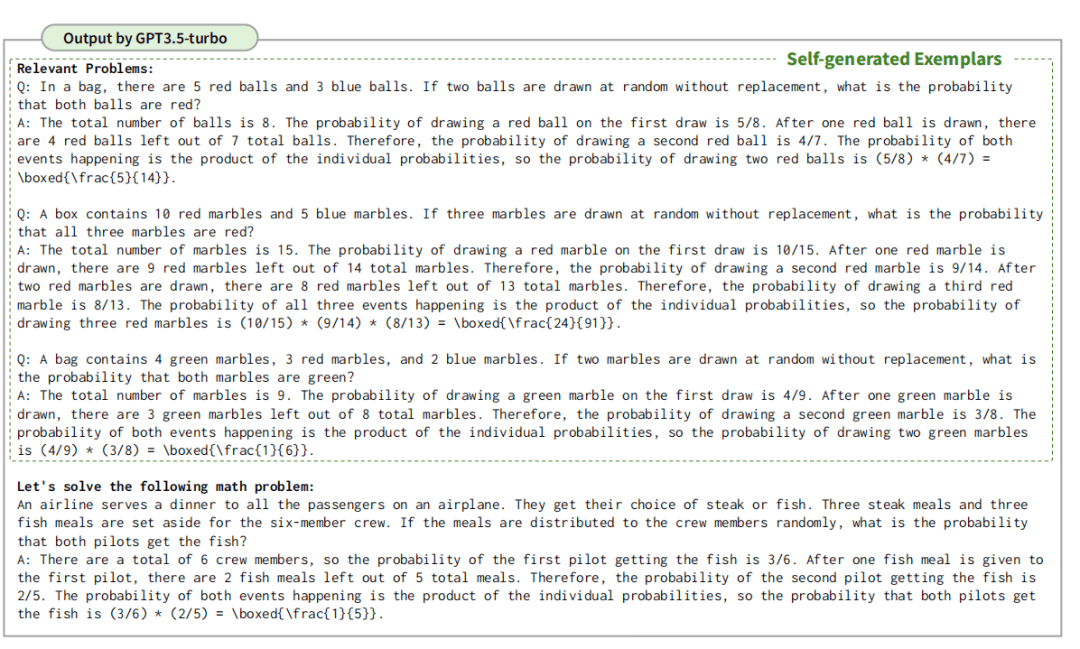

这里有一些细节: 1. 相关,但是不同的问题。更强的参考意义 2. 一个问题,一条这样的 Prompt好一些?还是我们和 LLMs 进行多次交互,每一次生成一个例子,拼起来再给到 LLMs 呢?文章中说一条就可以,我自己有做过类似的实验,确实不用费脑筋做多次,浪费资源。但有的情况例外,就是知识来自大模型之外——好像是废话。 3. 多少个例子合适呢?经过作者们的实验,发现 3-5 最佳。 其实 Prompt 的优化,真的是无止境的,一层一层,随便加,我自己在设计 Prompt 的时候,就有这样的感受。比如,在给出例子的基础之上,可以再给一个教程——解决这个问题的相关知识,抽象的,详细给出解决过程。

下面是结果

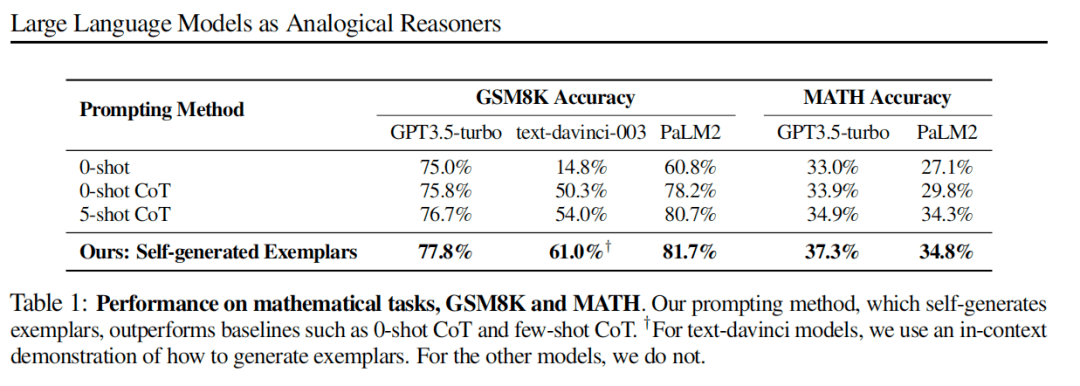

这有什么好处呢? 1. 一个抽象和具体的平衡,例子是很具体的,并且也不一定对。知识是比较抽象的,多一个约束 2. 一定程度上,用抽象概念,来产生例子。 论文这里的理解,我觉得有一些问题。因为 LLMs 在参考例子的时候,例子本身是否正确影响不大。更多的,还是“出现”合理的推理路径,更多的可以参考的,这个比较重要。 下面看看效果。 先看看数学任务

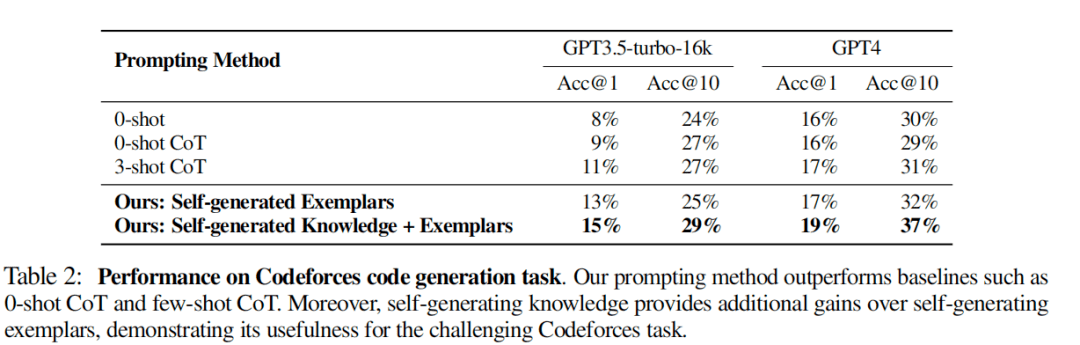

这个 GSM8K,我做了评估,并没有发现类比推理比 zero-shot 强,可能是gpt-3.5-turbo 本身更新了——也就是我最开始说的 Prompt 困境的问题。 代码生成的任务

这个我没有复现,但确实提升很多。 常识推理任务 这个要更厉害些,但我做了一些尝试,并不理想。后面我再整体跑一下数据。 最后,这个对比挺有意思的,就是和 RAG 进行对比

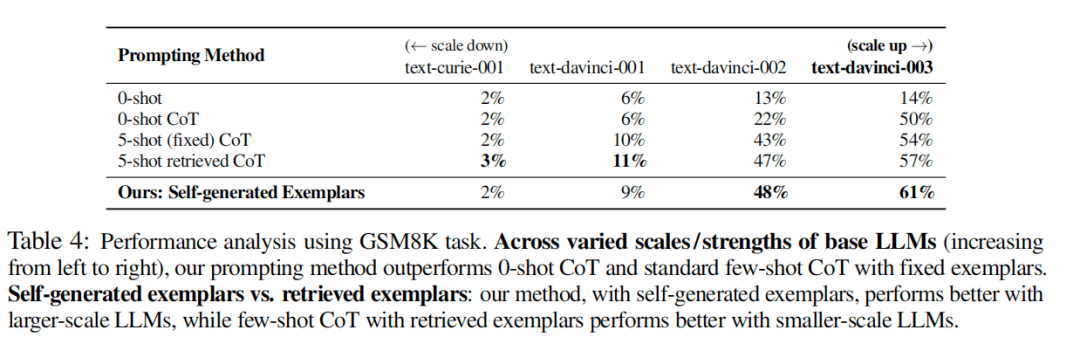

当模型规模小的时候,LLMs 本身知识有限,所以 RAG 的更强。当模型变大,本身的知识增加,类比推理效果更好些。 本文主要是对以下论文的理解,以及使用Prompt的经验。 论文题目:《LARGE LANGUAGE MODELS AS ANALOGICAL REASONERS》 论文链接:https://huggingface.co/papers/2310.01714返回搜狐,查看更多 |

【本文地址】

今日新闻 |

推荐新闻 |