人工智能基础部分7 |

您所在的位置:网站首页 › 神经网络的隐藏层怎么确定 › 人工智能基础部分7 |

人工智能基础部分7

|

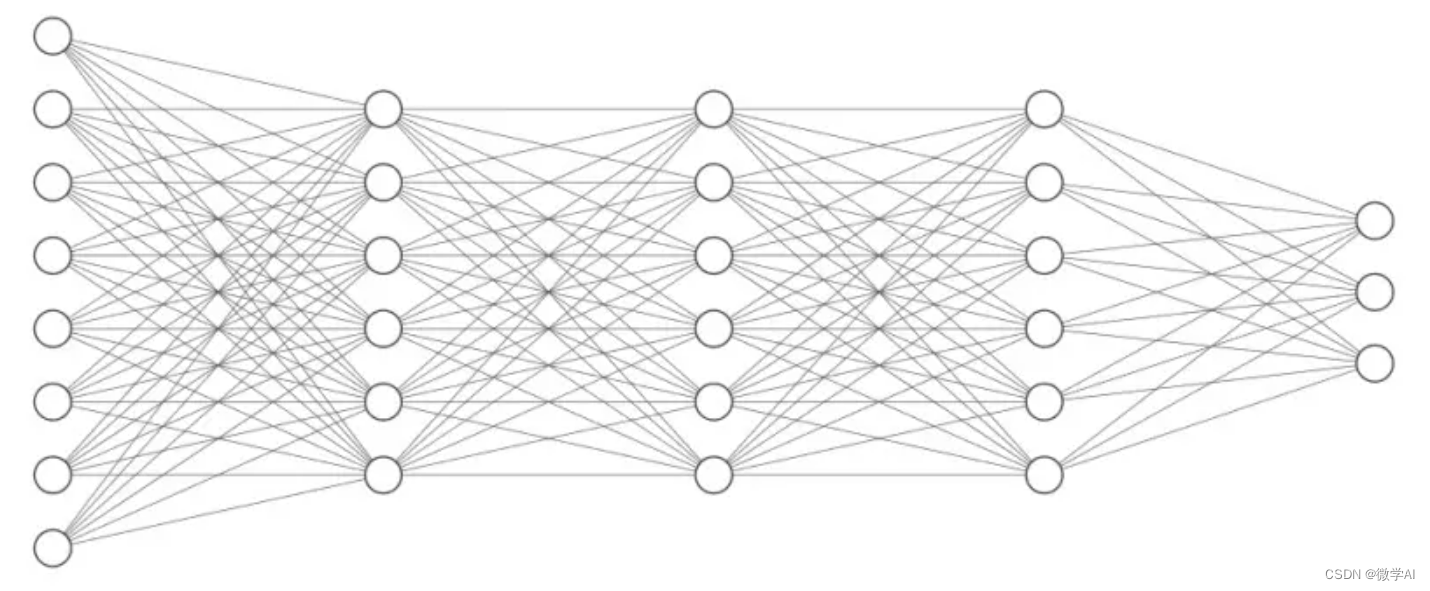

大家好,我是微学AI,今天给大家介绍一下高维空间的神经网络,学习高维空间的神经网络就意味着我们已经跨入深度学习领域了。 一、高维空间的神经网络概念 高维空间的神经网络是一种特殊的深度学习模型,用于处理高维数据。它通过增加网络层数来处理高维数据,用于提取高维特征,解决复杂的机器学习问题,并且可以用于解决许多机器学习应用场景。高维空间的神经网络可以更好地捕捉数据的复杂性,从而更好地解决机器学习问题。

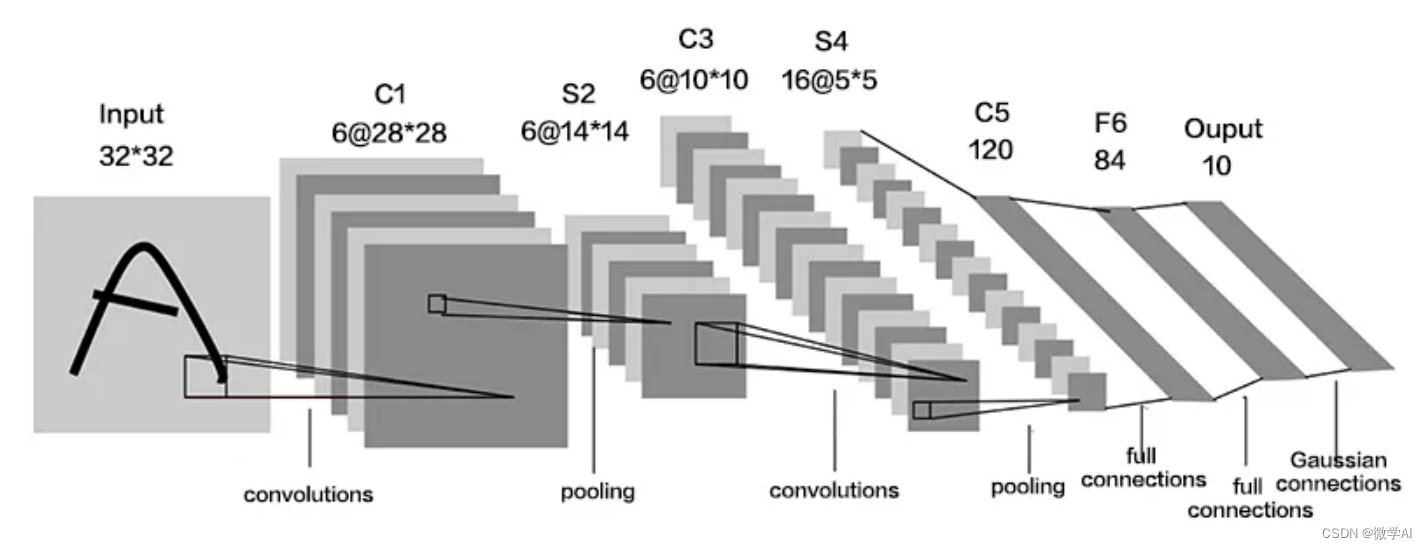

二、高维空间神经网络的应用 一个典型的高维空间神经网络案例应用是图像分类。图像分类任务中,输入数据是一张图像的像素,每个像素的值代表着图像的颜色,而这些像素的值在高维空间中代表了图像的特征。因此,使用神经网络对图像进行分类,就是利用高维空间中的特征对图像进行分类。

三、高维空间神经网络的案例描述 关于一个高维空间的非线性优化问题:例如,假设我们有一个n维的输入空间,其中每个维度代表一个特征。我们的任务是在这个n维空间中找到一个函数,它可以最好地拟合已知的数据点。 为了实现这一目标,我们可以使用一个神经网络,它由n个输入节点、m个隐藏层节点组成,以及一个输出节点。我们可以使用最小二乘法来优化神经网络的权重,使得神经网络能够最好地拟合已知的输入特征和输出结果。在这里,我们的目标是找到一组最优的权重参数,使得神经网络能够以最小的损失函数值来拟合已知的输入特征和输出结果。 有了这组最优的权重参数,我们就可以使用高维空间的非线性优化方法来求解这个问题。例如,我们可以使用genetic algorithms(遗传算法)、gradient descent(梯度下降法)等高维空间的最优化方法来求解这类问题。 高维空间神经网络可以用于解决复杂的高维空间问题,比如计算机视觉、自然语言处理和生物信息学等。下面我们来看一个关于高维空间神经网络的数学案例。 假设我们有一个高维空间神经网络,它由三个输入变量 四、高维空间神经网络的代码: 简单模型输入输出: import numpy as np import matplotlib.pyplot as plt # 定义函数:激活函数 def sigmoid(x): return 1 / (1 + np.exp(-x)) # 定义函数:梯度下降 def Gradient_Descent(x, y, theta, alpha, iterations): for i in range(iterations): grad = np.dot(x.T, (sigmoid(np.dot(x, theta)) - y)) theta = theta - alpha * grad return theta # 生成数据 X = np.random.randn(100, 2) # 生成100个样本,每个样本有2个特征 # 将标签设定为0-1分类 Y = np.array([0 if np.sum(x) |

【本文地址】

今日新闻 |

推荐新闻 |

一个高维空间的神经网络就像是一个复杂的连续空间,里面充斥着各种各样的点,每一个点都有自己的位置和属性,它们可以相互之间的关联,比如一个点的属性可能会影响另一个点的属性,这样就形成了一个复杂的连续空间,被称为神经网络。在这个空间里,每个点都可以激活其他点,同时也可以被其他点所激活,形成一个复杂的互动关系,从而使整个空间变得更加复杂,并且能够记录下大量的信息。因此,这种高维空间的神经网络可以更好的理解和模拟复杂的现实世界,并且还能够帮助我们解决复杂的问题。

一个高维空间的神经网络就像是一个复杂的连续空间,里面充斥着各种各样的点,每一个点都有自己的位置和属性,它们可以相互之间的关联,比如一个点的属性可能会影响另一个点的属性,这样就形成了一个复杂的连续空间,被称为神经网络。在这个空间里,每个点都可以激活其他点,同时也可以被其他点所激活,形成一个复杂的互动关系,从而使整个空间变得更加复杂,并且能够记录下大量的信息。因此,这种高维空间的神经网络可以更好的理解和模拟复杂的现实世界,并且还能够帮助我们解决复杂的问题。 另一个例子是文本分类。文本分类任务中,输入数据是一篇文章的单词,每个单词都会被转换成一个特征向量,而这些向量在高维空间中代表了文本的特征。因此,使用神经网络对文本进行分类,就是利用高维空间中的特征对文本进行分类。

另一个例子是文本分类。文本分类任务中,输入数据是一篇文章的单词,每个单词都会被转换成一个特征向量,而这些向量在高维空间中代表了文本的特征。因此,使用神经网络对文本进行分类,就是利用高维空间中的特征对文本进行分类。