遗传算法优化BP神经网络在非线性函数拟合中的应用 |

您所在的位置:网站首页 › 神经网络中的非线性 › 遗传算法优化BP神经网络在非线性函数拟合中的应用 |

遗传算法优化BP神经网络在非线性函数拟合中的应用

|

遗传算法优化BP神经网络在非线性函数拟合中的应用

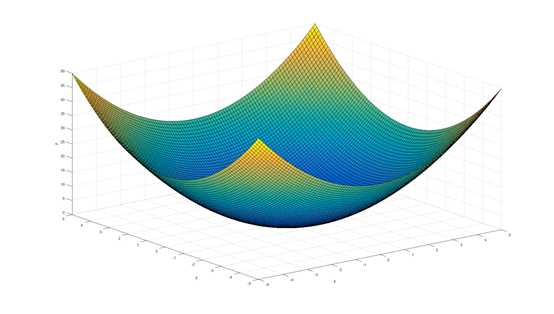

在工程应用中经常会遇到一些复杂的非线性系统,这些系统状态方程复杂,难以用数学方法精确建模。在这种情况下,可以建立BP神经网络表达这些非线性系统。通常BP神经网络的权值和阈值都是随机初始化的,这样容易导致拟合效果不稳定,况且由于使用梯度下降的方式训练BP网络的权值和阈值,容易导致训练陷入局部最优中,所以本案例我们通过遗传算法来对神经网络初始的权值和阈值进行优化。 本案例拟合的非线性函数为: y = x 1 2 + x 2 2 y= x_{1}^{2}+x_{2}^{2} y=x12+x22 该函数的图形,如下图所示。

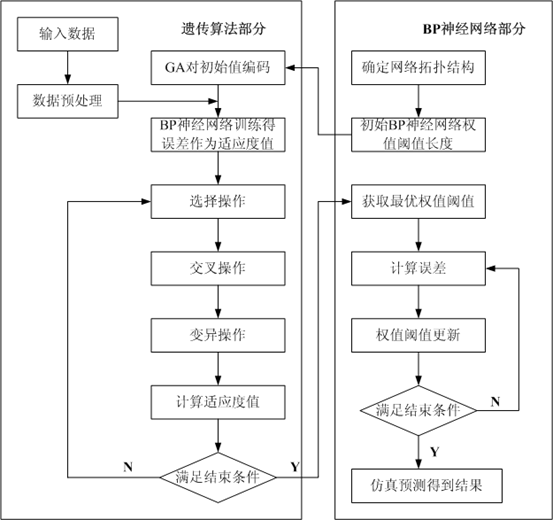

遗传算法优化BP神经网络算法流程如下图所示,分为BP神经网络结构确定、遗传算法优化和BP神经网络预测3个部分。 (1)BP神经网络结构确定部分:根据拟合函数输入输出参数个数确定BP神经网络结构,进而确定遗传算法个体长度。 (2)遗传算法优化部分:使用遗传算法优化BP神经网络的权值和阈值,种群中的每个个体都包含了一个网络所有权值和阈值,个体通过适应度函数计算个体适应度值,遗传算法通过选择、交叉和变异操作找到最优适应度值对应个体。 (3)BP神经网络预测部分:用遗传算法得到最优个体对网络初始权值和阈值赋值,网络经训练后预测函数输出。

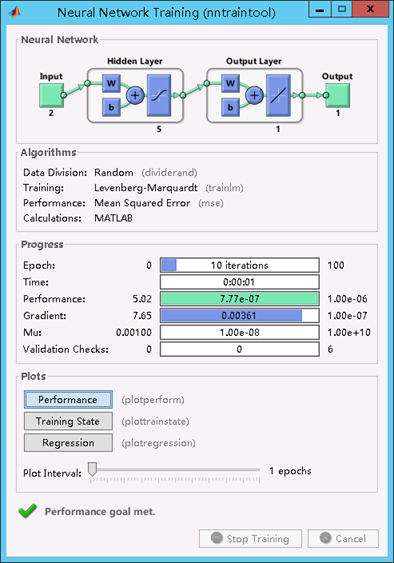

本案例中,由于拟合非线性函数有2个输入参数、1个输出参数,所以设置的BP神经网络结构为2-5-1,即输入层有2个结点,中间层有5个结点,输出层有1个结点,共有 2 × 5 + 5 × 1 = 15 2\times 5+5\times 1=15 2×5+5×1=15个权值,5+1=6个阈值,所以遗传算法个体编码长度为15+6=21。从非线性函数中随机得到2000组输入输出数据,从中随机选择1900组作为训练数据,用于网络训练,100组作为测试数据。把训练数据预测误差绝对值和作为个体适应度,个体适应度值越小,该个体越优。 1.2 遗传算法实现遗传算法优化BP神经网络的要素包括种群初始化、适应度函数、选择操作、交叉操作和变异操作。 1. 种群初始化 个体编码方法为实数编码,每个个体均为一个实数串,由输入层与中间层连接权值、中间层阈值、中间层与输出层连接权值以及输出层阈值4部分组成。个体包含了神经网络全部权值和阈值,在网络结构已知的情况下,就可以构成一个结构、权值、阈值确定的神经网络。 2、适应度函数 根据个体得到BP神经网络的初始权值和阈值,用训练数据训练BP神经网络后预测系统输出,把预测输出和期望输出之间的误差绝对值之和 E E E作为个体适应度值 F F F,计算公式为: F = k × ∑ i = 1 n a b s ( y i − o i ) F = k\times\sum_{i=1}^{n}{abs(y_i-o_i)} F=k×i=1∑nabs(yi−oi) 式中, n n n为网络输出结点数; y i y_i yi为BP神经网络第 i i i个结点的期望输出; o i o_i oi为第 i i i个结点的预测输出; k k k为系数,本案例 k = 1 k=1 k=1。 3、选择操作 遗传算法选择操作有轮盘赌法、竞标赛法等多种方法,本案例选择轮盘赌法,即基于适应度比例的选择策略,每个个体 i i i的选择概率 p i p_i pi为: f i = k F i f_i=\frac{k}{F_i} fi=Fik p i = f i ∑ j = 1 N f j p_i=\frac{f_i}{\sum_{j=1}^{N}{f_j}} pi=∑j=1Nfjfi 式中, F i F_i Fi为个体 i i i的适应度值,由于适应度越小越好,所以在个体选择前对适应度值求倒数; k k k为系数,本案例 k = 10 k=10 k=10; N N N为种群个体数目。 4、交叉操作 由于个体采用实数编码,所以交叉操作方法采用实数交叉法,第 k k k个染色体 a k a_k ak和第 l l l个染色体 a l a_l al在 j j j位的交叉操作方法如下: { a k j = a k j ( 1 − b ) + a l j b a l j = a l j ( 1 − b ) + a k j b \left \{ \begin{array}{c} a_{kj}=a_{kj}(1-b) + a_{lj}b \\ a_{lj}=a_{lj}(1-b) + a_{kj}b \\ \end{array} \right. {akj=akj(1−b)+aljbalj=alj(1−b)+akjb 式中, b b b是 [ 0 , 1 ] [0,1] [0,1]间的随机数。 5、变异操作 选取第 i i i个个体的第 j j j个基因 a i j a_{ij} aij进行变异,变异操作方法如下: a i j = { a i j + ( a m a x − a i j ) × f ( g ) , r > 0.5 a i j − ( a i j − a m i n ) × f ( g ) , r ≤ 0.5 a_{ij}=\left \{ \begin{array}{c} a_{ij} + (a_{max} - a_{ij})\times f(g), r>0.5 \\ a_{ij} - (a_{ij} - a_{min})\times f(g), r\leq 0.5\\ \end{array} \right. aij={aij+(amax−aij)×f(g),r>0.5aij−(aij−amin)×f(g),r≤0.5 f ( g ) = r ′ ( 1 − g G m a x ) 2 f(g) = r'(1-\frac{g}{G_{max}})^2 f(g)=r′(1−Gmaxg)2 式中, a m a x a_{max} amax为基因 a i j a_{ij} aij的上界; a m i n a_{min} amin为基因 a i j a_{ij} aij的下界; g g g为当前迭代次数; G m a x G_{max} Gmax为最大进化次数; r , r ′ r,r' r,r′为 [ 0 , 1 ] [0,1] [0,1]间的随机数。 二、MatLab实现 2.1 染色体编码 function ret=Code(lenchrom,bound) % 本函数将变量编码成染色体,用于随机初始化一个种群 % lenchrom input : 染色体长度 % bound input : 变量的取值范围 % ret output: 染色体的编码值 pick=rand(1,length(lenchrom)); %线性插值,编码结果以实数向量存入ret中 ret=bound(:,1)'+(bound(:,2)-bound(:,1))'.*pick; end 2.2 适应度函数 function error = fun(x,inputnum,hiddennum,outputnum,net,inputn,outputn) %该函数用来计算适应度值 %x input 个体 %inputnum input 输入层节点数 %outputnum input 隐含层节点数 %net input 网络 %inputn input 训练输入数据 %outputn input 训练输出数据 %error output 个体适应度值 %提取 w1=x(1:inputnum*hiddennum); B1=x(inputnum*hiddennum+1:inputnum*hiddennum+hiddennum); w2=x(inputnum*hiddennum+hiddennum+1:... inputnum*hiddennum+hiddennum+hiddennum*outputnum); B2=x(inputnum*hiddennum+hiddennum+hiddennum*outputnum+1:... inputnum*hiddennum+hiddennum+hiddennum*outputnum+outputnum); %网络进化参数 net.trainParam.epochs=20; % 最大迭代次数 net.trainParam.lr=0.05; % 学习率 net.trainParam.goal=0.00001; % 神经网络训练的目标误差 net.trainParam.showWindow=false; %网络权值赋值 net.iw{1,1}=reshape(w1,hiddennum,inputnum); % 输入层到中间层的权值 net.lw{2,1}=reshape(w2,outputnum,hiddennum); % 中间层到输出层的权值 net.b{1}=reshape(B1,hiddennum,1); % 中间各层神经元阈值 net.b{2}=B2; % 输出层各神经元阈值 %网络训练 net=train(net,inputn,outputn); an=sim(net,inputn); error=sum(abs(an-outputn)); end注: 先假设神经网络结构,{ 9 [80 50 20] 1 };9为输入层,[80 50 20]为隐层,1为输出层。 net.iw{1,1} 表示 输入层 到 第1层隐层 的权重,为80*9的矩阵;net.lw{2,1} 表示 第1层隐层 到 第2层隐层 的权重,为50*80的矩阵;net.lw{3,2} 表示 第2层隐层 到 第3层隐层 的权重,为20*50的矩阵;net.lw{4,3} 表示 第3层隐层 到 输出层 的权重,为1*20的矩阵;net.b{1} 表示 第1层隐层 的偏置,为80*1的矩阵;net.b{2} 表示 第2层隐层 的偏置,为50*1的矩阵;net.b{3} 表示 第3层隐层 的偏置,为20*1的矩阵;net.b{4} 表示 输出层 的偏置,为1*1的矩阵; 2.3 选择操作 function ret=Select(individuals,sizepop) % 该函数用于进行选择操作 % individuals input 种群信息 % sizepop input 种群规模 % ret output 选择后的新种群 %求适应度值倒数 fitness1=10./individuals.fitness; %individuals.fitness为个体适应度值 %个体选择概率 sumfitness=sum(fitness1); sumf=fitness1./sumfitness; %采用轮盘赌法选择新个体 index=zeros(1,sizepop); for i=1:sizepop %sizepop为种群数 pick=rand; while pick==0 pick=rand; end for j=1:sizepop pick=pick-sumf(j); if pickpcross continue; end % 随机选择交叉位 pick=rand; while pick==0 pick=rand; end %随机选择进行交叉的位置,即选择第几个变量进行交叉, %注意:两个染色体交叉的位置相同 pos=ceil(pick.*sum(lenchrom)); pick=rand; %交叉开始 v1=chrom(index(1),pos); v2=chrom(index(2),pos); %在v1与v2之间生成一个数,所以无须担心不符合约束条件 chrom(index(1),pos)=pick*v2+(1-pick)*v1; chrom(index(2),pos)=pick*v1+(1-pick)*v2; %交叉结束 end ret=chrom; end 2.5 变异操作 function ret=Mutation(pmutation,lenchrom,chrom,sizepop,num,maxgen,bound) % 本函数完成变异操作 % pcorss input : 变异概率 % lenchrom input : 染色体长度 % chrom input : 染色体群 % sizepop input : 种群规模 % opts input : 变异方法的选择 % num input : 当前迭代次数 % maxgen input : 最大迭代次数 % ret output : 变异后的染色体 for i=1:sizepop %每一轮for循环中,可能会进行一次变异操作, %染色体是随机选择的,变异位置也是随机选择的, %但该轮for循环中是否进行变异操作则由变异概率决定(continue控制) % 随机选择一个染色体进行变异 pick=rand; while pick==0 pick=rand; end index=ceil(pick*sizepop); % 变异概率决定该轮循环是否进行变异 pick=rand; if pick>pmutation continue; end % 变异位置 pick=rand; while pick==0 pick=rand; end pos=ceil(pick*sum(lenchrom)); %随机选择了染色体变异的位置, %即选择了第pos个变量进行变异 pick=rand; %变异开始 fg = rand*(1-num/maxgen)^2; if pick>0.5 chrom(index,pos)=chrom(index,pos)+... (bound(pos,2)-chrom(index,pos))*fg; else chrom(index,pos)=chrom(index,pos)-... (chrom(index,pos)-bound(pos,1))*fg; end %变异结束 end ret=chrom; 2.6 遗传算法主函数遗传算法主函数流程为: 步骤1:随机初始化种群;步骤2:计算种群适应度值,从中找出最优个体;步骤3:选择操作;步骤4:交叉操作;步骤5:变异操作;步骤6:判断进化是否结束,若否,则返回步骤2; % 清空环境变量 clc clear %% 读取数据 % input:2000*2,output:2000*1 load data.mat input output % 训练数据和预测数据 input_train = input(1:1900,:)'; input_test = input(1901:2000,:)'; output_train = output(1:1900)'; output_test = output(1901:2000)'; % 选择样本输入输出数据归一化 [inputn,inputps] = mapminmax(input_train); [outputn,outputps] = mapminmax(output_train); %% 网络结构建立 % 节点个数 inputnum = 2; hiddennum = 5; outputnum = 1; % 构建网络 net=newff(inputn,outputn,hiddennum); %% 遗传算法参数初始化 maxgen = 50; %进化代数,即迭代次数 sizepop = 10; %种群规模 pcross = 0.4; %交叉概率选择,0和1之间 pmutation = 0.2; %变异概率选择,0和1之间 % 节点总数 numsum = inputnum * hiddennum + hiddennum + hiddennum * outputnum+outputnum; lenchrom = ones(1,numsum); bound=[-3*ones(numsum,1) 3*ones(numsum,1)]; %数据范围 %% 种群初始化 % 将种群信息定义为一个结构体 individuals=struct('fitness',zeros(1,sizepop), 'chrom',[]); %初始化种群 for i=1:sizepop %随机产生一个种群 individuals.chrom(i,:)=Code(lenchrom,bound); %编码结果为一个实数向量 x=individuals.chrom(i,:); %计算适应度 individuals.fitness(i)=fun(x,inputnum,hiddennum,... outputnum,net,inputn,outputn); %染色体的适应度 end %找最好的染色体 [bestfitness,bestindex]=min(individuals.fitness); %每一代种群的最佳适应度 bestchrom=individuals.chrom(bestindex,:); %适应度最好的染色体 avgfitness=sum(individuals.fitness)/sizepop; %每一代种群的平均适应度 % 记录每一代进化中最好的适应度和平均适应度 trace=ones(maxgen+1,2); trace(1,:)=[avgfitness bestfitness]; %% 迭代求解最佳初始阀值和权值 % 进化开始 for i=1:maxgen disp(['遗传算法第',num2str(i),'代:']) % 选择 individuals=Select(individuals,sizepop); % 交叉 individuals.chrom=Cross(pcross,lenchrom,individuals.chrom,sizepop); % 变异 individuals.chrom=Mutation(pmutation,lenchrom,individuals.chrom,... sizepop,i,maxgen,bound); % 计算适应度 for j=1:sizepop x=individuals.chrom(j,:); individuals.fitness(j)=fun(x,inputnum,hiddennum,outputnum,net,... inputn,outputn); end %找到最小和最大适应度的染色体及它们在种群中的位置 [newbestfitness,newbestindex]=min(individuals.fitness); [worestfitness,worestindex]=max(individuals.fitness); % 代替上一次进化中最好的染色体 if bestfitness>newbestfitness bestfitness=newbestfitness; bestchrom=individuals.chrom(newbestindex,:); end individuals.chrom(worestindex,:)=bestchrom; individuals.fitness(worestindex)=bestfitness; avgfitness=sum(individuals.fitness)/sizepop; %记录每一代进化中最好的适应度和平均适应度 trace(i+1,:)=[avgfitness bestfitness]; disp(['最佳适应度',num2str(bestfitness)]) end % 遗传算法结果分析 figure(1) plot(trace(:,1),'b--'); hold on plot(trace(:,2),'r--'); title(['适应度曲线 ' '终止代数=' num2str(maxgen)]); xlabel('进化代数');ylabel('适应度'); legend('平均适应度','最佳适应度'); disp('遗传算法优化后的网络权值阈值'); x=bestchrom; disp(x);

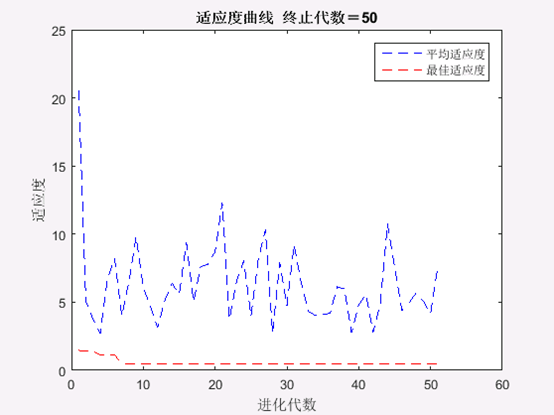

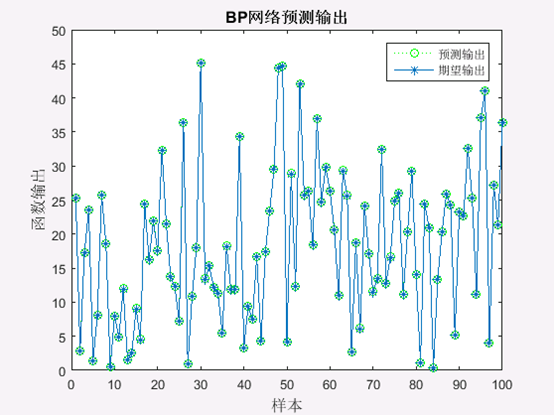

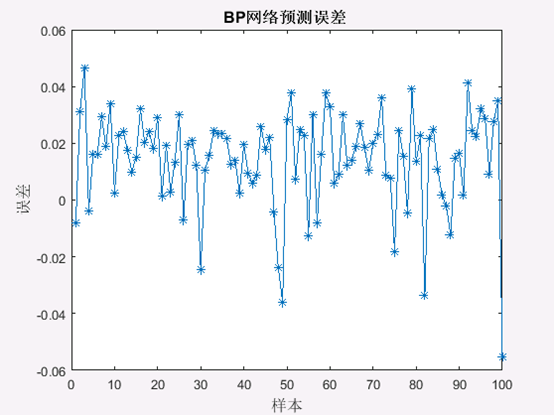

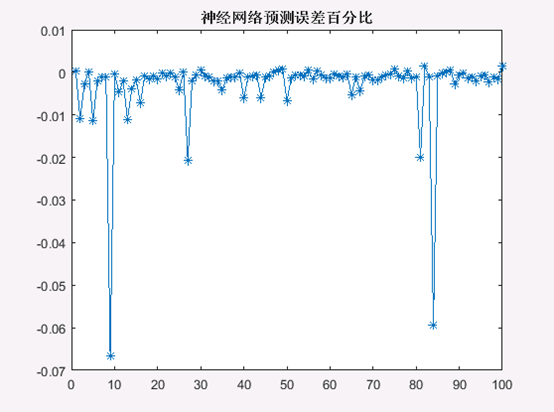

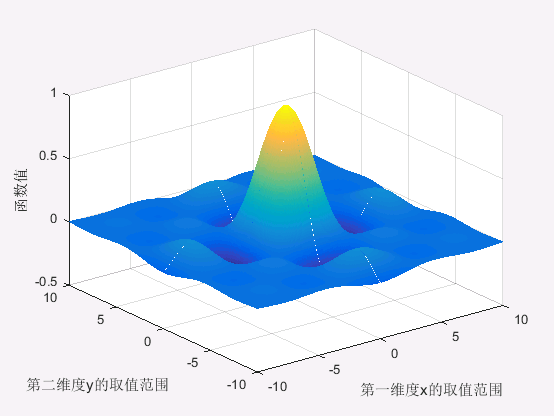

遗传算法优化BP神经网络过程中平均适应度与最优个体适应度值变化如图3所示。 遗传算法优化得到的BP神经网络最优初始权值和阈值如下表1所列。 表1 最优初始权值阈值 属性向量输入层隐含层间权值0.4315,2.6971,-1.8066,-2.4710,0.6966,0.0125,-1.7951,-2.0182,-2.5766,-2.1384隐含层节点阈值2.7510,0.6041,-1.4095,0.1721,-2.7112隐含层输出层间权值0.5404,-2.7593,-0.6510,1.9226,0.8620输出层节点阈值-0.3504把最优初始权值和阈值赋给神经网络,用训练数据训练100次后预测非线性函数输出,预测误差如图6、7所示。从对比数据见表2,可以看出遗传算法优化的BP神经网络预测更加精确。 表2 不同方法对比 优化方法迭代次数总体误差单隐含层BP神经网络1009.1493多隐含层BP神经网络1002.2148GA优化 BP神经网络101.9824可见,遗传算法优化BP神经网络是对普通BP神经网络的一种优化方法,如果把BP神经网络看成是一个预测函数,遗传算法优化BP神经网络相当于优化预测函数中的参数,优化后BP神经网络的预测效果一般优于未优化的BP网络。但是该算法是有局限性的,它只能有限提高原有BP神经网络的预测精度,并不能把预测误差较大的BP神经网络优化为能够准确预测的BP神经网络。尤其对一些因为样本数量少、样本分布不均匀而造成神经网络预测误差大的问题,优化后的网络预测能力一般不能得到明显提高。 四、练习(1)拟合的非线性函数: f ( x , y ) = sin x x × sin y y , x , y ∈ [ − 10 , 10 ] f(x,y) = \frac{ \sin x}{x}\times \frac{\sin y}{y},x,y\in[-10,10] f(x,y)=xsinx×ysiny,x,y∈[−10,10] 该函数的图形,如下图所示。

|

【本文地址】

今日新闻 |

推荐新闻 |