一种监控视频地理参考的方法 |

您所在的位置:网站首页 › 监控摄像头摆放位置图 › 一种监控视频地理参考的方法 |

一种监控视频地理参考的方法

|

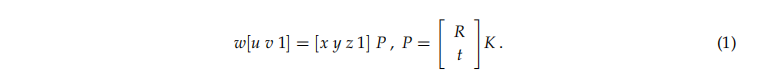

摘要: 监视摄像机视频与三维(3D)地理信息系统(GIS)的集成要求对视频进行地理配准。由于视频由单独的帧组成,因此必须对每个帧进行地理定位。为了对视频帧进行地理配准,我们依赖于捕获帧时有关摄像机视图的信息。 3D空间中的相机视图完全由相机位置(camera position),方向(orientation)和视野(field-of-view)确定。由于要精确测量这些参数非常困难,因此本文提出了一种基于将某些点特征的视频帧坐标与其3D地理位置进行匹配的估计方法。为了获得这些坐标,我们依赖于感兴趣区域的高分辨率正射照片和数字高程模型(DEM)。匹配足够数量的点后,将应用Levenberg-Marquardt迭代优化来查找最合适的视频帧地理参考,即摄像机的位置和方向。 关键字:视频监控; 相机校准; 地理注册 地理配准 1.简介由于视频监控系统在交通监控,犯罪预防,安全和事后分析中的重要作用,因此视频监控系统已迅速扩展[1]。 由于越来越多的安全问题,摄像机监视已被广泛用作监视公共场所的一种方法[2]。 当前,城市中有成千上万的摄像机每天收集大量数据[3]。 视频监视系统最初是为人类操作人员设计的,可以同时观看和录制视频以供以后分析。 随着摄像机数量的显着增加以及操作人员无法管理已归档视频数据的数量,引入了智能视频监视系统[2] 实时视频监控在众多安全,执法和军事应用的监控系统中发挥着越来越重要的作用[4]。然而,传统的视频监控系统在多点监控方面存在各种问题[5]。用于常规视频监视的典型系统将每个摄像机直接连接到相应的监视器。当监视系统的规模大于监视人员的能力时,可能会出现严重的问题。安全操作员必须在心理上将每个监视监控器映像映射到现实世界中的相应区域,而这一复杂的任务需要培训和经验[5]。为了促进多摄像机的协调和跟踪,Sankaranarayanan和Davis [6]强调了建立可将这些摄像机映射到的公共参考系的重要性。他们建议使用GIS作为通用参考框架,因为它不仅可以提供坚实的基础事实,而且(更重要的是)还可以用于存储语义信息(例如,建筑物,道路,敏感区域等)以用于在跟踪和活动分析等应用程序中使用。 为了集成视频和GIS,必须在地理上引用该视频。由于视频代表了一系列独立的图像(帧),因此要对其进行地理定位,必须在每个帧上附加信息,以将帧的像素映射到相应的地理位置。一种方法是在捕获帧时记录摄像机的位置,方向和视野,以便以后可以将帧图像投影到虚拟3D GIS场景中。由于测量这些参数可能既不准确又复杂,因此在本文中,我们将提出一种间接估计方法。该方法依赖于将视频帧的不同点与地理正射影像图和数字高程模型(DEM)进行匹配,以获取其3D坐标。匹配足够数量的不同点后,将应用Levenberg-Marquardt迭代优化[7,8]来找到最合适的视频地理参考,即摄像机的位置和方向。合适性的度量是所选点的输入和获得的图像坐标之间的最小平方误差的总和。 本文的组织结构如下:第2节介绍了有关视频监控(video surveillance),摄像机校准(camera calibration)和图像地理配准(image georegistration)的相关工作。 第3节介绍了有关监视摄像机视频地理配准(surveillance camera video georeferencing)的详细信息,重点是说明用于对单个视频帧进行地理配准的参数。 在第4节中,介绍了建议的估算方法,该方法涵盖了固定摄像机和全景摄像机(PTZ)的变化。 第5节介绍了该方法的软件实现和获得的实验结果。 最后,第6节介绍了结论。 2.相关工作传统上,视频监控系统的用户界面基于视频显示,地图和间接控件的矩阵。 空间导航,特别是对于涉及许多摄像机的复杂事件的实时跟踪,可能非常困难。 在这种情况下,操作员必须快速,准确地决定要使用哪些摄像机在众多可用摄像机之间导航。 为了应对安装的摄像机数量的增加,现代视频监控系统依靠智能视频监控[3]实现自动化,并通过上下文感知解决方案[9]更好地呈现监控数据,并与虚拟GIS环境集成[10,11]。 智能视频监控的目标是通过自动检测,跟踪和识别感兴趣的对象以及理解和分析在视频中检测到的活动,来从监控摄像机创建的大量视频中有效地提取有用的信息[3]。智能视频监控旨在最大程度地减少视频处理,传输和存储需求,使其适合大规模用作智能城市中的集成式安全保护解决方案。 Calavia等。 [12]提出了一种通过分析物体的轨迹来检测和识别异常和警报情况的系统。另一方面,视频和GIS的集成旨在统一从不同地理位置收集的视频信息的表示[13]。因此,它与智能和上下文感知视频监视技术没有冲突。相反,许多创新功能(例如基于GIS的用户界面可更好地了解情况,将一个或多个PTZ摄像机自动指向给定地理位置,与地理位置传感器集成以及基于地理位置的自动化用于事件处理)可以实现。出现[10]。 Lewis等人考虑了将空间视频(即地理参考视频数据)作为GIS中其他数据类型的潜力。 [14]。他们的研究重点是使用Viewpoint数据结构表示视频帧,以便进行地理空间分析。近年来,越来越多的论文解决了大规模视频监控以及与GIS集成的不同问题。 Wang等人提出了视觉覆盖率的估计方法,它是描述摄像机网络可用性的最重要的质量指标之一。 [15]和Yaagoubi等。 [16]。针对类似问题,Choi和Lee [1]提出了一种评估监视覆盖率指数的方法,以定量地衡量视频监视系统可以如何有效监视目标区域。 Wu等人解决了组织和管理用于公共安全视频监视的实时地理空间数据的问题。 [17]。他们提出了一种用于实时数据访问和结构化的动态分析的NoSQL-SQL混合方法,可以满足时空大数据链接分析需求的增长。为了克服常规视频监控系统的局限性,例如视频搜索效率低,视频数据传输冗余以及在地理空间中定位视频内容的能力不足,Xie等人。 [13]提出了通过使用运动检测和空间映射将GIS和运动视频中的移动对象集成在一起的方法。 视频和GIS融合(the fusion of video and GIS)的前提是视频帧在地理上是参考的(video frames are geographically referenced)。 地理配准视频(Georeferencing video)在许多方面与摄像机校准(camera calibration)(或摄像机姿态估计camera pose estimation)和视频地理配准(video georegistration)的问题有关。 相机校准是计算机视觉中的一个基本问题,在许多视频监控应用中必不可少[3]。 相机校准是估计内部和/或外部参数的过程。 内部参数处理相机的内部特性,例如焦距(focal length),主点(principal point),偏斜系数(skew coefficients)和失真系数(distortion coefficients)。 外在参数描述了它在世界上的位置(position)和方向(orientation)。 相机校准的问题已在文献中得到了很好的介绍。 Zhang [18]提出了一种简单的相机校准技术,通过观察在几个不同方向上显示的平面图案来确定径向变形。 Lee and Nevatia [2]开发了一种用于城市环境的视频监控摄像机校准工具,该工具依赖于消失点提取。由于有许多平行线,例如街道线,灯杆,建筑物等,在城市环境中很容易获得消失点。Muñoz等人已经研究了通过Levenberg-Marquardt方法校准环境摄像机图像。 [19]。他们提出了一种程序,该程序依靠少量的地面控制点(GCP)来估计所有针孔相机模型参数,包括镜头畸变参数。对于许多其他与计算机视觉和摄影测量相关的问题,例如从多个图像进行的3D重建(3D reconstruction)[20],视觉测距(visual odometry)[21]和视觉SLAM(同时定位和映射simultaneous localization and mapping)[22],相机校准技术(Camera calibration techniques)必不可少。 视频地理配准(Video georegistration)是视频图像在地理上校准的参考图像的空间配准,以便视频可以继承参考坐标[23]。将大地坐标分配给视频像素的能力是使多种操作受益的步骤,这些操作可以从大规模视频监视中受益。在摄影测量界,从移动平台进行地理空间图像精确地理配准的流行方法称为直接地理配准[24]。此类应用所需的相机位置和方向是从大地测量级全球导航卫星系统(GNSS)接收器与高质量导航级惯性导航系统(INS)结合获得的。通过额外集成地面控制信息,可以进一步提高直接地理配准的可实现精度。 Neumann等。 [25]介绍了一种基于数据与可用3D模型的融合来稳定直接地理参考视频流的方法。莫尔斯等。 [26]作为他们致力于创建地理空间视频覆盖质量地图的研究的一部分,报告了使用地形模型和空中参考图像来完善无人机(UAV)摄像机的姿态估计的情况。 地面图像或静止视频(例如监视摄像机视频)的地理注册通常依赖于基于单应矩阵(homography matrix-based)的方法[27,28]。这些方法假定在地理空间中为平面地面,因此需要四个或更多匹配点才能确定相应的单应性矩阵。由于它们基于平面地面的假设,因此基于单应矩阵的方法不适用于大型场景或复杂地形的场景。在这些情况下,通常会考虑地形模型,并且地理配准(georegistration)等效于地理空间中的摄像机姿态估计(the camera pose estimation)[19]。近年来,出现了其他基于地理注册3D点云的方法。 Li等。 [29]提出了一种使用大型地理配准3D点云进行全球相机姿态估计的方法,该方法覆盖了世界各地。他们的方法直接在图像特征和3D点之间建立对应关系,然后计算与这些特征匹配相一致的相机姿态。 Qi Shan等人也采用了类似的方法。 [30]附加将地面图像扭曲到目标视图中,以实现更可靠的特征对应。 提议的对监视视频进行地理配准的方法依赖于将视频帧中的2D图像坐标与3D大地坐标相匹配,以估计摄像机在地理空间中的位置和方向。 这种方法的主要优点是通用性强,即监视区域不必一定是平面的,并且可以以不同的方式获得已识别点的3D大地坐标。 该方法的第二个重要优点是它的简便性,因为应用该方法的唯一两个先决条件是地理正射影像图和DEM。 最后,第三个也是最明显的优势是它支持PTZ摄像机的地理配准。 3.地理配准监控摄像机视频(Georeferencing Surveillance Camera Video) 3.1 针孔相机模型视频代表一系列固定间隔的静态图像(称为“帧”)。 对视频进行地理配准的问题归结为对视频的每个帧进行地理配准的问题。 要对视频帧进行地理配准,我们依赖于帧捕获时有关摄像机视图的信息。 可以使用pinhole camera模型[18]中定义的4×3摄像机矩阵(P)来指定摄像机视图:

相机矩阵(P)将3D世界坐标(x,y,z)映射到图像坐标(u,v)。 摄像机矩阵(P)可以使用外部([R t] T)和内部(K)参数表示。 外在参数表示相机在3D世界中的位置和方向,而内在参数表示相机的光学中心(cu,cv)和焦距(fu,fv): 参数s是偏斜系数,如果图像轴不垂直,则偏斜系数不为零。 参数fu和fv分别代表以像素为单位的水平和垂直方向上的焦距。 可以使用世界单位(F)的焦距和世界单位(pu,pv)的像素大小来表示它们:

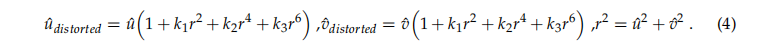

提出的针孔相机模型不考虑镜头畸变,因此为了准确表示真实的相机,使用了以下径向畸变模型[18]:

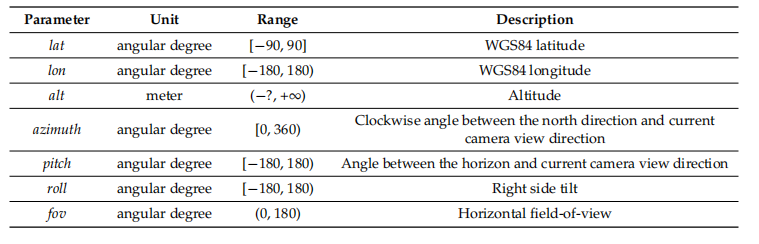

使用k1,k2和k3参数对径向变形进行建模。 未归一化的像素位置(uˆ,vˆ)和畸变的(uˆdistorted,vˆdistorted)像素在标准化图像坐标中表示。 通过将像素坐标平移到光学中心(cu,cv),然后将其除以像素的焦距(fu,fv),可以从像素坐标计算出归一化的图像坐标。 3.2 观察者观点模型要将摄像机视图与地理空间相关联,必须在地理上引用外部摄像机参数。 Milosavljevi´c等人定义了一组较短的参数,这些参数确定地理空间中的摄像机视图。 [31]作为观察者视点模型。 为了描述摄像机视图,观察者视点模型使用摄像机的位置(position),方向(orientation)和视野(field-of-view)(简称fov)。 相机的视野代表一个简单的参数,而相机的位置和方向则是更为复杂的视点特征,可以用几种不同的方式表示。 为了表示摄像机在3D地理空间中的位置,我们需要将三个坐标绑定到某个地理坐标系。地理坐标系主要分为三类:地心坐标系,大地坐标系和投影坐标系[32]。地心和大地坐标适用于地球级别,而投影系统通常与某些地区或国家相关。地心坐标系是笛卡尔型坐标系,其中心与地球中心对齐。为了表示地心系统中的一个点,x,y和z坐标与以米为单位的值一起使用。尽管对某些转换有利,但表示地球位置的更自然的方法是使用大地坐标系。大地坐标中的位置由纬度(lat),经度(lon)和海拔高度(alt)指定。当今最广泛的大地坐标系称为WGS84,它基于具有相同名称的椭球[33]。 WGS84坐标系用于全球定位系统(GPS),因此,由于其通用性,它还可用于表示观察者视点模型中的位置(纬度,经度和高度参数)。 相机方向定义了相机外观的方向。 通过应用围绕所有三个轴的旋转来设置3D空间中的方向。 这意味着相机方向也由三个参数确定,其中每个参数代表围绕某个轴的旋转。 这三个角度必须与某个参考系统绑定在一起才能有意义。 我们依靠一种用于飞行动力学的方法来引入三种旋转:偏航(yaw),俯仰(pitch)和横滚(roll)[34]。 在右手坐标系中定义旋转,其中x轴指向飞机方向,y轴指向右边,z轴指向下方。 围绕z轴的旋转称为偏航,围绕y轴的旋转称为俯仰,而围绕x轴的旋转称为滚动。 所有旋转均沿顺时针方向指定。 如果我们将坐标中心与摄影机位置对齐,将z轴指向地球的重心,将x轴指向地理北极,则可以使用所描述的模型指定地理空间中的摄影机方向。 在这种情况下,围绕z轴的旋转表示方位角。 最后,为了定义视频帧的地理参考,即在捕获帧时的摄像机视点,我们使用表1中指定的七个参数。 表1.用于在地理空间中指定摄像机视点的一组参数。

Clockwise angle between the north direction and current camera view direction:北方方向与当前相机查看方向之间的顺时针角度 Angle between the horizon and current camera view direction:水平线和当前相机查看方向之间的角度 Right side tilt:右侧倾斜 Horizontal field-of-view:水平视场 提议的视频地理配准模型是通用的,即,它不依赖于地理空间视频的来源。 它既可以应用于固定和PTZ监控摄像机,也可以应用于配备GPS和方向传感器的移动电话,也可以应用于安装在无人机或车辆上的摄像机等。 当涉及对视频监控摄像机框架进行地理配准时,所有摄像机的主要特点是它们被固定在固定的位置。 结果,摄像机视点的前三个参数(lati, loni, alti)是恒定的,并且在摄像机安装期间确定。 对于固定摄像机,其他四个参数也是恒定的,而对于PTZ摄像机,可以从本地摄像机参数,例如,平移,倾斜和缩放 确定它们(pan, tilt, zoom)[31]。 这意味着对摄像机摄像头视频进行地理配准是确定摄像机位置,初始方向和视野的一次性任务,即对摄像机本身进行地理配准。 视频帧地理配准的图形化图示如图1所示。除了观察者视点模型参数的图示以外,图1还描述了使用虚构的“图片平面”(picture plane)进行摄像机操作的原理。 通过将现实世界坐标(lati,loni,alti)投影到图片平面(ui,vi)上来形成图像。 在数字摄影中,输出结果是以像素为单位的一定宽度(w)和高度(h)的数字图像,因此图像坐标(ui,vi)也可以以像素表示。 链接现实世界的大地坐标和图像像素坐标是所提出的估算相机地理参考方法的基石。 在下一节中,我们将进一步研究它们之间的关系。

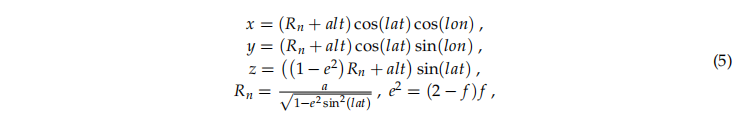

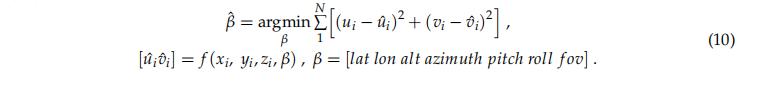

图1.使用观察者视图模型的七个参数对视频帧进行地理配准的示意图。 4.相机地理参考的估计提出的摄像机地理配准方法依赖于将视频中的不同点与其各自的3D大地坐标相匹配。 为了获取这些坐标,我们依靠将这些点与地理正射影像图上的位置进行匹配,并从感兴趣区域的数字高程模型(DEM)中读取它们的高度。 获取大地坐标的其他方法也是可能的。 匹配足够数量的不同点后,将应用Levenberg-Marquardt(列文伯格算法)迭代优化[7,8]来找到最合适的视频地理参考,即摄像机的位置和方向。 过程精度的度量是所选点的输入坐标与获得的图像坐标之间的最小平方误差的总和。 由于图像坐标是以像素为单位指定的,因此该误差表示对估算的地理参考的“视觉质量”(visual quality)的度量。 该方法可同时应用于固定摄像机和PTZ摄像机。首先,我们将讨论固定摄像机,然后介绍所需的修改,以便将该方法应用于PTZ摄像机。 4.1 固定相机为了更好地理解所提出方法的输入和输出,让我们再次考虑图1所示的示例。该方法的输出是摄影机地理参考,即参数lat,lon,alt,azimuth(方位角),pitch(俯仰)和roll(横滚)。 最后一个参数fov也可以估算,或者可以预先测量[35],并在此过程中取为常数。 方法输入是一定数量(i = 1,...,N)的成对世界(lati,loni,alti)和图像坐标(ui,vi)。 由于我们依靠迭代优化,因此我们还需要一些初始地理参考来启动此过程,还需要对摄像机的位置和方向进行一些粗略的估算。 最后,我们需要相机的数学模型,该模型将使用当前的地理参考(lat, lon, alt, azimuth, pitch, roll, fov)将输入的3D大地坐标(lati,loni,alti)转换为估计的图像坐标(ui,vi)。 为此,我们采用了先前描述的pinhole camera model(请参见公式(1)–(3))。 由于针孔模型在笛卡尔空间中使用3D世界坐标进行操作,因此必须在内部将输入大地坐标转换为适当的笛卡尔形式。 为了确保我们的方法在地球上任何地方的统一适用性,我们使用了通过大地到地心变换获得的地心坐标[36]:

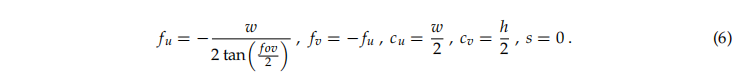

其中参数a代表半长轴(赤道半径),参数f代表椭圆体的扁平度(对于WGS84椭圆体a = 6,378,137 m和f = 1 / 298.257223563)。 应用针孔相机模型的下一步是使用观察者视点模型的七个参数来指定相机的外部([R t] T)和固有(K)参数。 相机固有矩阵(K)的参数fu,fv,cu和cv使用fov参数以及以像素为单位的帧的宽度(w)和高度(h)进行计算:

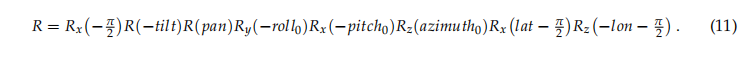

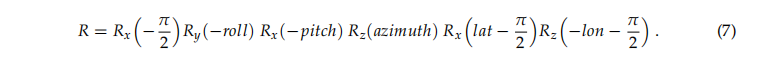

旋转矩阵R使用azimuth(方位角),pitch(俯仰)和roll(横滚) 参数计算,而lat和lon用于旋转坐标系:

最后,根据地心相机位置(通过转换lat,lon和alt参数以及先前计算的旋转矩阵R来计算平移矢量t):

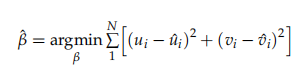

一旦我们初始化了针孔模型参数并将输入的大地坐标(lati,loni,alti)转换为地心坐标(xi,yi,zi),就可以将这些坐标转换为图像坐标(ui,vi)。 在获得的图像坐标(ui,vi)和输入即期望的图像坐标(ui,vi)之间计算出在处理过程中最小化的均方误差:

注: 在迭代过程的每个循环中,都对地理参考参数β进行了修改,以减少误差。 当误差降到某个特定值以下或所有参数的增量降到某个特定值以下时,该过程结束。 我们应该强调,如果fov参数是预先确定的,则可以将其排除在优化过程之外。 为了开始迭代过程,有必要定义估计参数的初始值,即摄像机地理参考。 在一个函数只有一个最小值的情况下,初始值不会影响结果。 但是,如果存在多个局部最小值,则初始值应接近预期的解。 当应用于我们的案例时,考虑到转换的复杂性,这意味着有必要提供摄像机位置和方向的近似值,即大致确定摄像机的地理参考。 最后,让我们总结一下执行固定摄像机地理配准方法的步骤清单: 1.设置初始地理参考:可以通过使用GPS测量摄像机位置或从地图中读取来获得初始地理参考。可以使用罗盘(方位角参数)或通过将周围物体与地图匹配来大致估计相机方向。 2.识别视频中的不同点:应从视频中识别出大约十个或更均匀分布的点,并记录其图像坐标。选定的点不应随时间变化,而应位于地面上(如果可以提供点的高度,则这不是强制性的)。 3.获取识别点的3D大地坐标:可以使用高分辨率正射影像图和DEM获得大地坐标。在没有地图的情况下,也可以使用差分GPS测量那些坐标。 4.使用迭代过程细化地理参考参数:进行迭代优化,以找到在识别出的图像坐标和通过转换获得的图像坐标之间均方误差最小的地理参考参数。如果优化被锁定在局部最小值中,并且估计误差太大,则应使用新的初始地理参考和可能的新点集重新启动该过程。 5.验证获得的地理参考:估计最佳地理参考后,可以通过观察输入坐标和获得的图像坐标之间的差异来应用和检验。 4.2 PTZ相机PTZ是Pan-Tilt-Zoom的首字母缩写,在视频监控术语中表示一类摄像机,可以水平旋转(pan)和垂直旋转(tilt),并且可以通过更改缩放级别来改变视场。 Milosavljevi介绍了一种方法,该方法用于根据当前相对摄像机方向(pan【水平】 和 tilt【俯仰】)和当水平和平移参数为0(azimuth0, pitch0, and roll0)时,从当前相对摄像机方向(pan水平和tilt俯仰)和绝对摄像机方向来计算绝对摄像机方向(方位)Milosavljevi´c et al. [31].。 关于前面关于初始化针孔模型参数的讨论,唯一的区别是旋转矩阵R的计算方式:

由于外部相机矩阵现在取决于pan(水平)和tilt(倾斜)参数,并且fov参数不再固定,因此必须将它们以及大地测量和图像坐标包括在内作为输入量度(pani,tliti,fovi)。 因此,现在将公式(10)中定义的优化参数β和变换f修改为:

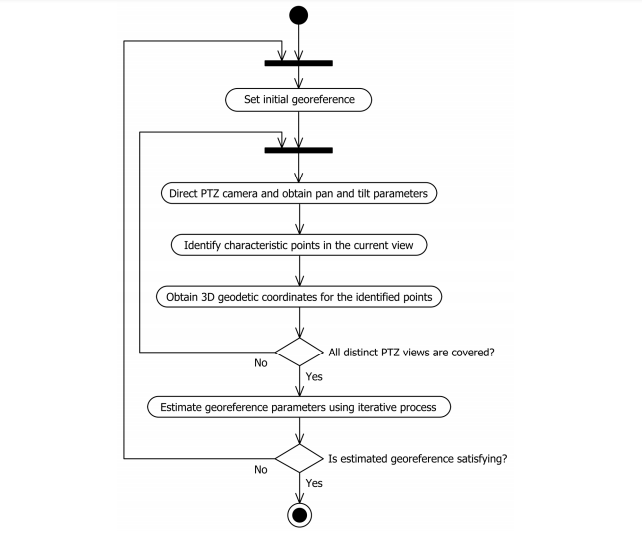

由于不再估计当前摄像机的视场(fovi),因此有必要根据变焦参数的相应值来确定它。 可以通过分析[35]进行适当的转换,也可以根据经验对特定相机模型进行测量并保存在查找表中。 一个UML活动图说明了PTZ摄像机地理配准的过程,如图2所示。 set initial georeference 设置初始地理参考 direct PTZ camera and obtain pan and tilt parameters 定向PTZ摄像机并获取平移和倾斜参数 Identify characteristic points in the current view 识别当前视图中的特征点 Obtain 3D geodetic coordinates for the identified points 获取已识别点的3D大地坐标 All distinct PTZ views are covered? 是否涵盖所有不同的PTZ视图? Estimate georeference parameters using iterative process 使用迭代过程估算地理参考参数 Is estinated georeference satisfying? 估计的地理参考是否令人满意?

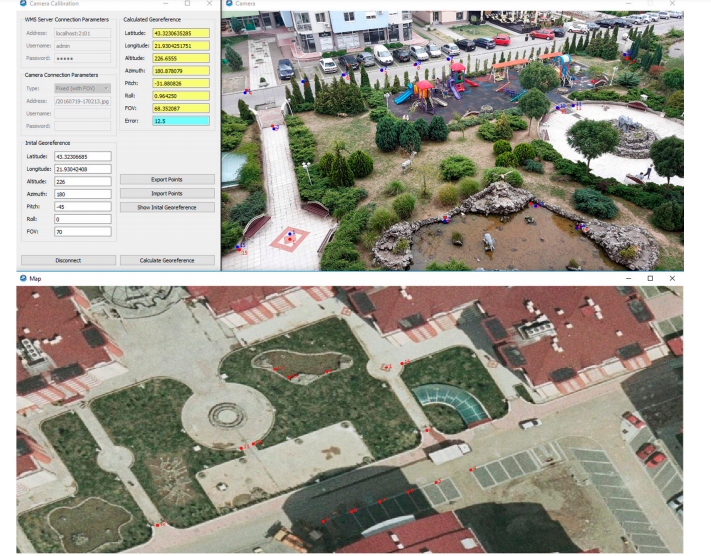

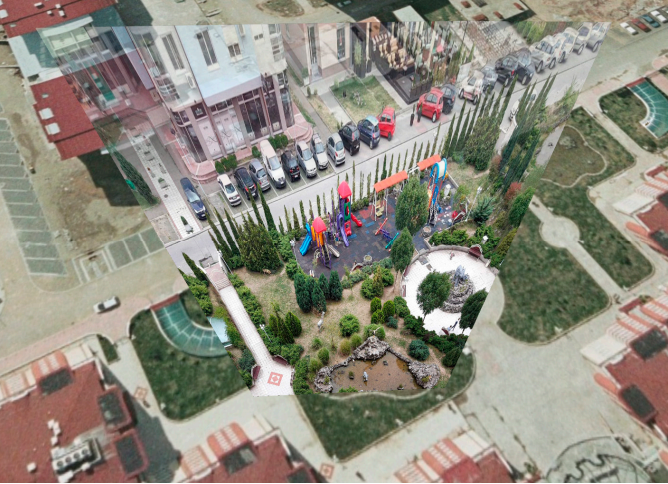

图2.一个UML活动图,它说明了PTZ摄像机地理配准的过程。 5.实施和实验结果为了验证所提出的估算方法,我们为地理配准监视摄像机实施了名为“摄像机校准”(Camera Calibration for georeferencing surveillance cameras)的应用程序。 该应用程序支持固定和PTZ网络(即IP)摄像机。 视频检索是使用HTTP协议完成的,因此对于固定摄像机,只需输入用于检索当前视频帧的URL。 (可选)可以输入用户名和密码来访问相机API。 对于PTZ摄像机,除了视频帧外,还需要另外检索当前的平移,倾斜和缩放值。 目前,我们仅通过VAPIX协议支持AXIS PTZ摄像机,但可以进行进一步升级。 除了依赖于相机之外,该应用程序还依赖于Web地图服务(WMS)的使用来检索相机周围区域的正射影像图,从而检索所选点的高程。 这就是应用程序依赖两个标准WMS请求的原因:GetMap和GetFeatureInfo。 顾名思义,GetMap用于检索请求区域的地理参考图像(地图),而GetFeatureInfo用于检索该地图上特定点的其他信息(在本例中为高程)。 该应用程序是使用Qt框架版本4.8.5在C ++中实现的。用户界面(UI)如图3所示,它分为三个独立的部分(窗口)。主窗口用于控制应用程序。在这里,用户可以设置WMS服务器和摄像机参数,输入初始地理参考,开始地理参考估计并查看计算结果。第二部分是摄像机视图,用于显示视频和其中标识的点,还用于标识点,显示相应的输出点,并且在PTZ摄像机的情况下,它允许用户控制摄像机。最后,第三部分是地图视图,该地图视图用于显示和导航感兴趣区域的正射影像,从而输入和显示识别的点。图3描绘了如何在使用15点的相机地理配准的实际场景中使用应用程序的不同部分。获得的地理参考的结果在摄像机视图中以蓝色点和红色输入点表示。为了说明使用所提出的方法实现的精度,图4描绘了我们基于GIS的视频监控解决方案[10]的投影视频模式下显示的对应摄像机输出。图5显示了以相同方式描述的地理参考的其他几个示例。这些示例的地理参考使用像素大小为0.1 m的thophoto地图和地面采样距离(GSD)为1 m的DEM进行。

图3.用于地理配准监视摄像机的Camera Calibration应用程序的用户界面。

图4.使用Camera Calibration应用程序进行地理配准的结果,显示在基于GIS的视频监控解决方案的投影视频模式中

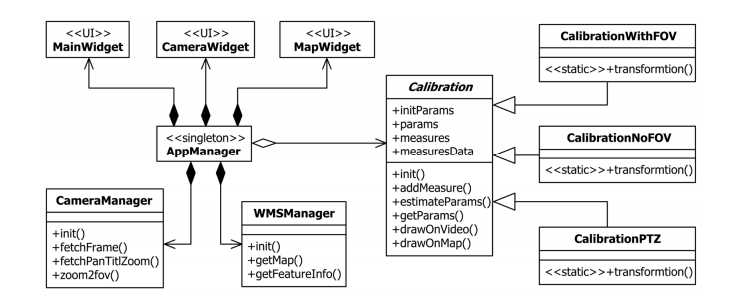

图5.使用摄像机校准应用程序获得的示例地理参考,显示在我们基于GIS的视频监控解决方案的投影视频模式中[10] 四重迭代优化。 该技术是非线性最小二乘问题的一种标准方法,可以认为是最速下降法和高斯-牛顿法的组合[37]。 为了在我们的应用程序中实现它,我们使用了一个名为levmar [38]的开源C / C ++库。 levmar的优势之一是它支持使用解析和近似雅可比矩阵。 由于我们用于将输入3D大地坐标映射到输出图像坐标的转换相当复杂,因此寻找解析Jacobian并不是一件容易的事。 这就是为什么我们依靠levmar的特征使用有限差分法近似Jacobian的原因。 levmar库提供了几个接口函数,这些函数提供无约束和约束优化,单精度和双精度的使用,以及如前所述的解析和近似雅可比行列式。 在我们的实现中,我们使用了dlevmar_dif函数,该函数提供双精度,无约束的优化以及近似雅可比行列式。 相应的输入参数的完整描述在[38]中给出,但是通常,它需要一个初始参数的估计值,测量向量,一个可选的指向附加数据的指针以及一个指向实现适当转换的函数的指针。 在我们的情况下,初始参数对应于初始地理参考,对一组输入视频坐标的测量,而其他数据则包含相应的3D大地坐标,帧宽度(w)和高度(h),以及可选的fov,pan ,以及每次测量的倾斜值。 最后,为了完成本概述,让我们考虑实现的应用程序的体系结构。相应的UML类图如图6所示。整个应用程序围绕单例类AppManager构建,该类用于其他类之间的通信。每个类都有三个小部件类(MainWidget,CameraWidget和MapWidget)。前面描述的UI部件。 CameraManager类代表指向监视摄像机的接口,而WMSManager类代表指向WMS服务器的接口。最后,应用程序最重要的部分封装在Calibration抽象类及其派生类中。当包含fov时,Class CalibrationWithFOV类可实现固定摄像机的完整地理参考估计。同样,如果已知fov并将其从估计中排除,则将CalibrationNoFOV类用于固定摄像机。最后,使用CalibrationPTZ估算PTZ摄像机的地理参考。这三个子类包含每个指定子域的特定转换,而抽象超类为该过程提供一个公共接口并保存必要的数据。

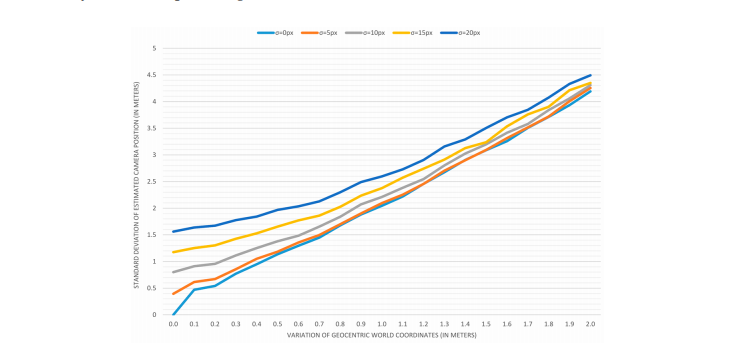

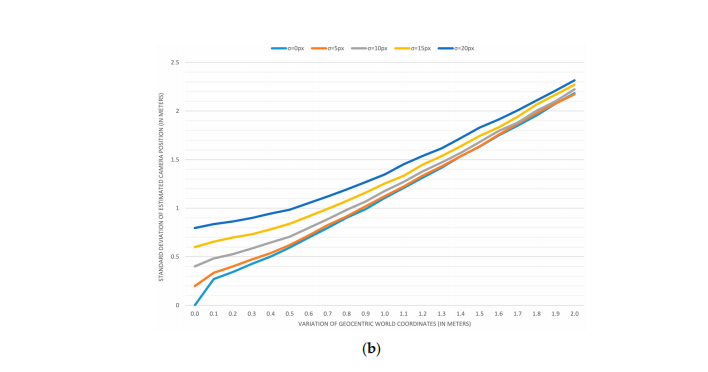

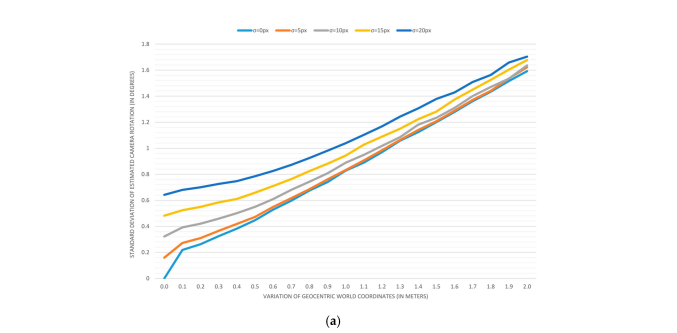

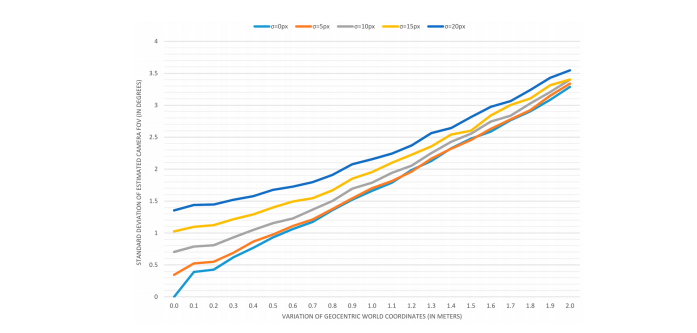

图6.使用UML类图说明了Camera Calibration应用程序的体系结构。 准确性分析 图4和5所示的示例为我们提供了一些有关估计摄像机地理参考的可达到精度的想法。 但是,由于我们缺乏基本的真值,因此很难确定估计值之间的差异。 另外,知道确定世界和图像坐标的精度如何影响结果将是很有趣的。 为了应对特定的挑战,我们开发了一系列综合实验,将3D世界和图像坐标的测量误差与估计位置,方向和视野中的误差相关联。 实验使用以下方法进行: 1.创建地面真实数据集:基于包含15个大地坐标和图像坐标之间映射关系的真实示例,我们估算了相机的地理参考,即相机的位置,方向和视野。 然后,我们使用获得的地理参考对输入的大地坐标进行转换,并获得输出图像坐标。 这些图像坐标,以及输入的大地坐标和所选的地理参考,代表了我们理想的零误差数据集,该数据集将被视为所有其他估计的基础事实。 2.添加变化并估计地理参考:为了模拟获取大地测量和图像坐标的过程中的错误,我们将某个范围(正负变化量)中随机生成的值添加到输入坐标中。 为了模拟地图读取中的错误,我们生成了以米为单位的变化,并将其添加到根据地面真实大地坐标计算得出的地心坐标中。 为了模拟图像坐标读取中的错误,我们生成了像素变化,并将其添加到地面真实图像坐标中。 以这种方式创建样本数据集后,我们将应用估算方法来确定最合适的地理参考。 记录参数之间差异的平方. 3.平均结果:由于单次测量严重依赖于所选取的随机值,为了平均结果并获得误差的估计,我们基于累积的平方差应用了10,000次这样的测量,因此我们计算了位置的标准偏差( (以米为单位),方向和视野(以度为单位)。 4.绘制结果图:为了可视化趋势,我们应用了先前的测量方法,以测量地心坐标的变化范围为0至2 m,步长为0.1 m。 0、5、10、15和20像素的图像坐标变化为 准确性分析的结果显示在图7–10中。图7描述了当估计视场(a)和预定视场时(b),在估计摄像机位置时的误差。可以看出,估计过程中的一个附加参数使定位误差加倍。以类似的形式,图8描述了估计摄像机方向时的误差。在这种情况下,再次估计视野会导致更大的误差,但在这种情况下,差异几乎没有意义。下图显示了相机视野的估计误差(图9)。最后,图10表示在估计视场(a)和预先确定视场(b)时,根据图像坐标的标准偏差表示的估计过程误差。可以假定,将视场作为附加的估计参数会导致较小的总体过程误差,但是令人惊讶的是,这种差异很难引起注意。 提出的结果得出的结论是,应尽可能考虑独立准确地确定摄像机的视场。第二个有趣的发现是,当地图读取或在0.3m以上时,最多5个像素的输入图像坐标的变化几乎不会影响准确性。

图7

图7.对于世界坐标的不同变化,估计的摄像机位置的标准偏差:(a)估算视场参数时,(b)预定视场时。 不同的序列描述了输入图像坐标(σ值)的不同变化。

图8.对于世界坐标的不同变化,估计的照相机方向的标准偏差:(a)估计视场参数时,(b)预定视场时。 不同的序列描述了输入图像坐标(σ值)的不同变化。

图9.对于世界坐标的不同变化,估计的摄像机视场的标准偏差。不同的序列描述了输入图像坐标(σ值)的不同变化。

图10.针对世界坐标的不同变化进行优化后的图像坐标的标准偏差:(a)估算视场参数时,(b)预定视场时。不同的序列描述了输入图像坐标(σ值)的不同变化。 6.结论视频监视和3D GIS的集成为传统监视系统无法实现的新机遇铺平了道路[20]。获取视频中每个点的地理位置或将PTZ摄像机定向到给定地理位置的能力取决于所提供视频地理参考的质量。由于视频代表一连串图像(帧),因此要对其进行地理配准,我们需要知道确切的参数,这些参数确定在捕获每一帧时的摄像机视图。 Milosavljevi´c等人先前已经定义了一组适当的七个参数,用于指定摄像机的位置,方向和视野。 [31]作为观察者视点模型。由于基于GIS的视频监视依赖于视频帧与虚拟3D GIS场景的重叠,因此地理参考参数中即使很小的误差也变得显而易见。因此,有必要准确地确定相机的地理参考。尽管可以测量这些参数,但是所需的过程很复杂,并且结果并不总是保证令人满意的精度。本文提出的研究目的是通过开发一种间接估计这些参数的方法来提出另一种选择。 所提出的方法基于将可以在视频中识别的某些静态点特征的图像坐标与从高分辨率正射照片和DEM获得的3D地理位置配对。 一旦我们配对了足够均匀的分布点,便应用Levenberg-Marquardt迭代优化算法来找到最合适的摄像机地理参考,即估算摄像机的位置和方向。 为此,该过程试图使输入图像坐标与使用当前地理参考参数转换输入3D大地坐标获得的图像坐标之间的最小二乘误差之和最小。 所提出的方法可用于估计固定摄像机和PTZ摄像机的地理参考。 对于固定摄像机,我们有一个更简单的情况,其中视频帧的地理参考是恒定的,可以视为摄像机的地理参考。 另一方面,PTZ摄像机引入了“动态”视频帧地理参考,这取决于平移,倾斜和缩放的当前值。 在那种情况下,摄像机的地理参考值等于视频帧的地理参考值,其中平移和倾斜设置为零。 当前帧的地理参考值是根据摄影机的地理参考值和当前的平移和倾斜值计算得出的。 在本文中,我们还讨论了如何将该方法应用于估算PTZ摄像机的地理参考。 基于提出的方法,我们实现了对固定和PTZ监控摄像机进行地理配准的应用程序。 该应用程序不仅提供了对所描述方法的验证,而且证明了在分配的任务中非常有效。 提出的方法的优点可以总结如下: •与测量值相比,生成的地理参考的精度非常高 •简化的地理配准程序(无需离开办公室) •即使在无法进行现场测量的情况下(例如,遥远的位置,受限的区域),也能够确定相机的地理参考 •当无法测量固定摄像机的视野时(例如,预先安装的摄像机),可以估算固定摄像机的视野 •支持PTZ摄像机 最后,我们要强调的是,即使这些结果令人满意,该方法还是依赖于人类的,因此,它具有很大的自动化潜力。 自动识别和配对点的能力将是一项巨大的进步,可能会导致视频和GIS的集成超越视频监控。 参考文献 1. Choi, K.; Lee, I. CCTV Coverage Index Based on Surveillance Resolution and Its Evaluation Using 3D Spatial Analysis 基于监视分辨率的CCTV覆盖率指数及其3D空间分析评估. Sensors 2015, 15, 23341–23360. [CrossRef] [PubMed] 2. Lee, S.C.; Nevatia, R. Robust camera calibration tool for video surveillance camera in urban environment. In Proceedings of the IEEE CVPR 2011 Workshops, Colorado Springs, CO, USA, 20–25 June 2011; pp. 62–67. 用于城市环境中视频监控摄像机的强大摄像机校准工具。 在IEEE CVPR 2011研讨会论文集中 3. Wang, X. Intelligent multi-camera video surveillance: A review. Pattern Recognit. Lett. 2013, 34, 3–19. [CrossRef]智能多摄像机视频监控:评论、 模式识别 4. Sebe, I.O.; Hu, J.; You, S.; Neumann, U. 3D video surveillance with Augmented Virtual Environments. In Proceedings of the First ACM SIGMM International Workshop on Video Surveillance (IWVS’03),增强虚拟环境的3D视频监控。 在第一届ACM SIGMM国际视频监控研讨会上的会议记录 New York, NY, USA, 2–8 November 2003; p. 107. 5. Kawasaki, N.; Takai, Y. Video monitoring system for security surveillance based on augmented reality. In Proceedings of the 12th international conference on artificial reality and telexistence (ICAT), Tokyo, Japan, 4–6 December 2002.基于增强现实的安全监控视频监控系统。 在第十二届人工现实与远程体验国际会议论文集(ICAT) 6. Sankaranarayanan, K.; Davis, J.W. A Fast Linear Registration Framework for Multi-camera GIS Coordination. In Proceedings of the 2008 IEEE Fifth International Conference on Advanced Video and Signal Based Surveillance, Santa Fe, NM, USA, 1–3 September 2008; pp. 245–251. 用于多摄像机GIS协调的快速线性注册框架。 在美国新墨西哥州圣达菲举行的2008 IEEE第五届高级视频和信号监控国际会议论文集中 7. Levenberg, K. A Method for the Solution of Certain Non-Linear Problems in Least Squares. Q. Appl. Math. 1944, 2, 164–168. [CrossRef]最小二乘中某些非线性问题的求解方法。 8. Marquardt, D.W. An Algorithm for Least-Squares Estimation of Nonlinear Parameters. J. Soc. Ind. Appl. Math. 1963, 11, 431–441. [CrossRef]非线性参数的最小二乘估计算法。 9. De Haan, G.; Piguillet, H.; Post, F.H. Spatial Navigation for Context-Aware Video Surveillance. IEEE Comput. Graph. Appl. 2010, 30, 20–31. [CrossRef] [PubMed] 用于上下文感知视频监控的空间导航。 IEEE计算 图形。 10. Milosavljevi´c, A.; Ranˇci´c, D.; Dimitrijevi´c, A.; Predi´c, B.; Mihajlovi´c, V. Integration of GIS and video surveillance. Int. J. Geogr. Inf. Sci. 2016, 30, 2089–2107. [CrossRef] GIS和视频监控的集成 11. Eugster, H.; Nebiker, S. UAV-based augmented monitoring-real-time georeferencing and integration of video imagery with virtual globes. Int. Arch. Photogramm. Remote Sens. Spat. Inf. Sci. 2008, 37, 1229–1236.基于UAV的增强型实时监控地理配准以及视频图像与虚拟地球仪的集成 12. Calavia, L.; Baladrón, C.; Aguiar, J.M.; Carro, B.; Sánchez-Esguevillas, A. A Semantic Autonomous Video Surveillance System for Dense Camera Networks in Smart Cities. 智慧城市中密集摄像机网络的语义自治视频监控系统Sensors 2012, 12, 10407–10429. [CrossRef] [PubMed] 13. Xie, Y.; Wang, M.; Liu, X.; Wu, Y. Integration of GIS and Moving Objects in Surveillance Video. ISPRS Int. J. Geo-Inf. 2017, 6, 94. [CrossRef]监控视频中GIS和移动对象的集成 14. Lewis, P.; Fotheringham, S.; Winstanley, A. Spatial video and GIS. Int. J. Geogr. Inf. Sci. 2011, 25, 697–716. [CrossRef]空间视频和GIS 15. Wang, M.; Liu, X.; Zhang, Y.; Wang, Z. Camera Coverage Estimation Based on Multistage Grid Subdivision. ISPRS Int. J. Geo-Inf. 2017, 6, 110. [CrossRef]基于多级网格细分的摄像机覆盖率估计 16. Yaagoubi, R.; Yarmani, M.; Kamel, A.; Khemiri, W. HybVOR: A Voronoi-Based 3D GIS Approach for Camera Surveillance Network Placement. ISPRS Int. J. Geo-Inf. 2015, 4, 754–782. [CrossRef]基于Voronoi的3D GIS摄像机监视网络放置方法。 17. Wu, C.; Zhu, Q.; Zhang, Y.; Du, Z.; Ye, X.; Qin, H.; Zhou, Y. A NoSQL–SQL Hybrid Organization and Management Approach for Real-Time Geospatial Data: A Case Study of Public Security Video Surveillance.实时地理空间数据的混合组织和管理方法:以公共安全视频监视为例。 ISPRS Int. J. Geo-Inf. 2017, 6, 21. [CrossRef] 18. Zhang, Z. A flexible new technique for camera calibration. IEEE Trans. Pattern Anal. Mach. Intell. 2000, 22, 1330–1334. [CrossRef]灵活的相机校准新技术 19. Pérez Muñoz, J.C.; Ortiz Alarcón, C.A.; Osorio, A.; Mejía, C.; Medina, R. Environmental applications of camera images calibrated by means of the Levenberg–Marquardt method. Comput. Geosci. 2013, 51, 74–82. [CrossRef] 通过Levenberg-Marquardt方法校准的相机图像在环境中的应用 20. Agarwal, S.; Furukawa, Y.; Snavely, N.; Simon, I.; Curless, B.; Seitz, S.M.; Szeliski, R. Building Rome in a day. Commun. ACM 2011, 54, 105. [CrossRef]在一天之内建造罗马 21. Nister, D.; Naroditsky, O.; Bergen, J. Visual odometry. In Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR 2004), Washington, DC, USA,视觉里程表。 在2004年IEEE计算机学会计算机视觉和模式识别会议上的论文 27 June–2 July 2004; Volume 1, pp. 652–659. ISPRS Int. J. Geo-Inf. 2017, 6, 211 18 of 18 22. Kundu, A.; Krishna, K.M.; Jawahar, C.V. Realtime multibody visual SLAM with a smoothly moving monocular camera. In Proceedings of the IEEE 2011 International Conference on Computer Vision, Barcelona, Spain, 6–13 November 2011; pp. 2080–2087.借助平滑移动的单眼摄像头实现实时多体视觉SLAM。 23. Wildes, R.P.; Hirvonen, D.J.; Hsu, S.C.; Kumar, R.; Lehman, W.B.; Matei, B.; Zhao, W.-Y. Video georegistration: Algorithm and quantitative evaluation. In Proceedings of the Eighth IEEE International Conference on Computer Vision (ICCV 2001), Vancouver, BC, Canada, 7–14 July 2001; Volume 2, pp. 343–350.视频地理注册:算法和定量评估 24. Eugster, H.; Nebiker, S. Real-time georegistration of video streams from mini or mirco UAS using digital 3D city models. In Proceedings of the 6th International Symposium on Mobile Mapping Technology,使用数字3D城市模型对来自微型或微型无人机的视频流进行实时配准。 São Paulo, Brazil, 21–24 July 2009. 25. Neumann, U.; You, S.; Hu, J.; Jiang, B.; Lee, J.W. Augmented virtual environments (AVE): Dynamic fusion of imagery and 3D models. In Proceedings of the IEEE Virtual Reality, Los Angeles, CA, USA, 22–26 March 2003; ons.org/licenses/by/4.0/). 增强型虚拟环境(AVE):图像和3D模型的动态融合 |

【本文地址】

今日新闻 |

推荐新闻 |

表示使得似然函数取得最小值时β的取值

表示使得似然函数取得最小值时β的取值