清华大学开源中文版ChatGLM |

您所在的位置:网站首页 › 电工基础知识汇总 › 清华大学开源中文版ChatGLM |

清华大学开源中文版ChatGLM

|

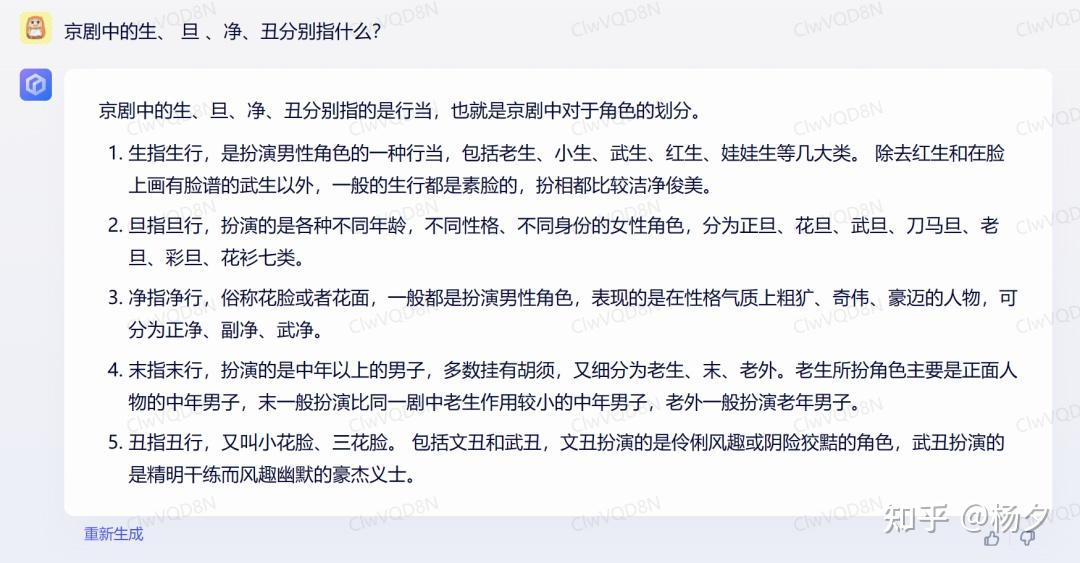

作者简介 作者:杨夕 推荐系统 百面百搭地址:https://github.com/km1994/RES-Interview-Notes NLP 百面百搭地址:https://github.com/km1994/NLP-Interview-Notes 个人笔记:https://github.com/km1994/nlp_paper_study  NLP && 推荐学习群【如果人数满了,加微信 blqkm601】  由清华技术成果转化的公司智谱 AI 宣布开源了 GLM 系列模型的新成员 —— 中英双语对话模型ChatGLM-6B,支持在单张消费级显卡上进行推理使用。这是继此前开源 GLM-130B 千亿基座模型之后,智谱 AI 再次推出大模型方向的研究成果。 此外,基于千亿基座的 ChatGLM 线上模型目前也在 chatglm.cn 进行邀请制内测,用户需要使用邀请码进行注册,也可以填写基本信息申请内测。 根据介绍,ChatGLM-6B 是一个开源的、支持中英双语问答的对话语言模型,并针对中文进行了优化。该模型基于 General Language Model (GLM) 架构,具有 62 亿参数。结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)。 ChatGLM-6B 使用了和 ChatGLM 相同的技术,针对中文问答和对话进行了优化。经过约 1T 标识符的中英双语训练,辅以监督微调、反馈自助、人类反馈强化学习等技术的加持,62 亿参数的 ChatGLM-6B 虽然规模不及千亿模型,但大大降低了推理成本,提升了效率,并且已经能生成相当符合人类偏好的回答。 ChatGLM-6B 具备以下特点: 充分的中英双语预训练:ChatGLM-6B 在 1:1 比例的中英语料上训练了 1T 的 token 量,兼具双语能力。优化的模型架构和大小:吸取 GLM-130B 训练经验,修正了二维 RoPE 位置编码实现,使用传统 FFN 结构。6B(62 亿)的参数大小,也使得研究者和个人开发者自己微调和部署 ChatGLM-6B 成为可能。较低的部署门槛:FP16 半精度下,ChatGLM-6B 需要至少 13 GB 的显存进行推理,结合模型量化技术,这一需求可以进一步降低到 10GB(INT8) 和 6GB(INT4),使得 ChatGLM-6B 可以部署在消费级显卡上。更长的序列长度:相比 GLM-10B(序列长度 1024),ChatGLM-6B 序列长度达 2048,支持更长对话和应用。人类意图对齐训练:使用了监督微调(Supervised Fine-Tuning)、反馈自助(Feedback Bootstrap)、人类反馈强化学习(Reinforcement Learning from Human Feedback)等方式,使模型初具理解人类指令意图的能力。输出格式为 markdown,方便展示。基于以上特点,ChatGLM-6B 在一定条件下具备较好的对话与问答能力。 硬件需求量化等级最低 GPU 显存FP16(无量化)13 GBINT810 GBINT46 GBChatGLM-6B可以实现的能力这是一个对话机器人,所以基本的问答系统都是支持的。官方提供了几个使用实例: 自我认知提纲写作文案写作邮件助手信息抽取角色扮演评论比较旅游向导使用方式环境安装使用 pip 安装依赖:pip install -r requirements.txt,其中 transformers 库版本推荐为 4.26.1,但理论上不低于 4.23.1 即可。 代码调用可以通过如下代码调用 ChatGLM-6B 模型来生成对话: # 导包 from transformers import AutoTokenizer, AutoModel # 加载模型 tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True) model = AutoModel.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True).half().cuda() # 测试 response, history = model.chat(tokenizer, "你好", history=[]) print(response) response, history = model.chat(tokenizer, "晚上睡不着应该怎么办", history=history) print(response) >>> 晚上睡不着可能会让人感到焦虑和不安。以下是一些可能有用的建议,帮助在晚上入睡: 1. 创建一个舒适的睡眠环境:确保房间安静、黑暗、凉爽和舒适。也可以试着使用放松的音乐或白噪音来降低压力和焦虑。 2. 建立睡前例行程序:在睡前半小时做一些放松的事情,如泡澡、阅读、听轻柔的音乐等,有助于放松身心,进入睡眠状态。 3. 避免在睡前吃大量食物或饮料:这些食物或饮料可能会导致胃部不适或刺激,从而影响睡眠。 4. 尝试规律的睡眠时间表:尽量在同一时间上床,以帮助身体适应一个固定的睡眠时间表,更容易入睡。 5. 减少咖啡因和酒精的摄入:咖啡因和酒精都可能影响睡眠,所以尽可能避免在睡前摄入这些物质。 6. 进行适量的身体活动:适度的身体活动可以帮助放松身心,但避免在睡前进行过于激烈的运动。 如果以上建议无法帮助入睡,建议咨询医生或专业人士,了解是否有其他潜在的健康问题,需要采取相应的治疗措施。chatGPT vs 百度 文心一言 vs ChatGLM-6B文学创作 提问:龟兔赛跑的结局是什么?如果要续写这个故事,可以有哪些角度? 「文心一言」的回答: ChatGPT 的回答: ChatGPT 的回答: ChatGLM-6B 的回答: ChatGLM-6B 的回答: 从结果可以看出,「文心一言」和 ChatGPT 和 ChatGLM-6B都进行了正确回答,不同之处在于「文心一言」对故事整体概述了一遍,解释了乌龟赢得比赛的原因。在故事的续写上,二者给出的角度也不分伯仲,而「文心一言」更是对每个续写角度都给出了相应的寓意解释。 整体而言,在这个问题中「文心一言」和 ChatGPT 和 ChatGLM-6B 不相上下,「文心一言」以更全面的回答略胜一筹。 中文理解 提问:京剧中的生、 旦 、净、丑分别指什么? 「文心一言」的回答: ChatGPT 的回答: ChatGPT 的回答: ChatGLM-6B 的回答: ChatGLM-6B 的回答: 百度称「文心一言」具备中文领域最先进的自然语言处理能力,从它对京剧生、 旦 、净、丑的理解来看,水平还不错,还多回答了一个题目中没问的“末”。ChatGPT 的回答乍看之下也挺好,但细看之后,净行居然要“跳高、走钢丝”? ChatGLM-6B 能够准确回答问题,并通过举例说明的方式,帮助用户理解每个角色的特点。 对于中国文化特有的词汇,相较于 ChatGPT,ChatGLM-6B 和「文心一言」在这方面要更准确一些。 附加题:编写代码 提问:请写一个使用逻辑回归模型判断用户更喜欢文心一言还是chatGPT的训练代码 「文心一言」的回答: ChatGPT 的回答: ChatGPT 的回答: ChatGLM-6B的回答: ChatGLM-6B的回答: 对于这个编码问题,我们邀请了专业程序员对二者生成的代码进行分析: 1. ChatGPT 准确生成了逻辑回归模型模版代码,解决的是目标问题。2. 「文心一言」虽然生成了代码,但是生成的是图深度优先搜索(Deep First Search)代码,并不是目标问题解法代码。 3. ChatGLM-6B 生成的代码直接语法都存在问题。 正如百度在发布会上所说,「文心一言」和 ChatGLM-6B 的代码能力还需加强,而 ChatGPT 以擅长编码“出圈”果然不无道理。 局限性由于ChatGLM-6B的小规模,其能力仍然有许多局限性。以下是我们目前发现的一些问题: 模型容量较小:6B的小容量,决定了其相对较弱的模型记忆和语言能力。在面对许多事实性知识任务时,ChatGLM-6B可能会生成不正确的信息;它也不擅长逻辑类问题(如数学、编程)的解答。产生有害说明或有偏见的内容:ChatGLM-6B只是一个初步与人类意图对齐的语言模型,可能会生成有害、有偏见的内容。(内容可能具有冒犯性,此处不展示)英文能力不足:ChatGLM-6B 训练时使用的指示/回答大部分都是中文的,仅有极小一部分英文内容。因此,如果输入英文指示,回复的质量远不如中文,甚至与中文指示下的内容矛盾,并且出现中英夹杂的情况。易被误导,对话能力较弱:ChatGLM-6B 对话能力还比较弱,而且 “自我认知” 存在问题,并很容易被误导并产生错误的言论。例如当前版本的模型在被误导的情况下,会在自我认知上发生偏差。不过 GLM 团队也坦言,整体来说 ChatGLM 距离国际顶尖大模型研究和产品(比如 OpenAI 的 ChatGPT 及下一代 GPT 模型)还存在一定的差距。该团队表示,将持续研发并开源更新版本的 ChatGLM 和相关模型。“欢迎大家下载 ChatGLM-6B,基于它进行研究和(非商用)应用开发。GLM 团队希望能和开源社区研究者和开发者一起,推动大模型研究和应用在中国的发展。” 参考ChatGLM-6B 清华系公司智谱AI开源ChatGLM-6B模型,千亿基座对话模型开启内测 智谱 AI 开源 ChatGLM-6B 中英对话模型,千亿基座ChatGLM内测中 清华大学开源中文版ChatGPT模型——ChatGLM-6B发布 文心一言 vs ChatGPT!相同 10 问,结果出乎意料 |

【本文地址】

今日新闻 |

推荐新闻 |