也谈ChatGPT(2) |

您所在的位置:网站首页 › 牧的词语接龙 › 也谈ChatGPT(2) |

也谈ChatGPT(2)

|

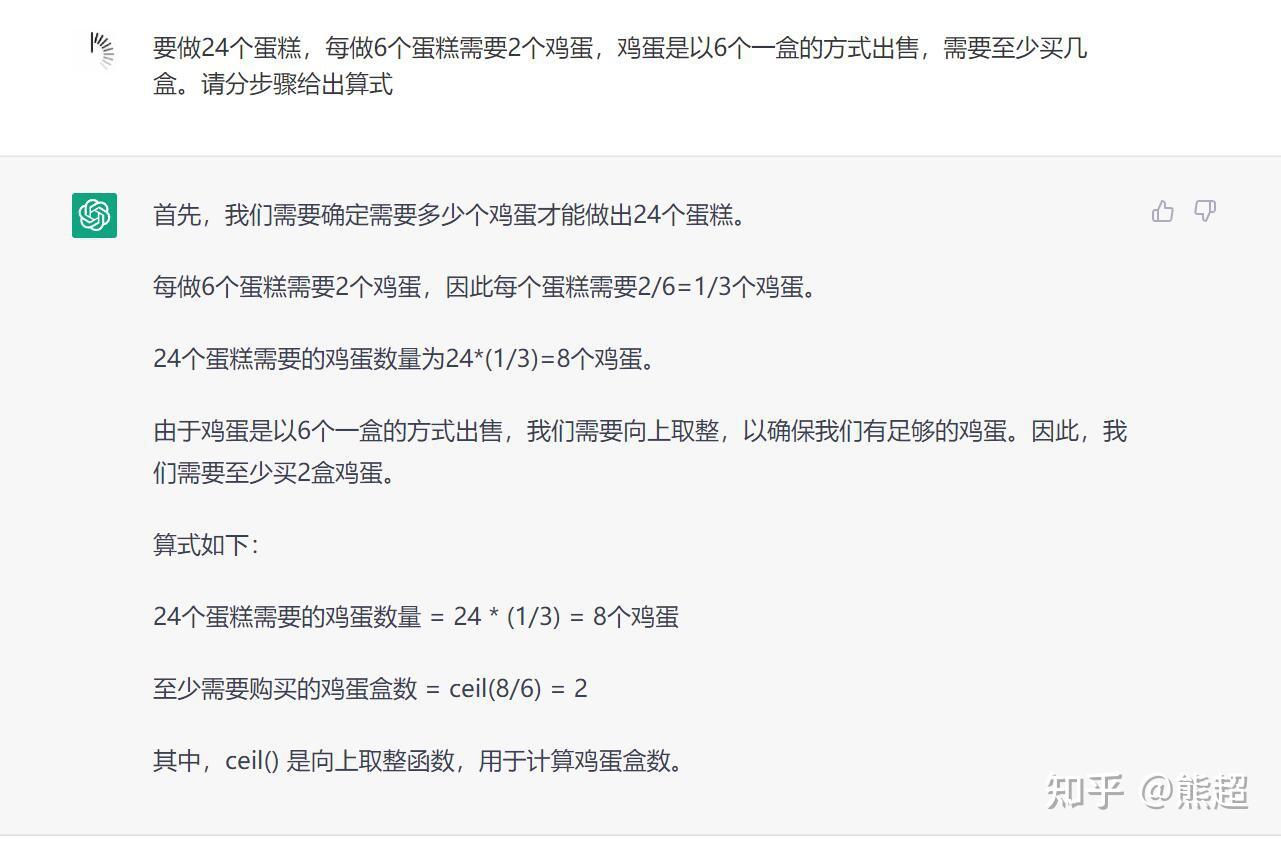

看了很多胡说八道的文章和评论,对ChatGPT的有些描述过于夸张和神话,尤其是说ChatGPT马上将涌现出人类一样的“智能”甚至“意识”,这是把“智能”和“意识”这两个概念都定义得过于简单了。现阶段的语言模型内部对文本序列的处理方式,本质上就是一个词语接龙而已,每一步就是根据上文采样下一个词,使得整个文本序列更“真实”地接近于其训练文本序列,本质上就是一个拟合函数,这里面根本就没有思考推理的机制。如果只看ChatGPT表现得好的对话内容,好象确实有那么一些推理能力,但那也只是因为模型学过的文本词语序列的数量极大,在接龙的经验上远超人类,其接龙能力已经强大到让你以为它是经过“思考推理"的。其实完全可以拿出很多反例来说明ChatGPT接龙时仍然经常胡说八道,给一个我今天刚试过的例子,一道小学三年级的数学竞赛题:  如果你已经内心非常相信ChatGPT,顺着读下来,这么通顺的回答很好啊,而这才是ChatGPT在严肃应用上最可怕的地方。上面的回答我让我儿子看了一下,他一眼就看出来算式计算错误在哪儿了,因为我儿子是真有算过,而ChatGPT还没这功能。 这个问题其实早就被发现,并且只要加上半句"step by step"的提示,ChatGPT就往往能给出正确的结果,比如后面再加上一句“请分步骤给出算式”:  这个"step by step"的提示对于模型解决问题的重要性及其背后的原理,已经有专门的论文在研究论述。但其实也不用搞得这么复杂,因为这就是词语接龙的特性啊,你给的提示词语里面有“要分步骤”,模型在玩词语接龙时就会给出更细致的列式步骤,而这样细一下就让模型绕过了它还不会基本连式计算的坑。加了这个分步骤的提示之后,模型虽然给出了正确答案,但在“真实”概率上就低于正常人类小朋友的会给出的解答了,哪个人类这么简单的一个问题还会用ceil函数啊。所以,别再随便说智能了,现阶段模型仍只是一个强大的词语接龙利器,谈不上有思想,象数学算式背后的推理过程那根本就不是ChatGPT模型学习的目标。ChatGPT可以通过强大的接龙能力,接续出个体人类未学习或了解过的知识,所以是一个强大的知识边界扩展工具,但现阶段还不能说它有思想。 确实,随模型参数规模的增大,大模型确实好象具有了一定的符号逻辑推理能力,但学界对于这种COT“思想链”的涌现机制也仍在研究之中,现有模型的“思想链”也只是对现象的定义,其链条能力水平也还远达不到人类的思想水平,更谈不上有意识。在语言模型也引入因果推断的机制之前,词语接龙的输出结果再怎么像专家,那也不能称是智能,离真正的通用智能还早着呢,现在不用过分地神话。 那些说几年内程序员就将会失业的,那也是天真地把程序员想简单了,程序员在ChatGPT、CodePilot等语言模型的助力之下是会更强大,但肯定不会被替代。现在AGI刚有一个良好的起步,千万不要再来一次印度大神骗Engineer.ai的笑话。我相信未来会有一天基于自然语言的AIGC编程会达到人类的工程化水平,但是仍然需要懂软件工程的人类来引导安排,你觉得作为未来创造出具备此种AI能力的工程师们会让自己失业吗? 作为人类,请对自己的大脑自信一点吧,只要你还保持着你左脑的思考判断,你就已经比现在只会词语接龙的ChatGPT强大了太多太多了,更何况你还有充满想像力的右脑!至于机器未来会否终有一天产生意识,很多伟大的人类大脑都还在研究思考这个问题,这问题超出了我现在的认识能力范围,我还在读《千脑智能》,有些启发,后续可能会分享。仅从工程的角度,我直觉上要想数字化表达出意识,其所需要的参数量至少也应该是千万亿级的,以现在的机器能力还远远做不到,就算能做到了那也比人类大脑的运算成本高太多了。 本系列第二篇就先这么多吧,下一篇就来谈下模型成本的问题。 总结还是那句话,别急: 版权声明 ©转载请注明出处原创不易,觉得有用的话,请多转发点赞支持 |

【本文地址】