深度学习笔记(五):学习率过大过小对于网络训练有何影响以及如何解决 |

您所在的位置:网站首页 › 温度过低时栅压为什么不能调的太高 › 深度学习笔记(五):学习率过大过小对于网络训练有何影响以及如何解决 |

深度学习笔记(五):学习率过大过小对于网络训练有何影响以及如何解决

|

文章目录

1.学习率的作用2.学习率太大有何影响3.学习率太小有何影响4.如何进行学习率设置5.学习率缓减机制

1.学习率的作用

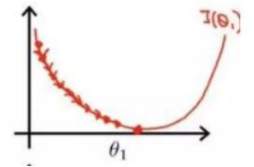

学习率 (learning rate),作为监督学习以及深度学习中重要的超参,它控制网络模型的学习进度,决定这网络能否成功或者需要多久成功找到全局最小值,从而得到全局最优解,也就是最优参数。换句话说学习率和stride(步长)性质差不多。 2.学习率太大有何影响首先我们要认识到学习率过大,自然第一反应就是学习的速度或者说忽略了某些阶段直接学到了下一个阶段的东西,这对于计算机来说是不可取的,特别是用于神经网络之中。这就好比在网络模型中我们所需要的最佳的值是50,如果我们学习率正好设置的是50,初始值为0,那么我们可以一步到位,若是设置的是10,多走几步依然可到,但是如果设置的是100,那我们就会直接跳过了50,也就是说忽略了最佳的结果。 那么学习率设置太大会造成网络不能收敛,在最优值附近徘徊,也就是说直接跳过最低的地方跳到对称轴另一边,从而忽视了找到最优值的位置。如下图

如果学习率设置太小,网络收敛非常缓慢,会增大找到最优值的时间,也就是说从山坡上像蜗牛一样慢慢地爬下去。虽然设置非常小的学习率是可以到达,但是这很可能会进入局部极值点就收敛,没有真正找到的最优解,换句话说就是它步长太小,跨不出这个坑。  4.如何进行学习率设置

4.如何进行学习率设置

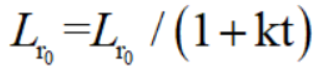

在训练过程中,一般根据训练轮数设置动态变化的学习率。 刚开始训练时:学习率以 0.01 ~ 0.001 为宜。 一定轮数过后:逐渐减缓。 接近训练结束:学习速率的衰减应该在100倍以上。 如果是 迁移学习 ,由于模型已在原始数据上收敛,此时应设置较小学习率 (≤0.0001) 在新数据上进行微调 。 5.学习率缓减机制 方法1.每N轮学习率减半(学习率按训练轮数增长指数差值递减): 方法2.最常用的是指数衰减,也是最为有效的。tensorflow中的表达式为: decayed_lr =lr0*(decay_rate^(global_steps/decay_steps) 参数解释: decayed_lr:衰减后的学习率,也就是当前训练不使用的真实学习率 lr0: 初始学习率 decay_rate: 衰减率,每次衰减的比例 global_steps:当前训练步数 decay_steps:衰减步数,每隔多少步衰减一次。

方法2.最常用的是指数衰减,也是最为有效的。tensorflow中的表达式为: decayed_lr =lr0*(decay_rate^(global_steps/decay_steps) 参数解释: decayed_lr:衰减后的学习率,也就是当前训练不使用的真实学习率 lr0: 初始学习率 decay_rate: 衰减率,每次衰减的比例 global_steps:当前训练步数 decay_steps:衰减步数,每隔多少步衰减一次。

方法二中tensorflow对应API: global_step = tf.Variable(0) lr = tf.train.exponential_decay( lr0, global_step, decay_steps=lr_step, decay_rate=lr_decay, staircase=True)staircase=True 参数是说 global_steps/decay_steps 取整更新,也就是能做到每隔decay_steps学习率更新一次。 方法3.通过引入BN层来解决,由于BN层(也叫归一化层)它可以防止网络中间层在训练过程中国,数据分别发生改变,它和卷积、池化都属于网络层的一种。一般是在网络每一层输入的时候插入一个BN层(归一化为均值为0,方差为1),然后在进入下一层。有了它现在我们可以采用初始很大的学习率,然后学习率的衰减速度也很大,因为BN算法收敛很快。当然这个算法即使你选择了较小的学习率,也比以前的收敛速度快,因为它具有快速训练收敛的特性; |

【本文地址】

今日新闻 |

推荐新闻 |