线性回归的简单介绍 |

您所在的位置:网站首页 › 残差平方和计算公式高中 › 线性回归的简单介绍 |

线性回归的简单介绍

|

一、背景

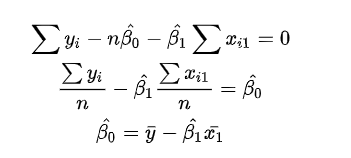

简单线性回归(Simple linear regression)也称为一元线性回归,是分析一个自变量(x)与因变量(y)之间线性关系的方法,它的目的是拟合出一个线性函数或公式来描述x与y之间的关系。 我们以最简单的一元线性回归回归方程来解释: y i = β 0 + β 1 × x i + e i y_i = \beta_0 + \beta_1 \times x_i + e_i yi=β0+β1×xi+ei 其中, y i y_i yi 为因变量, x i x_i xi 为 自变量, β 0 \beta_0 β0 为截距, β 1 \beta_1 β1 为斜率, e i e_i ei 为残差。 线性回归拟合的实质:残差平方和(Residual Sum of Squares, RSS)收敛到最小值的过程。一般,通过最小二乘法,获取回归方承担的系数。 二、线性回归原理之最小二乘法最小二乘法的主要思想是通过确定未知参数(通常是一个参数矩阵),来使得真实值和预测值的误差(也称残差)平方和最小,其计算公式为 R S S = ∑ ( y i − y i ^ ) RSS = \sum(y_i - \hat{y_i}) RSS=∑(yi−yi^),其中 y i y_i yi 是真实值, y i ^ \hat{y_i} yi^是对应的预测值。 我们仍以最简单的回归方程: y i = β 0 + β 1 × x i y_i=\beta_0+\beta_1 \times x_i yi=β0+β1×xi 为例。 根据最小二乘法: m i n ∑ ( y i − y i ^ ) 2 = m i n ∑ e i 2 = m i n ∑ ( y i − β 0 − β i x i ) = m i n F min \sum (y_i - \hat{y_i})^2 = min \sum e_i^2 = min\sum(y_i - \beta_0 - \beta_i x_i) = min \ F min∑(yi−yi^)2=min∑ei2=min∑(yi−β0−βixi)=min F 为了获得 β 0 \beta_0 β0 和 β 1 \beta_1 β1的最佳值,我们对其进行求偏导: ∂ F ∂ β 0 ^ = ∑ i = 1 n ( y i − β 0 ^ − β 1 ^ x i ) = 0 ∂ F ∂ β 1 ^ = ∑ i = 1 n x i ( y i − β 0 ^ − β 1 ^ x i ) = 0 \frac{\partial F}{\partial \hat{\beta_0}} = \sum_{i=1}^{n}(y_i - \hat{\beta_0} - \hat{\beta_1}x_i) = 0 \\ \frac{\partial F}{\partial \hat{\beta_1}} = \sum_{i=1}^{n}x_i(y_i - \hat{\beta_0} - \hat{\beta_1}x_i) = 0 ∂β0^∂F=i=1∑n(yi−β0^−β1^xi)=0∂β1^∂F=i=1∑nxi(yi−β0^−β1^xi)=0 分别求

β

0

^

\hat{ \beta_0}

β0^: 基于最小二乘法获取的回归方程,最重要的是基于残差的平方和的最小值获取的,或者说是其损失函数。 在这里,我没有对其做进一步的讨论(其实残差最重要的是判定线性你和的优良性)。 本次仅仅介绍和残差有关的几个概念:残差平方和(Residuals sum of squares, RSS),均方误差(Mean squared error, MSE),均方根误差(Root mean squared error, RMSE),残差的标准误差(Residual standard error, RSE)。 # 建立模型 # load data mydata |

【本文地址】

求

β

1

^

\hat{\beta_1}

β1^:

求

β

1

^

\hat{\beta_1}

β1^: