【机器学习笔记】最小二乘法&最小平方损失函数 |

您所在的位置:网站首页 › 残差变异常用函数表达式 › 【机器学习笔记】最小二乘法&最小平方损失函数 |

【机器学习笔记】最小二乘法&最小平方损失函数

|

最小二乘法(Least Squares Method)

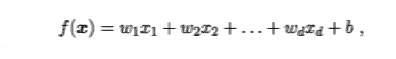

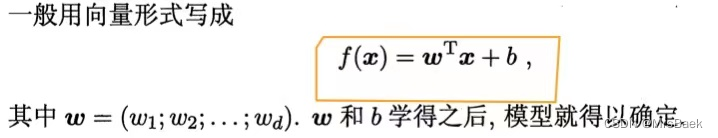

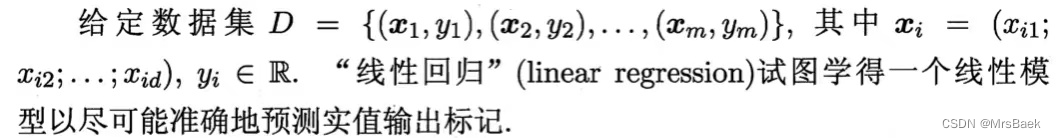

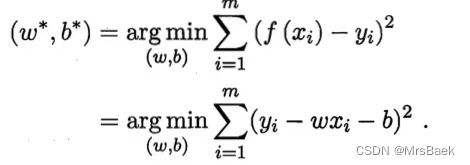

这是一种常用的参数估计方法,用于拟合数据和求解线性回归模型的参数。它通过最小化平方损失函数来找到最佳的模型参数。 在最小二乘法中,假设我们有一组输入变量 X 和对应的输出变量 Y,我们希望找到一个线性模型来描述它们之间的关系。线性模型可以表示为: 线性回归的基本形式

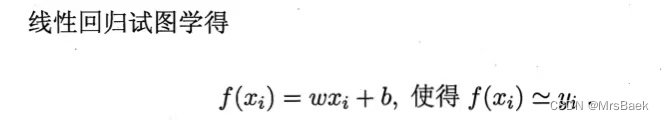

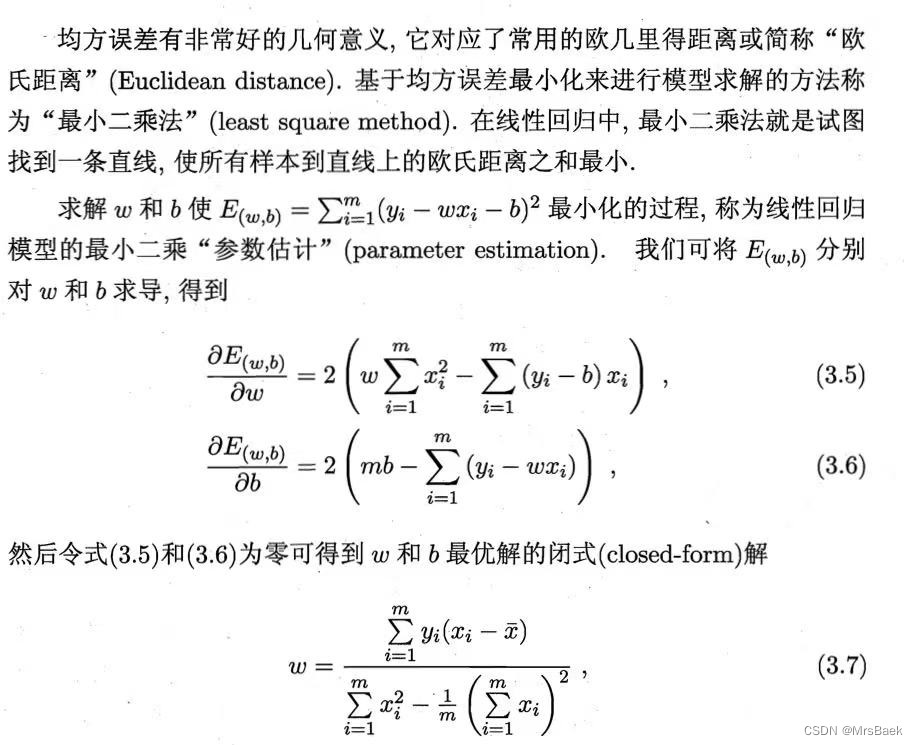

最小二乘法的目标是找到最佳的参数估计值 β,使得模型预测值 Y_hat 和真实观测值 Y 的差异最小化。这可以通过最小化平方损失函数来实现: L(β) = Σ(Y - Y_hat)² 其中,Y_hat 是模型的预测值,Y 是真实观测值。 为了求解最小二乘法,我们需要对平方损失函数进行最小化。这可以通过对损失函数关于参数 β 的偏导数为零的方程组进行求解,得到最佳的参数估计值。 最小二乘法在线性回归模型中广泛应用,通过拟合数据和求解参数,可以用来预测和解释变量之间的关系。它提供了一种直观和可解释的方法来估计模型参数,并且在一些假设条件下具有良好的统计性质。 线性回归

试图让均方误差最小化

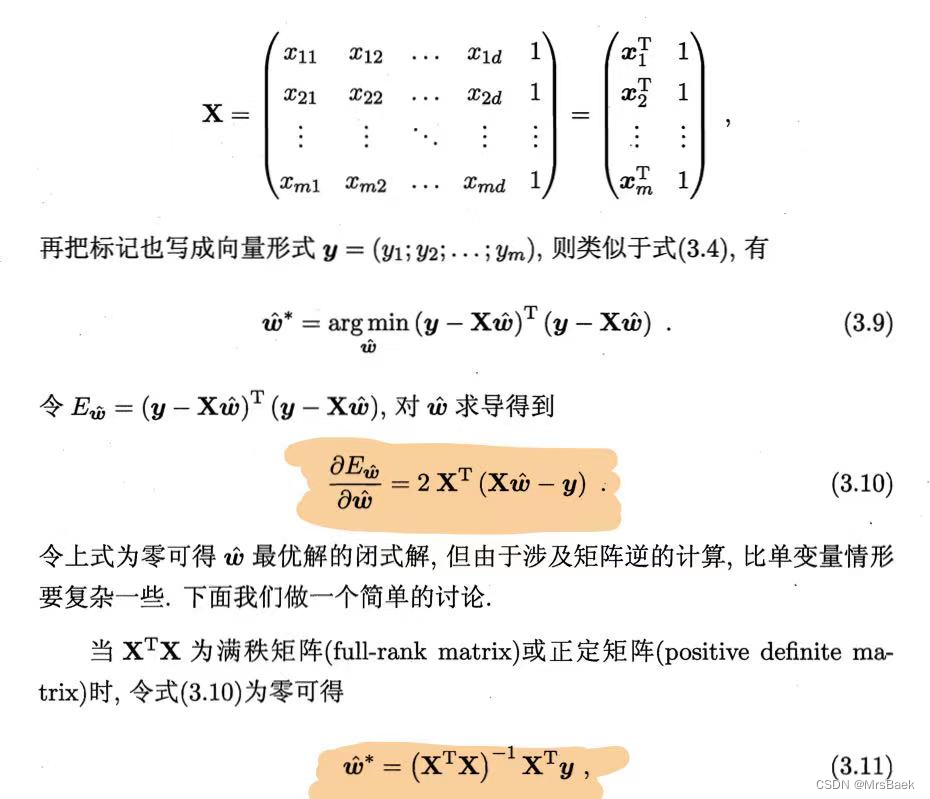

多元线性回归矩阵 线性回归模型为:

简写为:

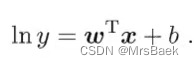

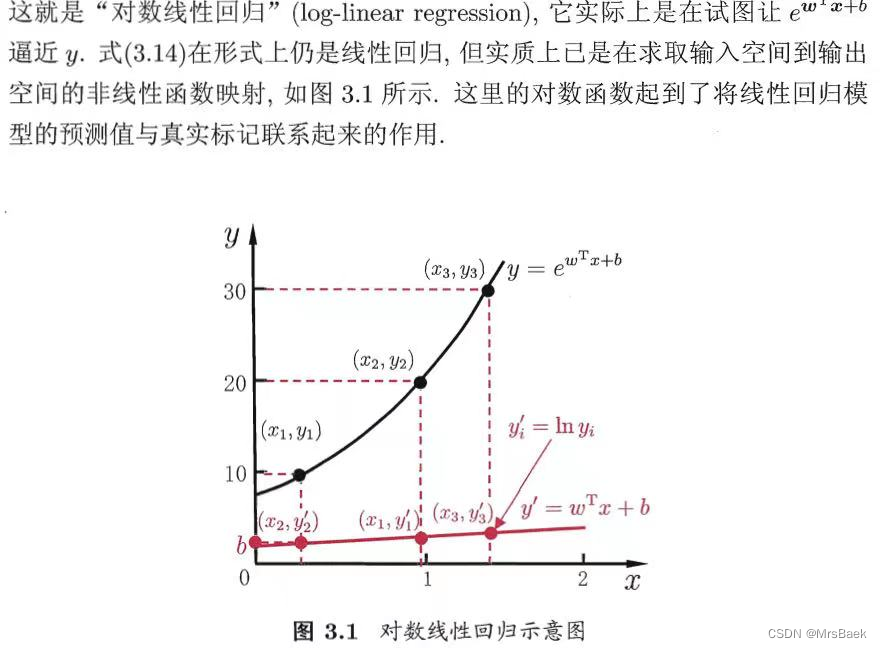

对数线性回归

对最小二乘法进行举例 假设我们有一组输入变量 X 和对应的输出变量 Y,我们希望拟合一个线性模型来描述它们之间的关系。 % 输入变量 X 和输出变量 Y X = [1, 2, 3, 4, 5]'; Y = [2, 4, 6, 8, 10]'; % 构建设计矩阵 X_design = [ones(size(X)), X]; % 使用最小二乘法求解参数估计值 beta_hat = (X_design' * X_design) \ (X_design' * Y); % 输出参数估计结果 beta0 = beta_hat(1); beta1 = beta_hat(2); % 打印参数估计值 fprintf('估计的参数值:beta0 = %.2f, beta1 = %.2f\n', beta0, beta1); % 绘制拟合曲线 Y_hat = X_design * beta_hat; plot(X, Y, 'ro', X, Y_hat, 'b-'); legend('观测值', '拟合曲线'); xlabel('X'); ylabel('Y');

在上述示例中,我们首先定义了输入变量 X 和输出变量 Y。然后,构建了设计矩阵 X_design,其中包括了常数项和输入变量。接下来,使用最小二乘法求解参数估计值 beta_hat,通过求解线性方程组 (X_design' * X_design) * beta_hat = X_design' * Y。最后,我们输出了估计的参数值,并绘制了观测值和拟合曲线的图形。 通过最小二乘法,我们可以得到线性回归模型的参数估计值,从而对输入变量和输出变量之间的关系进行拟合和预测。 最小平方损失函数(Least Squares Loss Function 这是一种常用的损失函数,用于衡量模型预测值与真实观测值之间的差异。它在许多机器学习算法中被广泛使用,尤其是在线性回归模型中。 最小平方损失函数定义为预测值与真实观测值之间差异的平方和。对于单个样本,最小平方损失函数可以表示为: L(y, y_hat) = (y - y_hat)^2 其中,y 是真实观测值,y_hat 是模型的预测值。 对于整个数据集,最小平方损失函数可以表示为: L(Y, Y_hat) = Σ(y_i - y_hat_i)^2 其中,Y 是真实观测值的向量,Y_hat 是模型的预测值的向量。 最小平方损失函数的目标是最小化预测值与真实观测值之间的差异。通过最小化损失函数,我们可以找到最佳的模型参数,使得模型能够更准确地拟合训练数据。 最小平方损失函数在不同的机器学习算法中有不同的形式。以下是一些常见的最小平方损失函数: 1. 线性回归损失函数(Linear Regression Loss Function):对于线性回归问题,最小平方损失函数是最常见的形式。它定义为预测值与真实观测值之间差异的平方和。 L(y, y_hat) = (y - y_hat)^2 其中,y 是真实观测值,y_hat 是模型的预测值。 2. 岭回归损失函数(Ridge Regression Loss Function):岭回归是一种用于处理具有多重共线性问题的线性回归方法。其损失函数是最小平方损失函数与正则化项的加权和。 L(y, y_hat) = (y - y_hat)^2 + λ||β||² 其中,y 是真实观测值,y_hat 是模型的预测值,β 是模型的参数,λ 是正则化参数。 3. LASSO回归损失函数(LASSO Regression Loss Function):LASSO回归是一种用于特征选择和稀疏性建模的线性回归方法。其损失函数是最小平方损失函数与L1正则化项的加权和。 L(y, y_hat) = (y - y_hat)^2 + λ||β||₁ 其中,y 是真实观测值,y_hat 是模型的预测值,β 是模型的参数,λ 是正则化参数。 对比最小平方损失函数和最小二乘法是紧密相关的概念,但它们的角色和应用略有不同。 最小平方损失函数(Least Squares Loss Function)是一种用于衡量模型预测值与真实观测值之间差异的损失函数。它通过计算预测值与真实观测值之间的差的平方和来衡量模型的拟合程度。最小平方损失函数广泛应用于许多机器学习任务,尤其是线性回归模型中。 最小二乘法(Least Squares Method)则是一种基于最小平方损失函数的参数估计方法。它通过最小化最小平方损失函数来估计模型的参数。最小二乘法的目标是找到使得最小平方损失函数最小化的参数值,从而使得模型能够最优地拟合训练数据。 最小二乘法通常应用于线性回归模型中,其中我们希望通过线性模型来拟合输入变量和输出变量之间的关系。通过最小二乘法,我们可以求解出使得最小平方损失函数最小化的模型参数,从而得到一个最优的线性回归模型。 因此,最小平方损失函数是衡量模型拟合程度的指标,而最小二乘法是一种使用最小平方损失函数进行参数估计的方法。它们在线性回归中是密切相关的,并且常常一起使用。 |

【本文地址】