【基础知识 |

您所在的位置:网站首页 › 正交矩阵一定是可逆矩阵吗为什么 › 【基础知识 |

【基础知识

|

最近在看PRML,总是出现雅可比行列式。我们知到,雅可比行列式体现了变量的“体微元”变换的放缩比例。 虽然我对多元微分学、高等代数认识并不深刻,但是经常遇到雅可比矩阵、行列式,因此,这里对相关结论进行总结,以增强直观上的一些认识,顺便练习计算能力。 1. 雅可比矩阵与坐标变换我们在进行多维的欧氏空间中,对基底进行变换后,空间中相应点的坐标也会发生变化。为了描述二元空间的微元面积关系,还记得大一的高等数学教科书有如下的图,以及计算性的证明。(毕竟我只是个学计算机的,没有数学分析大佬的水平)。 例如,在xy平面坐标系上,如下左图有点 ( x 0 , y 0 ) (x_0,y_0) (x0,y0),以及两条曲线 r 1 r_1 r1, r 2 r_2 r2。我们考察点和曲线上的微元构成的面微元如何表示。如果我们关心某一区域的面积求解,那么这个不规则的面微元的表达,或者是曲线的表达式,非常重要。 如果从面微元的角度出发,我们希望找到某种变换

u

=

f

(

x

,

y

)

,

v

=

g

(

x

,

y

)

u=f(x,y),v=g(x,y)

u=f(x,y),v=g(x,y),使得在uv坐标系下,我们能方便的计算微元面积。显然,如果在uv坐标系下,该曲线围成的区域形成矩形则最好,可以直接计算面微元:

d

S

u

v

=

d

u

d

v

dS_{uv}=dudv

dSuv=dudv 那么假如我们确实找到了可微函数

f

、

g

f、g

f、g满足上述条件,那么我们从计算的角度(不是从严谨的分析角度)探讨微元

d

S

x

y

dS_{xy}

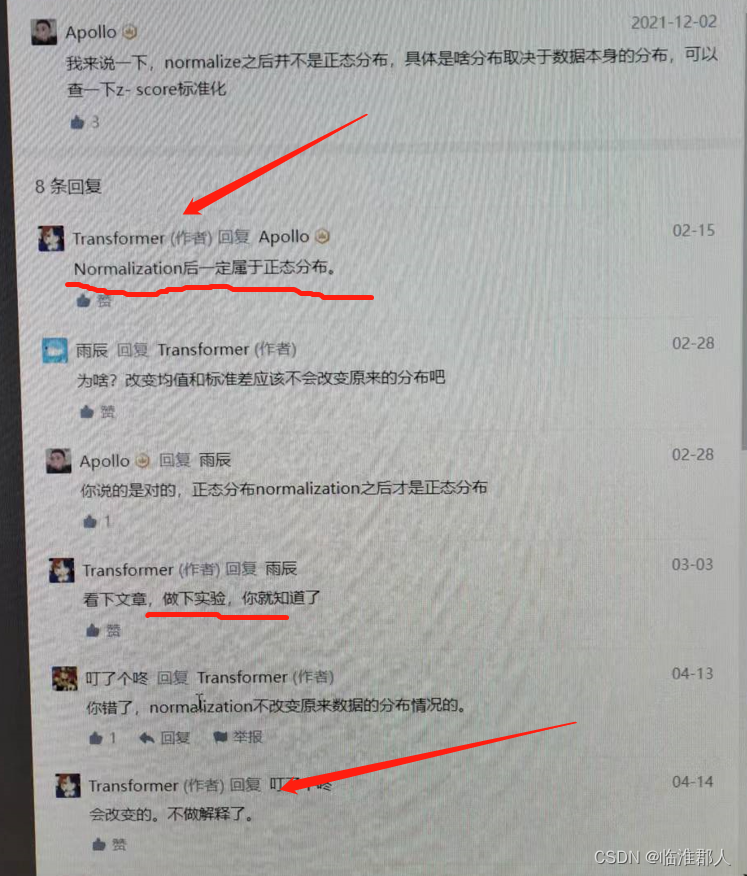

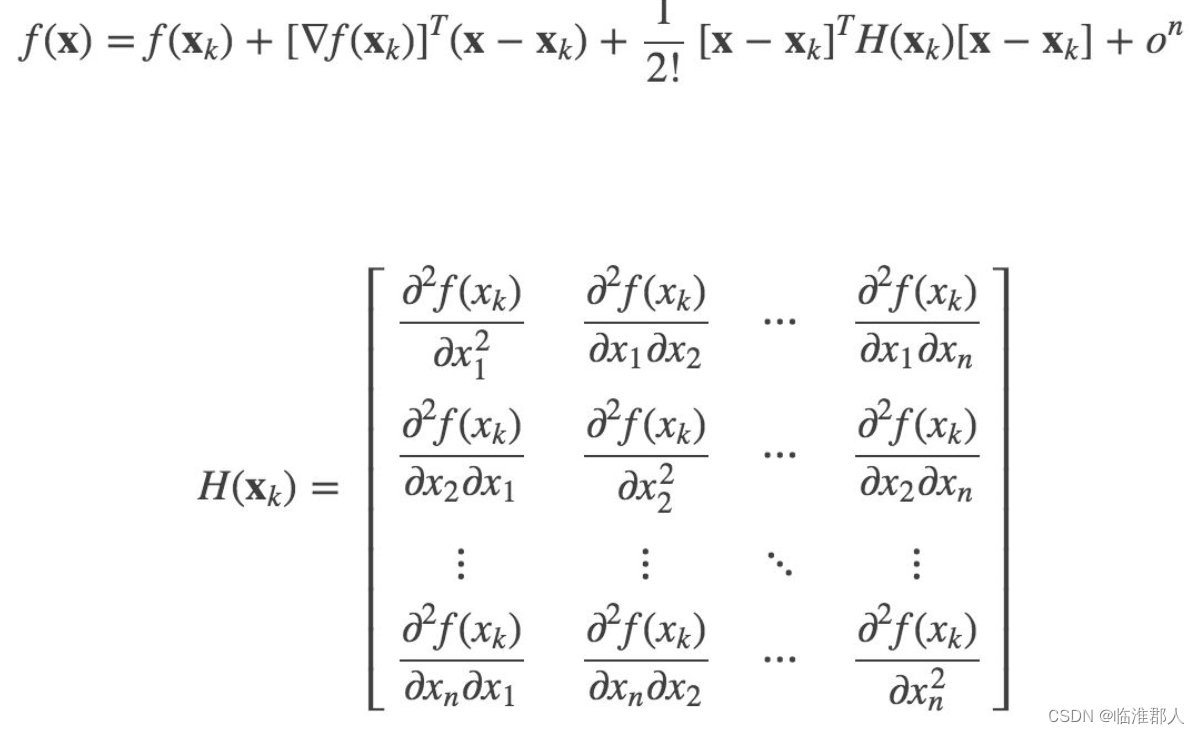

dSxy的表达。 首先我们回顾一下多元泰勒公式,其实我们只需要记得形式和二项式定理类似就行,如下式子展开两阶,这里实际上我们只需要用到一阶就行,即考虑线性的近似。 当然,这是二阶的情况,如果是n元变换的话,其实也类似,这里就不赘述了。 在线性近似的条件下,我们计算原本在xy平面上复杂曲线围成的面微元。复杂曲线的面微元计算如下所示。 回过头来,为什么我们只需要讨论一阶展开,就足以表达面积积分呢?这点就不在我们讨论的范围内了。但是我们不禁就会有疑问,即 J ( x , y ) J(x,y) J(x,y)和 J ( u , v ) J(u,v) J(u,v)有没有什么关系?我们如下将继续深入这一个小问题。 2.雅可比行列式可逆性证明我们知道,在一元变量中,我们有: d y d x d x d y = 1 {dy \over dx} {dx \over dy} =1 dxdydydx=1 但是在多元的变换过程中,我们其实也有类似的好结论,即关于雅可比行列式的结论。不过条件是我们不能把未知数变换少了(即两个空间的维度必须相同),因为这相当于把维度降低了,变量单位微元组成的面积求为0了(我们知到,行列式的含义其实是“体积”)。如下我们从计算的角度证明结论,而不是从严格数学证明的角度,毕竟我只是个学计算机的。 首先我们证明二元的情况,再证明多元的情况,如下所示两个证明。 大四下学期看了不少论文,感觉一些文章的理论部分不太严谨,或者说都是从应用的角度上进行讨论,而不仔细讨论条件——大家习惯性的基于方便的计算法则进行计算。事实上,很多理想的条件,不太能达到,或者说存在理论与实践上的巨大误差。其它就是网上资料的质量层次不齐,大部分只会复制粘贴,甚至有时候还会出现如此言语:认为BN能够改变分布的类型,把各种分布均变为正态分布。。。我觉得但凡上过大学,也不至于有这样的表述。 此外,还有不少论文的符号表达不明白,变量使用混乱,使得我们理解论文非常困难。更有一些论文,甚至公式是错误的。这从层面说明,很多时候利用神经网络做拟合或者完成任务,并不需要很精细的推到,只需要某种“相关性”就行。 因此不仅感慨,其实我也就只配做做应用或者粗浅的理论之类的东西,真的。 其一,是自己的数学水平摆在那里,没办法研究太深的内容。不过好在深度学习让我们摆脱于繁复的计算公式,而只需要借助于经验和工程实践来研究。其二,是也没必要特别深入理论,很多内容是启发性的,我们只需要在某一高度上能自圆其说就行。例如从最朴素的MMGAN,到之后的WGAN种种,对GAN的优化目标进行详细的讨论。但说到底,有的工作能够自圆其说,但是深究下去“这么做为什么work?我能否推广这些方法?”,我觉得真的存疑。例如很多人跟风说WGAN的优化目标Wasserstein距离,如何让人拍案叫绝,但是实际上“它通过改变了什么更为根本的东西使得WGAN比以各种散度为优化目标的模型好呢?”,依旧是个问题。 |

【本文地址】

今日新闻 |

推荐新闻 |

我们可以知道,在xy平面某点

(

x

0

,

y

0

)

(x_0,y_0)

(x0,y0)附近的微小变化,将对相应的uv平面

(

u

0

,

v

0

)

(u_0,v_0)

(u0,v0),造成如下的微小变化:

[

Δ

u

Δ

v

]

=

[

∂

f

∂

x

∂

f

∂

y

∂

g

∂

x

∂

g

∂

y

]

[

Δ

x

Δ

y

]

\begin{bmatrix} \Delta u \\ \Delta v \end{bmatrix}=\begin{bmatrix} {\partial f \over \partial x} & {\partial f \over \partial y} \\ {\partial g \over \partial x} & {\partial g \over \partial y} \end{bmatrix} \begin{bmatrix} \Delta x \\ \Delta y \end{bmatrix}

[ΔuΔv]=[∂x∂f∂x∂g∂y∂f∂y∂g][ΔxΔy] 其中,我们称矩阵

[

∂

f

∂

x

∂

f

∂

y

∂

g

∂

x

∂

g

∂

y

]

\begin{bmatrix} {\partial f \over \partial x} & {\partial f \over \partial y} \\ {\partial g \over \partial x} & {\partial g \over \partial y} \end{bmatrix}

[∂x∂f∂x∂g∂y∂f∂y∂g] 为雅可比矩阵,我们可以简单的记作

J

(

x

,

y

)

J(x,y)

J(x,y),或者更详细的记作

∂

(

u

,

v

)

∂

(

x

,

y

)

\partial(u,v) \over \partial(x,y)

∂(x,y)∂(u,v)。

我们可以知道,在xy平面某点

(

x

0

,

y

0

)

(x_0,y_0)

(x0,y0)附近的微小变化,将对相应的uv平面

(

u

0

,

v

0

)

(u_0,v_0)

(u0,v0),造成如下的微小变化:

[

Δ

u

Δ

v

]

=

[

∂

f

∂

x

∂

f

∂

y

∂

g

∂

x

∂

g

∂

y

]

[

Δ

x

Δ

y

]

\begin{bmatrix} \Delta u \\ \Delta v \end{bmatrix}=\begin{bmatrix} {\partial f \over \partial x} & {\partial f \over \partial y} \\ {\partial g \over \partial x} & {\partial g \over \partial y} \end{bmatrix} \begin{bmatrix} \Delta x \\ \Delta y \end{bmatrix}

[ΔuΔv]=[∂x∂f∂x∂g∂y∂f∂y∂g][ΔxΔy] 其中,我们称矩阵

[

∂

f

∂

x

∂

f

∂

y

∂

g

∂

x

∂

g

∂

y

]

\begin{bmatrix} {\partial f \over \partial x} & {\partial f \over \partial y} \\ {\partial g \over \partial x} & {\partial g \over \partial y} \end{bmatrix}

[∂x∂f∂x∂g∂y∂f∂y∂g] 为雅可比矩阵,我们可以简单的记作

J

(

x

,

y

)

J(x,y)

J(x,y),或者更详细的记作

∂

(

u

,

v

)

∂

(

x

,

y

)

\partial(u,v) \over \partial(x,y)

∂(x,y)∂(u,v)。 可见,经过坐标变换后,xy平面上的面微元和uv平面上的面微元,不是相等的,而是由一个雅可比矩阵的行列式,表达其放缩关系。

可见,经过坐标变换后,xy平面上的面微元和uv平面上的面微元,不是相等的,而是由一个雅可比矩阵的行列式,表达其放缩关系。