机器学习需要的最小数据量是多少? |

您所在的位置:网站首页 › 最小的1位数是几 › 机器学习需要的最小数据量是多少? |

机器学习需要的最小数据量是多少?

|

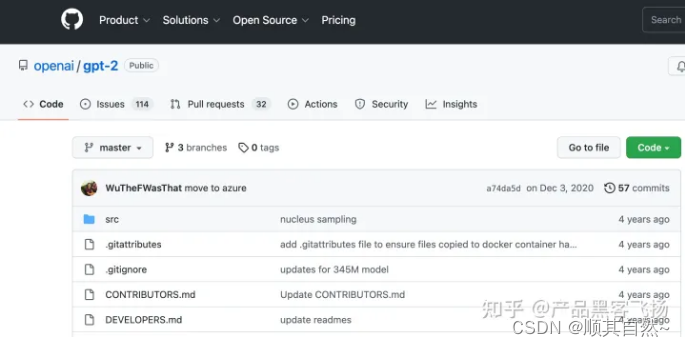

数据不够,假设来凑。一个数据点甚至没有数据都能搞。 参数不多的参数化统计模型(比如线性模型或者是基于被建模对线机理而定制的参数化模型)或者是常见的非参数化贝叶斯模型(例如高斯过程)都是不错的选择。 机器学习的常见搞法都是基于数据对于某一族的模型进行选择。适当的模型假设和归纳偏置可以极大地减少估计模型参数所需要的数据量。当数据量过少的时候,一个常见的办法就是对于模型加入我们对于要建模问题的先验知识。比如在贝叶斯模型里面使用适当的先验分布,在数据少的时候能有效地提升模型效果,而在数据逐渐增大之后,不同先验的区别往往会逐渐趋近直至几乎没有区别,最后完全由数据来决定模型的推断。对于特定的问题,参数化的估计也可以有不错的效果,比如对于计数问题(例如预测客服中心一天接到的电话次数),在数据很小的情况下使用泊松回归大概率是比GBDT或者MLP或者更加复杂的神经网络结构要有更好的预测结果。 现在一说到机器学习就是深度学习大数据大模型。但是在许多传统行业或者是某些特定的场景下,无论是算力还是数据都被极大地限制,但这并不代表统计机器学习方法就没有用武之地了。恰恰相反,这些小数据场景在这个大数据时代往往催生了不少有意思的方法和应用。 参考:机器学习需要的最小数据量是多少? - 知乎 1.需要“具体问题具体分析” 机器学习需要的最小数据量是不确定的。取决于许多因素,如:问题的复杂性、数据的多样性、特征的数量和质量、模型的类型和复杂度等。 一般来说,数据量越大,模型的性能和泛化能力会更好。但是,如果数据量太小,模型可能会过拟合,无法准确地预测新数据。 最低限度,机器学习需要的数据量应该是几千到几万个样本,具体数量取决于具体的问题和应用场景。对于一些复杂的应用场景,例如自然语言处理或计算机视觉,可能需要更多的数据来训练模型。 2.展开几个“具体问题,具体分析”的例子 2.1-GPT2模型 GPT-2 模型的最小训练数据量取决于所使用的预训练模型的大小和训练任务的难度。GPT-2 是一个非常大的语言模型,需要大量的数据进行训练。根据 OpenAI 的官方文档,GPT-2 模型的预训练数据集包括了超过800万篇文章,总计13.5亿个单词。 如果要对 GPT-2 进行微调(fine-tuning),需要在预训练数据集的基础上再增加少量的特定领域数据进行训练,通常需要至少数千条甚至更多的数据才能获得较好的效果。 因此,要训练一个较为稳定和有效的 GPT-2 模型,需要非常大的数据集支持。 举这个例子是因为GPT-2模型已在GitHub上以开源方式发布,可以通过以下链接进行查看和下载:https://github.com/openai/gpt-2:

2.2-谷歌李菲菲教授的成名战 李菲菲教授最大的贡献之一是在2012年的ImageNet挑战赛上,使用CNN模型成功将图像分类误差率降低到了15.3%,远远超过了当时其他所有方法。这一成果标志着深度学习在计算机视觉领域的开端,并为后来的深度学习研究打下了坚实的基础。 当年获胜的秘诀:使用了超过100万张图片来训练模型。其中训练集包含120万张图片,验证集包含5万张图片,测试集包含15万张图片。这个模型被称为AlexNet,其表现优秀,使得深度学习在计算机视觉领域获得了广泛应用和认可。 机器学习需要的最小数据量取决于所使用的模型类型、数据的特征和数据的复杂性等因素。通常情况下,数据量越大,训练出的模型效果越好,因为大量的数据可以提供更多的信息和更全面的表示。但是,在某些情况下,即使只有很少的数据,也可以构建出有用的模型。 具体来说,以下是一些常见的机器学习任务和其所需的最小数据量估计: 二分类或多分类问题:通常需要至少几百个样本,但最好有数千个样本。回归问题:需要的数据量通常与特征数量有关,一般需要至少几百个样本。图像分类问题:需要的数据量通常要比其他任务更多,一般需要数千到数十万个样本。自然语言处理问题:需要的数据量也通常要比其他任务更多,一般需要数千到数百万个样本。总的来说,虽然没有一种通用的最小数据量要求,但是在实际应用中,为了获得较好的模型性能,建议使用尽可能多的数据。 参考:https://www.zhihu.com/question/586916966/answer/2920519757 这个问题没有一个确定的答案,因为机器学习需要的最小数据量取决于许多因素,例如: 问题类型:不同类型的问题需要不同量级的数据来获得良好的性能。例如,一个简单的二元分类问题可能只需要几百个样本,而一个复杂的图像分类问题可能需要数万个样本。特征数量:如果特征数量很少,那么需要的数据量也相对较少。然而,如果特征数量很大,那么需要的数据量也会相应地增加。数据质量:如果数据质量很好,那么需要的数据量也会相对较少。相反,如果数据质量很差,那么可能需要更多的数据才能得到准确的模型。模型类型:不同类型的模型需要不同数量级的数据来进行训练。例如,深度神经网络通常需要大量的数据来训练,而决策树等简单模型可能只需要相对较少的数据。总体来说,一般认为,机器学习需要的最小数据量应该在几百到几千之间,但具体取决于上述因素。在实践中,通常需要进行一些试验来确定需要多少数据才能得到令人满意的结果。 参考:https://www.zhihu.com/question/586916966/answer/2916748569 有限的数据量是一个普遍的问题,但是有一些技术可以帮助您在这种情况下进行机器学习训练。下面是一些建议: 数据增强(Data Augmentation):这是一种技术,它利用现有的数据来创建新的训练样本。例如,对于图像数据,可以对原始图像进行平移、旋转、缩放、翻转等操作,生成新的训练样本。这样可以有效地扩充数据集,从而提高模型的泛化能力。迁移学习(Transfer Learning):这是一种技术,它利用预先训练好的模型来加速新模型的训练过程。例如,可以使用在大规模数据集上预先训练好的模型,将其权重加载到新模型中,并对其进行微调,以适应您的特定任务和数据集。模型压缩(Model Compression):这是一种技术,它通过减少模型的参数数量来减少训练数据的需求。例如,可以使用参数共享、权重剪枝、低秩近似等技术来减少模型的参数数量,从而在有限数据情况下训练更小、更快速的模型。正则化(Regularization):这是一种技术,它通过在损失函数中添加惩罚项来减少模型的过度拟合。例如,可以使用L1或L2正则化来减少模型参数的数量或大小,从而提高模型的泛化能力。集成学习(Ensemble Learning):这是一种技术,它利用多个不同的模型来对同一问题进行预测,并将它们的结果进行组合。这样可以有效地减少模型的方差,并提高预测的准确性。以上这些技术都可以帮助您在有限数据情况下进行机器学习训练。但请注意,在训练模型之前,您应该仔细考虑您的数据集的质量,并确保数据集能够代表您要解决的问题。 转自:https://www.zhihu.com/question/586916966/answer/2918354177 |

【本文地址】

今日新闻 |

推荐新闻 |