信息论 » BIT Lecture |

您所在的位置:网站首页 › 最大似然译码函数 › 信息论 » BIT Lecture |

信息论 » BIT Lecture

|

信息论

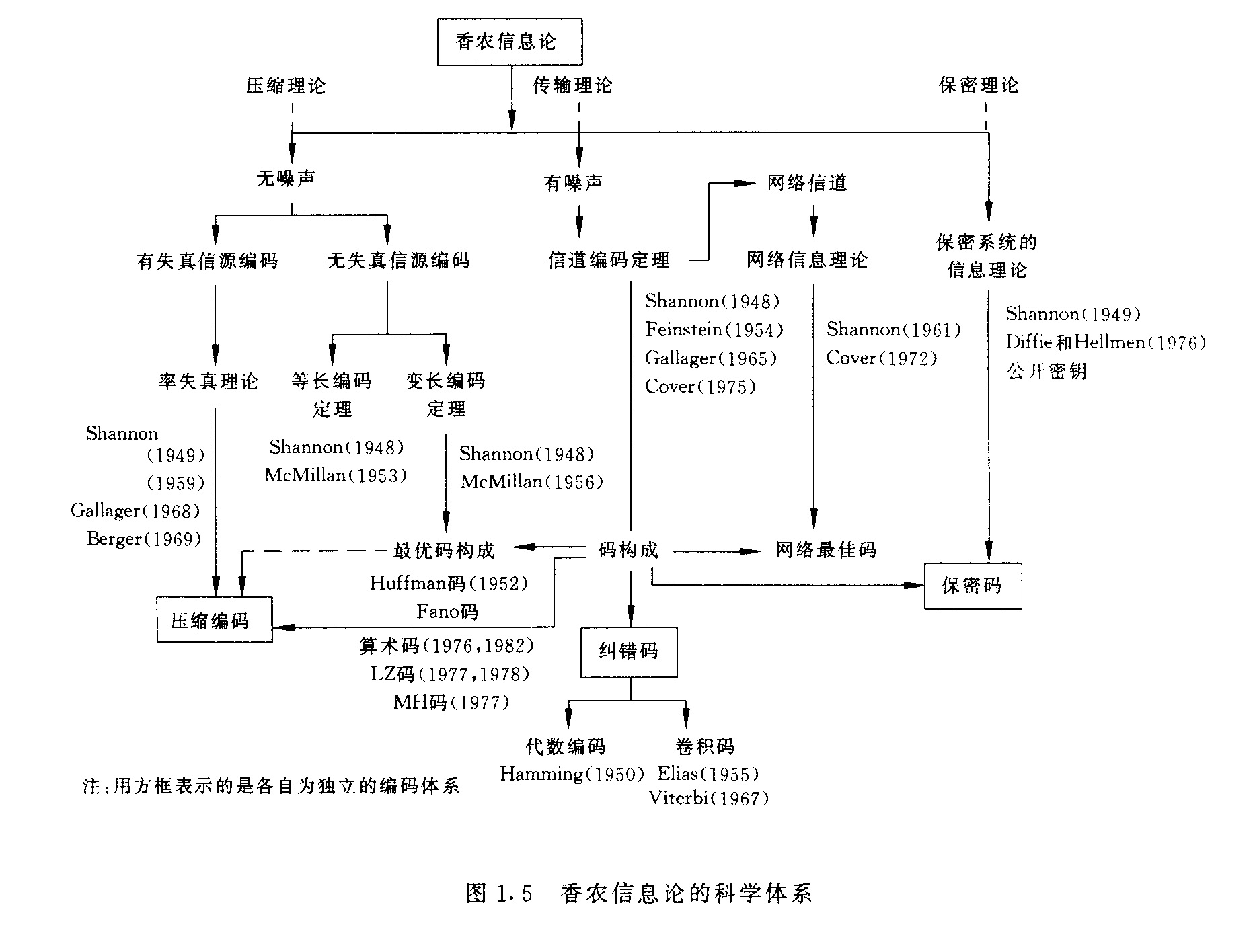

91 分钟读完 第一部分 绪论主要讲什么是信息以及通信系统的结构。 1 信息、消息与信号 含义信息是指各个事物运动的状态及状态变化的方式。 消息是指包含信息的语言、文字和图像等。 信号是消息的物理体现。 关系消息是信息的数学载体,信号是信息的物理载体。 同一信息,可以采用不同形式的物理量来载荷,也可以采用不同的数学描述方式。同样,同一类型信号或消息也可以代表不同内容的信息。 区别信号:具体的、物理的 消息:具体的、非物理的 信息:非具体的、非物理的 信息的度量信息是可以量度的,信息量有多少的差别。 2 信息论的起源、历史与发展1948年,香农提出信息论。《通信中的数学理论》——现代信息论的开创性的权威论文,为信息论的创立做出了独特的贡献。 香农信息论的科学体系

香农信息论的科学体系 3 通信系统的性能指标通信系统的性能指标主要是有效性、可靠性、安全性和经济性。通信系统优化就是使这些指标达到最佳。 有效性从提高通信系统的有效性意义上说,信源编码器的主要指标是它的编码效率,即理论上所需的码率与实际达到的码率之比。 提高通信系统有效性的最根本途径是信源编码,减少冗余。 可靠性信道编码,增加冗余。 由此我们可以看出,通信系统的有效性和可靠性是矛盾的。 第二部分 压缩理论 离散信源 1 信源的数学模型及分类 离散信源离散信源数学模型如下 \[\left[\begin{matrix}X\\P(x)\end{matrix}\right]=\left[\begin{matrix}a_1&a_2&...&a_q\\P(a_1)&P(a_2)&...&P(a_q)\end{matrix}\right]\]且满足 \[00\),只要满足 \[\frac{l}{N}\geq \frac{H(s)+\varepsilon}{logr}\]当N无穷大时,则可以实现几乎无失真编码。反之,若 \[\frac{l}{N}\leq \frac{H(s)-2\varepsilon}{logr}\]则不可能实现无失真编码,当N趋向于无穷大时,译码错误概率接近于1。 编码效率 \[\eta=\frac{H(S)}{\frac{l}{N}logr}\] 变长码\(l\)是变值,相应的编码定理称为变长编码定理,\(l\)值最小意味着数学期望最小。

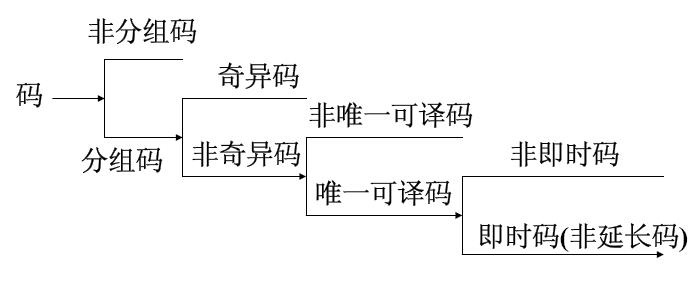

信源编码 Kraft不等式对于码符号为\(X={x_1,x_2,...,x_q}\)的任意即时码,所对应的码长为\(l_1,l_2,...,l_q\),则必定满足 \[\sum\limits_{i=1}^{q}r^{-l_i}\leq1\]反之,若码长满足上式,则一定存在这样的即时码。 唯一可译码一定满足Kraft不等式;反之,满足不等式的码不一定是唯一可译码,但一定至少存在一种唯一可译码。 唯一可译码的判断方法和步骤 首先观察其是否是非奇异码。若是奇异码则一定不是唯一可译码。 其次观察其是否满足Kraft不等式,若不满足则一定不是唯一可译码。 将码化成一棵码树图,观察其是否满足即时码的树图构造,若满足则是唯一可译码。 用萨德纳斯和彼特森设计的判断方法,计算出码中所有可能的尾随后缀集合F,观察F中有没有包含任意码字。若无则为唯一可译码;若有则一定不是唯一可译码。 变长信源编码定理(香农第一定理)离散无记忆信源\(S\)的\(N\)次扩展信源\(S^N\),其熵为\(H(S^N)\) ,并且编码器的码元符号集为\(X=\{x_1,x_2,…,x_r\}\) 对信源\(S^N\)进行编码, 总可以找到一种编码方法,构成唯一可译码,使信源S中每个符号所需要的平均码长满足 \[\frac{H(S)}{logr}\leq \frac{L_N}{N}0),&i\ne j \end{array} \right.\] \[[D]= \left[ \begin{matrix} 0 & a & a & ... & a\\ a & 0 & a & ... & a\\ a & a & 0 & ... & a\\ \vdots & \vdots & \vdots & 0 & \vdots\\ a & a & a & ... & 0 \end{matrix} \right]\]当\(i=j\)时,\(U\)与\(V\)的取值一样,用\(V\)来代表\(U\)就没有误差,所以定义失真函数为\(0\); 当\(i\ne j\)时,用\(V\)代表\(U\)就有误差。 这种定义认为对所有不同的\(i\)和\(j\)引起的误差都一样,所以定义失真函数为常数\(a\)。 失真矩阵的特点是对角线上的元素均为0,对角线以外的其它元素都为常数\(a\)。 当\(a=1\)时的失真函数称为汉明失真函数。 均方失真函数 \[d(u_i,v_j)=(v_j-u_i)^2\]这种函数称为平方误差失真函数,失真矩阵为平方误差失真矩阵。 若信源符号代表输出信号的幅度值,则较大的幅度失真比较小的幅度失真引起的错误更为严重,严重程度用平方表示。 绝对失真 \[d(u_i,v_j)=|v_j-u_i|\] 相对失真 \[d(u_i,v_j)=\frac{|v_j-u_i|}{|u_i|}\]第一种失真函数适用于离散信源,后三种失真函数适用于连续信源。 平均失真度 定义 \[\begin{aligned} \overline{D} &= E[d(u_i,v_j)]\\ &=\sum\limits_{U,V}P(u,v)d(u,v)\\ &=\sum\limits_{i=1}^{r}\sum\limits_{j=1}^{s}P(u_i)P(v_j\mid u_i)d(u_i,v_j) \end{aligned}\]若平均失真度\(\overline{D}\)不大于我们所允许的失真限度\(D\),则称为保真度准则。 凡满足保真度准则的这些试验信道称为D失真许可的试验信道。 意义\(\overline{D}\)是在平均意义上,从总体上对整个系统失真情况的描述。它是信源统计特性\(p(u_i)\) 、信道统计特性\(p(v_j\mid u_i)\)和失真度\(d(u_i,v_j)\)的函数 。当\(p(u_i)\),\(p(v_j\mid u_i )\)和\(d(u_i,v_j)\)给定后,平均失真度就不是一个随机变量了,而是一个确定的量。 如果信源和失真度一定,\(\overline{D}\)就只是信道统计特性的函数。信道传递概率不同,平均失真度随之改变。 信息率失真函数 定义在满足保真度准则下平均互信息的最小值,即 \[R(D)=\min\limits_{p(v_j\mid u_i)\in B_D} I(U;V)\]改变试验信道求平均互信息的最小值,实质上是选择一种编码方式使信息传输率为最小。 定义域(允许失真限度的最小值和最大值) 失真度限度的最小值\(D_{min}\)令失真矩阵\([D]\)中某一行中的最小元素所对应的试验信道的转移概率为1,其余为0,则和式最小,即 \[\left\{ \begin{array}{rcl} \sum\limits_{j=1}^sP(v_j\mid u_i)=1 &所有d(u_i,v_j)=最小的v_i\\ P(v_j\mid u_i)=0 & d(u_i,v_j)\ne最小的v_i \end{array} \right.\]则可得信源的最小平均失真度为 \[D_{min}=\sum\limits_{i=1}^{r}p(u_i)\min\limits_{j}d(u_i,v_j)\] 失真度限度的最大值\(D_{max}\)\(R(D)\)等于零时,所对应的平均失真度的下界就是失真限度的最大值\(D_{max}\) \[D_{max}=\min\limits_{j}\left[\sum\limits_{i=1}^rp(u_i)d(u_i,v_j)\right]\] 结论 \(R(D)\)的定义域为\((D_{min},D_{max})\); 一般情况下\(D_{min}=0\),\(R(D_{min})=H(U)\); 当\(D\geq D_{max}\)时,\(R(D)=0\); 当\(D_{min} |

【本文地址】

今日新闻 |

推荐新闻 |