大数据分析与挖掘 |

您所在的位置:网站首页 › 大数据的特征4v分析大数据在银行成功的 › 大数据分析与挖掘 |

大数据分析与挖掘

|

第一章 绪论

大数据分析与挖掘简介

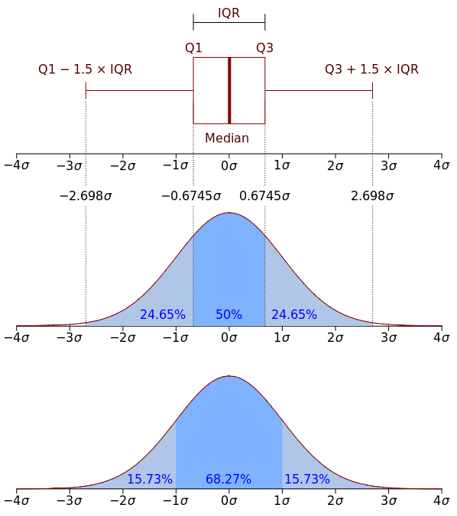

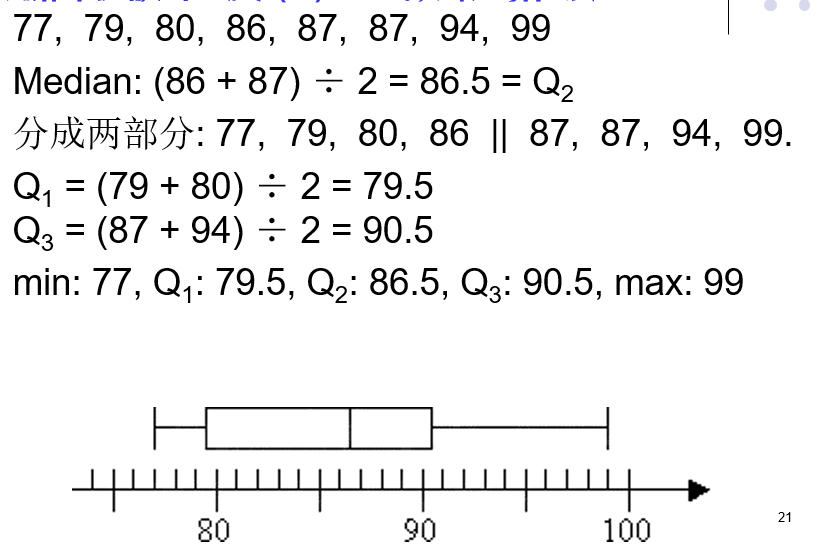

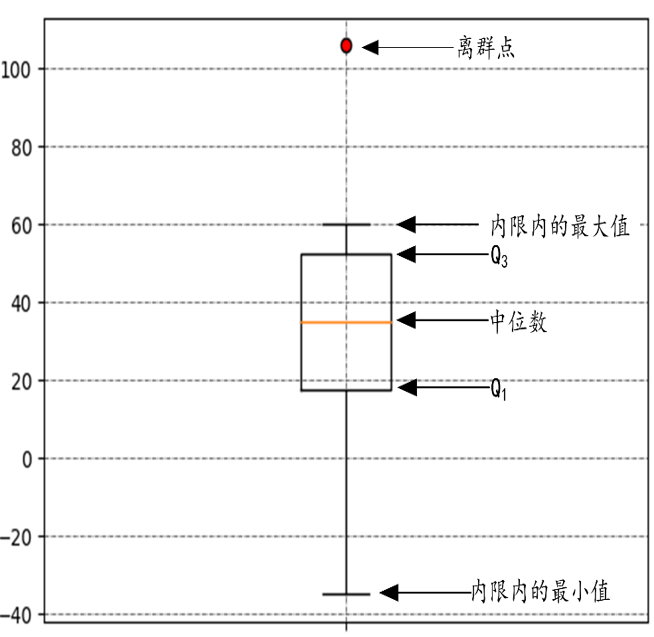

大数据的四个特点(4v):容量(Volume)、多样性(Variety)、速度(Velocity)和价值 概念:数据分析是用适当的统计分析方法,对收集来的大量数据进行分析,提取有用信息和形成结论并对数据加以详细研究和概括总结的过程。数据分析可以分为三个层次,即描述分析、预测分析和规范分析。 数据挖掘:是指从数据集合中提取人们感兴趣的知识,这些知识是隐含的、实现未知的、潜在有用的信息。提取出来的知识一般可表示为概念、规则、规律、模式等形式。 大数据分析与挖掘主要技术大数据分析与挖掘的过程一般分为如下几个步骤: 任务目标的确定 这一步骤主要是进行应用的需求分析,特别是要明确分析的目标,了 解与应用有关的先验知识和应用的最终目标。 目标数据集的提取 这一步骤是要根据分析和挖掘的目标,从应用相关的所有数据中抽取数据集,并选择全部数据属性中与目标最相关的属性子集。 数据预处理 这一步聚用来提高数据挖掘过程中所需数据的质量,同时也能够提高挖掘的效率。数据预处理过程包括数据清洗、 数据转换、数据集成、数据约减等操作。 建立适当的数据分析与挖掘模型 这一步骤包含了大量的分析与挖掘功能,如统计分析、分类和回归、聚类分析、关联规则挖掘、异常检测等。 模型的解释与评估 这一步骤主要见对挖掘出的模型进行解释,可以用可视化的方式来展示它们以利于人们的理解。 对模型的评估可以采用自动或半自动方式来进行,目的是找出用户真正感兴趣或有用的模型。 知识的应用 将挖掘出的知识以及确立的模型部署在用户的应用中。但这并不代表数据挖掘过程的结束,还需要一个不断反馈和迭代的过程,使模型和挖掘出的知识更加完善。数据挖掘主要包括如下的功能 对数据的统计分析与特征描述 关联规则挖掘和相关性性分析 分类和回归 例如决策树、贝叶斯分类器、KNN分类器、组合分类算法等,回归则是对数值型的函数进行建模,常用于数值预测。 聚类分析 聚类的主要目标是使聚类内数据的相似性最大,聚类间数据的相似性最小 异常检测 第二章 数据特征分析与预处理 数据类型2.1.1数据集类型 结构化数据 即行数据,存储在数据库里,可以用二维表结构来逻辑表达实现的数据,所有的数据都具有相同的模式。 半结构化数据 半结构化数据也具有一定的结构,但是没有像关系数据库中那样严格的模式定义。 常见的半结构化数据主要有XML文档和JSON数据 非结构化数据 非结构化数据没有预定义的数据了模型,涵盖各种文档、文本、图片、报表、图像、音频、视频数据属性的类型 标称属性 标称属性类似于标签,其中的数字或字符只是用来对物体进行识别和分类,不具有顺序关系,也不存在比较关系。 对标称属性不能做加减乘除运算,可以分析各个属性值出现的次数 当标称属性类别或状态数为两个的时候,称为二元属性,也被称为布尔属性,如果二元属性的两种状态具有相同的重要程度,则称为对称的。 序数属性 这种属性值之间可以有顺序关系,例如:学生成绩可以分为优秀、良好、中等、及格和不及格;产品质量可以分为优秀、合格和不合格。这样的属性称为序数属性,在统计学中也称为定序变量 标称、二元和序数属性的取值都是定性的,它们只描述对象的特征,如高、低等定性信息,并不给出实际的大小。可以用来比较大小,但还不能反应不同等级间的差异程度,不能进行加减乘除等数学运算 数值属性 数值属性是可以度量的,通常用实数来表示。 数值属性可以分为区间标度属性和比率标度属性。 (1)区间标度属性不能进行比率运算,例如20℃不能说是10℃的两倍,类似区间标度属性的还有日历日期、华氏温度、智商、用户满意度打分等。这些区间标度属性共同的特点是:用相等的单位尺度度量,属性的值有序,可以为正、负或零。相等的数字距离代表所测量相等的数量差值,在统计学上也称为定距变量。 (2)比率标度属性由于存在绝对零点,因此可以进行比率的计算,即它可进行加减乘除运算。这一类数值属性称为比率标度属性,在统计学中称为定比变量,是应用最广泛的一类数值属性属性类型总结 标称属性 序数属性 区间标度属性 比率标度属性 频数统计 √ √ √ √ 众数 √ √ √ √ 顺序关系 √ √ √ 中位数 √ √ √ 平均数 √ √ 量化差异 √ √ 加减运算 √ √ 乘除运算 √ 定义"真正零值" √ 数据的描述性特征描述数据几种趋势的度量 1. 算术平均数 一个包含n个数值型数据的集合,其算术平均数的定义是: \[\bar{x} = \frac{1}{n}\sum_{i=1}^{n}x_{i} \](1)一个集合中的各个数据与算术平均数离差之和等于零,即:\(\sum_{i=1}^{n}(x_{i}-\bar{x})=0\) 这个性质在数据的规范化中会被用到 (2)一个集合中的各个数据与算术平均数的离差平方之和是最小的。 算术平均数的缺点:容易受到集合中极端值或离群点的影响。 中位数 中位数是按照一定顺序排列后处于中间位置上的数据,中位数比算术平均数对于离群点的敏感度要低。当数据集合的分布呈现偏斜的时候,采用中位数作为集中趋势的度量更加有效 众数 (适合标称属性) 当数据的数量较大并且集中趋势比较明显的时候,众数更适合作为描述数据代表性水平的度量。 k百分位数 将一组数据从小到大排序,并计算相应的累计百分比,处于k%位置的值称为第k百分位数,用\({X_{k\% }}\)表示。在一个集合里,有k%的数小于或等于\({X_{k\% }}\),有1-k%的数大于它。 例:设有一组数据:[-35,10,20,30,40,50,60,100],求它的25百分位数,即\({X_{25\% }}\) 一般有两种方法,分别是(n+1) * k%或者1+(n-1) * k% \({X_{25\% }}\)所在位置是1+(8-1)* 25%=2.75,处于第二个和第三个数之间,即10与20之间。如果采用线性插值的话\({X_{25\% }}\)=10+(20-10)* 0.75=17.5,中点:(10+20)/ 2=15 四分位数 四分位数是一种特殊的百分位数。 (1)第一四分位数Q1,又称“较小四分位数”,即25百分位数。 (2)第二四分位数Q2,就是中位数。 (3)第三四分位数Q3,又称“较大四分位数”,即75百分位数。 四分位数是比较常见的分析数据分布趋势的度量 描述数据离中趋势的度量 极差 极差是指一组数据中最大值与最小值之差,又称范围误差或全距,用R表示。 四分位数极差(IQR) 四分位数极差也称内距,计算公式IQR=Q3-Q1,即第三四分位数减去第一四分位数的差,反应了数据集合中间50%数据的变动范围。 在探索性数据分析中,IQR可用于发现离群点,约翰·图基给了一个判定方法:超过Q3+1.5 * IQR或者低于Q1-1.5 * IQR的数据可能是离群点。

样本方差: \[{s^2}{\rm{ = }}\frac{1}{{n - 1}}\sum\limits_{i = 1}^n {{{({x_i} - \overline x )}^2}} \]♦标准差 标准差=方差的算数平方根 5. 离散系数 离散系数又称变异系数,样本变异系数是样本标准差与样本平均数之比: \[{{\rm{C}}_{\rm{v}}} = \frac{s}{{\mathop x\limits^ - }} \]数据分布形态的度量

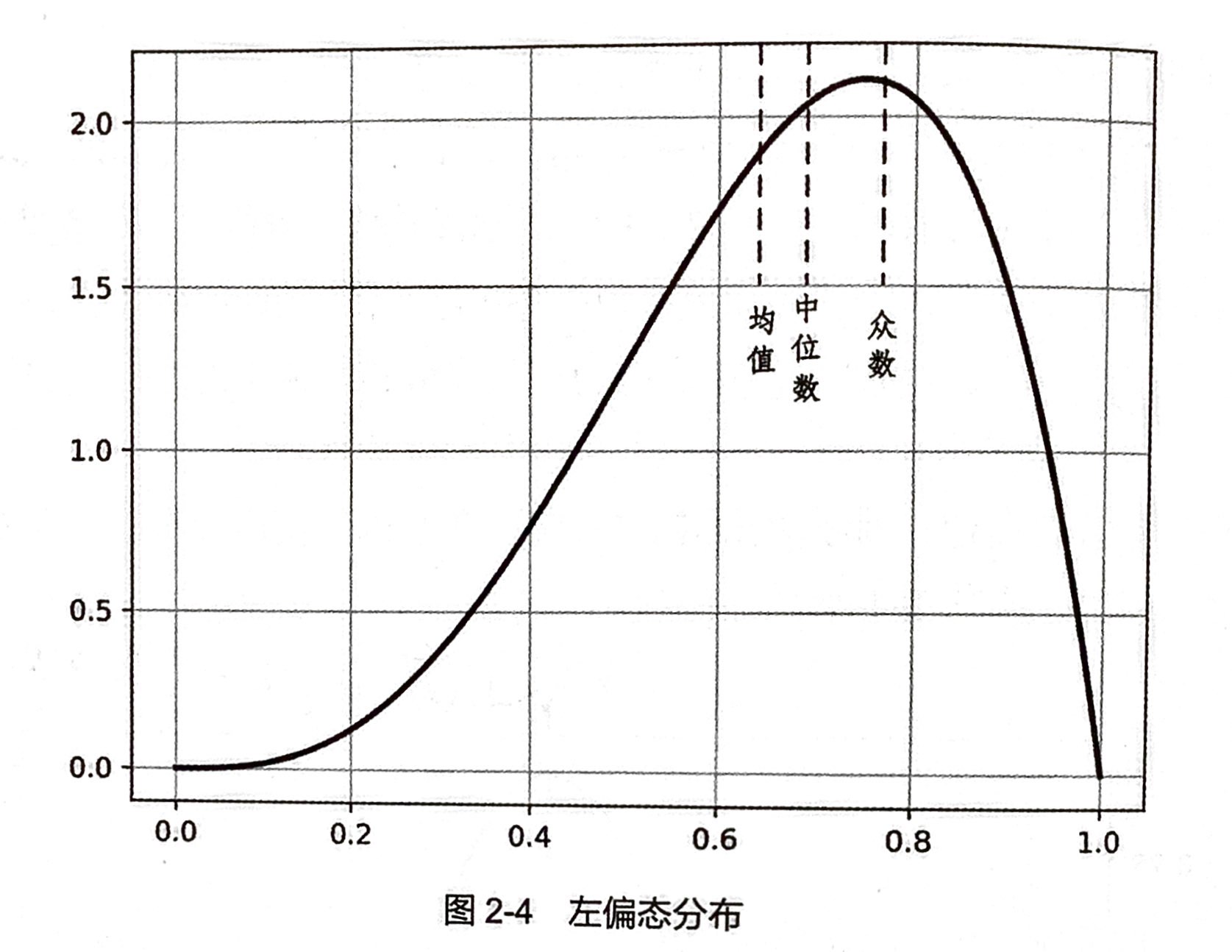

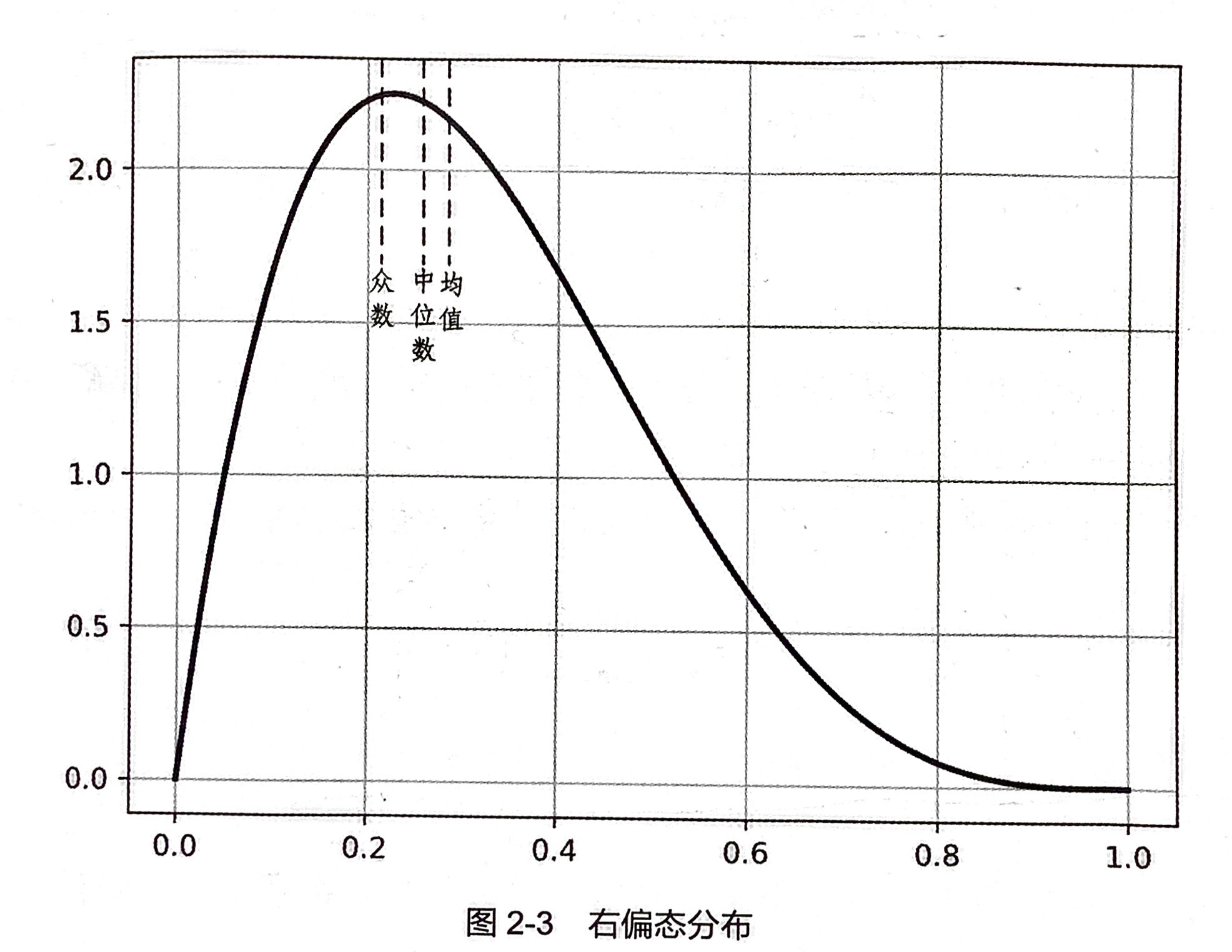

皮尔逊偏态系数 \(s{k_1} = \frac{{\mathop x\limits^ - - {M_0}}}{s}\) 或者 \(s{k_2} = \frac{{3(\mathop x\limits^ - - {M_d})}}{s}\) 其中,\(\mathop x\limits^ - \\\) 是平均数,\(\\{M_0}\\\)是重数,\(\\{M_d}\\\)是中位数,s是样本标准差 数据的峰度及度量 峰度用于衡量数据分布的平坦度,它以标准正态分布作为比较的基准。峰度的度量使用峰度系数: \[k = \frac{\frac{1}{n}\sum_{i=1}^{n}(x_{i}-\bar{x})^{4}}{(\frac{1}{n}\sum_{i=1}^{n}(x_{i}-\bar{x}))^{2}}-3 \]k≈0,称为常峰态,接近于正态分布。 k0,称为尖峰态。 数据偏度和峰度的作用 给定一个数据集合,通过计算它的偏度和峰度,可以符集数据分布与正态分布的差异,结合前面介绍的数据集中和离中趋势度量,就能够大致判断数据分布的形状等概要性信息,增加对数据的理解程度。 箱型图

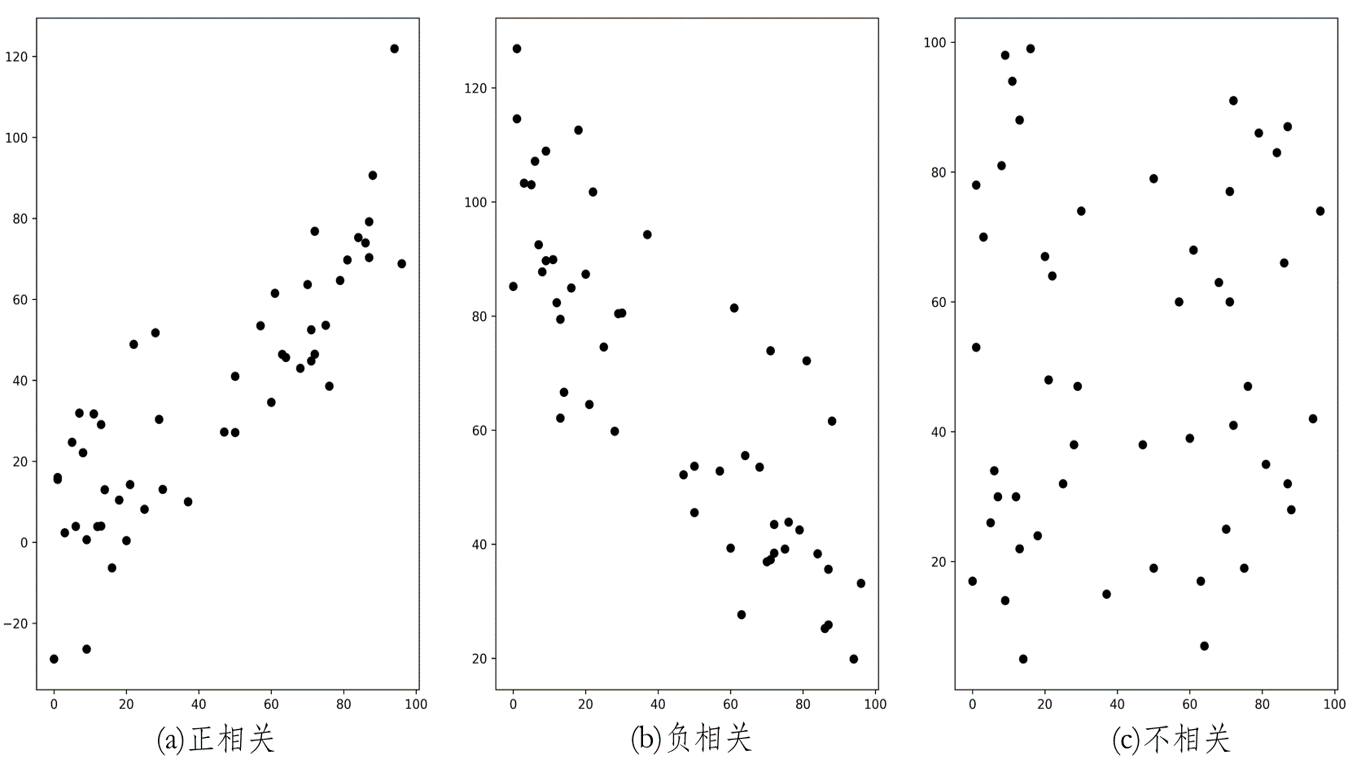

相关分析 散点图

判断两个属性之间是否有相关性,可以首先通过散点图进行直观判断。

散点图是将两个属性的成对数据,绘制在直角坐标系中得到的一系列点,可以直观地描述属性间是否相关、相关的表现形式以及相关的密切程度。

相关系数 数据的各个属性之间关系密切程度的度量,主要是通过相关系数的计算与检验来完成的。 属性X和Y之间的样本协方差的计算公式: \[{\mathop{\rm cov}} (X,Y) = \frac{{\sum\limits_{i = 1}^n {({X_i} - \mathop X\limits^ - )({Y_i} - \mathop Y\limits^ - )} }}{{n - 1}} \]协方差的正负代表两个属性相关性的方向,而协方差的绝对值代表它们之间关系的强弱。 样本相关系数,协方差的大小与属性的取值范围、量纲都有关系,构成不同的属性对之间的协方差难以进行横向比较。为了解决这个问题,把协方差归一化,就得到样本相关系数的计算公式:\[\\r(X,Y) = \frac{{{\mathop{\rm cov}} (X,Y)}}{{{s_X}{s_Y}}}\\ \]\(\\{s_X}{s_Y}\\\)标准差 相关系数消除了两个属性量纲的影响,它是无量纲的。相关系数的取值范围:-1=m),如果存在整数1L3=>C4=>L4······ 一组候选序列的产生是通过在先前扫描通过的序列模式上进行自我结合的。在第k次扫描的时候,只要每个它的每个length-(k-1)的子序列实在第k-1次扫描的时候找到的一个序列模式,那么这个序列就是候选序列。当在一次扫描的过程中没有发现候选序列或者没有候选序列的产生的时候算法就停止了。 Sequential patterns with length 3 After join After Pruning如上图所示,在连接的过程中,种子序列和种子序列连接可产生候选4序列;和种子序列连接可产生候选4序列。其余的序列均不满足连接条件,在剪枝过程中,候选4序列被减去,因为其连续子序列不包含3序列模式集合L3中。 GSP算法存在的问题 如果序列数据库的规模比较大,则有可能产生大量的候选序列模式; 需要对序列数据库进行循环扫描 对于序列模式的长度比较长的情况,算法很难处理 Freespan算法 Free Span算法执行的过程 首先给定序列数据库S及最小支持度阈值\(\varsigma\)。扫描S找到S中的频繁项集,并以降序排列生成f list列表。 执行下面步骤: (1)第1遍扫描S,构造频繁项矩阵; (2)生成长度为2的序列模式,循环项模式的标记和投影数据库的标记; (3)再次扫描S,生成循环项模式和投影数据; (4)对生成的投影数据库递归调用矩阵投影挖掘算法挖掘更长的候选模式。FreeSpan算法优点 它将频繁序列和频繁模式的挖掘统一起来,把挖掘工作限制在投影数据库中,还能限制序列分片的增长。它能有效地发现完整地序列模式,同时大大减少产生候选序列所需地开销,比基于Apriori的GSP算法快很多。 FreeSpan算法缺点 它可能会产生许多投影数据库,如果一个模式在数据库中的每个序列中出现,该模式的投影数据库将不会缩减;另外,一个长度为k的序列可能在任何位置增长,那么长度为k+1的候选序列必须对每个可能的组合情况进行考察,这样所需的开销是比较大的。 PrefixSpan算法 PrefixSpan算法的全称是Prefix-Projected Pattern Growth,即前缀投影的模式挖掘。里面有前缀和投影两个词。那么我们首先看看什么是PrefixSpan算法中的前缀prefix。在PrefixSpan算法中的前缀prefix通俗意义讲就是序列数据前面部分的子序列。如果用严格的数学描述,前缀是这样的:对于序列A={a1,a2,...ana1,a2,...an}和序列B={b1,b2,...bmb1,b2,...bm},n≤mn≤m,满足a1=b1,a2=b2...an−1=bn−1,而an⊆bn,则称A是B的前缀。比如对于序列数据B=,而A=,则A是B的前缀。当然B的前缀不止一个,比如< a >, < aa >, 也都是B的前缀。 看了前缀,我们再来看前缀投影,其实前缀投影这儿就是我们的后缀,有前缀就有后缀嘛。前缀加上后缀就可以构成一个我们的序列。下面给出前缀和后缀的例子。对于某一个前缀,序列里前缀后面剩下的子序列即为我们的后缀。如果前缀最后的项是项集的一部分,则用一个“_”来占位表示。 下面这个例子展示了序列的一些前缀和后缀,还是比较直观的。要注意的是,如果前缀的末尾不是一个完全的项集,则需要加一个占位符。 前缀 后缀(前缀投影) < a > < aa > < a(ab) >PrefixSpan算法思想 现在我们来看看PrefixSpan算法的思想,PrefixSpan算法的目标是挖掘出满足最小支持度的频繁序列。那么怎么去挖掘出所有满足要求的频繁序列呢。回忆Aprior算法,它是从频繁1项集出发,一步步的挖掘2项集,直到最大的K项集。PrefixSpan算法也类似,它从长度为1的前缀开始挖掘序列模式,搜索对应的投影数据库得到长度为1的前缀对应的频繁序列,然后递归的挖掘长度为2的前缀所对应的频繁序列····以此类推,一直递归到不能挖掘到更长的前缀挖掘为止。 比如对应于我们第二节的例子,支持度阈值为50%。里面长度为1的前缀包括< a >, < b >, < c >, < d >, < e >, < f >,< g >我们需要对这6个前缀分别递归搜索找各个前缀对应的频繁序列。如下图所示,每个前缀对应的后缀也标出来了。由于g只在序列4出现,支持度计数只有1,因此无法继续挖掘。我们的长度为1的频繁序列为< a >, < b >, < c >, < d >, < e >,< f >。去除所有序列中的g,即第4条记录变成

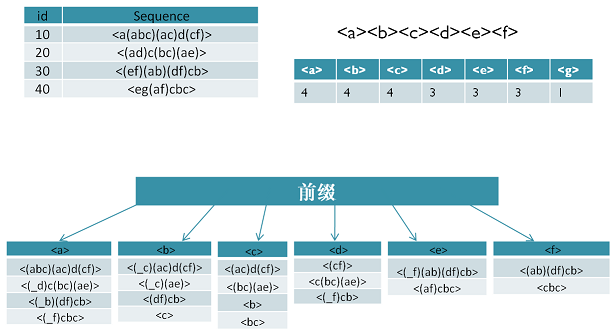

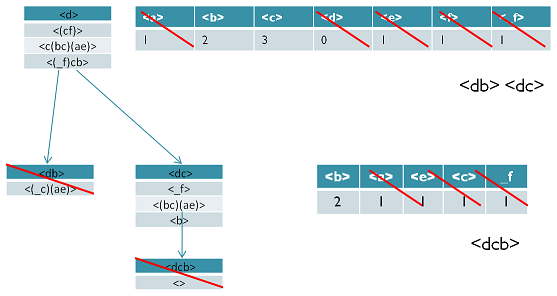

现在我们开始挖掘频繁序列,分别从长度为1的前缀开始。这里我们以d为例子来递归挖掘,其他的节点递归挖掘方法和D一样。方法如下图,首先我们对d的后缀进行计数,得到{a:1, b:2, c:3, d:0, e:1, f:1,_f:1}。注意f和_f是不一样的,因为前者是在和前缀d不同的项集,而后者是和前缀d同项集。由于此时a,d,e,f,_f都达不到支持度阈值,因此我们递归得到的前缀为d的2项频繁序列为和。接着我们分别递归db和dc为前缀所对应的投影序列。首先看db前缀,此时对应的投影后缀只有,此时_c,a,e支持度均达不到阈值,因此无法找到以db为前缀的频繁序列。现在我们来递归另外一个前缀dc。以dc为前缀的投影序列为, , ,此时我们进行支持度计数,结果为{b:2, a:1, c:1, e:1, _f:1},只有b满足支持度阈值,因此我们得到前缀为dc的三项频繁序列为。我们继续递归以为前缀的频繁序列。由于前缀对应的投影序列支持度全部不达标,因此不能产生4项频繁序列。至此以d为前缀的频繁序列挖掘结束,产生的频繁序列为。 同样的方法可以得到其他以< a >, < b >, < c >, < e >, < f >为前缀的频繁序列。

PrefixSpan算法流程 输入:序列数据集S和支持度阈值αα 输出:所有满足支持度要求的频繁序列集 1)找出所有长度为1的前缀和对应的投影数据库 2)对长度为1的前缀进行计数,将支持度低于阈值αα的前缀对应的项从数据集S删除,同时得到所有的频繁1项序列,i=1. 3)对于每个长度为i满足支持度要求的前缀进行递归挖掘: a) 找出前缀所对应的投影数据库。如果投影数据库为空,则递归返回。 b) 统计对应投影数据库中各项的支持度计数。如果所有项的支持度计数都低于阈值αα,则递归返回。 c) 将满足支持度计数的各个单项和当前的前缀进行合并,得到若干新的前缀。 d) 令i=i+1,前缀为合并单项后的各个前缀,分别递归执行第3步。 PrefixSpan算法小结 PrefixSpan算法由于不用产生候选序列,且投影数据库缩小的很快,内存消耗比较稳定,作频繁序列模式挖掘的时候效果很高。比起其他的序列挖掘算法比如GSP,FreeSpan有较大优势,因此是在生产环境常用的算法。 PrefixSpan运行时最大的消耗在递归的构造投影数据库。如果序列数据集较大,项数种类较多时,算法运行速度会有明显下降。因此有一些PrefixSpan的改进版算法都是在优化构造投影数据库这一块。比如使用伪投影计数。 第四章 分类与回归算法 数据分类主要包含两个步骤:第一步,事先利用已有数据样本建立一个数学模型,这一步通常称为“训练”,为建立模型的学习过程提供的具有类标号的数据称为“训练集”;第二步,使用模型,对未知分类的对象进行分类。 决策树算法决策树简介 类似于流程图的树结构 每个内部节点表示在一个属性上的测试 每个分枝代表一个测试输出 每个树叶节点代表类或类分布决策树类型 决策树分为分类树和回归树两种,分类树相对离散变量做决策树,回归树则对连续变量做决策树。 根据决策树的不同属性,可将其分为以下几种。 决策树内节点的测试属性可能是单变量的,即每个内节点只包括一个属性;也可能是多变量的,例如,多个属性的线性组合,即讯在包括多个属性的内节点。 每个内节点分支的数量取决于测试属性值的个数。如果每个内节点只有两个分支则称之为二叉决策树。 分类结果既可能是两类有可能是多类,如果二叉决策树的结果只能有两类则称之为布尔决策树。决策树构造过程 自顶向下的分治方式构造判定树 从代表所有训练样本的单个根节点开始 使用分类属性(如果是量化属性,则需先进行离散化) 递归的通过选择相应的测试属性,来划分样本,一旦一个属性出现在一个节点上,就不在该节点的任何后代上出现 测试属性是根据某种启发信息或者是统计信息来进行选择(如:信息增益)决策树学习采用自顶向下的分治方式构造判定树。决策树生成算法分成两个步骤:第一步是树的生成,开始时所有训练样本都在根节点,然后递归进行数据分片;第二步是树的修建。决策树停止分割的条件包括:一个节点上的数据都是属于同一个类别;没有属性可以再用于对数据进行分割。 预备知识:信息的定量描述 若概率很大,受信者事先已有所估计,则该消息信息量就很小; 若概率很小,受信者感觉很突然,该消息所含信息量就很大。 例:在一个口袋中,有100个球,其中1个是红球,另外99个是绿球,现在你随意抓一个球。 如果事先预言家告诉你将抓到绿球,你会觉得惊讶吗? 如果预言家告诉你将抓到红球,则觉得他的确有神算能力。信息量的定义 根据客观事实和人们的习惯概念,函数f(p)应满足以下条件: f(p)应是概率p的严格单调递减函数,即当p1>p2, f(p1) |

【本文地址】

今日新闻 |

推荐新闻 |