多元统计分析(2) |

您所在的位置:网站首页 › 多元正态分布函数的期望 › 多元统计分析(2) |

多元统计分析(2)

|

本part简介(*^_^*)

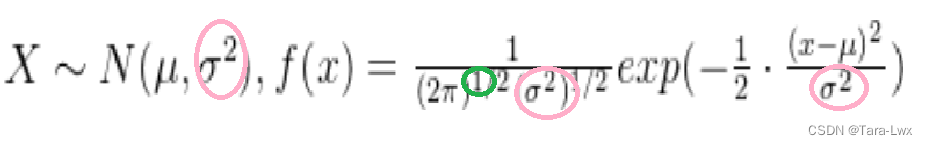

个人感觉这部分插在这里乱乱的…因为拿到多元数据首先考虑的好像不是它是否符合某个特定分布,而应该是如何处理它以得到样本特征,进而考察总体…所以刚讲完基础和前置知识就把这个极其特殊的分布引入似乎有点突兀(大概。不过理解这种组织结构的一种思路是,后续所有的具体分析方式,涉及非多元正态分布时和多元正态时都会体现出差异。因此先给个简单铺垫倒也合理( 以下内容给多元正态分布一个缩写:Multivariate Normal Distribution(主要是不想打字了orz 就MND本身的性质而言… 长啥样(密度函数及等高线首先看看它的密度函数,这个可以从一元的直接改写出来,所以直接给出具体的改写方法。 一元的长这个样子

把里面画圈的分别替换成多元对应的形式即可,会变成

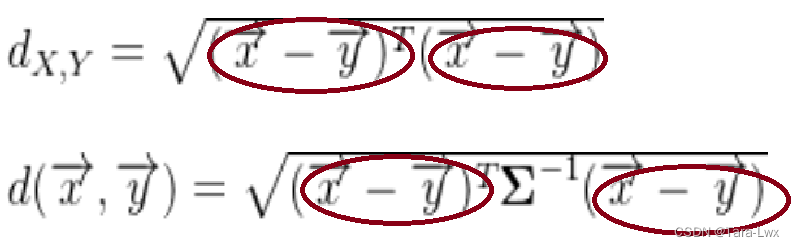

这里面 这个密度函数里藏着某种玄机,看到exp的括号里面的部分。如果把它提取出来,这种“行向量乘对称阵乘列向量”的形式(学名二次型)非常像马氏距离表达式。进而,假设它等于某个常数,那么就可以得到这个概率密度的等高线(相当于这条线上每个点概率相同),因为到中心的距离是一样的。 我们的原始数据矩阵从几何上理解,就是在一个 通常使用的距离计算方式是下面这种 叫做欧氏距离,适用于那些所有维度的单位和尺度都一样的情况。比如说,每个维度都是分数,只不过分不同科目这种情况。但如果有的维度是分数,有的维度是身高,如果想比较不同点之间的距离,直接用这种方式算会让尺度大的维度上的差异遮蔽尺度相对小的。有点类似于瘦死的骆驼比马大,所以最好是把骆驼放在骆驼群比较,把马放在马群比较。具体来说就是除以这个维度的方差,这就是传说中标准化的主要思路。这里的“方差”同样有两种算法,如果题目给出的是总体水平,那么就是 但这种情况下是假定这几个维度互相独立,意味着他们的坐标轴画出来是互相正交的。最简单理解这个的思路是,如果几个点欧氏距离相等,那么他们处于以原点为圆心的一个⚪上;如果几个点马氏距离相等,那么处于以原点为中心的一个椭圆上。但是椭圆这东西,转来转去的话并不相等,坐标系是不是它的长短轴,对于它的位置区别还是很大的。而上面的考虑相当于只对各个维度之间的差异进行了伸缩,而没有考虑旋转的问题。所以,如果这几个维度并不互相独立,那么还要考虑他们之间的相关性。 具体来说,就是要通过一种旋转方式,把坐标轴转成椭圆的各个轴的方向。如果是二维,那么是长短轴,如果不是,那么多个维度都需要对应。然后经过计算,发现这种旋转和拉伸的总效果是把欧氏距离中间乘上了协差阵的逆。具体来说

现在把这两个距离的表示放到一起来看,可以发现他们都是二次型的形式,都是某个向量的转置乘个矩阵再乘这个向量。

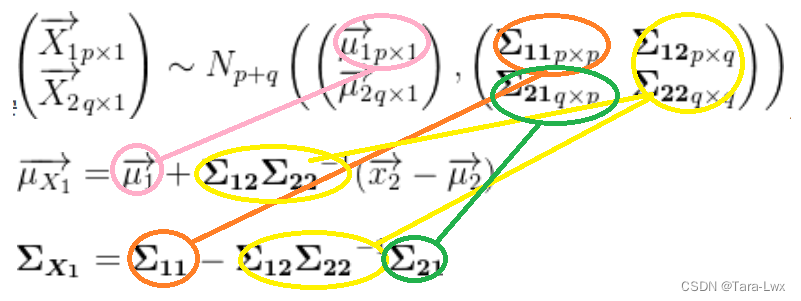

假定两边的随机向量是

观察期望内部的式子,由于这里面的 然后看里面那个东西,回忆一下一元随机向量里 然后如果对以上两个距离的二次型套用这个定理,就可以分别得到这两个距离的期望,第一步是求出旁边的这俩向量的期望和协差阵。对于 两个非常简洁的常数。 补充一下这两种距离本身之间的关系的几何理解。具体来说,我们刚刚求解马氏距离对原数据进行的变换是,先旋转、再拉伸,最后把原来堆得像一个椭圆的数据搓成一个⚪。这个变化过程本身就类似谱分解。而再看马氏距离的定义式 这个里边的 它总共是6个东西的乘积,仔细观察会发现,前三个东西凑在一起相当于是后三个东西的转置。所以可以直接化成某一个向量的转置再乘自己的形式。把这个向量记为 得到的最直接的关系是 这个从直观上可以这么理解,旋转和伸缩坐标系都相当于反向旋转和伸缩数据点,进而把所有数据糅进一个⚪里,进而新的数据的协差阵为 写出来就是这么个式子,

先说一个基本性质,和它本身的定义是等价的。通俗地说,如果 上面的内容说的是,如果 那么如果这几个向量的期望不同,但是协差阵是相等的,那么根据它的线性性质可以得到 更进一步,如果有两组这么个玩意儿,比如再来一个 假设现在有一堆符合一元标准正态分布的 这个可以直接从总体的期望和协差阵得到,具体来说可以直接参考这个例子

相当于把对应位置上的期望和协差阵直接提取出来,不用管剩下的东西是多少。但剩下的东西不是完全没有影响,它的意义在于,如果这里面(-1,2)这部分是0,那么可以推出 比如说 条件分布(其实也是正态,但系数麻烦这里给出一个最简单的版本,假定

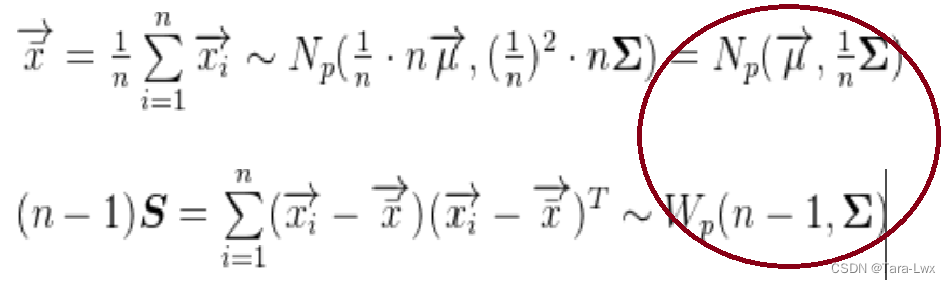

这一部分和上面的本质区别在于,手头上有的到底是理念世界存在的模型,还是一大堆据说符合某个分布的样本。啥意思呢,放在题目里就是,前面的内容适用于“假设某个向量符合MND,请问它经过xxx之后是什么分布”,而后面的内容则适用于“已知如下数据符合MND,请问它的xxxx参数是什么”。 如何对两大参数(均值&协差阵)进行点估计?——MLE似然函数就是把每个样本的密度函数乘起来,然后对需要求解的参数求偏导,可以得到下面这俩

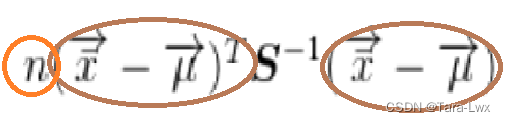

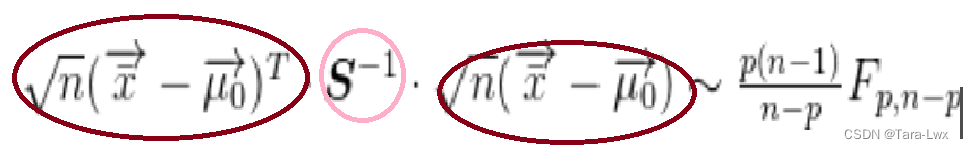

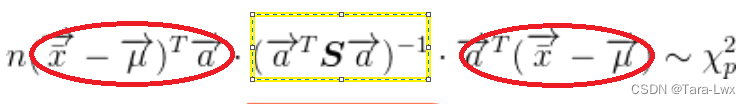

首先 这里先宕开一笔,简单说说假设检验的基本思路是什么,再说说如何应用到这个具体情境中。简单来说它涉及到两条线,分别从理想与现实出发,然后最终判断是否一致。从理想出发,就是定义一个原假设和一个备择假设,不到万不得已不推翻原假设。从现实出发,就是选取一个检验统计量,这玩意儿要求可以完全由手头上的数据计算得出,并且在理想情况下是符合某个我们知道的分布的(比如t和F这种),这样就可以根据现实判断,它到底符合还是不符合。接下来,根据这个已知的分布和事先给定的显著性水平找到拒绝域,这个依然是理想情况。然后再转回现实,看样本计算出的检验统计量是在拒绝域里呢,还是外面。 只有一个总体的情况(看均值和自己的预设是否一致从理想出发,我们有一个预设 那就涉及到一个问题,怎么找到“  并且他俩是彼此独立的。

为啥这俩彼此独立呢?直观理解,就是样本中心在哪里和它有多分散是不相干的两码事。计算证明也很简洁, 并且他俩是彼此独立的。

为啥这俩彼此独立呢?直观理解,就是样本中心在哪里和它有多分散是不相干的两码事。计算证明也很简洁,

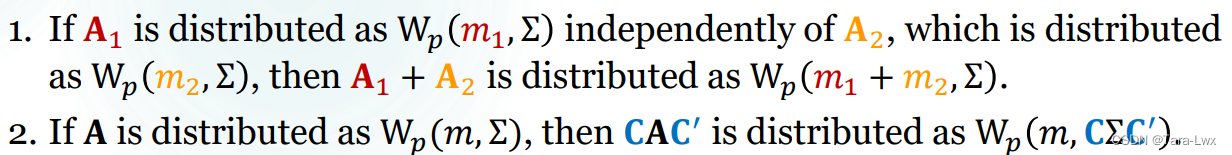

基于这几个式子,又可以得到一个新的分布,这个放在一元里也成立,但不常用,一般会用它开根号得到的t分布。

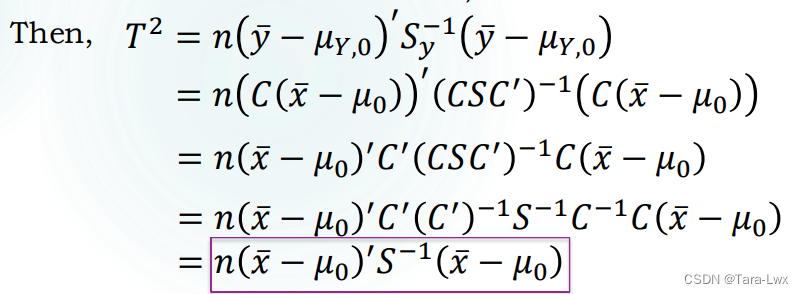

这个新的分布也有一些好特质。最有用的就是线性变换之后保持不变。那么如果换之后的不好算,就直接用换之前的就行。

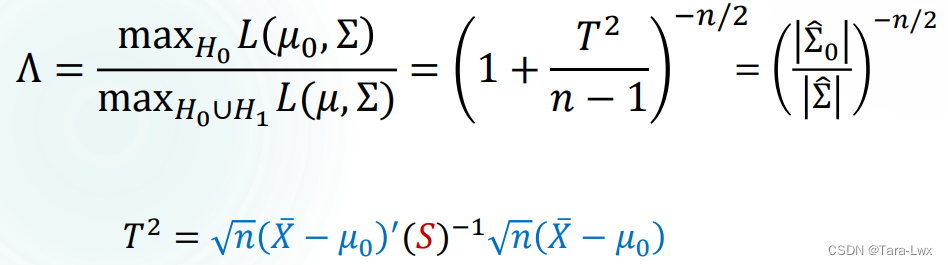

这个式子相当于一元情况下t检验的推广。分析一下它的形式,相当于一个MND的内积,中间除了一个Wishart。如果根据它确定拒绝域(也就是到底距离差多少的时候我们拒绝原假设?)那么开口向右边,就是根据样本把这个值算出来,大于 这个也需要两种相反的假设。但和上面的检验方法异曲同工。

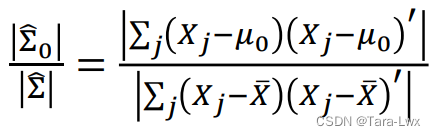

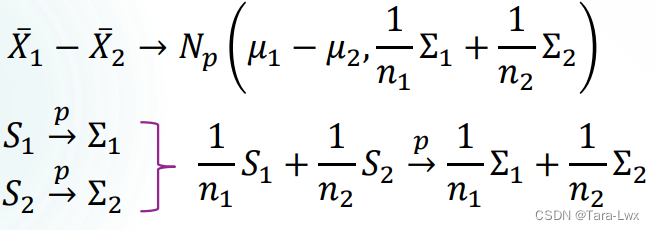

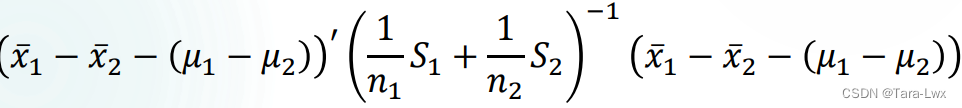

这是一种比较巧算的方法,因为矩阵行列式好求,但逆矩阵不好求。这样可以绕开求逆。 有俩总体,要判断期望之差是否符合预设的情况这里面涉及到一个非常关键的问题,这俩总体到底是否独立?这个不同事实上是很关键的。具体的区别比如,检验同样的学生受教育前后的成绩是否变化,那就需要把同一个人前后的成绩相减然后看成新的单一总体,使用上面的方法,不然会忽略个体差异对成绩的影响;但如果采的是两个班的样,确定是不一样的总体,并且样本之间的顺序不影响作差的结果,就无需配对,跳到第二种方法。 首先要配对!然后回到上边把同一样本前后的差异求出来,记成一堆新样本 这一部分既非常接近一元时的双总体,又非常接近多元时的一总体。(有一种杂交的感觉。首先对他们总体水平期望的差异的估计很显然是样本均值的差异

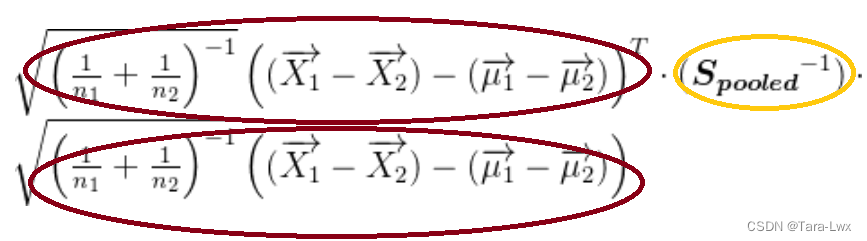

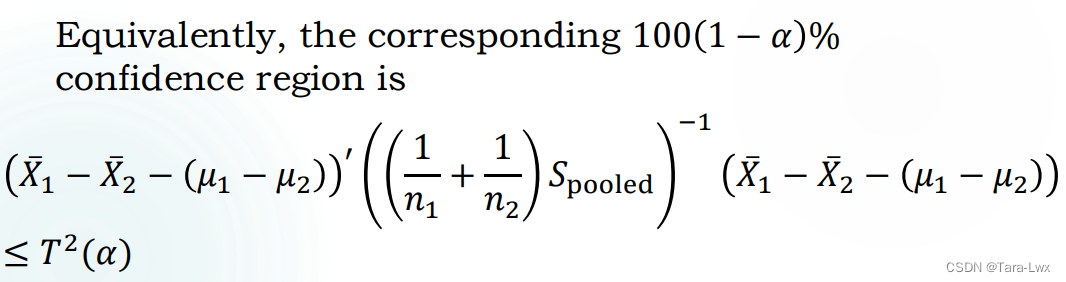

但这个是比较理想的情况,现实里我们也不知道这个相同的总体斜差阵到底是多少,所以需要用样本来估计。但问题出现了:俩总体的样本协差阵极大概率有差异,用谁的来估计更准确呢?二选一肯定不如把他们的信息综合起来,这个综合的方式就是pool过的大样本协差阵,把下面这两个式子组合起来 然后用到这个分布的特殊性质,把它们叠起来就能得到

最后一步就是模仿前面的形式, 写出一个针对双总体的检验统计量,也是“一个MND转置*一个Wishart倒数*这个MND本身”的样子,进而它的分布也应该是一个F分布。看上面这个公式可以确定系数。

到目前为止,前文所有推断都是基于某个假设,即我们得到的所有样本来源都是某个正态,虽然我们不知道具体是什么,但可以确认是个正态。但事实上,这个假设大部分情况下未见得成立。这时候一种有效的补救措施是,如果样本量足够大,其实我们并不需要这个假设一定成立。 在一元情况下有一个东西叫CLT中心极限定理,就是说不管初始时 这里面第一步就是一个抄定义,第二步是非常经典的加一项减一项的操作。然后把它们拆开,再利用一下上面那个性质会发现它变成了 在这种情况下,原始的随机向量不一定符合MND,但是假如我们(通过某些方式)已知总体的期望和协差阵分别是 可以用这种方式来做假设检验。拒绝域同样设在右边。不过这次用的是 在一元的数据里,最简单的检验方法就是用图形,两类图是比较常见的 直方图QQ图考虑到我们之前说,多元本身可以由一元得到,进而,检验它的方式也可以还原到一元的尺度上。具体来说,我们可以找到它的边缘分布,看每一个边缘分布是不是符合一元正态分布,如果不是,那这个整体肯定不是多元正态分布;当然,即使全都是,也不一定整体是。 还有一种方式也可以把这个多元正态转换成某个一元正态——让某个行向量左乘它,把它变成自己的各个分量的线性组合。 那如果协差阵不同呢…(同样需要大样本

最终依然趋近于卡方分布。我们的检验统计量是

这个东西的标准统一格式都是,点估计 这就需要回溯上面的分布 首先分位点可以一眼看出

这个里面,小于号左边的内容就是上面的检验统计量的变形,把已知、待检验的

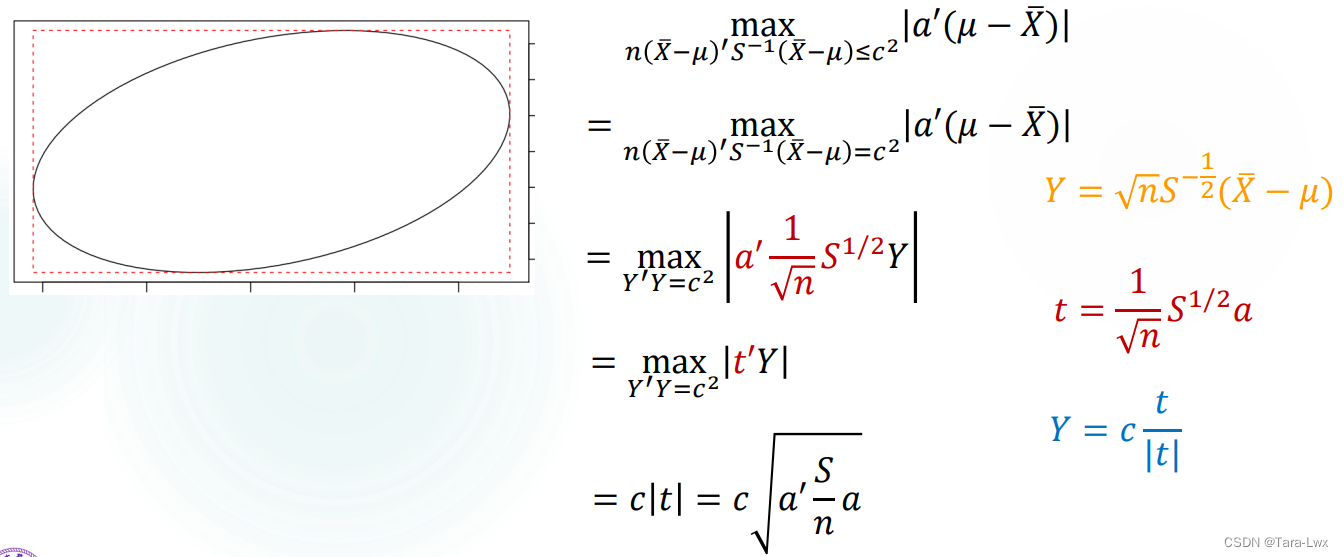

考虑到我们上面的到的整个期望是一个巨大的向量,但是我们有时候关心他们每个分量分别所处的位置信息。具体来说,假设我们想得到各个分量之间的某种线性组合,比如这个向量与另一个向量

那如果更进一步,现在有多个这种组合,然后想看看,能不能对每个组合找一个区间,使他们综合来看都处于区间之中的概率是 给出下面这个非常经典的修正:Bonferroni correction。具体来说,就是把原来的分位点 那有没有可能找到一个区间能同时覆盖所有的这种线性组合呢?答案是有的!这个需要回头用到上面的F分布,具体来说,区间半长和点估计都不变,但分位点需要改成 它俩之间确实有关联。画出图会发现CR是这种CI的内切椭圆。

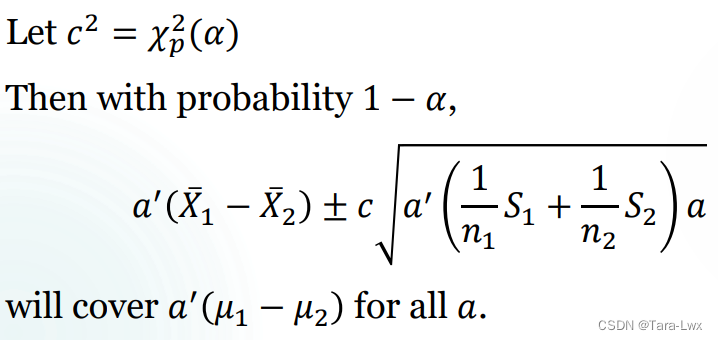

我们现在已有的信息是  趋近于 趋近于然后我们想找到一个对于所有

首先点估计是不变的

|

【本文地址】

今日新闻 |

推荐新闻 |

这个东西的期望有个计算公式,现在来一步步推一下。

这个东西的期望有个计算公式,现在来一步步推一下。

,接着就非常一目了然了。

,接着就非常一目了然了。