一文看懂线性回归(3个优缺点+8种方法评测) |

您所在的位置:网站首页 › 回归分析为什么叫回归 › 一文看懂线性回归(3个优缺点+8种方法评测) |

一文看懂线性回归(3个优缺点+8种方法评测)

|

HomeAI 知识库AI 算法

线性回归 – linear regression

文章目录

线性回归是很基础的机器学习算法,本文将通俗易懂的介绍线性回归的基本概念,优缺点,8 种方法的速度评测,还有和逻辑回归的比较。 什么是线性回归?

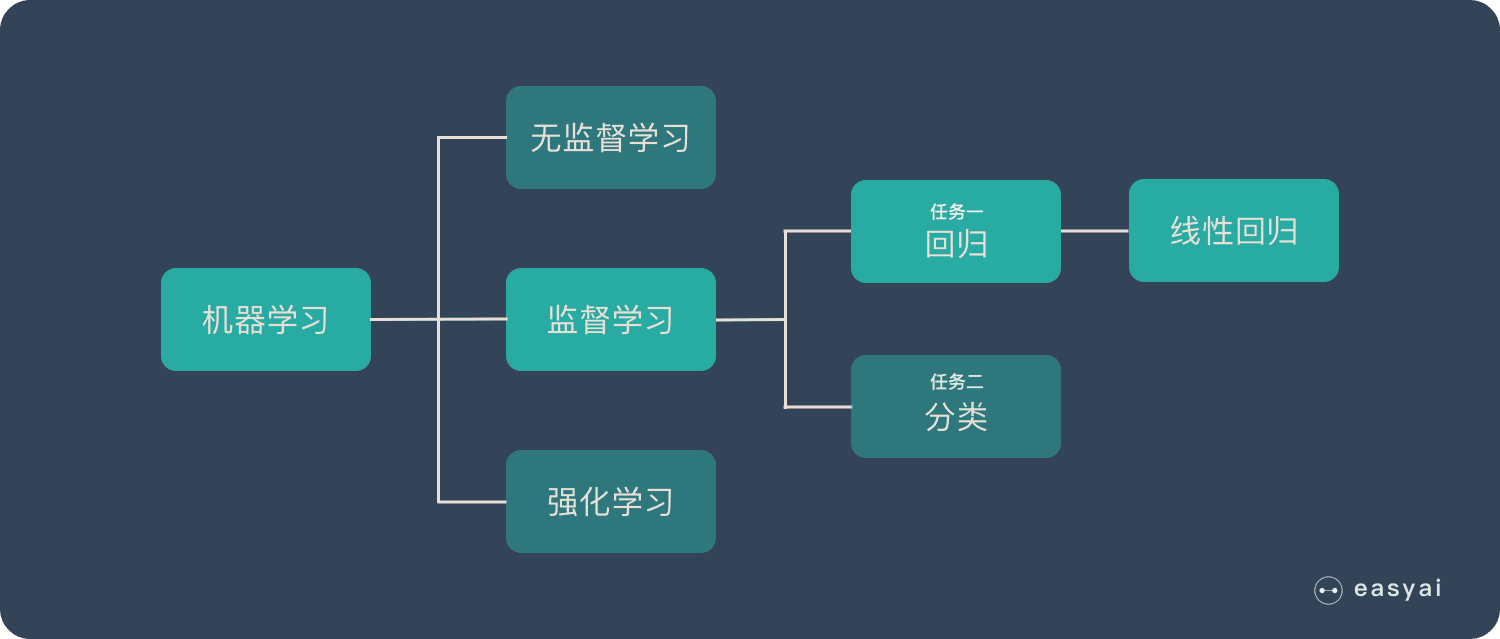

线性回归的位置如上图所示,它属于机器学习 – 监督学习 – 回归 – 线性回归。 扩展阅读: 《一文看懂机器学习!(3种学习方法+7个实操步骤+15种常见算法)》 《一文看懂监督学习(基本概念+4步流程+9个典型算法)》

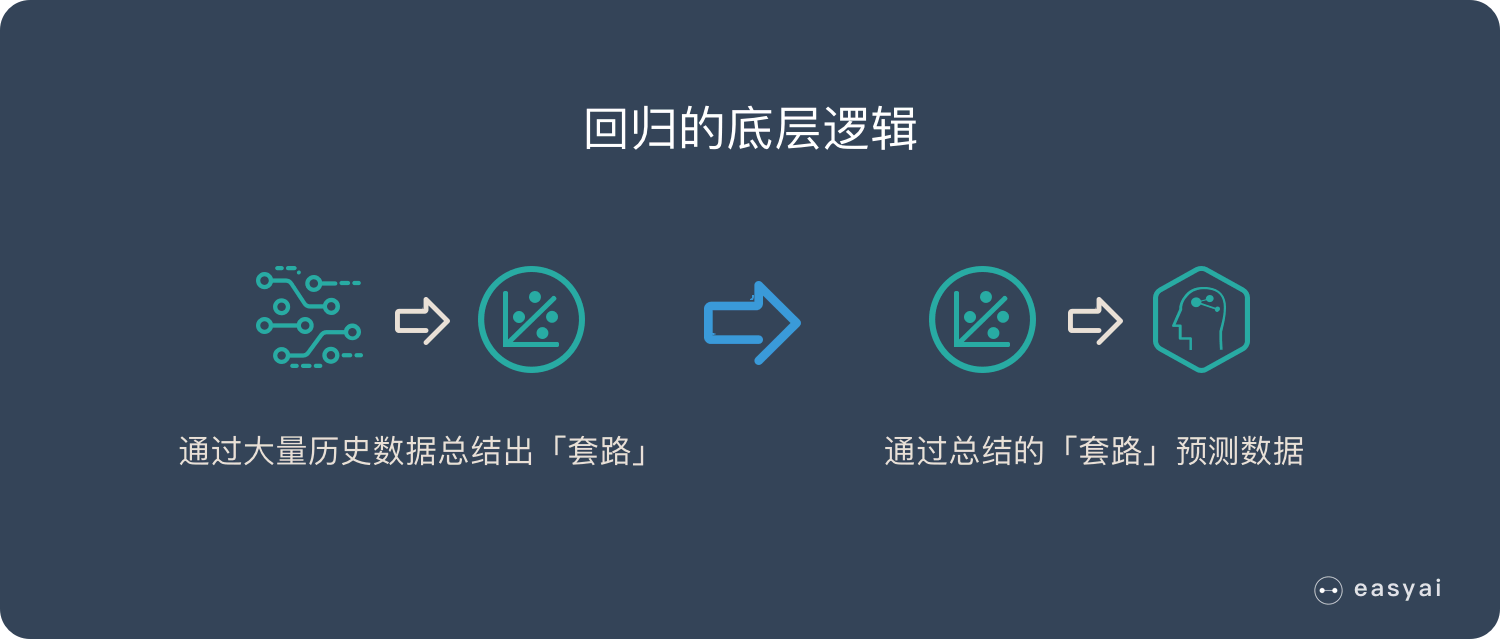

什么是回归? 回归的目的是为了预测,比如预测明天的天气温度,预测股票的走势… 回归之所以能预测是因为他通过历史数据,摸透了“套路”,然后通过这个套路来预测未来的结果。

什么是线性? “越…,越…”符合这种说法的就可能是线性个关系: 「房子」越大,「租金」就越高 「汉堡」买的越多,花的「钱」就越多 杯子里的「水」越多,「重量」就越大 …… 但是并非所有“越…,越…”都是线性的,比如“充电越久,电量越高”,他就类似下面的非线性曲线:

线性关系不仅仅只能存在 2 个变量(二维平面)。3 个变量时(三维空间),线性关系就是一个平面,4 个变量时(四维空间),线性关系就是一个体。以此类推…

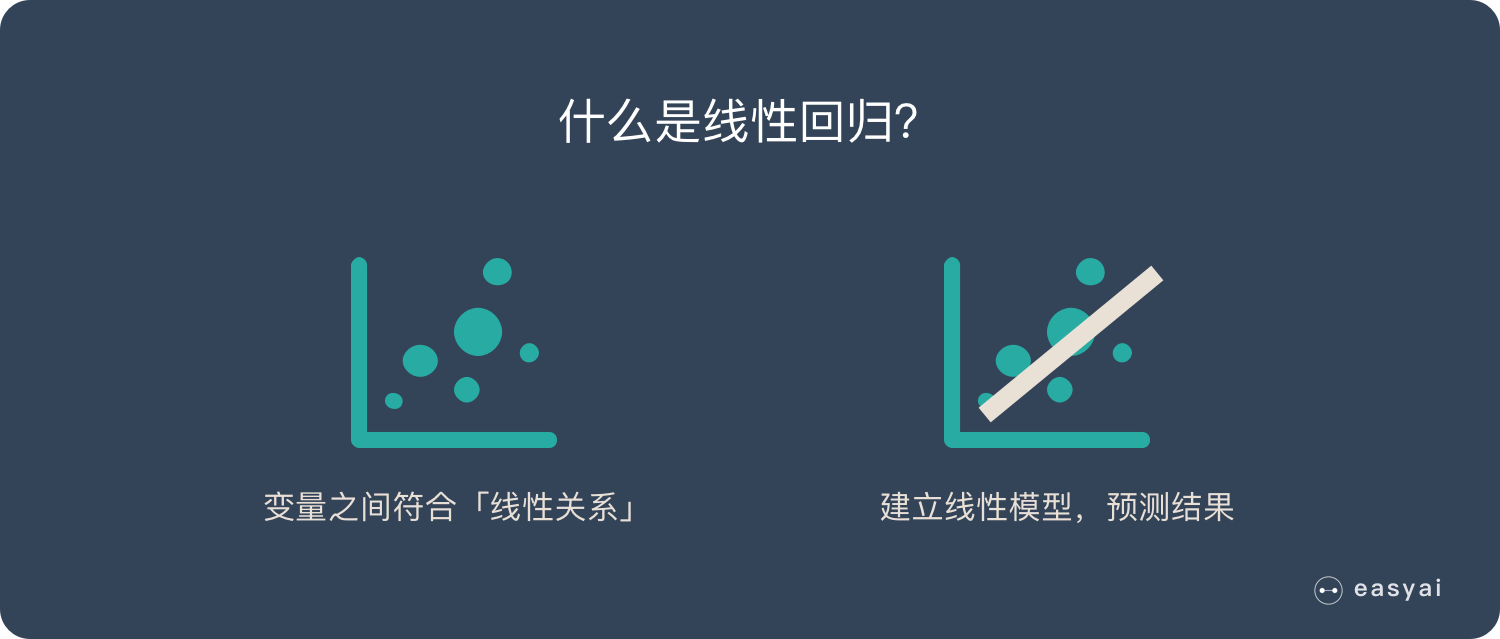

什么是线性回归? 线性回归本来是是统计学里的概念,现在经常被用在机器学习中。 如果 2 个或者多个变量之间存在“线性关系”,那么我们就可以通过历史数据,摸清变量之间的“套路”,建立一个有效的模型,来预测未来的变量结果。

线性回归的优缺点

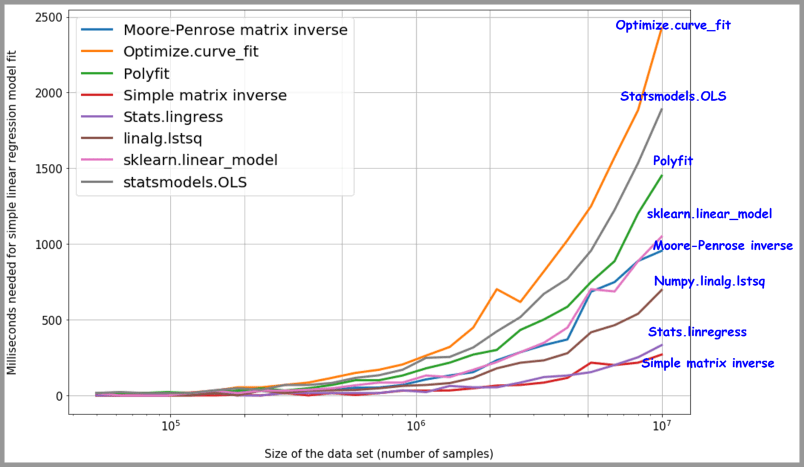

优点: 建模速度快,不需要很复杂的计算,在数据量大的情况下依然运行速度很快。 可以根据系数给出每个变量的理解和解释缺点:不能很好地拟合非线性数据。所以需要先判断变量之间是否是线性关系。 为什么在深度学习大杀四方的今天还使用线性回归呢? 一方面,线性回归所能够模拟的关系其实远不止线性关系。线性回归中的“线性”指的是系数的线性,而通过对特征的非线性变换,以及广义线性模型的推广,输出和特征之间的函数关系可以是高度非线性的。另一方面,也是更为重要的一点,线性模型的易解释性使得它在物理学、经济学、商学等领域中占据了难以取代的地位。 8 种Python线性回归的方法的速度评测 Scipy.polyfit( ) or numpy.polyfit( ) Stats.linregress( ) Optimize.curve_fit( ) numpy.linalg.lstsq Statsmodels.OLS ( ) 简单的乘法求矩阵的逆 首先计算x的Moore-Penrose广义伪逆矩阵,然后与y取点积 sklearn.linear_model.LinearRegression( )

结果:令人惊讶的是,与广泛被使用的scikit-learnlinear_model相比,简单矩阵的逆求解的方案反而更加快速。 详细评测可以查看原文《Data science with Python: 8 ways to do linear regression and measure their speed》 线性回归 VS 逻辑回归 线性回归和逻辑回归是 2 种经典的算法。经常被拿来做比较,下面整理了一些两者的区别:

注: 自变量:主动操作的变量,可以看做「因变量」的原因 因变量:因为「自变量」的变化而变化,可以看做「自变量」的结果。也是我们想要预测的结果。

百度百科+维基百科 百度百科版本 线性回归是利用数理统计中回归分析,来确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法,运用十分广泛。其表达形式为y = w’x+e,e为误差服从均值为0的正态分布。 回归分析中,只包括一个自变量和一个因变量,且二者的关系可用一条直线近似表示,这种回归分析称为一元线性回归分析。如果回归分析中包括两个或两个以上的自变量,且因变量和自变量之间是线性关系,则称为多元线性回归分析。 查看详情 维基百科版本在统计学中,线性回归是一种线性方法,用于建模标量响应(或因变量)与一个或多个解释变量(或独立变量)之间的关系。一个解释变量的情况称为简单线性回归。对于多个解释变量,该过程称为多元线性回归。该术语不同于多元线性回归,其中预测了多个相关因变量,而不是单个标量变量。 在线性回归中,使用线性预测函数对关系进行建模,其中未知模型参数是根据数据估计的。这种模型称为线性模型。最常见的是,给定解释变量(或预测变量)的值的响应的条件均值被假定为这些值的仿射函数 ; 不太常见的是,使用条件中值或一些其他分位数。与所有形式的回归分析一样,线性回归侧重于条件概率分布给出预测变量值的响应,而不是所有这些变量的联合概率分布,这是多变量分析的领域。 查看详情 扩展阅读 用Python的Scikit-Learn库实现线性回归 机器学习算法_线性回归 通俗理解线性回归(一) 2019年1月3日 by 打不死的小强 Updated: 2022年8月15日 AI 算法, 机器学习 linear regression, 机器学习, 算法, 线性回归Thanks for your rating! You have already rated this article An error occured, please try again later Was This Article Helpful? |

【本文地址】

今日新闻 |

推荐新闻 |