奇异值 |

您所在的位置:网站首页 › 取最大值是什么意思 › 奇异值 |

奇异值

|

又是网上搜刮的几篇文章

1. https://www.zhihu.com/question/22237507/answer/28007137(郑宁的回答) 2. 转自taotao1233的博客http://blog.csdn.net/jinshengtao/article/details/18448355 本文将分别介绍特征值分解、奇异值分解、及PCA的相关理论概念。 文章末尾将给出Householder矩阵变换、QR算法求解特征值、特征向量的代码 其中,特征值分解、奇异值分解的相关内容,转载自: http://www.cnblogs.com/LeftNotEasy/archive/2011/01/19/svd-and-applications.html 考虑到本文50%以上的部分不是那个哥们的博客原文,所以我搞成原创标题了。。。。

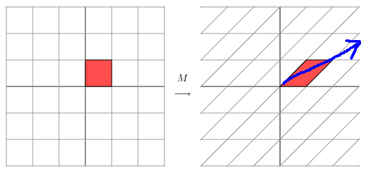

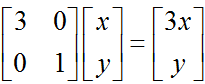

一、特征值与特征向量的几何意义 1. 矩阵乘法 在介绍特征值与特征向量的几何意义之前,先介绍矩阵乘法的几何意义。 矩阵乘法对应了一个变换,是把任意一个向量变成另一个方向或长度的新向量。在这个变化过程中,原向量主要发生旋转、伸缩的变化。如果矩阵对某些向量只发生伸缩变换,不产生旋转效果,那么这些向量就称为这个矩阵的特征向量,伸缩的比例就是特征值。 比如:

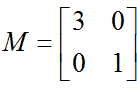

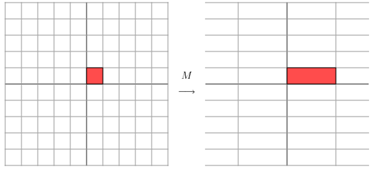

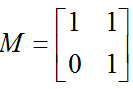

因为,这个矩阵乘以一个向量(x,y)的结果是: 那么如果矩阵M不是对称的,比如:

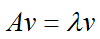

这其实是在平面上对一个轴进行的拉伸变换【如蓝色箭头所示】,在图中蓝色箭头是一个最主要的变化方向。变化方向可能有不止一个,但如果我们想要描述好一个变换,那我们就描述好这个变换主要的变化方向就好了。 2. 特征值分解与特征向量 如果说一个向量v是方阵A的特征向量,将一定可以表示成下面的形式:

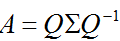

λ为特征向量 v 对应的特征值。特征值分解是将一个矩阵分解为如下形式: 其中,Q是这个矩阵A的特征向量组成的矩阵,Σ是一个对角矩阵,每一个对角线元素就是一个特征值,里面的特征值是由大到小排列的,这些特征值所对应的特征向量就是描述这个矩阵变化方向(从主要的变化到次要的变化排列)。也就是说矩阵A的信息可以由其特征值和特征向量表示。 对于矩阵为高维的情况下,那么这个矩阵就是高维空间下的一个线性变换。可以想象,这个变换也同样有很多的变换方向,我们通过特征值分解得到的前N个特征向量,那么就对应了这个矩阵最主要的N个变化方向。我们利用这前N个变化方向,就可以近似这个矩阵(变换)。 总结一下,特征值分解可以得到特征值与特征向量,特征值表示的是这个特征到底有多重要,而特征向量表示这个特征是什么。不过,特征值分解也有很多的局限,比如说变换的矩阵必须是方阵。

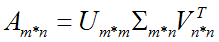

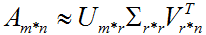

二、奇异值分解 1. 奇异值 特征值分解是一个提取矩阵特征很不错的方法,但是它只是对方阵而言的,在现实的世界中,我们看到的大部分矩阵都不是方阵,比如说有N个学生,每个学生有M科成绩,这样形成的一个N * M的矩阵就不可能是方阵,我们怎样才能描述这样普通的矩阵呢的重要特征呢?奇异值分解可以用来干这个事情,奇异值分解是一个能适用于任意的矩阵的一种分解的方法:分解形式: 假设A是一个M * N的矩阵,那么得到的U是一个M * M的方阵(称为左奇异向量),Σ是一个M * N的矩阵(除了对角线的元素都是0,对角线上的元素称为奇异值),VT(V的转置)是一个N * N的矩阵(称为右奇异向量)。

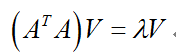

2. 奇异值与特征值 那么奇异值和特征值是怎么对应起来的呢?我们将一个矩阵A的转置乘以 A,并对(AA T)求特征值,则有下面的形式:

这里V就是上面的右奇异向量,另外还有: 这里的σ就是奇异值,u就是上面说的左奇异向量。【证明那个哥们也没给】 奇异值σ跟特征值类似,在矩阵Σ中也是从大到小排列,而且σ的减少特别的快,在很多情况下,前10%甚至1%的奇异值的和就占了全部的奇异值之和的99%以上了。也就是说,我们也可以用前r( r远小于m、n )个的奇异值来近似描述矩阵,即部分奇异值分解: 右边的三个矩阵相乘的结果将会是一个接近于A的矩阵,在这儿,r越接近于n,则相乘的结果越接近于A。

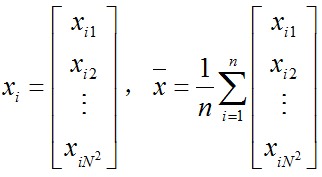

三、PCA主成份分析 主成分分析(PrincipalComponents Analysis。即PCA,也称为K-L变换),是图像压缩中的一种最优正交变换。PCA用于统计特征提取构成了子空间法模式识别的基础。它从图像整体代数特征出发,基于图像的总体信息进行分类识别。PCA的核心思想是利用较少数量的特征对样本进行描述以达到降低特征空间维数的目的。 1. PCA理论 给定一副N*N大小图像,将它表示成一个N2*1维向量,向量中元素为像素点灰度,按行存储,如下列公式分别表示第i张图片和n张图片平均值:

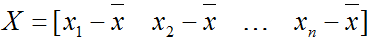

令N2*n矩阵X为:

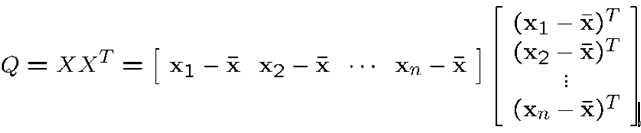

注意,矩阵减去平均值相当于将坐标系原点移动到平均值位置。 设Q=XXT,则Q是一个N2* N2矩阵:

,Q是方阵 ,Q是对称矩阵。 ,Q被成为协方差矩阵, ,Q的数据量非常庞大 那么,X中的每个元素xj可以被如下表达:

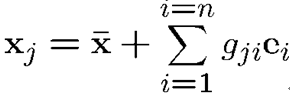

其中,ei是Q中非零特征值对应的特征向量。由特征向量e1,e2,…,en组成的空间叫做张成特征空间。对于N*N图像,e1,e2,…,en是N2*1维相互正交的向量。尺度gji是xj在空间中的坐标。

2. 实现PCA 为了降维,可以对特征值设定阈值或按照其他准则,寻找协方差矩阵Q中前k个特征向量。这里Q十分庞大,对于一副256*256的图像,Q的大小为65536*65536!替代方案是,考虑矩阵

.P和Q都是对称矩阵 .P≠QT .Q的大小是N2*N2,而P大小为n*n .n为训练样本图像数量,通常n |

【本文地址】

,它对应的线性变换是下面的形式形式:

,它对应的线性变换是下面的形式形式:

。由于矩阵M是对称的,所以这个变换是一个对 x , y 轴的一个拉伸变换。【当M中元素值大于1时,是拉伸;当值小于1时,是缩短】

。由于矩阵M是对称的,所以这个变换是一个对 x , y 轴的一个拉伸变换。【当M中元素值大于1时,是拉伸;当值小于1时,是缩短】  ,它所描述的变换如下图所示:

,它所描述的变换如下图所示: