基于卷积神经网络的目标分类案例 |

您所在的位置:网站首页 › 卷积层与池化层的区别 › 基于卷积神经网络的目标分类案例 |

基于卷积神经网络的目标分类案例

|

一、卷积神经网络(CNN)

卷积神经网络(Convolutional Neural Networks, CNN)是一类包含卷积计算且具有深度结构的前馈神经网络(Feedforward Neural Networks),是深度学习(deep learning)的代表算法之一。顾名思义,就是将卷积与前馈神经网络结合,所衍生出来的一种深度学习算法。

1.1 卷积

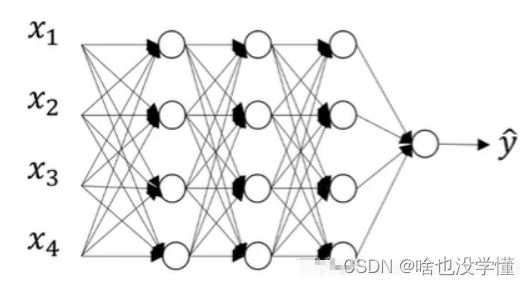

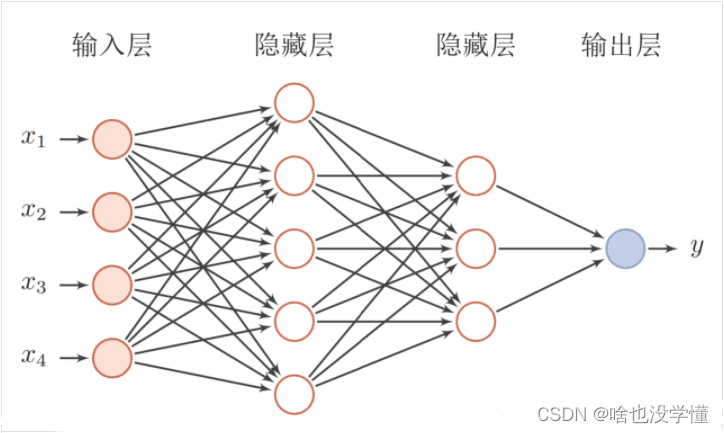

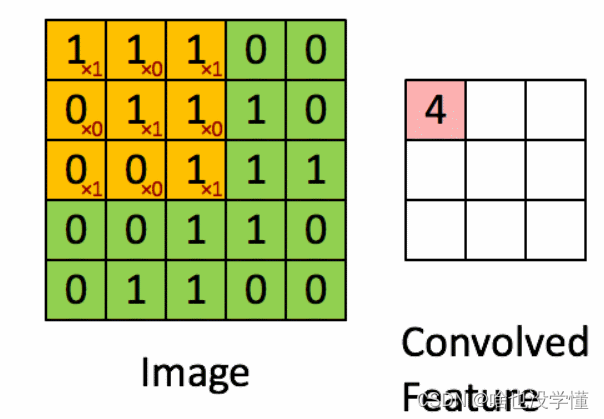

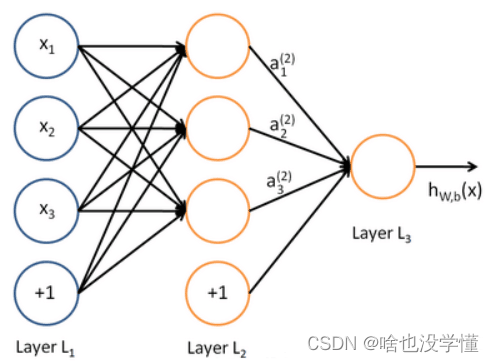

简单定义:设f ( x ) , g ( x )是R1上的两个可积函数,作积分: 称为函数f与g的卷积,记为:f ( x ) ∗ g ( x ) = h ( x ) 卷积与傅里叶变换有着密切的关系:两函数的傅里叶变换的乘积 = 它们卷积后的傅里叶变换(能简化傅里叶分析) h ( x )要比f ( x )、g ( x )更光滑:特别当g ( x )为具有紧致集的光滑函数,f ( x )为局部可积时,它们的卷积h ( x )也是光滑函数;利用这一性质,对于任意的可积函数f ( x ),都可以简单地构造出一列逼近于f ( x )的光滑函数列fs,这种方法称为函数的光滑化或正则化。 卷积的概念还可以推广到数列、测度以及广义函数上去。 1.2 前馈神经网络 前馈神经网络是一种最简单的神经网络,各神经元分层排列。每个神经元只与前一层的神经元相连。接收前一层的输出,并输出给下一层.各层间没有反馈。其中每一层包含若干个神经元,各神经元可以接收前一层神经元的信号,并产生输出到下一层。第0层叫输入层,最后一层叫输出层,其他中间层叫做隐含层(或隐藏层、隐层),隐层可以是一层。也可以是多层。一个典型的多层前馈神经网络如下图所示: 1.3 卷积神经网络(CNN)

卷积神经网络是在前馈神经网络的隐藏层做的改变,它的隐藏层包括卷积层、池化层、全连接层三部分。 ①卷积层

1.3 卷积神经网络(CNN)

卷积神经网络是在前馈神经网络的隐藏层做的改变,它的隐藏层包括卷积层、池化层、全连接层三部分。 ①卷积层

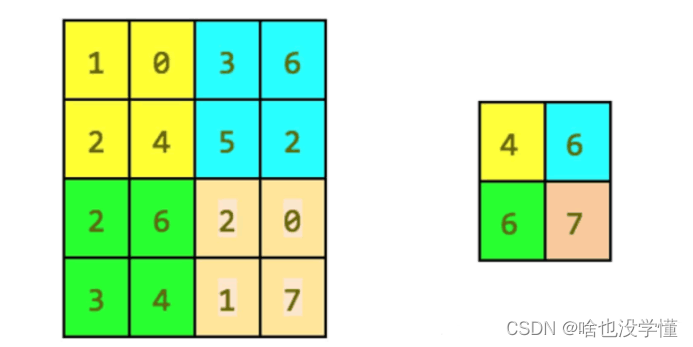

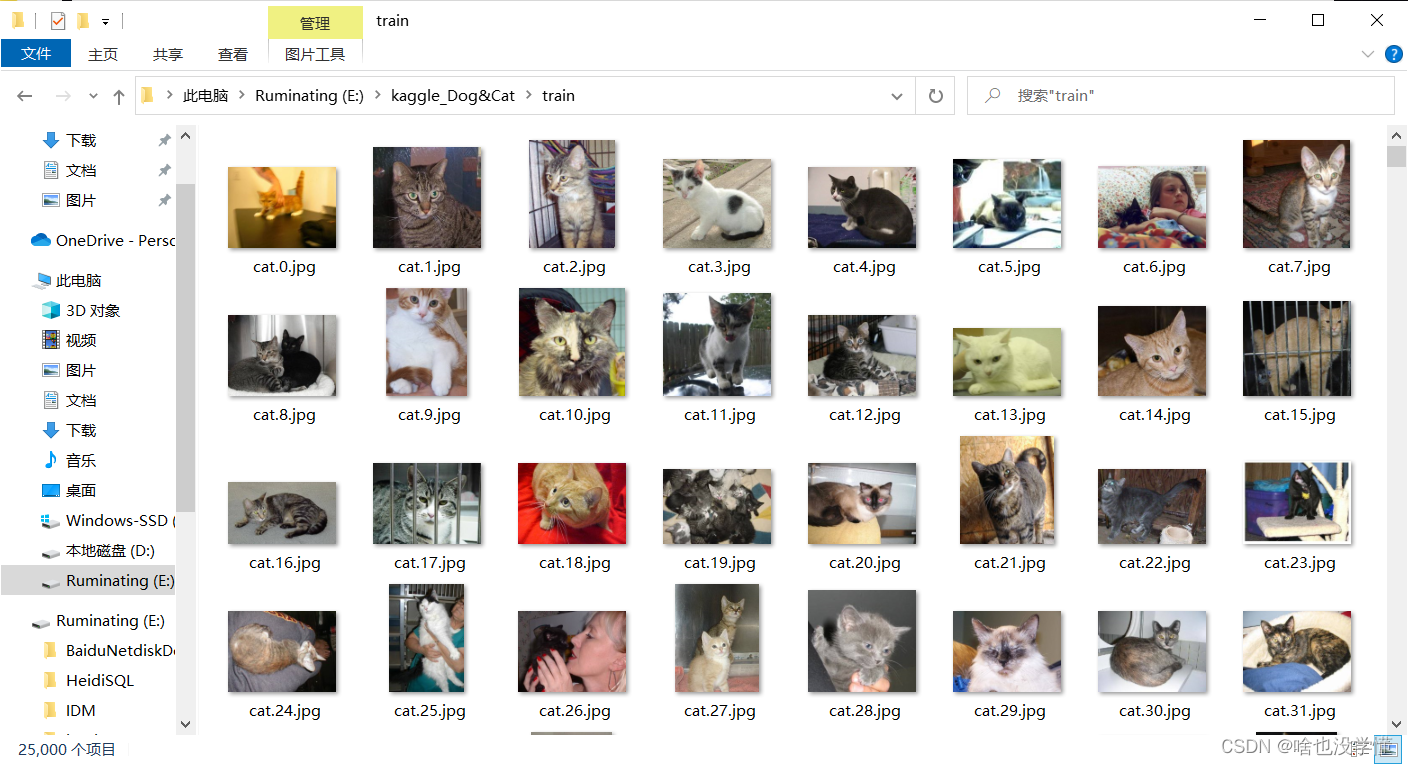

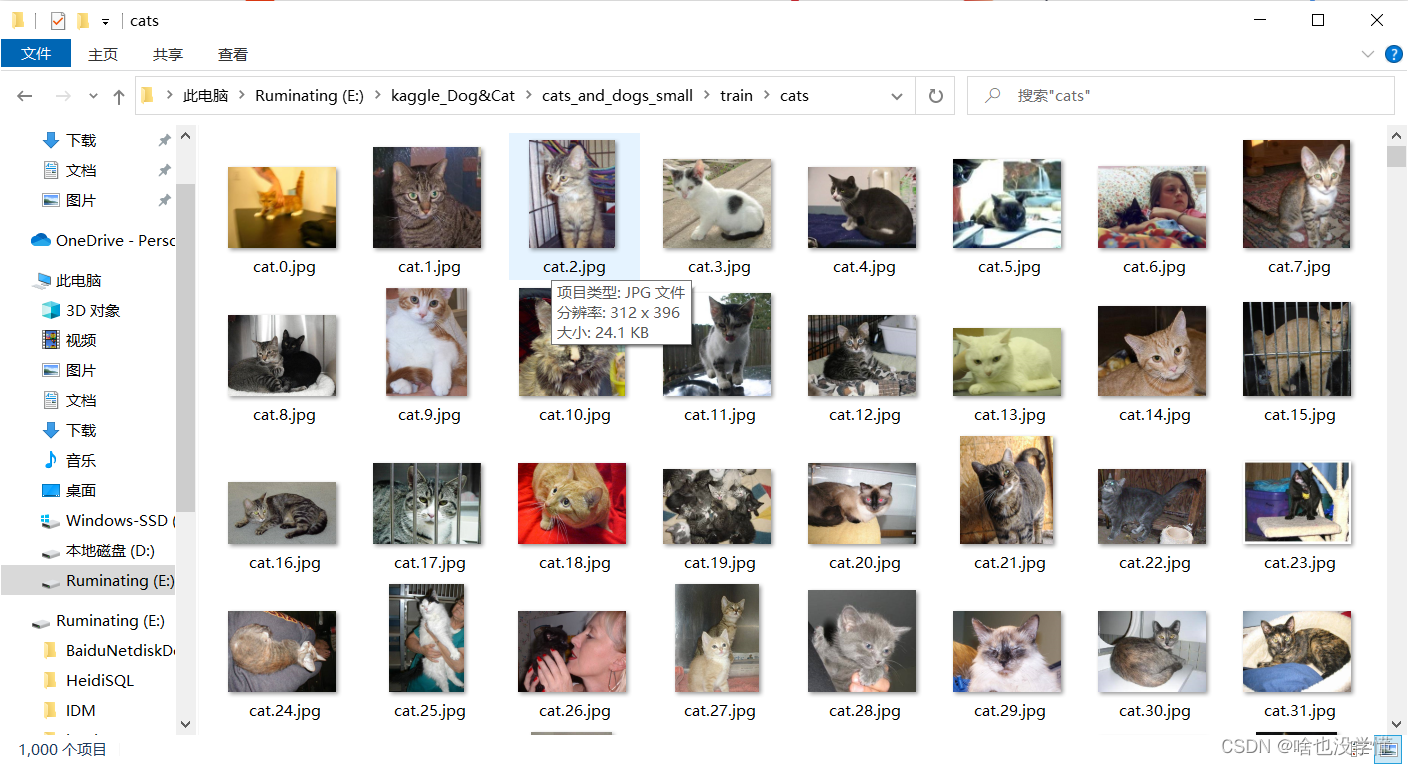

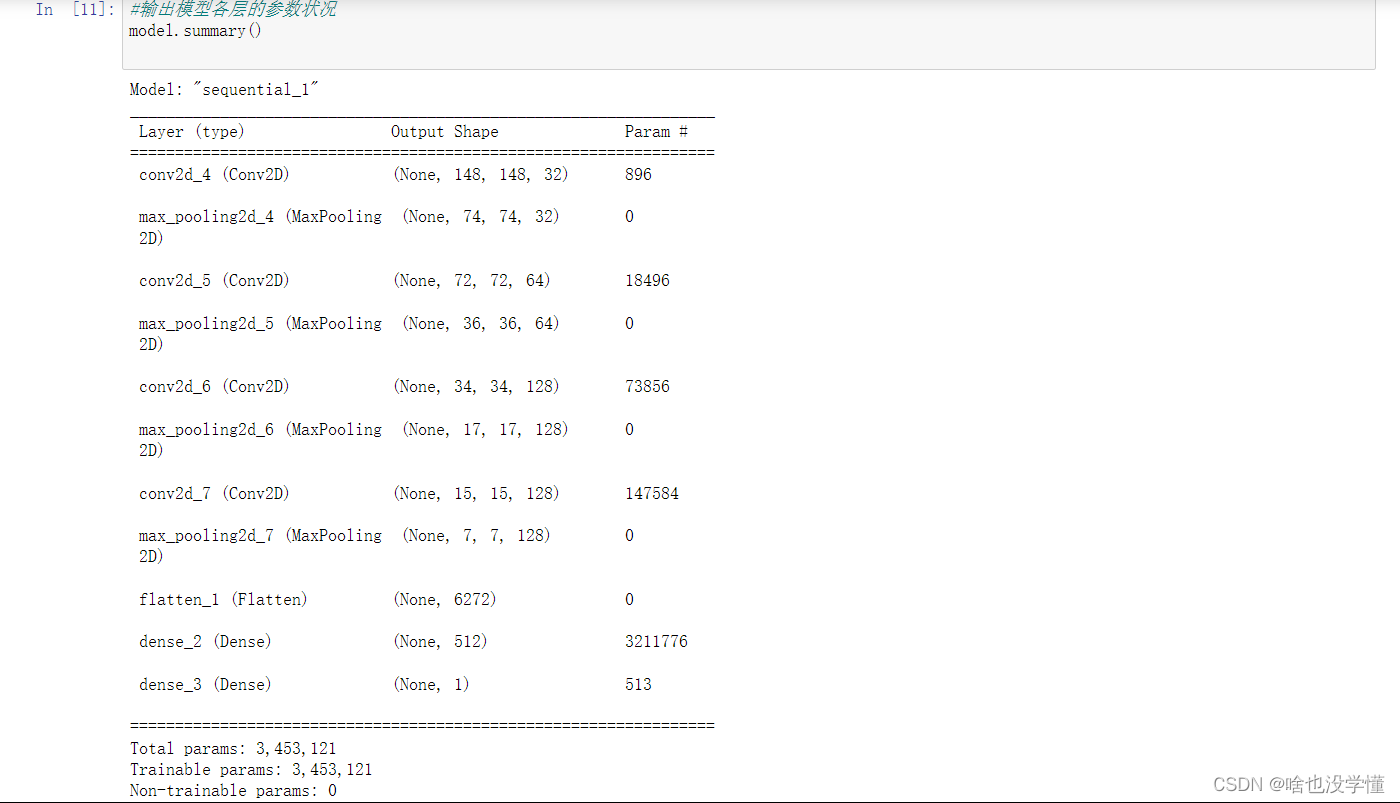

上面图中是33的卷积核(卷积核一般采用33和2*2 )与上一层的结果(输入层)进行卷积的过程 ②池化层 最大池化,它只是输出在区域中观察到的最大输入值 均值池化,它只是输出在区域中观察到的平均输入值 两者最大区别在于卷积核的不同(池化是一种特殊的卷积过程) ③全连接层 全连接过程,跟神经网络一样,就是每个神经元与上一层的所有神经元相连 二、猫狗数据分类建模 2.1 猫狗图像预处理 对猫狗图像进行分类,代码如下: import tensorflow as tf import keras import os, shutil # 原始目录所在的路径 original_dataset_dir = 'E:\\kaggle_Dog&Cat\\train' # 数据集分类后的目录 base_dir = 'E:\\kaggle_Dog&Cat\\cats_and_dogs_small' os.mkdir(base_dir) # # 训练、验证、测试数据集的目录 train_dir = os.path.join(base_dir, 'train') os.mkdir(train_dir) validation_dir = os.path.join(base_dir, 'validation') os.mkdir(validation_dir) test_dir = os.path.join(base_dir, 'test') os.mkdir(test_dir) # 猫训练图片所在目录 train_cats_dir = os.path.join(train_dir, 'cats') os.mkdir(train_cats_dir) # 狗训练图片所在目录 train_dogs_dir = os.path.join(train_dir, 'dogs') os.mkdir(train_dogs_dir) # 猫验证图片所在目录 validation_cats_dir = os.path.join(validation_dir, 'cats') os.mkdir(validation_cats_dir) # 狗验证数据集所在目录 validation_dogs_dir = os.path.join(validation_dir, 'dogs') os.mkdir(validation_dogs_dir) # 猫测试数据集所在目录 test_cats_dir = os.path.join(test_dir, 'cats') os.mkdir(test_cats_dir) # 狗测试数据集所在目录 test_dogs_dir = os.path.join(test_dir, 'dogs') os.mkdir(test_dogs_dir) # 将前1000张猫图像复制到train_cats_dir fnames = ['cat.{}.jpg'.format(i) for i in range(1000)] for fname in fnames: src = os.path.join(original_dataset_dir, fname) dst = os.path.join(train_cats_dir, fname) shutil.copyfile(src, dst) # 将下500张猫图像复制到validation_cats_dir fnames = ['cat.{}.jpg'.format(i) for i in range(1000, 1500)] for fname in fnames: src = os.path.join(original_dataset_dir, fname) dst = os.path.join(validation_cats_dir, fname) shutil.copyfile(src, dst) # 将下500张猫图像复制到test_cats_dir fnames = ['cat.{}.jpg'.format(i) for i in range(1500, 2000)] for fname in fnames: src = os.path.join(original_dataset_dir, fname) dst = os.path.join(test_cats_dir, fname) shutil.copyfile(src, dst) # 将前1000张狗图像复制到train_dogs_dir fnames = ['dog.{}.jpg'.format(i) for i in range(1000)] for fname in fnames: src = os.path.join(original_dataset_dir, fname) dst = os.path.join(train_dogs_dir, fname) shutil.copyfile(src, dst) # 将下500张狗图像复制到validation_dogs_dir fnames = ['dog.{}.jpg'.format(i) for i in range(1000, 1500)] for fname in fnames: src = os.path.join(original_dataset_dir, fname) dst = os.path.join(validation_dogs_dir, fname) shutil.copyfile(src, dst) # 将下500张狗图像复制到test_dogs_dir fnames = ['dog.{}.jpg'.format(i) for i in range(1500, 2000)] for fname in fnames: src = os.path.join(original_dataset_dir, fname) dst = os.path.join(test_dogs_dir, fname) shutil.copyfile(src, dst)分类前: 1.构建网络模型 #网络模型构建 from keras import layers from keras import models #keras的序贯模型 model = models.Sequential() #卷积层,卷积核是3*3,激活函数relu model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(150, 150, 3))) #最大池化层 model.add(layers.MaxPooling2D((2, 2))) #卷积层,卷积核2*2,激活函数relu model.add(layers.Conv2D(64, (3, 3), activation='relu')) #最大池化层 model.add(layers.MaxPooling2D((2, 2))) #卷积层,卷积核是3*3,激活函数relu model.add(layers.Conv2D(128, (3, 3), activation='relu')) #最大池化层 model.add(layers.MaxPooling2D((2, 2))) #卷积层,卷积核是3*3,激活函数relu model.add(layers.Conv2D(128, (3, 3), activation='relu')) #最大池化层 model.add(layers.MaxPooling2D((2, 2))) #flatten层,用于将多维的输入一维化,用于卷积层和全连接层的过渡 model.add(layers.Flatten()) #全连接,激活函数relu model.add(layers.Dense(512, activation='relu')) #全连接,激活函数sigmoid model.add(layers.Dense(1, activation='sigmoid'))

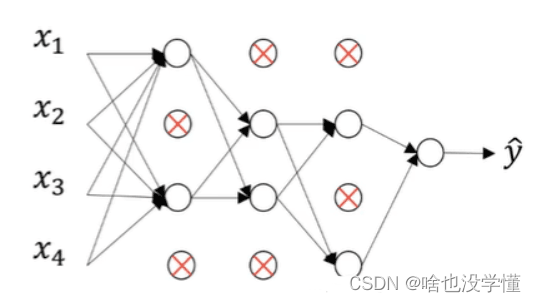

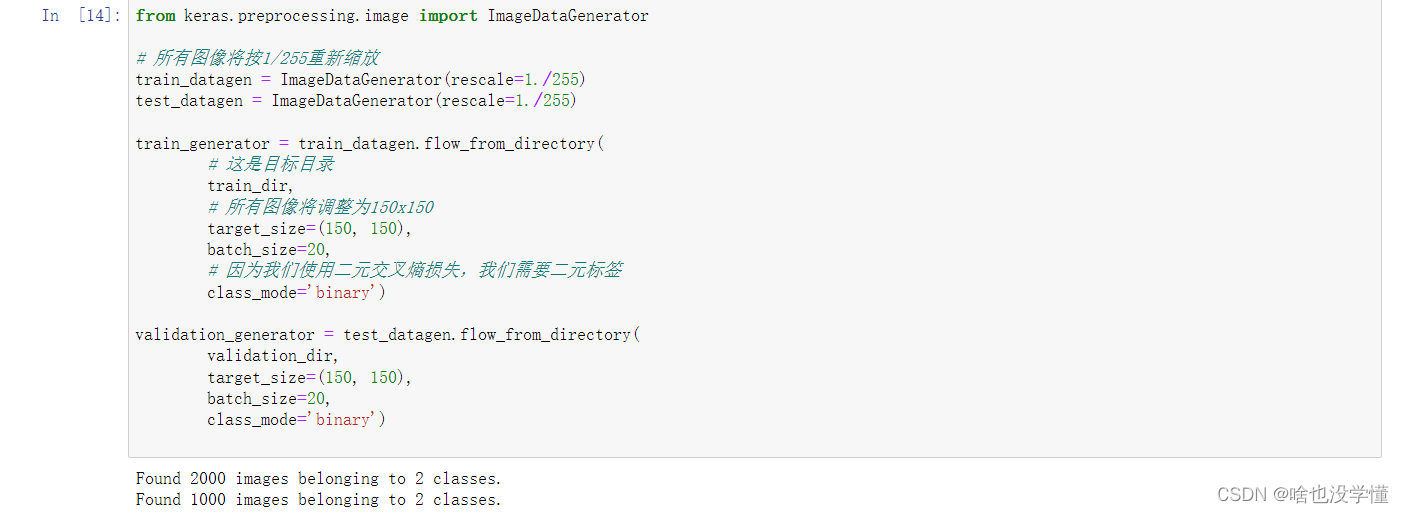

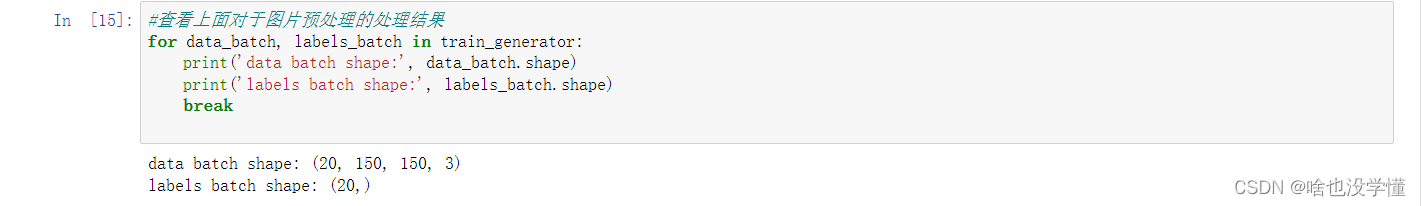

文件中图像转换成所需格式 将训练和验证的图片,调整为150*150 from keras.preprocessing.image import ImageDataGenerator # 所有图像将按1/255重新缩放 train_datagen = ImageDataGenerator(rescale=1./255) test_datagen = ImageDataGenerator(rescale=1./255) train_generator = train_datagen.flow_from_directory( # 这是目标目录 train_dir, # 所有图像将调整为150x150 target_size=(150, 150), batch_size=20, # 因为我们使用二元交叉熵损失,我们需要二元标签 class_mode='binary') validation_generator = test_datagen.flow_from_directory( validation_dir, target_size=(150, 150), batch_size=20, class_mode='binary')

图像增强 利用图像生成器定义一些常见的图像变换,图像增强就是通过对于图像进行变换,从而,增强图像中的有用信息。 #该部分代码及以后的代码,用于替代基准模型中分类后面的代码(执行代码前,需要先将之前分类的目录删掉,重写生成分类,否则,会发生错误) from keras.preprocessing.image import ImageDataGenerator datagen = ImageDataGenerator( rotation_range=40, width_shift_range=0.2, height_shift_range=0.2, shear_range=0.2, zoom_range=0.2, horizontal_flip=True, fill_mode='nearest')①rotation_range 一个角度值(0-180),在这个范围内可以随机旋转图片 ②width_shift和height_shift 范围(作为总宽度或高度的一部分),在其中可以随机地垂直或水平地转换图片 ③shear_range 用于随机应用剪切转换 ④zoom_range 用于在图片内部随机缩放 ⑤horizontal_flip 用于水平随机翻转一半的图像——当没有假设水平不对称时(例如真实世界的图片) ⑥fill_mode 用于填充新创建像素的策略,它可以在旋转或宽度/高度移动之后出现 查看增强后的图像 import matplotlib.pyplot as plt # This is module with image preprocessing utilities from keras.preprocessing import image fnames = [os.path.join(train_cats_dir, fname) for fname in os.listdir(train_cats_dir)] # We pick one image to "augment" img_path = fnames[3] # Read the image and resize it img = image.load_img(img_path, target_size=(150, 150)) # Convert it to a Numpy array with shape (150, 150, 3) x = image.img_to_array(img) # Reshape it to (1, 150, 150, 3) x = x.reshape((1,) + x.shape) # The .flow() command below generates batches of randomly transformed images. # It will loop indefinitely, so we need to `break` the loop at some point! i = 0 for batch in datagen.flow(x, batch_size=1): plt.figure(i) imgplot = plt.imshow(image.array_to_img(batch[0])) i += 1 if i % 4 == 0: break plt.show()网络模型增加一层dropou #网络模型构建 from keras import layers from keras import models #keras的序贯模型 model = models.Sequential() #卷积层,卷积核是3*3,激活函数relu model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(150, 150, 3))) #最大池化层 model.add(layers.MaxPooling2D((2, 2))) #卷积层,卷积核2*2,激活函数relu model.add(layers.Conv2D(64, (3, 3), activation='relu')) #最大池化层 model.add(layers.MaxPooling2D((2, 2))) #卷积层,卷积核是3*3,激活函数relu model.add(layers.Conv2D(128, (3, 3), activation='relu')) #最大池化层 model.add(layers.MaxPooling2D((2, 2))) #卷积层,卷积核是3*3,激活函数relu model.add(layers.Conv2D(128, (3, 3), activation='relu')) #最大池化层 model.add(layers.MaxPooling2D((2, 2))) #flatten层,用于将多维的输入一维化,用于卷积层和全连接层的过渡 model.add(layers.Flatten()) #退出层 model.add(layers.Dropout(0.5)) #全连接,激活函数relu model.add(layers.Dense(512, activation='relu')) #全连接,激活函数sigmoid model.add(layers.Dense(1, activation='sigmoid')) #输出模型各层的参数状况 model.summary() from keras import optimizers model.compile(loss='binary_crossentropy', optimizer=optimizers.RMSprop(lr=1e-4), metrics=['acc']) 五、数据增强 什么是数据增强? 项目Value旋转 /反射变换(Rotation/reflection)随机旋转图像一定角度; 改变图像内容的朝向翻转变换(flip)沿着水平或者垂直方向翻转图像缩放变换(zoom)按照一定的比例放大或者缩小图像平移变换(shift)在图像平面上对图像以一定方式进行平移;可以采用随机或人为定义的方式指定平移范围和平移步长, 沿水平或竖直方向进行平移. 改变图像内容的位置尺度变换(scale)对图像按照指定的尺度因子,进行放大或缩小;或者参照SIFT特征提取思想,利用指定的尺度因子对图像滤波构造尺度空间;改变图像内容的大小或模糊程度对比度变换(contrast)在图像的HSV颜色空间,改变饱和度S和V亮度分量,保持色调H不变;对每个像素的S和V分量进行指数运算(指数因子在0.25到4之间),增加光照变化噪声扰动(noise)对图像的每个像素RGB进行随机扰动, 常用的噪声模式是椒盐噪声和高斯噪声颜色变化在图像通道上添加随机扰动颜色变化在图像通道上添加随机扰动输入图像随机选择一块区域涂黑参考《Random Erasing Data Augmentation》 六、dropout 层 什么是dropout层?Dropout层在神经网络层当中是用来干嘛的呢?它是一种可以用于减少神经网络过拟合的结构,那么它具体是怎么实现的呢? 假设下图是我们用来训练的原始神经网络: 一共有四个输入 x i ,一个输出 y。Dropout 则是在每一个 batch 的训练当中随机减掉一些神经元,而作为编程者,我们可以设定每一层 dropout(将神经元去除的的多少)的概率,在设定之后,就可以得到第一个 batch 进行训练的结果: 从上图我们可以看到一些神经元之间断开了连接,因此它们被 dropout 了!dropout顾名思义就是被拿掉的意思,正因为我们在神经网络当中拿掉了一些神经元,所以才叫做 dropout 层。 参考博客:https://blog.csdn.net/ssj925319/article/details/117787737 https://blog.csdn.net/qq_43279579/article/details/117298169 |

【本文地址】

今日新闻 |

推荐新闻 |

分类后:

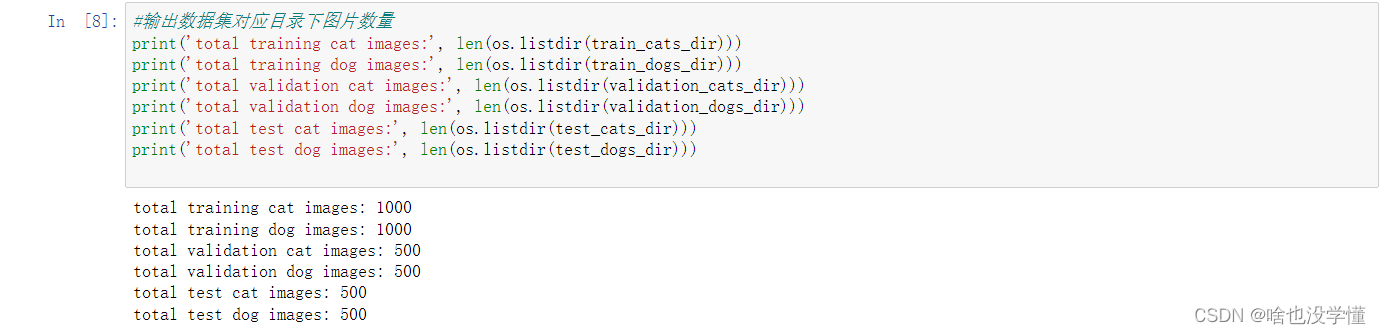

分类后:  查看分类后,对应目录下图片数量

查看分类后,对应目录下图片数量

配置训练方法

配置训练方法 查看处理结果

查看处理结果 模型训练并保存生成的模型

模型训练并保存生成的模型