ker矩阵是什么意思 |

您所在的位置:网站首页 › 主对角占优是什么意思 › ker矩阵是什么意思 |

ker矩阵是什么意思

在上一篇文章中,空间变换和基变换已经被详细讨论过了。特别是基变换,从两个角度看待它对理解特征值分解和奇异值分解会起到很大的帮助。 阿姆斯特朗:矩阵分析(一):空间变换与基变换zhuanlan.zhihu.com 一、特征值与特征向量

一、特征值与特征向量

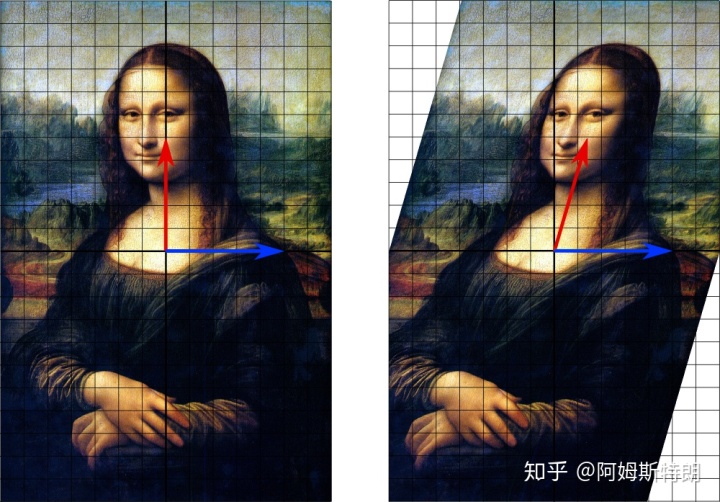

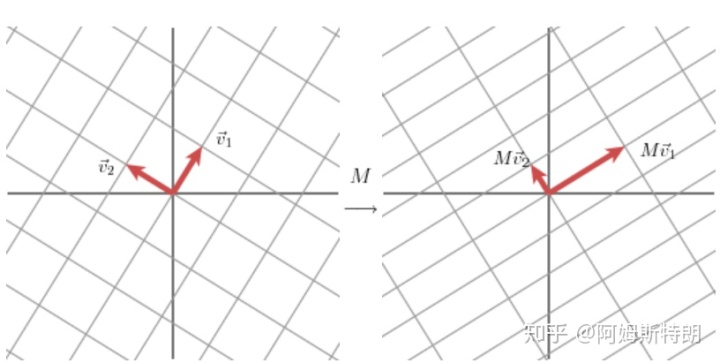

上一节谈到了形如 对于一些变换来说,选择合适的基向量,那么变换相当于只有伸缩没有旋转,那么 如下图,变换后,蓝色向量及于其平行的向量都没有改变方向,只有伸缩,那么蓝色向量就是其中一个特征向量,1是对应的特征值(长度没变)。而红色向量则不是特征向量,因为发生了旋转。但是这个剪切变换无法进行特征值分解,因为只有“一个”特征向量不能张成这个二维平面。

只有在一定条件下(如其矩阵形式为实对称矩阵的线性变换),一个变换可以由其特征值和特征向量完全表述,也就是说:所有的特征向量组成了这向量空间的一组基底。 如下图中,变换矩阵为 也就是

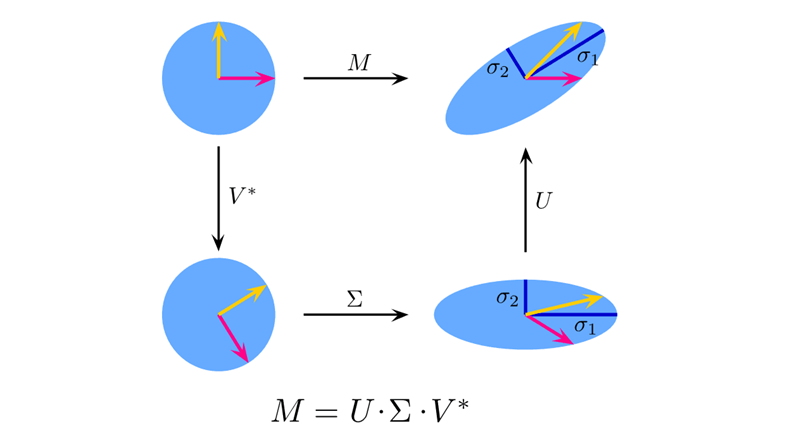

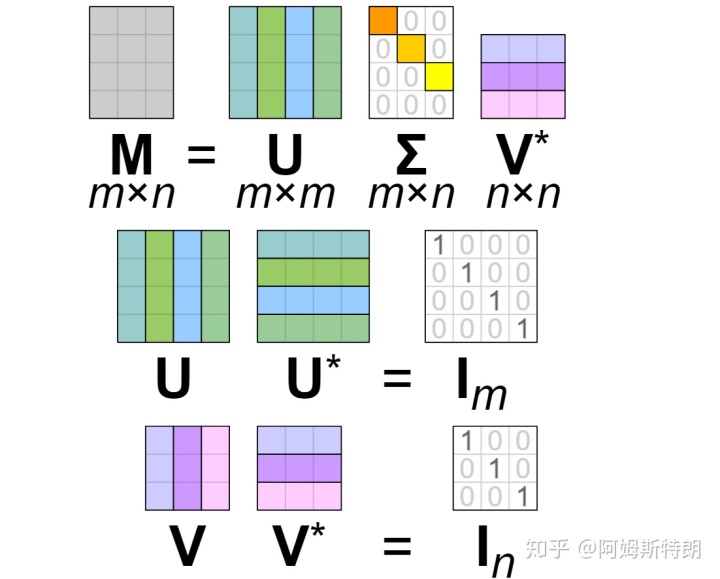

而特征值不仅仅存在于线性代数,在解方程以及信号处理中都有很大的意义。毕竟寻找特征向量其实就是寻找变换或者函数中固有的量或者不变量,它们能代表一些本质的东西。例如信号处理中傅里叶变换用 特征值分解又称为矩阵对角化,但是不是所有的矩阵都可以对角化。谱定理描述了什么样的矩阵可以被对角化。 二、奇异值分解SVD上文中提到过,有些矩阵不能被特征值分解。那么SVD就是一种广义的特征值分解。它可以对任何 以2*2实矩阵为例。若变换

若选择 而因为单位正交向量 所以 而根据我前面所写,  三、对SVD的两种理解

从矩阵分解的角度

三、对SVD的两种理解

从矩阵分解的角度

直接观察

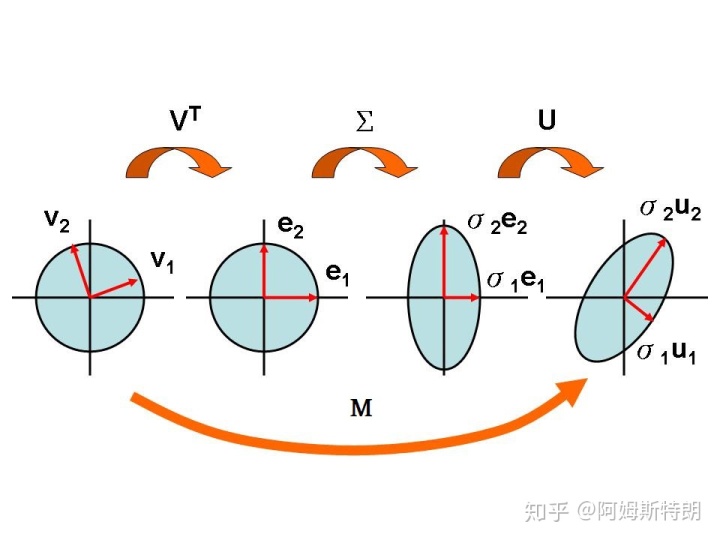

这三个变换都是有意义的。第一个变换  从基变换的角度理解

从基变换的角度理解

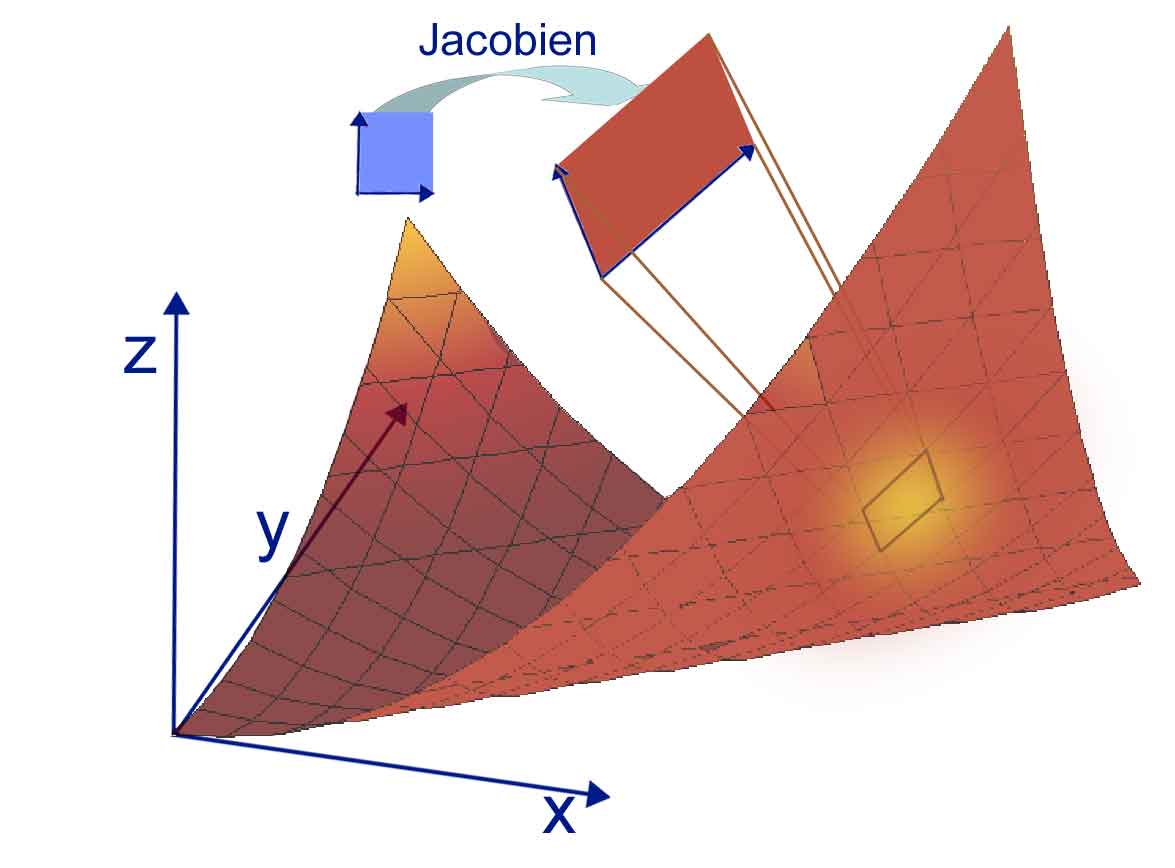

特征值分解是一种基变换。而观察特征值分解与奇异值分解的形式,可以看到它们之间很相似。 特征值分解: 奇异值分解: 其实奇异值分解也可以视作是一种特征值分解。 所以说,也可以认为奇异值分解将标准正交基下的向量变为了在 若是考虑在原空间选择一组基,在像空间选择另一组基,那么就有以下: 引用wiki上的几何意义:因为U和V都是酉的,我们知道U的列向量u1,...,um组成了 矩阵 这样,SVD分解的几何意义就可以做如下的归纳:对于每一个线性映射 如果你觉得有收获,就点个赞吧! 参考: [1]https://en.wikipedia.org/wiki/Eigenvalues_and_eigenvectors [2]https://en.wikipedia.org/wiki/Singular_value_decomposition#Geometric_meaning [3]Feature Column from the AMS |

【本文地址】