全景视频/VR的全流程处理解析 |

您所在的位置:网站首页 › vr全景拍摄流程图片 › 全景视频/VR的全流程处理解析 |

全景视频/VR的全流程处理解析

|

本文由以下资料整理汇总而成: 5G高新技术—VR视频技术白皮书-2020基于视场的沉浸式视频质量建模及应用面向视窗依赖机制的全景视频传输优化研究_谢绍伟全景视频的投影转换及编码_于宁全景视频的质量评价和编码优化_陈思佳全景视频拼接关键技术研究_蓝先迪 1. 完整流程

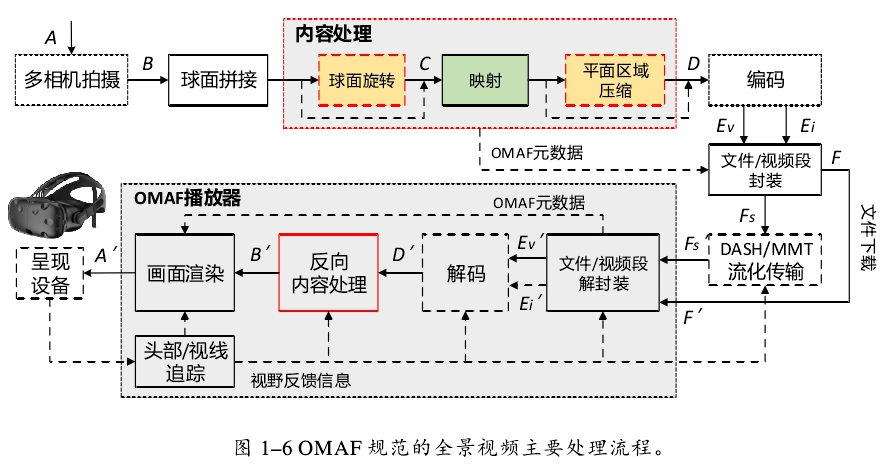

2015 年 10 月,MPEG 发起了面向全景视频封装格式的标准化工作,称作全方向媒体格式(Omnidirectional MediA Format,OMAF),由来自世界各地高新企业、研究机构、高等院校的专家共同参与制定。 OMAF 标准中规定,服务器端拼接的全景视频在经过内容预处理、编码及封装过程后,可以通过 DASH 或 MPEG 媒体传送协议流化传输。OMAF 播放器一方面可以接收、解析并呈现相关的媒体内容,另一方面需要追踪用户头动、眼动等交互操作,以便实时反馈视窗信息。 2. 拍摄

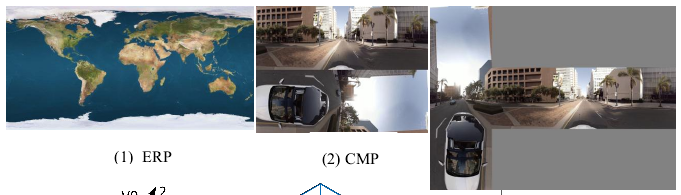

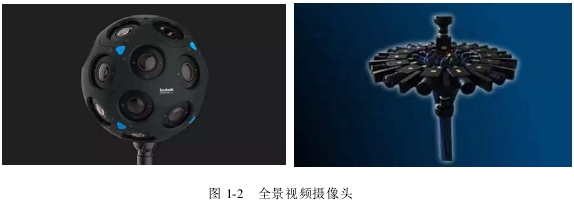

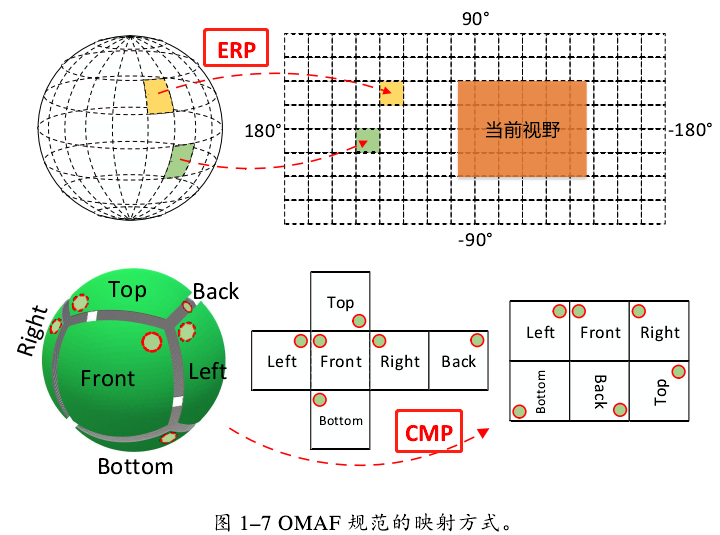

全景视频的采集需要依靠全景摄像机,如上图所示。全景摄像机具有多个镜头,覆盖当前场景全部视角,生成的视频分辨率越高,则需要摄像机具有越高的分辨率以及越多的镜头数量。 存在的主要问题: 视场角(Field of view,FOV) 视角FOV是指镜头所能覆盖的范围,(物体超过这个角就不会被收在镜头里),一个摄像机镜头能涵盖多大范围的景物,通常以角度来表示,这个角度就叫镜头的视角FOV。被 如果说有六台摄像机,它们的FOV角度被严格限定为水平和竖直都是90度,然后造一个一丝不苟的支架,把这六台摄像机牢固而稳定地安装到支架上,确保它们的中心点严格重合在一起,并且各自朝向一个方向——这样的话,输出的图像也许能够正好符合立方图的标准,并且可以直接使用。 然而,无论摄像机镜头的感光面积,焦距参数(以及由此得到的视场角),还是支架的钢体结构设计与制作,都无法确保精确地达到上面要求的参数。 mm量级的光学或者机械误差对于严丝合缝的立方体图像来说,必然会在最终呈现的沉浸式场景中留下一条或多条明显的裂缝 解决方法: 在拼接的地方留下足够大的冗余,然后正确识别和处理两台摄像机画面重合的区域。而这正是全景视频制作的下一步骤——拼接。 其他问题: 多个摄像头之间的同步性——“同步锁相”(genlock)的技术伪立体——比如将原来的6台相机改成12台相机,即每个方向都有左右眼两台相机负责拍摄。 3. 拼接详见:https://blog.csdn.net/shanghaiqianlun/article/details/12090595 常用的视频拼接算法可分为基于变换的图像拼接算法和基于拼接线的图像拼接算法。 基于变换的图像拼接算法的核心思想是通过对单应性矩阵进行调整,通过网格化的扭曲使重合区域拼接的缝隙尽可能减小,该算法适合小视角变换的情况。代表性算法有 AutoStitch、APAP、ANAP、GSP 等。 基于拼接线的图像拼接算法核心思想是通过对图像拼接线部分的重新调整,确保拼接的自然性,该算法适合大视角变换的情况。代表性算法有:Seam-Driven、Parallax-Tolerance 等 4. 投影/反投影为了达到全方位、沉浸式渲染效果,全景视频实际上是以球面形式呈现,然而其传输过程必须遵守现有的视频编码标准,即多相机拍摄的分视角视频在经过拼接后,需要映射成平面矩形帧 。 OMAF标准只支持经纬图映射ERP和立方体映射CMP。

存在的问题: 经纬图映射ERP:越靠近用户头顶或脚底的区域由于画面的拉伸失真越大。当基于空间分块方式传输 ERP 全景视频时,越靠近上下极点的视窗区域需要请求更多像素点(球面展开成ERP后,像素数增加了57%),即更大面积的分块视频,最终也会给网络带宽造成更大负担。立方体映射CMP:采用视窗依赖方式传输 CMP 全景视频时,由于单次映射过程只涉及六个离散区域,如果用户视窗横跨多个相邻的立方体面,则所需传输的媒体数据将会成倍增长。解决方案:引入球面旋转处理操作。

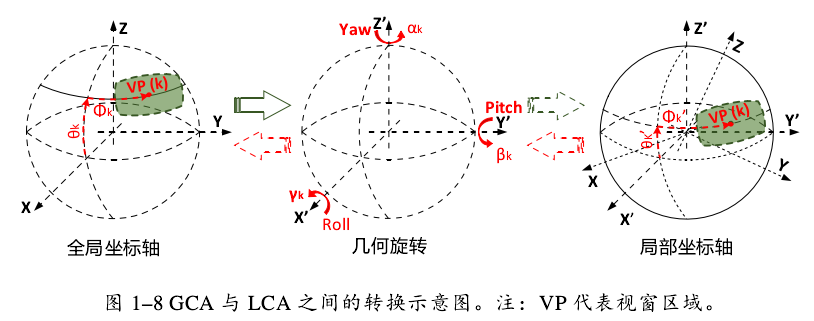

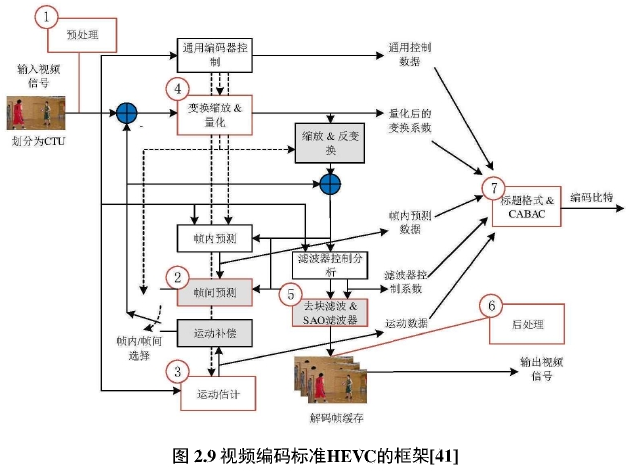

球面旋转通过改变原始坐标系偏航角、俯仰角和转动角(yaw、pitch 和 roll),能够在映射前将用户观看的任意视窗区域调整到ERP的赤道附近或CMP的一个面中,以便更高效地传输视窗内容。 存在的问题: 有很多映射方法都可以将全景视频投影成适用于当前编码器的二位平面格式。但是终端的显示设备一般不支持多种映射模型,因此在前端制作和传输分发过程中需要考虑各种不同终端的适配情况。 5. 编码/解码全景视频的编码与2D视频编码方法相似,都需要采用混合编码框架对序列进行压缩,但是全景视频高分辨率、高形变的特点又使其比2D视频编码面临更多困难。 5.1 传统视频编码标准尽管当前的视频编码标准日益多样化,但每个标准中都包含一些主要的模块:预测、变换、量化、熵编码和环路滤波。2013年,新一代视频编码标准HEVC发布。HEVC完全保留了主流基于块的视频编码标准中的模块,但是针对每个模块都进行了额外升级,这使得HEVC相对于它的前辈H.264能够在相同质量的前提下提升一倍编码效率。其框图如下图所示:  5.2 全景视频编码简介

5.2 全景视频编码简介

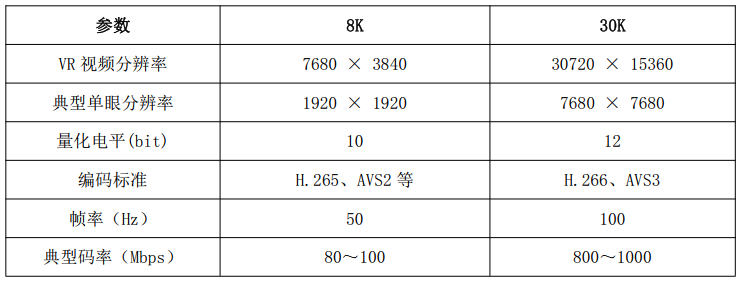

映射后的 VR 视频可采用普通视频的编码技术进行压缩。 码率是影响 VR 视频在终端接收观看清晰度的重要指标。8K/50P 的视频,采用H.265 或 AVS2 编码,码率需 80~100Mbps。 将传统编码方案直接用于全景视频带来的问题: 全景视频或多或少地存在不均匀采样,由此引入了几何失真。全景视频由球到面的投影增加了人工边界并导致不连续。以上两点都不利于编码效率。为了克服这些困难,研究者开发了各种专用于全景视频的编码工具,以在编码效率和视觉质量之间取得更好的折衷,这些工作可分为以下三类: 1)全景视频编码框架

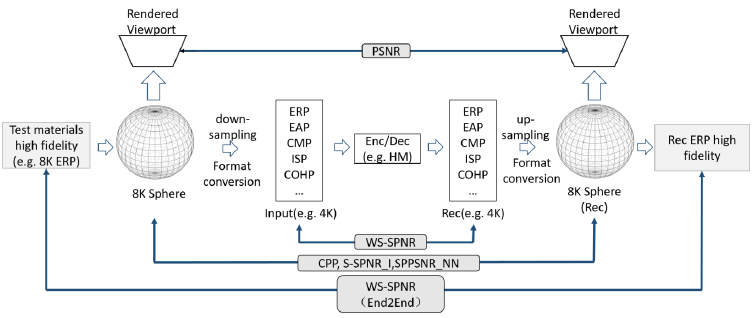

全景视频编码具体流程如下: 首先,输入的视频序列是以 ERP 格式保存的高保真测试材料,它们是视频质量评价的基础。ERP 投影视频首先被投影到球面。再通过下采样和投影格式转换,转换成指定格式的二维投影平面。经过上述投影转换后的二维视频作为传统视频编码框架的输入视频,利用现有的编解码器进行处理。通过传统编码框架输出的压缩后的视频,重新经过上采样和投影转换回到球面,再从球面投影成以 ERP 格式保存的高保真材料。 2)一些优化方案 - 针对投影特性的区域自适应平滑技术 出发点:ERP投影平面中,两个极点附近的区域要比球形区域中实际对应的区域大很多,而这些区域的变形则不那么重要。 方案:该技术在编码之前对 ERP 投影平面的顶部和底部区域进行平滑处理,经过平滑处理后的编码可以节省很多比特,因为平滑区域需要较少的变换系数来传输,并且几乎不会引起感知质量的下降。 存在的问题:难以推广到其他投影方式中。 率失真优化 通过分析球面上的失真变化并探讨其对率失真优化过程的影响,采用修改编码优化目标,实现了在球面上进行率失真优化。由于该算法是基于全景视频的质量评价指标的修改,因此可应用于各种投影,但是它使用的依然是基于像素变化的评价指标,不能很好地表示人的真实主观感受。 率失真优化理论 率失真优化的主要思想是同时考虑码率和失真度两方面因素, 在尽量降低失真的同时减少比特资源的消耗。

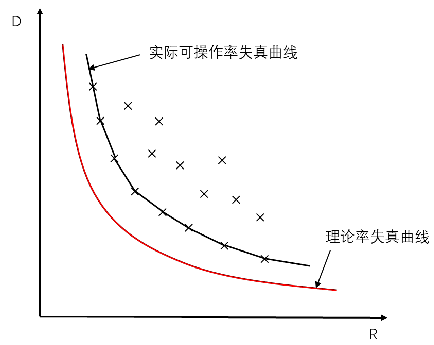

率失真函数 R(D) 的定义是假定信源在给定的情况下,在一定的失真范围内再现数据消息必须获取的最小平均互信信息,换句话说,就是在允许的失真内,数据可以压缩的最大程度。根据率失真理论,码率和失真的关系可以用一条下凸单调曲线来表示,称作率失真曲线。根据率失真曲线,对于给定的码率限制,可以直接得到最小的失真。 - 针对观察特性的Tang 等人提出了针对CMP和 ERP 的全景视频的两个优化指标。 第一个是内容自适应时间分辨率自适应方案,它通过动态分析 CMP 每一个投影面不同时间点的内容,来自适应地实时调节每一个投影面的帧率。 第二种是针对 ERP的自适应量化优化指标,它是根据观察者当前实际观察区域,对整个 ERP 图像不同区域分配不同的量化参数。 可伸缩视频编解码器 利用分层视频编码来传送流全景视频,降低视频冻结的可能性,用于降低比特率。 6. 封装/解封装目前,MPEG已发布了第一版全景媒体应用格式OMAF标准ISO/IEC 23090-2,该标准不仅定义了媒体格式,还定义了使用MMT、MPEG-DASH传送OMAF的内容的方法。 7. 流化传输 7.1 传输码率需求 7.2 传输方案

1)全视角传输方案

7.2 传输方案

1)全视角传输方案

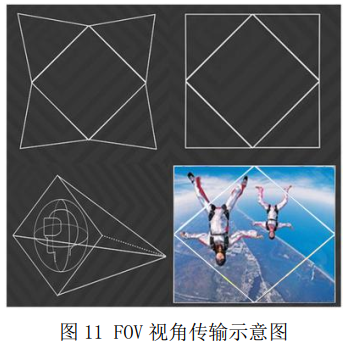

全视角传输方案就是将 360°环绕画面都传输给终端,当用户头部转动需要切换画面时,所有的处理都在终端本地完成。该方案码率需求非常大。 2)FOV传输方案该方案要求网络具有双向通信能力,因此,对于广播电视信道传输VR/AR视频时,基于视角的解决方法可能行不通,需要一次性将整个视频进行传输。 FOV 传输方案主要传输当前视角中的可见画面。一般都是将 360°全景视野划分为若干个视角,每个视角生成一个视频文件,只包含视角内高分辨率和周围部分低分辨率视觉信息,终端根据用户当前视角姿态位置,向服务器请求对应的视角文件。当头部转动视角发生变化时,终端向服务器请求新视角对应的视角文件。

以基于金字塔投影的 FOV 传输方案为例,如上图所示,将用户在虚拟环境中的视觉信息对应的全部球面数据放入金字塔投影。用户视点正前方的平面为 FOV平面,使用高分辨率编码,其余四个平面为非 FOV 平面,分辨率从与 FOV 平面相交的边到视角反方向的顶点逐渐降低。传输网络根据终端返回的用户视角信息,向终端提供 FOV 范围内的高质量画面和非 FOV 范围内的低质量画面。 7.3 传输架构

上图显示了两类的全景视频流框架: Pull based(客户端驱动): 将智能组件放在客户端,让客户决定想请求的视频块。Push based(服务器驱动): 由服务器决定要将哪段内容推送至客户端。单个组件的功能如下(部分略): Video Segmenter: 将编码后的视频分为多个片段,每个片段包含几个连续的视频帧,持续几秒钟。Video storage: 在服务器中存储已编码的视频帧,用于点播视频流。它可以存储多个不同视频质量等级的编码视频版本以支持自适应视频流。Orientation Extractor: 计算观看者的方向。Request Generator: 生成视频或视频片段的请求,根据框架类型的不同分别放置在不同位置。它往往是优化系统决策的核心组件。例如,可以在该组件中实现一种比特率分配算法,根据网络条件生成视频片段请求。Video renderer: 根据用户的方向计算视点,也可以转换投影模型。 1) Pull based在服务器端,360◦相机向视频编码器发送一个360◦视频。它在支持或不支持tile的情况下压缩该视频,并将编码后的视频发送给视频分割器。视频分割器将收到的视频分割成时间段,并(i)直接将这些段发送到视频流媒体,用于直播视频流;或(ii)将它们存储在视频存储器中,用于点播视频流。 在客户端,方向提取器不断记录观看者的方向,该方向是由HMD的传感器读数计算出来的。请求生成器考虑到当前的网络状况,同时可以将观看者的方向作为输入来生成请求。例如,自适应流媒体系统可以请求不同质量水平的视频片段或帧,而tiled视频流媒体系统可以根据观看者的方向跳过一些tile以节约带宽。 然后,服务器端的视频流媒体将来自视频分割器(直播视频)或来自视频存储(点播视频)的编码视频流向客户端。视频接收器将收到的视频传递给视频解码器。然后,视频解码器对编码的视频进行解码。视频渲染器根据观看者的方向对解码后的视频进行渲染。 优点: 支持DASH;不受NAT问题影响;可以方便地重用WWW架构,包含servers,caches和CDNs缺点: 分片的存储需要消耗大量的空间 更适合呈现式的视频流 2) Push based工作流程和Pull based的框架类似,只是Request Generator在服务器一侧。通常采用RTP作为传输协议, 优点: 采用RTP作为传输协议,低延时。 缺点: 需要流媒体服务器追踪潜在的众多客户端的状态。没有采用可靠的TCP协议,可能因为带宽不足、丢包、NAT穿越等问题造成视频质量的下降。更适合会话式的视频流 8. 播放 8.1 渲染渲染主要指根据用户头部姿态从全景视频中截取出用户当前应看到的画面,并根据HMD和VR眼镜的特性,对画面进行变形处理。

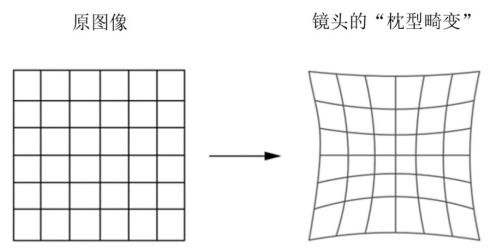

存在的问题:HMD 和 VR 眼镜的显示屏幕配合距离人眼只有 4~5cm 距离的凸透镜,达到增大 视角范围的效果。而正常的图像经过放大透镜后会产生枕形畸变。

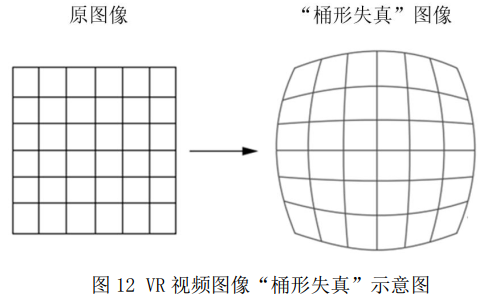

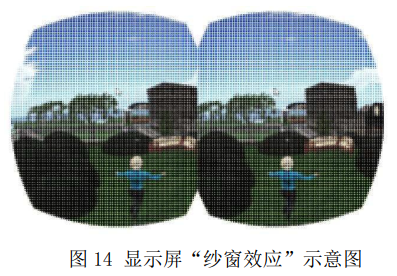

解决方案:应用软件预先对图像进行“桶形失真”变形处理,图像经透镜折射后,“桶形失真”与透镜折射引入的“枕形畸变”相互抵消,最终用户在 HMD 和 VR 眼镜里可看到正常的画面。 8.2 显示 1)像素密度人肉眼视网膜中心凹(视网膜中心凹是视觉敏锐度最高的区域)的分辨率极限是 60 PPD(因人而异,平均为 60 PPD)。根据人眼 60PPD 的分辨能力,可以计算得到,为达到良好视觉效果,VR 视频水平方向 360°应具有至少 21600 像素。 目前,VR 视频分辨率通常是 4K,与理想分辨率还有较大差距。未来拍摄 30K ×15K 的超高分辨率 VR 视频,达到人眼观看时 60PPD 的视网膜感受,才能带来画面质量质的飞跃。 2)显示屏分辨率目前,终端显示屏的最高分辨率可达到 4K,按照人眼视域 124°和 60PPD 计算,终端显示屏要达到 16K 才能实现理想的显示效果,因此终端屏幕分辨率还需要进一步提升。 存在的问题:纱窗效应

HMD 和 VR 眼镜内置了凸透镜,用于放大显示屏幕的图像,放大倍数一般为 5~7 倍。因此,用户通过 HMD 和 VR 眼镜观看 VR 视频时,相当于近距离用一个放大 5~7 倍的放大镜观看显示屏,显示屏的物理结构被放大显现出来,这就是业内常说的纱窗效应。 |

【本文地址】