pytorch框架对RTX 2080Ti RTX 3090的支持与性能测试 |

您所在的位置:网站首页 › rtx2080ti与3070 › pytorch框架对RTX 2080Ti RTX 3090的支持与性能测试 |

pytorch框架对RTX 2080Ti RTX 3090的支持与性能测试

|

时间点:2020-11-18

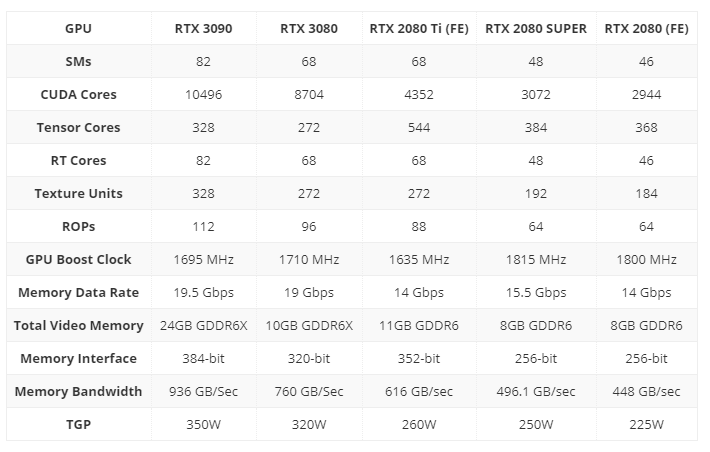

一、背景

2020年9月nvidia发布了30系列的显卡。比起20系列网上的评价是:性能翻倍,价格减半。 最近正好本人手上有RTX 2080Ti 和 RTX 3090,所以本人专门对其在深度学习上的性能进行了测试。 当前(2020-11-18)网上对3090与2080Ti在深度学习上的性能差异的测试数据比较少,大部分测试的对比每秒处理图片数,本人感觉这种测试有些不公平,3090显存24G,2080Ti显存11G,3090注定其显存能装载的图片数一定比2080Ti翻倍。所以本人的测试重点是在2者显存都没占满(小网络的情况下),其运行性能的差异。求证3090在CUDA Cores,Boost Clock与Memory Interface Width等参数(除了显存)提升所带来的性能提升。 二、测试环境 硬件:RTX 2080Ti & RTX 3090 nvidia-driver: 455.45.01(2020-11-17发布最新版,支持2080ti, 3090) 455.38(支持2080ti, 3090) 455.23.04 455.38(只支持30系列的稳定版) 450.80.02(不支持30系列的稳定版) pytorch: 官网pytorch 1.6.0, 官网pytorch 1.7.0, 源码编译pytorch 1.8.0a0+4883d39(cuda11.1+cudnn8.0.5+mkl) 操作系统:nvidia-docker ubuntu18.04(cuda10.2, cuda11.0, cuda11.1三个版本) 三、参数对比

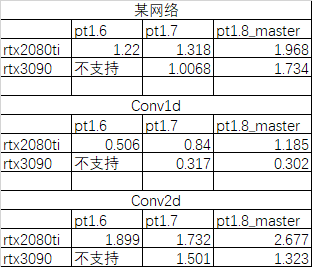

某网络:是本人使用的一个网络模型(小网络) Conv1d, Conv2d来源于 https://github.com/pytorch/pytorch/issues/47039 可得出: rtx3090比rtx2080ti快20%左右。 2021-02-01 更新:满负载情况下,完成同样任务。rtx3090比rtx2080ti快40%。 五、结论 tx2080ti: 用pytorch1.6.0版本 rtx3090: 用pytorch1.7.0版本 pytorch1.8(源码编译):性能最差。(无法解释😲,github上说cudnn8.0.5对30系列显卡性能会提升,都是骗人的😭.... 编译环境如下,如有高人明白请帮忙指明,在此谢过!) pytorch1.7.1: 同pytorch1.8(源码编译) pytorch对30系列的显卡还在支持中,期待其更新版本。有网友测试了,tf在3090上确实能实现比2080Ti翻倍的性能,希望pytorch加油 新东西别太早尝试,其生态不一定完善,需要时间。

|

【本文地址】