8x NVIDIA A100 为ChatGPT提供硬件动力 |

您所在的位置:网站首页 › nvidia什么 › 8x NVIDIA A100 为ChatGPT提供硬件动力 |

8x NVIDIA A100 为ChatGPT提供硬件动力

|

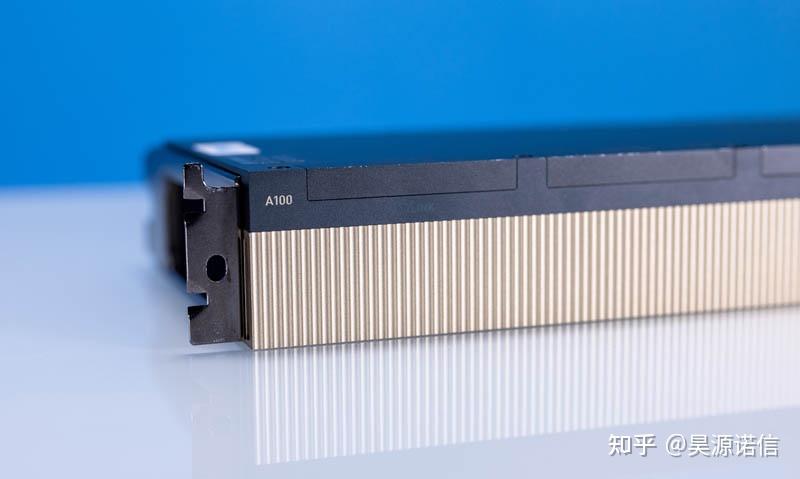

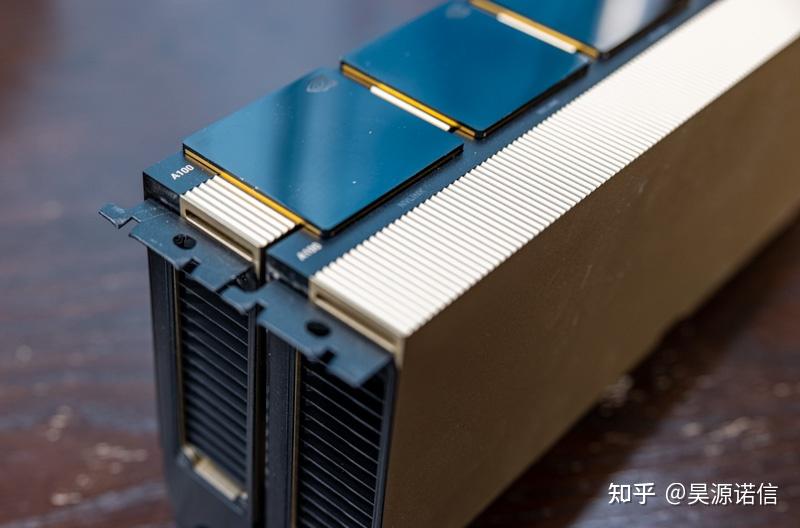

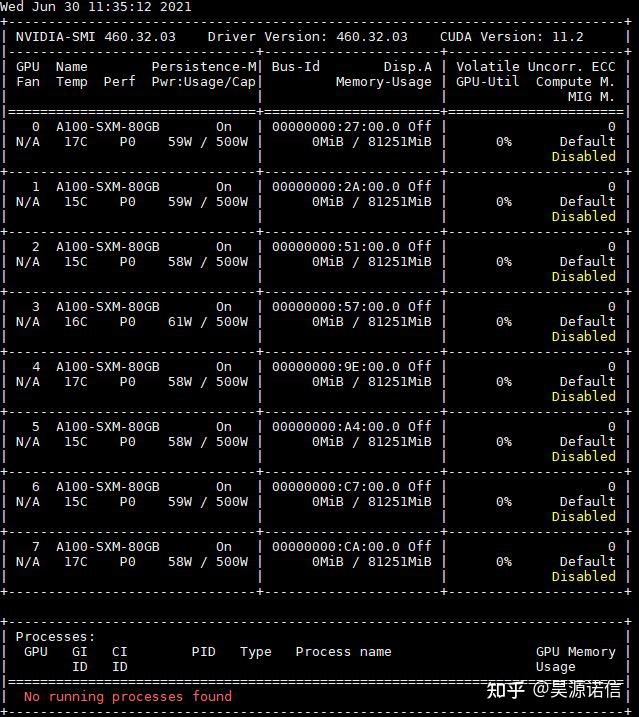

最近,以ChatGPT为首的生成类模型已经成为了人工智能的新热点,硅谷的微软、谷歌等都纷纷大举投资此类技术,以ChatGPT为代表的生成类模型有一个共同的特点,就是使用了海量数据做预训练,并且往往会搭配一个较为强大的语言模型。语言类生成式人工智能中的大语言模型需要非常多的参数,才能完成这类复杂的学习并且记住如此多的信息。以ChatGPT为例,其参数量高达1750亿(使用标准浮点数的话会占用700GB的存储空间),其语言模型之“大”可见一斑。 8x NVIDIA A100 为ChatGPT提供硬件动力首先,什么是 NVIDIA A100?许多人都了解 GPU 的概念,因为它是桌面系统中的常见组件。通常,GPU 是 PCIe 卡,可用于游戏或在服务器中越来越普遍。NVIDIA 专门为这些类型的系统制造 A100 GPU。  英伟达 A100 80GB PCIe 2 英伟达 A100 80GB PCIe 2NVIDIA A100 与游戏中常见的 NVIDIA GeForce 系列之间存在一些差异。其一,NVIDIA A100 在设计时考虑了服务器冷却。这意味着没有风扇,它们被设计成密集地装入紧凑的系统中。  虽然 GPU 具有高速互连,即使在这种 PCIe 外形中也称为 NVLink,但这些 GPU 并不是用于游戏的。A100 专门针对人工智能和高性能计算进行调整,而不是为游戏快速渲染 3D 帧。  2 个 NVIDIA A100 PCIe,安装了 NVLink 桥接器 2 个 NVIDIA A100 PCIe,安装了 NVLink 桥接器在 NVIDIA A100 GPU 的背面可以看到一个很好的例子来说明为什么会出现这种情况。在这里,支架只是有一个用于冷却气流的排气口。它们没有连接显示器或电视的显示输出。 大多数 8x NVIDIA A100 系统,尤其是在较大的云服务提供商处,都使用一种特殊的 NVIDIA 专用外形规格,称为 SXM4。在下图中,GPU 位于组件底部附近的黑色层周围。该组件的 80% 以上是散热片,用于耗散大量功率。虽然上面看起来像游戏 GPU 的 PCIe 变体通常只能处理 250W-300W,但 SXM4 变体每个可以处理 400-500W。额外的功率允许每个 A100 的性能更高。  ISC 2022 侧的 NVIDIA A100 SXM ISC 2022 侧的 NVIDIA A100 SXM这些 SXM4 A100 中的每一个都不作为单个单元出售。相反,它们以 4 或 8 个 GPU 子系统的形式出售,因为 SXM 安装极具挑战性。每个下面的盖子都隐藏着大量的电针。一个弯曲的针脚,甚至将散热器拧紧到 GPU 上太紧,都可能损坏成本与汽车一样高的 GPU。  NVIDIA A100 SXM 在 ISC 2022 底部 NVIDIA A100 SXM 在 ISC 2022 底部在现代服务器中,它们与 8 个 SXM4 GPU 一起安装在称为 NVIDIA HGX A100 的基板上。  浪潮NF5488A5 NVIDIA HGX A100 8 GPU总成19 浪潮NF5488A5 NVIDIA HGX A100 8 GPU总成19每个底板都旨在将八个 NVIDIA A100 SXM4 GPU 排列成一个阵列。使用高密度边缘连接器将 PCIe 连接提供回主机服务器。  NVIDIA HGX A100 上的其他大型散热器用于冷却 NVSwitch。NVIDIA 拥有自己的高速互连,允许每个 A100 在系统内以极高的速度相互通信。  Inspur NF5488A5 NVIDIA HGX A100 8 GPU 组件更大的 NVSwitch 冷却器 Inspur NF5488A5 NVIDIA HGX A100 8 GPU 组件更大的 NVSwitch 冷却器在服务器中,这是来自上方 NVIDIA HGX A100 组件的 8 个 NVIDIA A100 80GB 500W GPU 的外观。  8x NVIDIA A100 500W Nvidia Smi 输出 8x NVIDIA A100 500W Nvidia Smi 输出这意味着具有这些的系统将非常快,但也可以使用超过 5kW 的功率。  Supermicro AS 04124GO NART 液冷 Linpack 8x A100 80GB 500W Supermicro AS 04124GO NART 液冷 Linpack 8x A100 80GB 500W由于 NVIDIA A100 的板载内存比大多数台式机和笔记本电脑多,有 40GB-80GB,而且计算能力如此之大,因此 NVIDIA A100 具有称为多实例 GPU 或 MIG 的功能,可以将 GPU 分区为不同大小,类似于云实例。很多时候,对于 AI 推理,这可以用于在 GPU 上并行运行工作负载,从而提高 GPU 处理 AI 推理任务的吞吐量。  NVIDIA A100 40GB MIG 实例类型 NVIDIA A100 40GB MIG 实例类型以下是我们将 40GB NVIDIA A100 拆分为两个 MIG 实例时发生的情况。  NVIDIA A100 40GB 拆分为两个 MIG 实例 NVIDIA A100 40GB 拆分为两个 MIG 实例正如您可能已经看到的,所有这些都需要大量冷却。这里有两套NVIDIA A100系统,上面是风冷,下面是液冷。  Supermicro 液冷 Supermicro AS 4124GO NART 风冷和液冷前端 Supermicro 液冷 Supermicro AS 4124GO NART 风冷和液冷前端液体冷却提高了性能,使我们能够在更高的功率限制下运行 A100,从而提高性能。 虽然 NVIDIA A100 很酷,但下一个前沿是 NVIDIA H100,它有望提供更高的性能。 下一步是什么?NVIDIA H100NVIDIA A100 之后的下一代产品是 NVIDIA H100。这是一款采用新“Hopper”架构的更高功率卡。NVIDIA 将同时拥有 PCIe 和 SXM5 变体。 最后由于 NVIDIA A100 是一个热门话题,考虑到 OpenAI ChatGPT 和现在的 Microsoft Bing 集成,我们再次向大家简单介绍了这款显卡,虽然 NVIDIA A100 和新的 H100 被称为“GPU”并且可能比它们的桌面游戏兄弟(如 NVIDIA GeForce RTX 4090)更贵,但它们确实是针对 AI 工作负载调整的高性能计算加速器。 想了解更多 A100 和 H100 系统评测,请访问【昊源诺信】,或来电咨询【400-6997-916】~ |

【本文地址】

今日新闻 |

推荐新闻 |