AI作图手把手教程系列(3):进阶篇 |

您所在的位置:网站首页 › live2d图层怎么分 › AI作图手把手教程系列(3):进阶篇 |

AI作图手把手教程系列(3):进阶篇

|

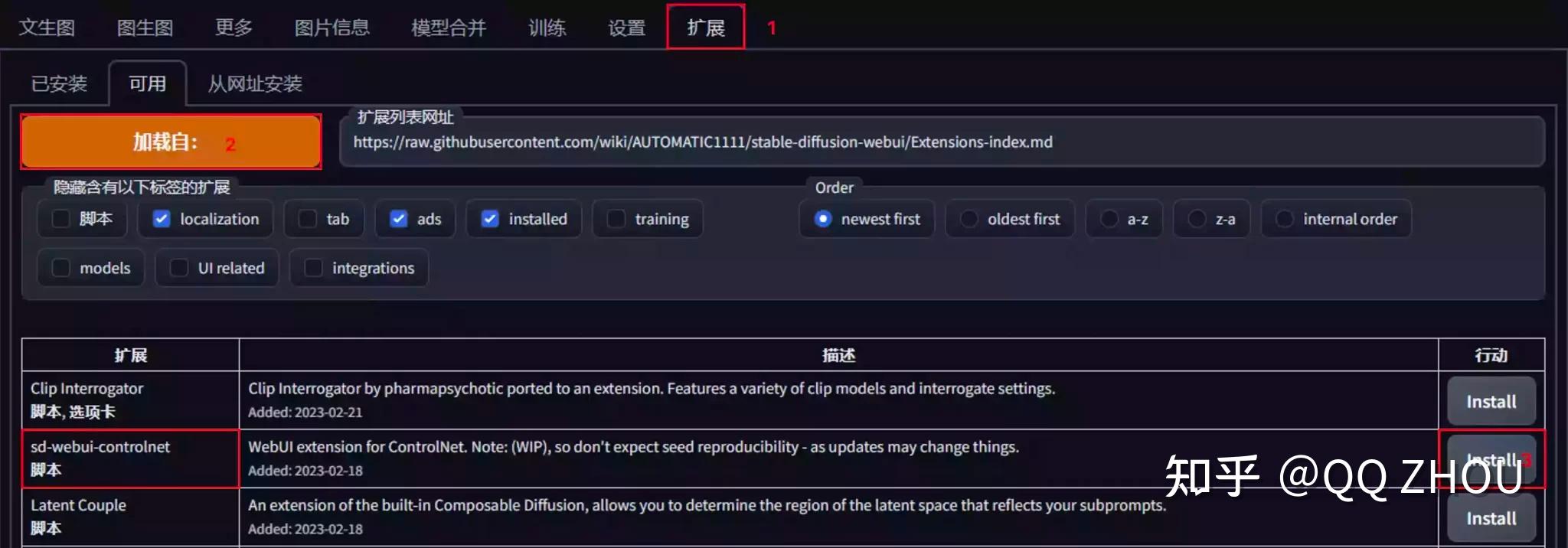

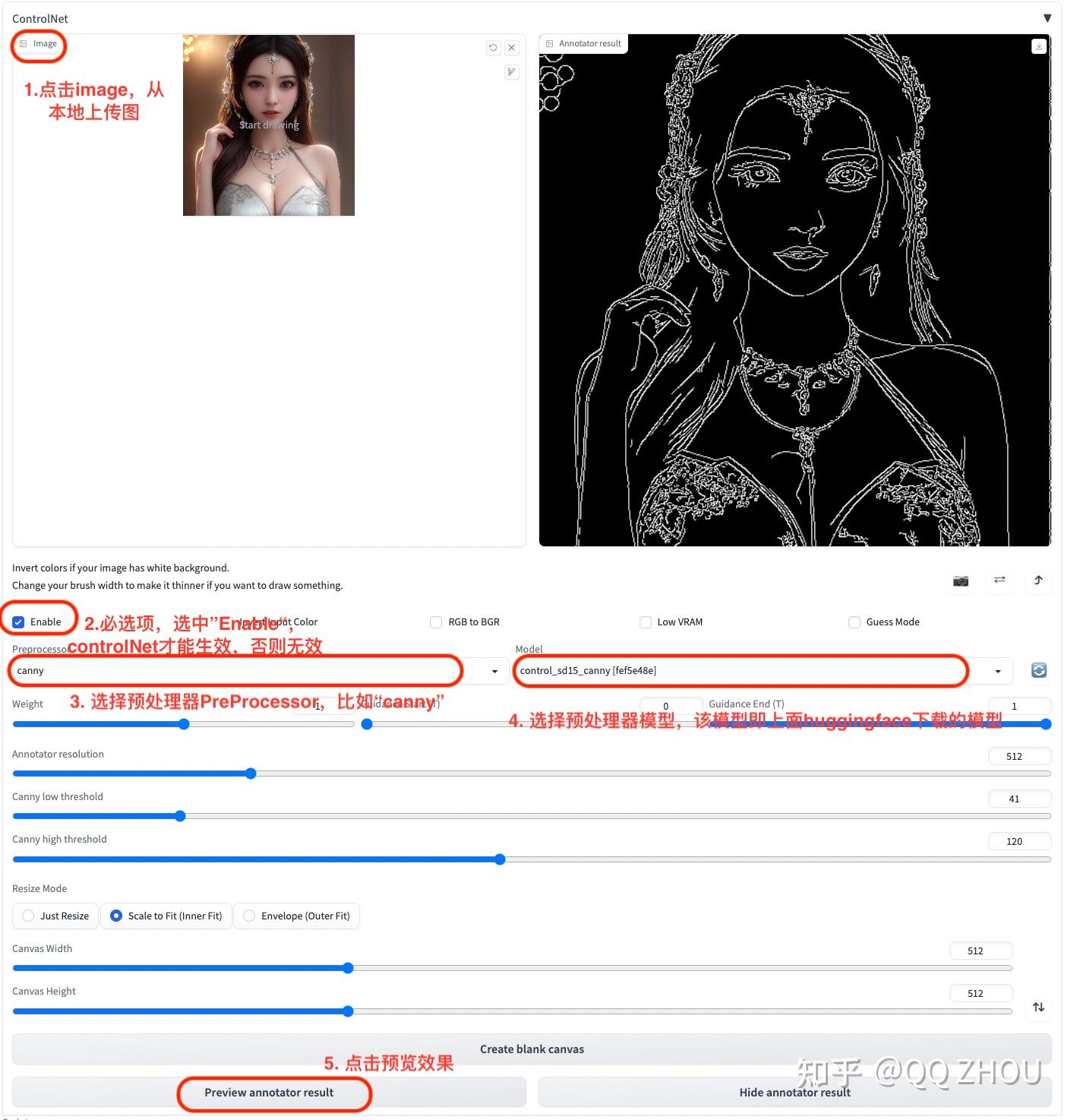

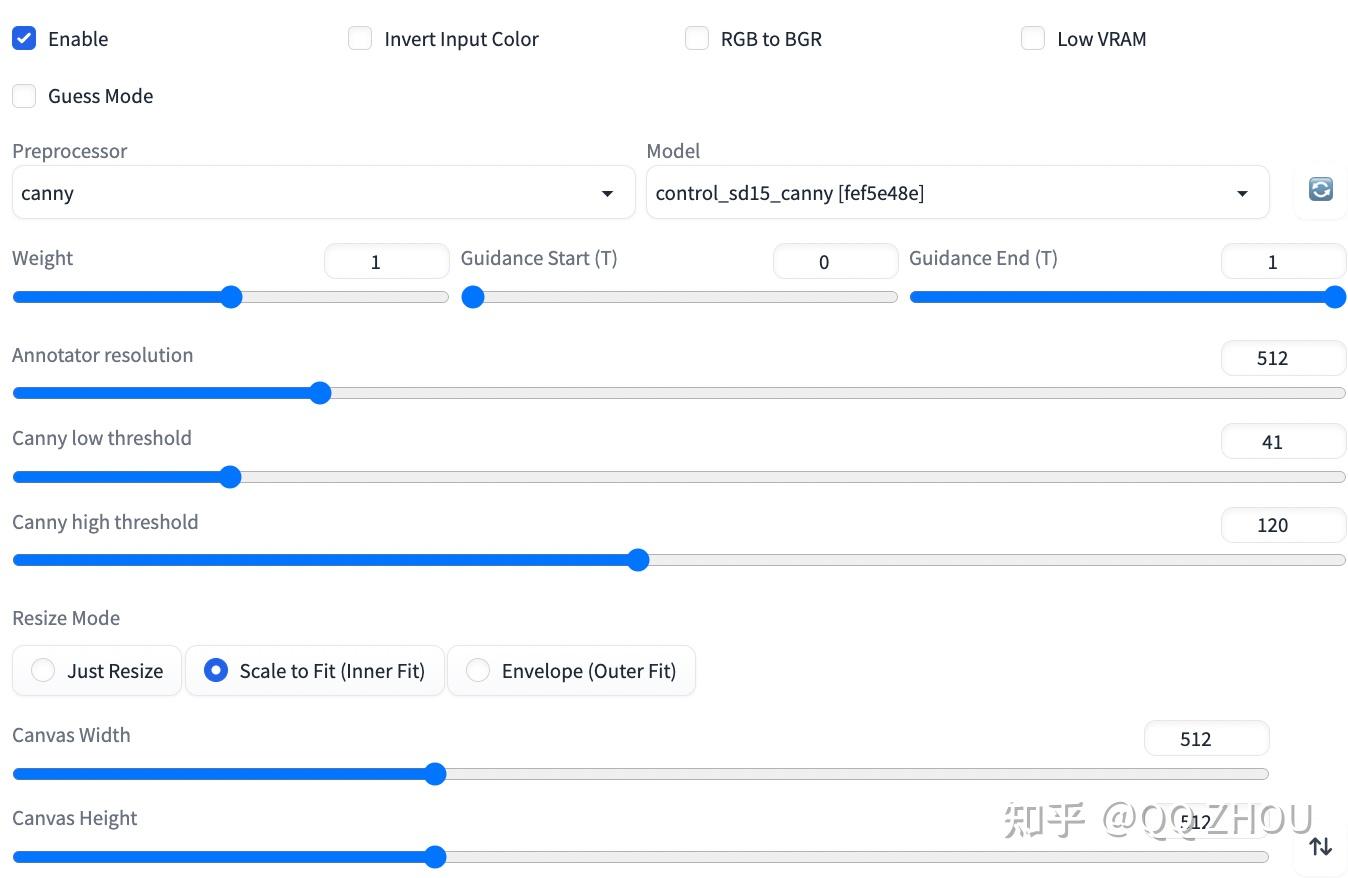

续前两篇AI教程,本篇文章将继续为大家介绍如何在stable_diffusion中使用ControlNet有控制的生成AI图像。下面给大家看一组图,这组图使用了ControlNet线稿功能,带大家初步体验一下ControlNet强大的制图功能。 本篇文章将介绍从安装ControlNet和相关模型->使用ControlNet,过程都非常简单,但效果非常惊人。当然,ControlNet模型和参数其实内容还是很多的,具体模型选择和参数调整我们将在下一篇文章介绍。在此,先带大家简单演练一下。 图1. 使用ControlNet中control_sd15_canny模型(模型下载和选择后续详细介绍)  图1. controlNet- canny 图1. controlNet- canny图2. 使用ControlNet中control_sd15_depth模型(模型下载和选择后续详细介绍)  图2. controlNet- depth下面以canny模型为例:一. 整体思路介绍 图2. controlNet- depth下面以canny模型为例:一. 整体思路介绍1. 安装ControlNet插件和对应模型。 2. 先选择一个整体模型。比如,我这里选择的仍旧是上一篇文章用到的中国风。 3. 让ControlNet帮你提取线稿,也是用来控图的基础,这一步就像画师先描线一样。 4. 调整ControlNet模型参数或选择不一样的模型,调整效果。 5. 点击Generate生成图像,此时生成的图像与原稿有几分相似。 上述1 在本文第二部分介绍。2,3,4,5具体操作在本文第三部分介绍。 二. 安装ControlNet插件和对应模型安装ControlNet插件前,需要安装stable_diffusion_webUI,如未安装可浏览QQ ZHOU:AI作图手把手教程系列(1)——stable diffusion云端安装和环境配置。 2.1 安装ControlNet插件下图按照步骤依次点击Extensions->Avaliable->Load from:-> 查看下面列表中的相关扩展插件,点击“Install”。  图3. ControlNet插件安装 图3. ControlNet插件安装如果您有需要编辑姿势的需求,那么建议您往下翻一点,找到一个名为OpenPose Editor的插件,安装该插件。  图4. OpenPose插件安装 图4. OpenPose插件安装安装好后上述插件后,可以再Extensions-Installed下面看到上面两个插件。如下图所示:  图5 图5安装好后,我们打开stable_diffusion_webui,可以看到ControlNet  图62.2 安装模型(ControlNet)打开链接:lllyasviel/ControlNet at main,点击Files and versions,可以看到很多.pth结尾的模型文件。点击其中一个进入到模型下载界面。 图62.2 安装模型(ControlNet)打开链接:lllyasviel/ControlNet at main,点击Files and versions,可以看到很多.pth结尾的模型文件。点击其中一个进入到模型下载界面。 图7 图72. 进入模型下载界面,右击下图download(箭头标出),点击复制链接地址。  图8 图83. 跳转到终端,下载模型,代码如下: ⚠️ 下载后的模型要存在 sd-webui-controlnet/models,我这里的绝对路径是~/autodl-tmp/stable-diffusion-webui/extensions/ wget https://huggingface.co/lllyasviel/ControlNet/resolve/main/models/control_sd15_canny.pth三. 使用ControlNet生成图3.1 选择模型,上传图片打开stable_diffusion_webui界面,选择这节课的图片风格(3Gupfeng3_v32Light.sagetensors)。点击ControlNet框右边的箭头(见图10),展开后上传我们上节课生成的图片。  图103.2 ControlNet提取线稿 图103.2 ControlNet提取线稿然后按照图11的步骤先试试,注意一定要选中Enable,否则无效。最后,点击Preview annotator result,结果得到线稿。  图113.3 适当调整模型参数,最后生成点击Gernerate。 图113.3 适当调整模型参数,最后生成点击Gernerate。 图12 图12参数介绍  Enable-启用 勾选后,点击生成按钮时,将会实时通过ControlNet引导图像生成,否则不生效。Invert Input Color 将你用画笔涂抹的区域颜色进行反转。RGB to BGR 颜色通道反转Low VRAM 低显存模式如果你的显卡内存小于4GB,建议勾选此选项。Guess Mode 猜测(盲盒)模式,不需要任何正面与负面提示词,出图效果随机。备注:经本站测试,盲盒效果极佳,很有可能产生意想不到的惊喜效果!Preprocessor 预处理器,每个ControlNet的模型都有不同的功能。Model 该列表的模型选择,必须与预处理选项框内的模型名称一致。如果预处理与模型不致也可以出图,但效果无法预料,且并不理想。比如:Preprocessor选择canny,model选择control_sd15_canny,可以从名称辨别出。Weight 权重,代表使用ControlNet生成图片的权重占比影响。Guidance strength(T) 中文为引导强度,在理解此功能之前,我们应该先知道生成图片的步数功能,步数代表生成一张图片要刷新计算多少次。假如你设置的生成步数是20步,引导强度设置为1时,代表这20步中的每1步都会被ControlNet引导1次,个人认为引导强度数值为1,效果最佳。Annotator resolution Canny线稿分辨率:该数值越高,ControlNet区域所生成的的预处理图像越精细。Canny low threshold 生成的线稿最低阈值,也就是控制最低采样深度。Canny high threshold 生成的线稿最高阈值,也就是控制最高采样深度Resize Mode 调整图像大小模式:默认使用缩放至合适即可,将会自动适配图片。Canvas Width与Canvas Height 画布宽高:请注意这里的宽高,并不是指SD生成图片的图像宽高比。该宽高代表ControlNet引导图像时所使用的比例,假如你用SD生成的图片是1000*2000的分辨率,那么使用ControlNet引导图像时,对显存的消耗将是具大的;我们可以将该分辨率设置为500*1000,也就是缩放为你原本图像一半的分辨率尺寸去进行引导,有利于节省显存消耗。Create blank canvas 如果您之前使用过ControlNet功能,那么将会在ControlNet的图像区域留有历史图片,点击该按钮可以清空之前的历史,也就是创建一张空白的画布。Preview annotator result 点击该按钮可以预览注释器结果例如:如果您使用Canny作为预处理和模型,那么点击该按钮之后,可以看到一张通过Canny模型提取的边缘线图片。如何:如果您使用OpenPose作为预处理和模型,那么点击该按钮之后,可以看到一张通过OpenPose模型提取的人物骨骼图片。如果现在看不懂也没有关系,后续将会对该功能进行详细的补充。Hide annotator result 隐藏通过Preview按钮生成的预览图像窗口【建议不隐藏】若有收获,请各位就点个赞吧!喜欢请关注 @QQ ZHOU, 后续还会为你分享更多稳定生图的内容。 更多作品请关注公众号文章,扫码关注公众号~  系列教程链接: QQ ZHOU:AI作图手把手教程系列(1)——stable diffusion云端安装和环境配置 QQ ZHOU:AI作图手把手教程系列(2)——使用AI绘制第一幅作品 |

【本文地址】