科学网 |

您所在的位置:网站首页 › index计算方式 › 科学网 |

科学网

|

香农信息熵 (Shannon's Entropy)在生命科学中的应用

已有 18221 次阅读 2013-7-11 02:48 |系统分类:观点评述| 信息 说 到Bioinformatics(生物信息)不能不提信息,说到信息(论)不能不提到Shannon, 因为他老人家是“信息论之父“。 Claude Elwood Shannon (1916–2001)出生在美国Michigan州一个小镇,父亲经商,母亲是一位语言老师同时也是中学校长。 Shannon 中学就毕业于他母亲所在的学校。这位同学从小就在数学和电子方面展现出不同寻常的天赋。Shannon 21岁时从MIT毕业,他的硕士论文被誉为有史以来最重要的硕士论文。他在密码学领域的研究,使得美国在二次世界大战密码战中占尽优势。个人以为,Shannon's entroy 是最简洁同时用途最多的数学公式之一。

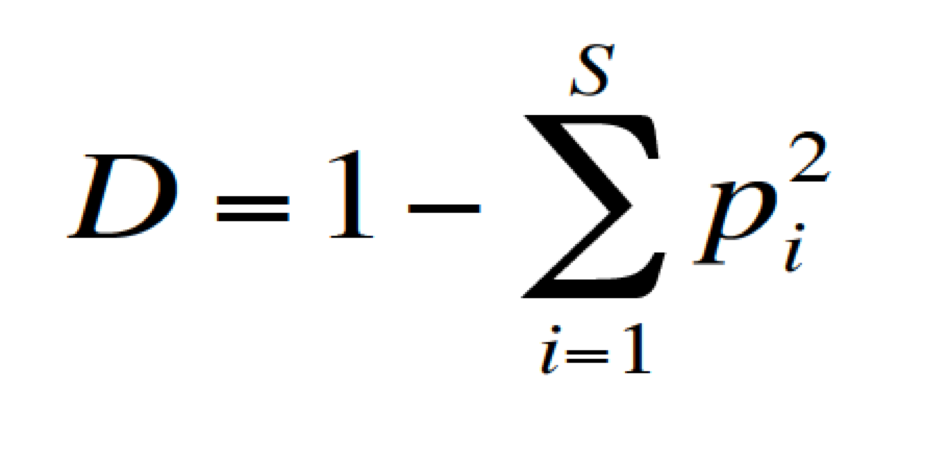

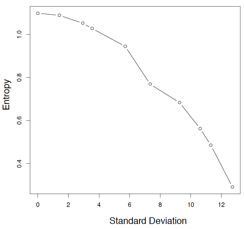

其本意是去衡量一件事物信息量的多少,而“信息量的多少”又决定于其“不确定性 (uncertainlty)”。这从entropy的单位是bit (联想到bit只有两个相同可能性的值: 0 或者1)就可以看出来。所以扔一次硬币的信息量(entropy)是1bit,怎么算出来的呢? 扔一次硬币,出现正面的概率是 p(face_up)=0.5, 出现反面的概率也是p(face_down)=0.5, 所以,下面是中学数学内容:H(fair_coin_toss) = -(0.5 * log2(0.5) + 0.5 * log2(0.5)) = 1 (bit)如果这枚硬币被做了手脚是unfair的,出现正面的概率是0.7, 反面是0.3。那么扔一个这个硬币的entropy肯定小于1bit,因为“不确定性减少”了:对于fair的硬币,你只能瞎蒙是正面还是反面,但对于这枚unfair的硬币,你会一直猜是正面。H(unfair_coin_toss)= -(0.7*log2(0.7) + 0.3*log2(0.3)) = 0.88 (bit)“不确定性”是个数学术语,太抽象,像我这样非数学专业的人不喜欢。在生命科学领域,“不确定性”的其中一个翻译就是“多样性(diversity)”,比如生态学中的“物种多样性”。再比如遗传学中等位基因(allele)在群体中的杂合性(heterogenity)。下面先用 物种多样性为例,来说明 Shannon's entropy到底牛在什么地方?应为这个例子最为形象具体。怎么衡量一个地方的生态系统到底健不健康?物种多样性是其中一个重要指标。物种多样性“好”的生态系统才稳定。那么怎么样才算”好“,打个比方,美国黄石国家公园和中国青海可可西里国家自然保护区,哪一个的生态系统更”健康“?仅仅比较物种数量可行吗?显然不行。 第一,由于人力和财力所限,你不可能count所有的物种,就算不考虑人力和财力,你也不能count所有物种,因为很多微生物无法用肉眼观测到。所以,你只能取样(sampling),是取样就有偏差(bias),这次取样和下次取样的物种数可能差异很大。 第二,物种数量不考虑频率信息。假如在一次取样中,发现黄石公园和可可西里都有1000个物种,你能认为这两个生态系统一样健康吗?不能。因为虽然总数一样,但每个物种的频率不一样。举个例子,第一个生态系统的1000物种中间,有300个濒临灭绝(或者说频率很低),而另外一个系统的1000个物种, 频率都差不多。你能说这两个系统一样健康?所以在比较物种多样性时,既要考虑物种数量,又要考虑物种频率。回到了entropy 的公式,entropy的大小取决与两个因素:p 的数量(求和公式)和p本身大小,如果所有的p都一样大,entropy 达到最大值(可以自己算一下,证明略)。 实际上,除了Shannon's entropy还有其他公式去算多样性(diversity),比如Simpson's index也被广泛使用: 为什么说Shannon's entropy最好呢?因为它不偏不倚。前面所说的简单数数,样品中有很多低频率物种的生态系统就占便宜了。用Simpson's index, 样品中有少数高频率物种的生态系统就占便宜了(注意到p的平方了吗? 少数几个比较大的p就可以把D的值“拉高”)。所以只有shannon‘s entropy既不偏向于低频率物种,也不偏向于高频率物种。世纪应用中, 要对取样造成的偏差进行校正。 在分子生物学中举个例子,每个基因(比如基因A)都有几个甚至更多个isoform( A1, A2,A3,A4),这些isoform是同时以相同的比例表达(A1=0.25,A2=0.25,A3=0.25,A4=0.25)还是只有一个或几个在表达?可以用entropy来衡量isoform表达的均衡与否。 生命科学领域,“不确定性”的另外一个翻译就是“可重复性” (reproducibility)。RNA-seq可以衡量基因的表达量高低,现在用两个procotol,对同一个样品做5次,问那一个protocol可重复性更好?对于某个gene来说,两个protocol得到的表达量为: protocol-1: 94,66,75,51,63 protocol-1: 71,79,59,68,90 哪一个procotol的可重复性好?(结果读者自己算吧) 如前面所说的,如果5个数值都一样,这时entropy达到最大值,意味着perfect reproducibility。有意思的是,entroy和标准方差(standard deviation) 有着近似的线性关系:标准方差越大,entropy越小。说明用entropy衡量 reproducibility是靠谱的。

那有人问为什么不用标准方差去衡量可重复性呢?第一:标准方差受ourtlier的影响较大,entropy也受影响,但要小的很多。第二:当数值都相等时,标准方差是0。不方便比较。举例说明: entropy (c(5,5,)) = 1 #实验2次,得到相同的值 entropy (c(5,5,5,5)) = 2 #实验4次,得到相同的值 entropy (c(5,5,5,5,5,5) = 2.58 #实验6次,得到相同的值 sd(c(5,5)) = 0 #实验2次,得到相同的值 sd(c(5,5,5,5)) = 0 #实验4次,得到相同的值 sd(c(5,5,5,5,5,5)) = 0 #实验6次,得到相同的值 这里sd代表standard deviation 当重复实验得到相同的数值时(表示100%的可重复性)entrpy达到最大,标准方差达到最小。但是,重复的次数越多,我就越自信。entrop的值随着重复次数的增加而增加,正是反映了这种自信的增加。从这方面来看,entropy衡量reproducibility确实要比标准方差好。 ==有空再续== https://blog.sciencenet.cn/blog-986653-707058.html 上一篇:how to publish your code (software) in professional fashion?下一篇:美国富人的社会责任感 收藏 IP: 129.176.151.*| 热度| |

【本文地址】

今日新闻 |

推荐新闻 |