【2023年4月7日】CVPR 2023 论文分享 |

您所在的位置:网站首页 › image表情 › 【2023年4月7日】CVPR 2023 论文分享 |

【2023年4月7日】CVPR 2023 论文分享

|

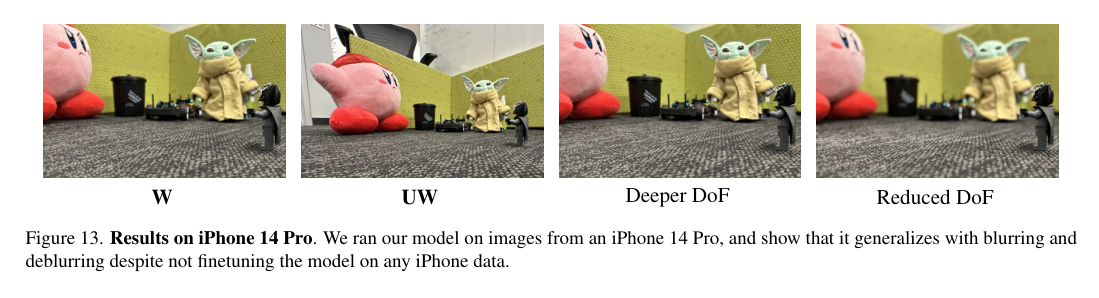

【2023年4月6日】CVPR 2023 论文分享 智能手机摄影(虚焦去模糊、虚化效果和图像焦点)▌\text{DC}^2: Dual-Camera Defocus Control by Learning to Refocus  论文作者:Hadi Alzayer,Abdullah Abuolaim,Leung Chun Chan,Yang Yang,Ying Chen Lou,Jia-Bin Huang,Abhishek Kar 论文链接:http://arxiv.org/abs/2304.03285v1 项目链接: https://defocus-control.github.io 1)方向:去模糊 2)应用:智能手机摄影 3)背景:虽然智能手机的硬件和软件不断升级,但是固定光圈仍然限制着用户控制所拍摄照片的景深,即焦点范围。 4)方法:提出一种名为 ext{DC}^2 的系统,通过融合双摄像头系统的信息,实现合成调整摄像机光圈、聚焦距离和任意的虚焦效果。利用智能手机相机数据集来学习控制虚焦,以图像重点作为代理任务,从而实现对景深的控制。 5)结果:在真实世界数据上进行定量和定性评估,结果表明该系统在虚焦去模糊、虚化效果和图像焦点方面表现优于最先进的技术。最后,通过该方法实现了创意后处理的景深控制,包括倾斜移位和基于内容的虚化效果。                   微表情识别 微表情识别 ▌Micron-BERT: BERT-based Facial Micro-Expression Recognition  论文作者:Xuan-Bac Nguyen,Chi Nhan Duong,Xin Li,Susan Gauch,Han-Seok Seo,Khoa Luu 论文链接:http://arxiv.org/abs/2304.03195v1 项目链接: https://github.com/uark-cviu/Micron-BERT 1)方向:微表情识别 2)应用:微表情识别 3)背景:微表情识别是情感计算中最具挑战性的课题之一,它旨在识别人类难以在短时间内感知的微小面部运动,即0.25到0.5秒。 4)方法:本文提出一种新的面部微表情识别方法Micron-BERT(\mu-BERT)。该方法基于两个关键思想,首先,采用对角微注意力(DMA)来检测两帧之间的微小差异。其次,引入新的感兴趣区域(PoI)模块,以定位和突出微表情感兴趣区域,并同时减少噪声背景和干扰。通过将这些组件结合到端到端的深度网络中,提出的\mu-BERT在各种微表情任务中显著优于以前的所有工作。 5)结果:\mu-BERT可以在大规模未标记的数据集上进行训练,即高达800万张图像,并在新的未见过的面部微表情数据集上实现高精度。实证实验表明,\mu-BERT在四个微表情基准(包括SAMM,CASME II,SMIC和CASME3)上始终优于最先进的性能。该方法的代码可在\url{https://github.com/uark-cviu/Micron-BERT}上获得。              人物交互 人物交互▌Instant-NVR: Instant Neural Volumetric Rendering for Human-object Interactions from Monocular RGBD Stream  论文作者:Yuheng Jiang,Kaixin Yao,Zhuo Su,Zhehao Shen,Haimin Luo,Lan Xu 论文链接:http://arxiv.org/abs/2304.03184v1 1)方向:人物交互 2)应用:人物与物体交互场景的建模和渲染 3)背景:在许多应用中,方便的人物与物体交互场景建模和渲染是必不可少的。然而,复杂交互场景的单目跟踪和渲染仍然具有挑战性。 4)方法:本文提出Instant-NVR,一种使用单个RGBD相机进行即时体积人物与物体跟踪和渲染的神经方法。它通过多线程跟踪-渲染机制将传统的非刚性跟踪与最近的即时辐射场技术相结合。在跟踪前端,采用了稳健的人物-物体捕获方案以提供足够的运动先验。进一步引入了一个分离的即时神经表示,以及一个新的混合变形模块来处理交互场景。还提供一种动态/静态辐射场的即时重建方案,通过高效的运动先验搜索实现。此外,引入一种在线关键帧选择方案和一个渲染感知的细化策略,以显著提高在线新视角合成的外观细节。 5)结果:广泛的实验表明,所提出方法在即时生成人物与物体辐射场方面具有有效性和效率,特别是在复杂的人物与物体交互场景下实现了实时的逼真新视角合成。              虚拟人物动画 虚拟人物动画▌CloSET: Modeling Clothed Humans on Continuous Surface with Explicit Template Decomposition  论文作者:Hongwen Zhang,Siyou Lin,Ruizhi Shao,Yuxiang Zhang,Zerong Zheng,Han Huang,Yandong Guo,Yebin Liu 论文链接:http://arxiv.org/abs/2304.03167v1 项目链接: https://www.liuyebin.com/closet 1)方向:虚拟人物动画 2)应用:创建可动画的人物角色 3)背景:将静态扫描数据转化为可动画虚拟人物需要对不同姿势下的服装变形进行建模。现有的基于学习的方法通常是在最小化穿衣网格模板或学习的隐式模板上增加姿态相关的变形,这些方法在捕捉细节方面存在局限性,或者阻碍端到端的学习。 4)方法:提出了一种基于点的解决方案,通过将明确的与服装相关的模板分解,然后在其上添加姿态相关的皱纹。通过这种方式,服装变形被分离,从而可以更好地学习和应用于未知的姿态。此外,为了解决最近点模型方法中的接缝问题,提出在身体表面上学习点特征,建立连续紧凑的特征空间,以捕捉细粒度和姿态相关的服装几何形状。 5)结果:在现有数据集和作者新引入的数据集上验证了该方法,表明在未知姿势下的服装变形结果更好。为了方便该领域的研究,还介绍了一个高质量的现实世界服装人体扫描数据集。代码和数据集可以在 https://www.liuyebin.com/closet 找到。                     行人检测 行人检测 ▌VLPD: Context-Aware Pedestrian Detection via Vision-Language Semantic Self-Supervision  论文作者:Mengyin Liu,Jie Jiang,Chao Zhu,Xu-Cheng Yin 论文链接:http://arxiv.org/abs/2304.03135v1 项目链接: https://github.com/lmy98129/VLPD 1)方向:行人检测 2)应用:自动驾驶、视频监控等领域的行人检测 3)背景:在城市场景中准确检测行人对于自动驾驶、视频监控等应用非常重要。然而,类似人的物体容易导致错误检测,而小尺度或严重遮挡的行人由于其不寻常的外观很容易被忽略。因此,如何充分利用更明确和语义化的上下文成为一个关键问题。 4)方法:本文提出了一种新的方法,通过视觉-语言语义自监督来进行上下文感知的行人检测(VLPD)。首先,提出了一种自监督的视觉-语言语义分割方法,通过视觉-语言模型生成的语义类别的显式标签来学习全监督的行人检测和上下文分割。其次,提出了一种自监督的原型语义对比学习方法,基于从VLS获得的更明确和语义化的上下文来更好地区分行人和其他类别。 5)结果:在流行的基准测试中,VLPD在小尺度和严重遮挡等具有挑战性的情况下表现出优异的性能,优于以前的最新技术水平。代码可在https://github.com/lmy98129/VLPD上获得。              图像合成 图像合成 ▌Zero-shot Generative Model Adaptation via Image-specific Prompt Learning  论文作者:Jiayi Guo,Chaofei Wang,You Wu,Eric Zhang,Kai Wang,Xingqian Xu,Shiji Song,Humphrey Shi,Gao Huang 论文链接:http://arxiv.org/abs/2304.03119v1 项目链接: https://github.com/Picsart-AI-Research/IPL-Zero-Shot-Generative-Model-Adaptation 1)方向:图像合成 2)应用:图像合成 3)背景:现有的CLIP-guided图像合成方法在将预训练的源域生成器适应到未见过的目标域时表现出了吸引人的性能。然而,现有方法在生成图像的质量上仍存在一些限制,并且可能会遭受模式崩溃问题。 4)方法:为了解决这个问题,提出了一种名为Image-specific Prompt Learning (IPL)的方法,为每个源域图像学习特定的提示向量。这为每个跨域图像对产生了更精确的适应方向,赋予了目标域生成器极大的灵活性。IPL不依赖于生成模型的结构,如生成对抗网络或扩散模型。 5)结果:在各种领域的定性和定量评估中,IPL有效地提高了合成图像的质量和多样性,并减轻了模式崩溃。此外,IPL的代码可在https://github.com/Picsart-AI-Research/IPL-Zero-Shot-Generative-Model-Adaptation上获得。                     目标检测 目标检测 ▌Continual Detection Transformer for Incremental Object Detection  论文作者:Yaoyao Liu,Bernt Schiele,Andrea Vedaldi,Christian Rupprecht 论文链接:http://arxiv.org/abs/2304.03110v1 1)方向:目标检测 2)应用:增量目标检测 3)背景:增量目标检测旨在分阶段训练目标检测器,每个阶段都有新的目标类别注释。然而,增量设置容易受到灾难性遗忘的影响,这通常通过知识蒸馏(KD)和样本重放(ER)等技术来解决。但是,如果直接应用于基于Transformer的最先进的目标检测器(如Deformable DETR和UP-DETR),则KD和ER效果不佳。 4)方法:本文提出了一种新的基于Transformer的增量目标检测方法ContinuaL DEtection TRansformer(CL-DETR),可以在这种情况下有效地使用KD和ER。首先,引入一个检测器知识蒸馏(DKD)损失,专注于旧版本模型中最具信息量和可靠性的预测,忽略冗余的背景预测,并确保与可用的ground-truth标签兼容。还通过提出校准策略来改进ER,以保留训练集的标签分布,从而更好地匹配训练和测试统计数据。 5)结果:在COCO 2017上进行了大量实验,并证明CL-DETR在增量目标检测设置中实现了最先进的结果。                  域泛化+目标检测 域泛化+目标检测 ▌Multi-view Adversarial Discriminator: Mine the Non-causal Factors for Object Detection in Unseen Domains  论文作者:Mingjun Xu,Lingyun Qin,Weijie Chen,Shiliang Pu,Lei Zhang 论文链接:http://arxiv.org/abs/2304.02950v1 项目链接: https://github.com/K2OKOH/MAD 1)方向:计算机视觉中的域适应和域泛化 2)应用:目标检测 3)背景:在实际应用中,域转移影响了目标检测模型的性能。许多之前的工作试图通过域对抗性学习(DAL)从源域中解耦并学习域不变(公共)特征来减轻域转移的影响。然而,这些方法忽略了隐藏在公共特征中的隐含的微不足道的非因果因素。 4)方法:作者基于因果机制的灵感,发现以前的方法忽略了公共特征中隐含的非因果因素,因为DAL的单视角性质。为了消除公共特征中的非因果因素,作者提出了一个基于多视角对抗训练的方法,因为由于数据的多模态结构,这些微不足道的非因果因素在其他潜在空间(视图)中仍可能是显著的。作者提出了一个Multi-view Adversarial Discriminator (MAD)的领域泛化模型,包括一个增加源域多样性的Spurious Correlations Generator (SCG)和一个将特征映射到多个潜在空间的Multi-View Domain Classifier (MVDC),以消除非因果因素并净化领域不变特征。 5)结果:在六个基准测试中,实验表明作者的MAD达到了最先进的性能。              多模态预训练模型 多模态预训练模型 ▌Learning Instance-Level Representation for Large-Scale Multi-Modal Pretraining in E-commerce  论文作者:Yang Jin,Yongzhi Li,Zehuan Yuan,Yadong Mu 论文链接:http://arxiv.org/abs/2304.02853v1 1)方向:多模态预训练模型 2)应用:电子商务 3)背景:大规模视觉语言预训练方法在一般领域中取得了显著进展,但是由于自然图像和电商产品图像之间存在显著差异,直接将这些方法应用于电商产品的图像级表示将不可避免地出现亚优化情况; 4)方法:提出了一种名为 ECLIP 的实例中心多模态预训练范式,其中采用了可学习实例查询的解码器结构,以显式聚合实例级语义,进而提出了两个特别配置的预文本任务,使模型能够专注于所需的产品实例而不依赖于昂贵的手动标注; 5)结果:在 1 亿个电商相关数据上预训练的 ECLIP 成功提取了更通用、语义丰富、鲁棒性更强的表示。广泛的实验结果表明,即使没有进一步的微调,ECLIP 在广泛的下游任务上都大幅超越了现有方法,展示了其在实际电商应用中的强大可转移性。                    视觉语言数据集 视觉语言数据集▌Uncurated Image-Text Datasets: Shedding Light on Demographic Bias  论文作者:Noa Garcia,Yusuke Hirota,Yankun Wu,Yuta Nakashima 论文链接:http://arxiv.org/abs/2304.02828v1 1)方向:计算机视觉和自然语言处理 2)应用:视觉语言模型训练数据集的公平性 3)背景:大规模的图像和文本数据集被用于视觉语言模型的训练,然而这些数据集中存在着社会偏见的问题,即使是MSCOCO这样的小规模数据集也受到影响。。 4)方法:本研究的第一项工作是用四个人口属性和两个上下文属性对Google Conceptual Captions数据集进行标注。第二项工作是对标注进行全面的分析,重点关注不同人口群体的代表性。第三项工作是评估三个普遍的视觉语言任务:图像描述、文本-图像CLIP嵌入和文本-图像生成,证明社会偏见在这些任务中是一个持久的问题。 5)结果:研究表明,社会偏见在大规模视觉语言数据集中是一个严重的问题,并对不同的视觉语言任务产生了负面影响。这项工作提供了一个标注工具和社会偏见分析方法来帮助改进视觉语言模型的公平性。               发型迁移 发型迁移▌StyleGAN Salon: Multi-View Latent Optimization for Pose-Invariant Hairstyle Transfer  论文作者:Sasikarn Khwanmuang,Pakkapon Phongthawee,Patsorn Sangkloy,Supasorn Suwajanakorn 论文链接:http://arxiv.org/abs/2304.02744v1 项目链接: https://stylegan-salon.github.io/ 1)方向:风格迁移 2)应用:虚拟试发型 3)背景:本文旨在实现将参考图像的发型转移到输入照片中,以实现虚拟试发型的目的。但面临着诸多挑战,例如将长发与刘海转换为短发,需要去除原有的头发并推断出额头的样子,或是将戴帽人头上只有部分可见的头发转移到另一个姿势中。过去的解决方案利用StyleGAN进行“GAN逆投影”,以生成缺失的部分,并通过称为“GAN反演”或“投影”的方法生成无缝的面部-发型复合图像。然而,如何控制生成的图像以精确地转移发型并保持输入的面部形状和身份仍然是一个挑战。。 4)方法:为了解决这个问题,本文提出了一个多视角优化框架,利用参考复合图像的“两个不同视角”来语义指导遮挡或模糊区域。该优化过程在两个姿势之间共享信息,从而能够从不完整的参考中产生高保真度和逼真度的结果。 5)结果:本文提出的框架在一个用户研究中表现出高质量的结果,并在比以前研究过的更具挑战性的发型转移场景中优于之前的工作。 项目页面:https://stylegan-salon.github.io/。                       甲烷排放检测 甲烷排放检测 ▌MethaneMapper: Spectral Absorption aware Hyperspectral Transformer for Methane Detection  论文作者:Satish Kumar,Ivan Arevalo,ASM Iftekhar,B S Manjunath 论文链接:http://arxiv.org/abs/2304.02767v1 1)方向:遥感技术 2)应用:甲烷排放检测 3)背景:甲烷是全球气候变化的主要贡献者。现有的分析方法对当地地形条件敏感,需要领域专家手动检查,容易出现显著误差,因此不可扩展。 4)方法:提出了一种新颖的端到端光谱吸收波长感知变换器网络MethaneMapper,用于检测和量化甲烷排放。MethaneMapper引入了两个新颖的模块,帮助在光谱域中定位最相关的甲烷云区域,并使用它们准确地定位这些区域。 5)结果:经过全面评估,MethaneMapper在检测方面达到了0.63 mAP,并将模型大小(5倍)与当前技术水平相比。此外,还介绍了一个大规模的甲烷云分割掩模数据集,包括2015-2022年超过1200个AVIRIS-NG飞行线的4000多个甲烷云站点。该数据集将为研究人员提供机会,开发和推进解决这一具有重大社会影响的挑战性温室气体检测问题的新方法。数据集和源代码是公开的。

|

【本文地址】

今日新闻 |

推荐新闻 |