机器学习算法中的F值(F |

您所在的位置:网站首页 › f啥意思网络含义 › 机器学习算法中的F值(F |

机器学习算法中的F值(F

|

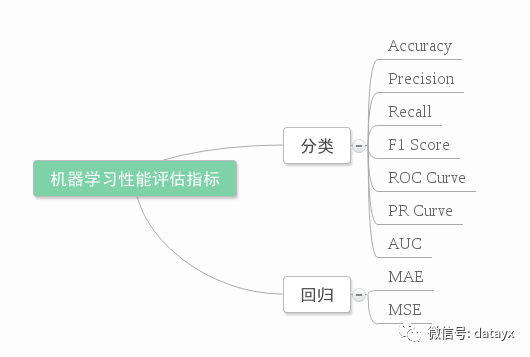

向AI转型的程序员都关注了这个号👇👇👇 人工智能大数据与深度学习 公众号:datayx 在机器学习、数据挖掘、推荐系统完成建模之后,需要对模型的效果做评价。 业内目前常常采用的评价指标有准确率(Precision)、召回率(Recall)、F值(F-Measure)等,下图是不同机器学习算法的评价指标。下文讲对其中某些指标做简要介绍。

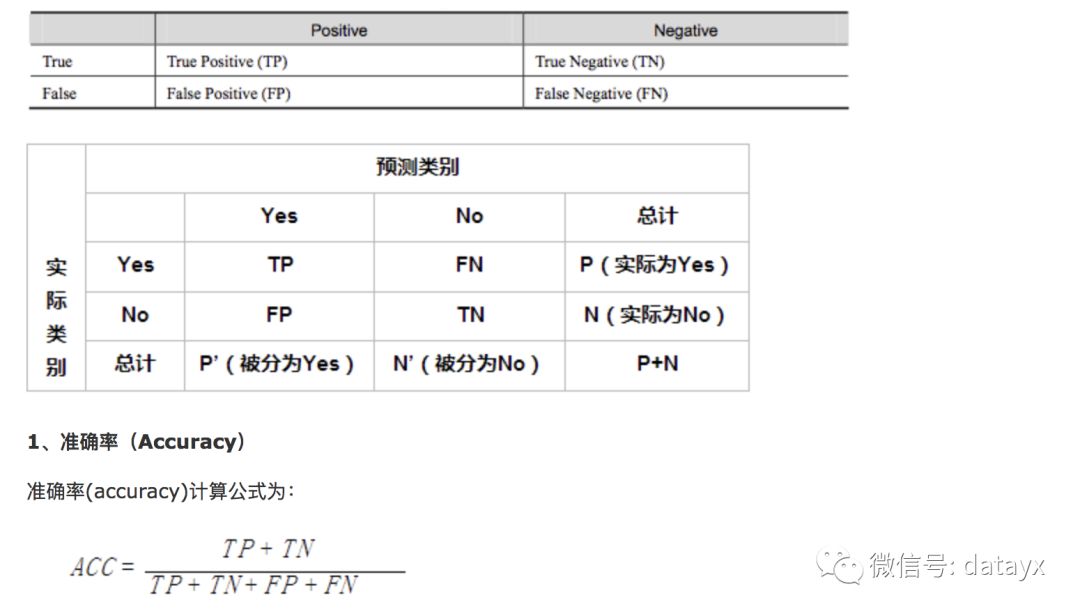

本文针对二元分类器! 在介绍指标前必须先了解“混淆矩阵”: True Positive(真正,TP):将正类预测为正类数 True Negative(真负,TN):将负类预测为负类数 False Positive(假正,FP):将负类预测为正类数误报 (Type I error) False Negative(假负,FN):将正类预测为负类数→漏报 (Type II error)

注:准确率是我们最常见的评价指标,而且很容易理解,就是被分对的样本数除以所有的样本数,通常来说,正确率越高,分类器越好。

2、错误率(Error rate) 错误率则与准确率相反,描述被分类器错分的比例, error rate = (FP+FN)/(TP+TN+FP+FN),对某一个实例来说,分对与分错是互斥事件,所以accuracy =1 - error rate。 3、灵敏度(sensitive) sensitive = TP/P,表示的是所有正例中被分对的比例,衡量了分类器对正例的识别能力。 4、特效度(sensitive) specificity = TN/N,表示的是所有负例中被分对的比例,衡量了分类器对负例的识别能力。 5、精确率、精度(Precision) 精确率(precision)定义为:

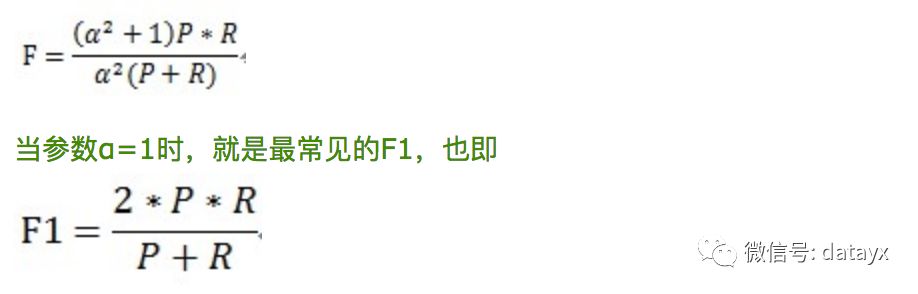

表示被分为正例的示例中实际为正例的比例。 6、召回率(recall) 召回率是覆盖面的度量,度量有多个正例被分为正例,recall=TP/(TP+FN)=TP/P=sensitive,可以看到召回率与灵敏度是一样的。 7、综合评价指标(F-Measure) P和R指标有时候会出现的矛盾的情况,这样就需要综合考虑他们,最常见的方法就是F-Measure(又称为F-Score)。

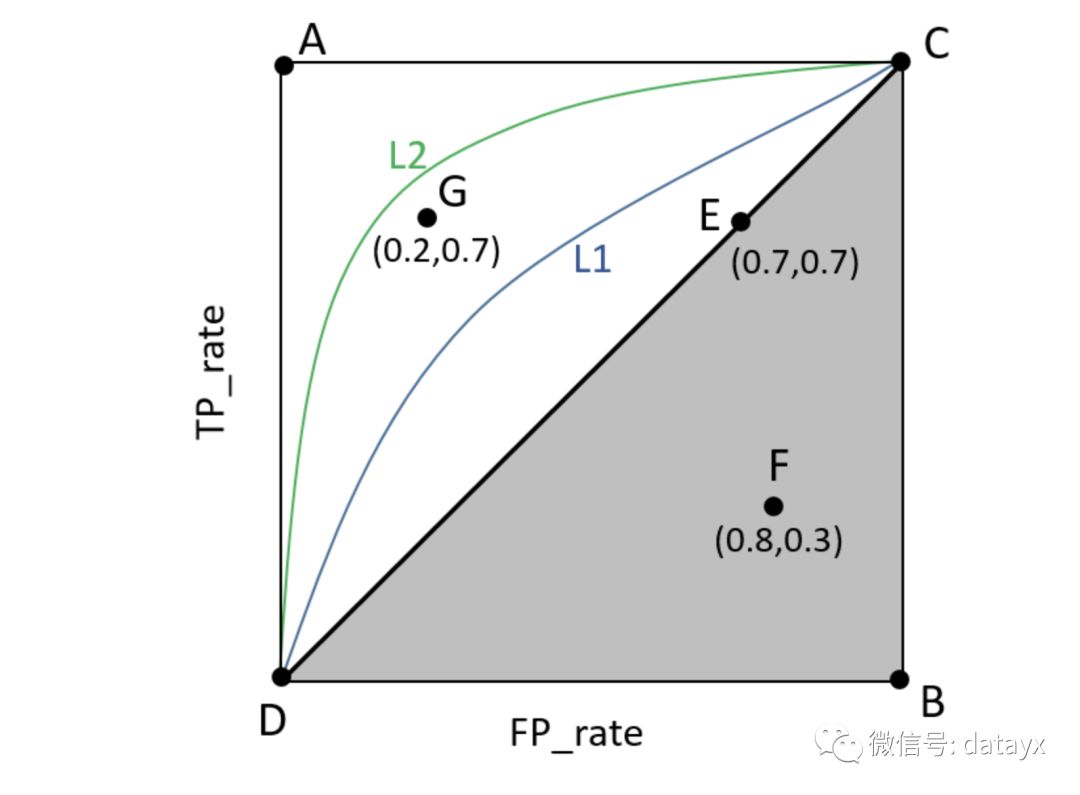

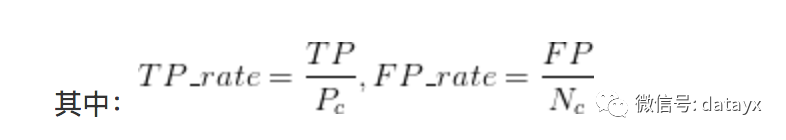

可知F1综合了P和R的结果,当F1较高时则能说明试验方法比较有效。 8、其他评价指标 计算速度:分类器训练和预测需要的时间; 鲁棒性:处理缺失值和异常值的能力; 可扩展性:处理大数据集的能力; 可解释性:分类器的预测标准的可理解性,像决策树产生的规则就是很容易理解的,而神经网络的一堆参数就不好理解,我们只好把它看成一个黑盒子。 下面来看一下ROC和PR曲线(以下内容为自己总结): 1、ROC曲线:

(1)曲线与FP_rate轴围成的面积(记作AUC)越大,说明性能越好,即图上L2曲线对应的性能优于曲线L1对应的性能。即:曲线越靠近A点(左上方)性能越好,曲线越靠近B点(右下方)曲线性能越差。

2、PR曲线:

阅读过本文的人还看了以下: 不断更新资源 深度学习、机器学习、数据分析、python 搜索公众号添加: datayx

长按图片,识别二维码,点关注 AI项目体验 https://loveai.tech

|

【本文地址】

今日新闻 |

推荐新闻 |

,因此FP_rate的值仍然很小(如果利用ROC曲线则会判断其性能很好,但是实际上其性能并不好),但是如果利用PR,因为Precision综合考虑了TP和FP的值,因此在极度不平衡的数据下(Positive的样本较少),PR曲线可能比ROC曲线更实用。

,因此FP_rate的值仍然很小(如果利用ROC曲线则会判断其性能很好,但是实际上其性能并不好),但是如果利用PR,因为Precision综合考虑了TP和FP的值,因此在极度不平衡的数据下(Positive的样本较少),PR曲线可能比ROC曲线更实用。