AAAI 2021 |

您所在的位置:网站首页 › flash歌词怎么和音乐对齐 › AAAI 2021 |

AAAI 2021

|

©作者 | 盛中昊 学校 | 北京大学硕士 研究方向 | 自然语言处理 本工作由北京大学 KCL 实验室与南京理工大学、微软亚洲研究院、浙江大学共同提出。KCL(Knowledge Computing Lab,知识计算实验室)是北大软件工程国家工程研究中心一支 20 多人的研究团队,主要研究领域包括:信息抽取、信息检索、文本生成、程序语言理解等。

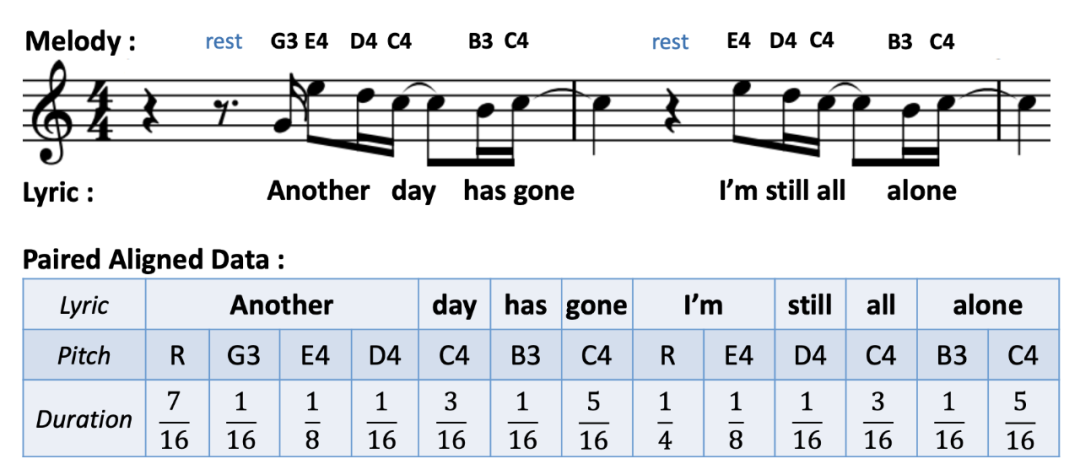

本文介绍我们发表于 AAAI 2021 的论文《SongMASS: Automatic Song Writing with Pre-training and Alignment Constraint》。该论文提出了 SongMASS,一种歌曲旋律生成和歌词文本生成的方法。我们使用扩展的 Masked Seq2Seq (MASS)预训练方法缓解平行语料稀缺的问题,设计句子级和字符级的注意力约束增强歌词和旋律对齐,并在推理阶段使用动态规划算法对齐歌词和旋律。

论文标题: SongMASS: Automatic Song Writing with Pre-training and Alignment Constraint 论文作者: Zhonghao Sheng, Kaitao Song, Xu Tan, Yi Ren, Wei Ye, Shikun Zhang, Tao Qin 论文链接: https://arxiv.org/pdf/2012.05168.pdf

背景 自动歌曲写作在学术界和工业界一直是令人感兴趣的话题,由歌词生成旋律(Lyric-to-Melody,L2M)和由旋律生成歌词(Melody-to-Lyric,M2L)是其中两个重要的任务。歌词和旋律都可以被表示为离散序列,使用 Seq2Seq 的方式建模。 L2M 和 M2L 任务有两个难点:(1)歌词和旋律之间的相关性较弱,这使得任务需要大量的平行语料去学习这种跨模态的映射关系,但大量的平行语料是难以获得的;(2)歌词中的一个词或音节需要和旋律中的一个或多个音符严格对齐,这需要模型额外生成这种对齐关系。之前的工作通常都只使用少量的平行语料训练模型,使用简单的贪婪策略进行对齐,使得生成效果差强人意。 针对平行语料稀缺的问题,我们首次将预训练技术应用在 L2M 和 M2L 任务上。MASS 是 Seq2seq 学习任务中一项成功的预训练技术,我们将 MASS 方法从句子级扩展到歌曲(篇章)级,使用大规模非平行语料进行无监督预训练,并利用少量平行语料进行有监督约束。在歌词与旋律对齐方面,我们设计了句子级和字符级的注意力约束增强对齐。在推理阶段,我们基于注意力权重使用动态规划算法全局地生成歌词和旋律的严格对齐。 实验结果充分证明相比于 Baseline,我们提出的 SongMASS 大幅度提升了歌词到旋律、旋律到歌词的生成效果。

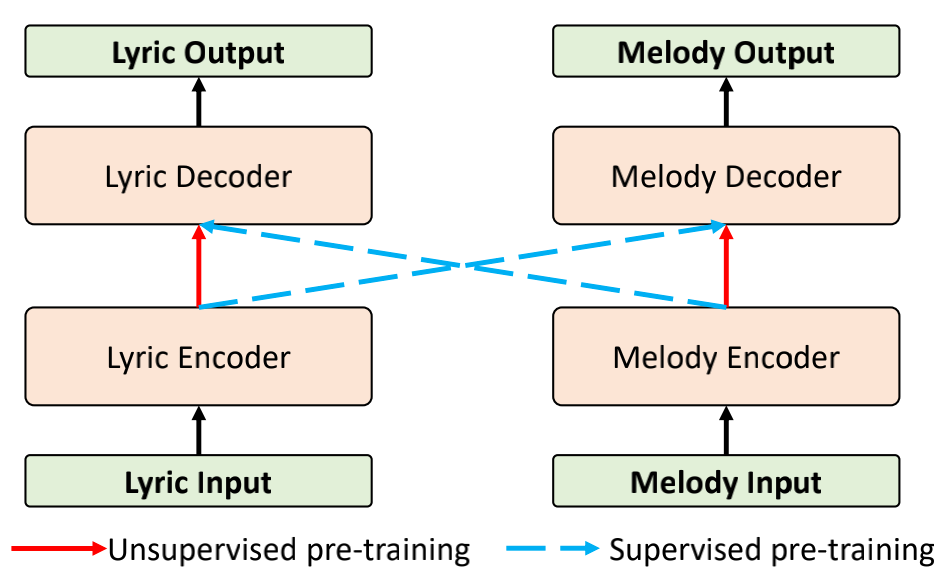

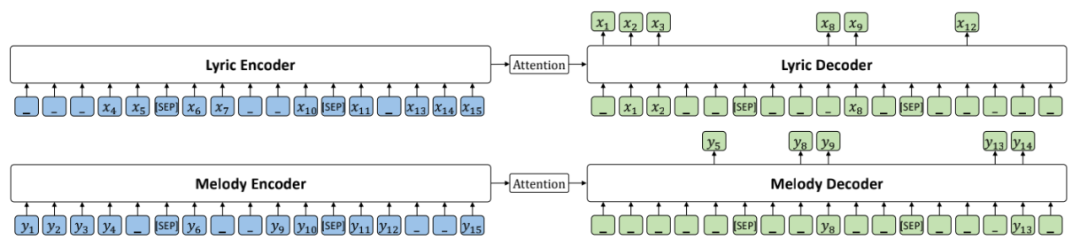

整体架构 下图是我们提出的 SongMASS 的整体架构,架构基于 Transformer 的编解码器结构。由于歌词和旋律之间的模态差异性巨大,我们对歌词和旋律分别使用独立的编解码器。

SongMASS 主要包含以下几个部分: 1)歌曲(篇章)级 MASS 预训练(上图红色箭头); 2)预训练过程中的有监督约束(上图蓝色箭头); 3)句子级和字符级的对齐约束; 4)基于动态规划的全局对齐。 下文将具体展开介绍。

歌曲(篇章)级MASS预训练 MASS 方法在句子级的 seq2seq 任务中取得了巨大成功。在自动歌曲写作的任务中,我们希望模型能捕捉整首歌的上下文信息,因此我们将 MASS 方法扩展到了歌曲(篇章)级的预训练。扩展的 mask 策略如下图所示,编码器输入含有多段屏蔽的歌曲序列,解码器解码出整个歌曲所有被屏蔽的部分。其中,我们在整首歌的句子与句子之间加入 [SEP] 作为边界标识。

我们让 X’ 和 Y’ 分别代表非平行的歌词和旋律语料,歌曲级的 MASS 公式如下:

S 表示的是 x 中句子的数目, 表示的是含有屏蔽的歌曲序列, |

【本文地址】

今日新闻 |

推荐新闻 |