【大模型】LLM显存占用对比:Qwen |

您所在的位置:网站首页 › eth要多大显存 › 【大模型】LLM显存占用对比:Qwen |

【大模型】LLM显存占用对比:Qwen

|

【大模型】LLM显存占用对比:Qwen-7B-Chat,Qwen-14B-Chat-Int8,chatglm3-6b

显存占用对比:总结参考

显存占用对比:

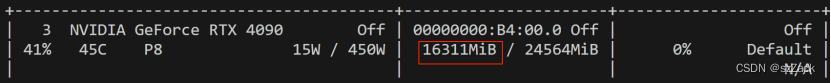

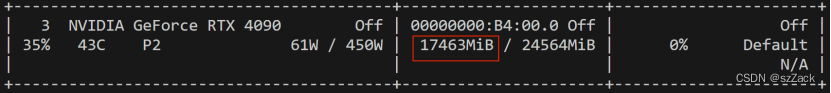

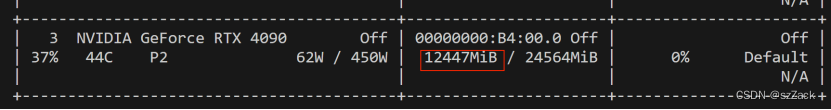

显卡:NVIDIA GeForce RTX 4090 系统环境:ubuntu 22.04LTS Qwen-14B-Chat-Int8 模型:qwen/Qwen-14B-Chat-Int8 GPU占用: Qwen-7B-Chat 模型:qwen/Qwen-7B-Chat(bf16, fp16) GPU占用: chatglm3-6b 模型:ZhipuAI/chatglm3-6b(bf16, fp16) GPU占用: 总结下来就是能用fp16就用fp16,能用Int8就用Int8,能用int4就用int4。 量化对降低显存占用还是非常不错。 参考 https://modelscope.cn/models/qwen/Qwen-14B-Chat-Int8/summaryhttps://modelscope.cn/models/qwen/Qwen-7B-Chat/summaryhttps://modelscope.cn/models/ZhipuAI/chatglm3-6b/summary |

【本文地址】

今日新闻 |

推荐新闻 |