EM算法原理总结 |

您所在的位置:网站首页 › em算法csdn › EM算法原理总结 |

EM算法原理总结

|

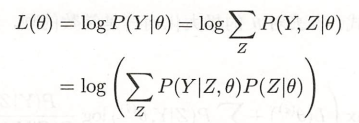

EM算法是一种迭代算法,用于含有隐变量的概率模型参数的极大似然估计。 EM算法的每次迭代由两步字组成:E步,求期望;M步,求极大。所以EM算法也称为期望极大算法(expectation maximization algorithm)。 如果概率模型的变量都是观测变量,那么给定数据,可以直接使用极大似然估计法或者贝叶斯估计法估计模型参数。但是,当模型含有隐变量时,就不能简单地用这些估计方法,只能通过迭代的方法求解。 目录 1 EM算法的引入 1.1 EM算法 1.2 EM算法的导出 2 EM算法在高斯混合模型学习中的应用 2.1 高斯混合模型 2.2 高斯混合模型参数估计的EM算法 1 EM算法的引入 1.1 EM算法 一般地,用Y表示观测变量的数据 ,Z边是隐随机变量的数据,Y和Z连在一起称为完全数据,观测数据Y又称为不完全数据。

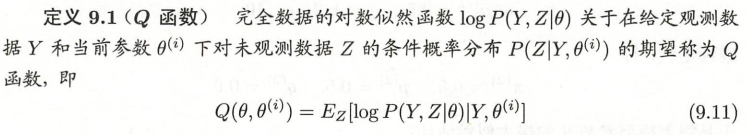

Q函数

我们面对一个含有隐变量的概率模型,目标是极大化观测数据(不完全数据)Y关于 这一极大化的主要困难是式中有未观测数据并有包含和(或积分)的对数。

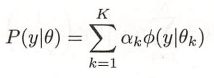

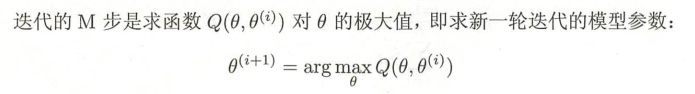

式(9.17)等价于EM算法的一次迭代,即求Q函数及其极大化。EM算法是通过不断求解下界的极大化逼近求解对数似然函数极大化的算法。 2 EM算法在高斯混合模型学习中的应用 高斯混合模型应用广泛,在许多情况下,EM算法是学习高斯混合模型(Gaussian mixture model)的有效方法。 2.1 高斯混合模型

假设观测数据 其中, 1.明确隐变量,写出完全数据的对数似然函数。

2. EM算法的E步:确定Q函数

3. 确定EM算法的M步

|

【本文地址】

今日新闻 |

推荐新闻 |