|

嗨嗨,我是小圆。

相信大家都会看小说,但是有些小说看几章就要付费,奈何自己又没有会员,只能用用python爬取一下了。

基本开发环境

Python 3.6 Pycharm

相关模块的使用

requests parsel

安装Python并添加到环境变量,pip安装需要的相关模块即可。

单章爬取

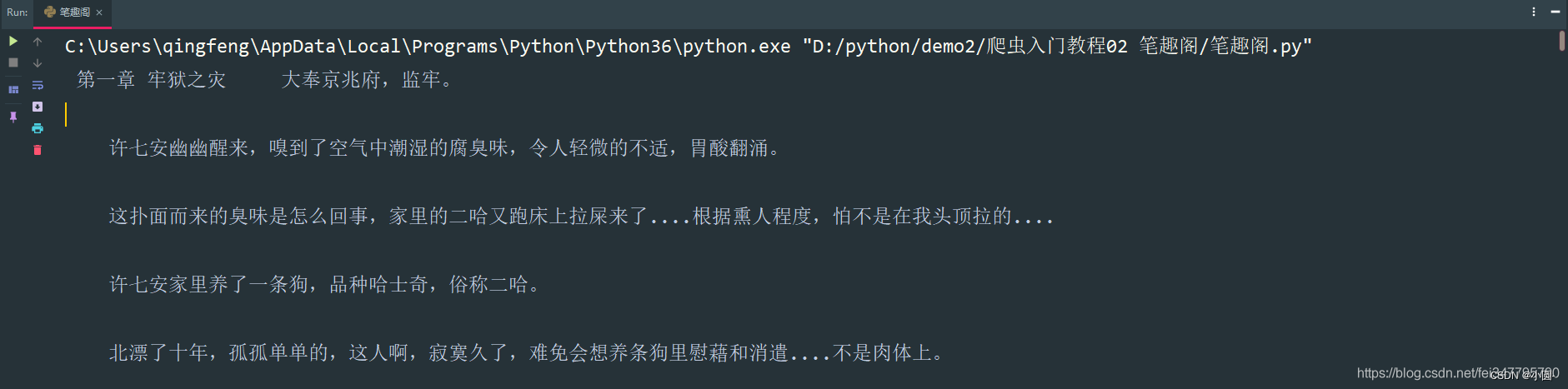

一、明确需求 爬取小说内容保存到本地 一、明确需求 爬取小说内容保存到本地

小说名字小说章节名字小说内容

# 第一章小说url地址

url = 'http://www.平台原因自己打.com/52_52642/25585323.html'

url = 'http://www.平台原因自己打.com/52_52642/25585323.html'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36'

}

response = requests.get(url=url, headers=headers)

print(response.text)

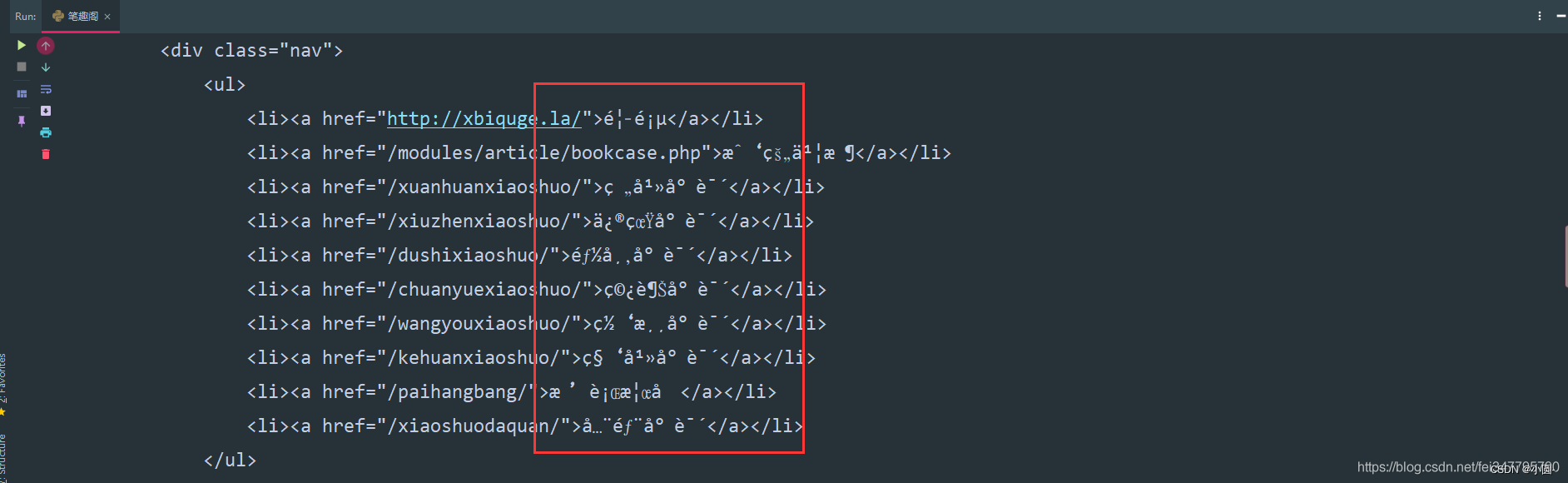

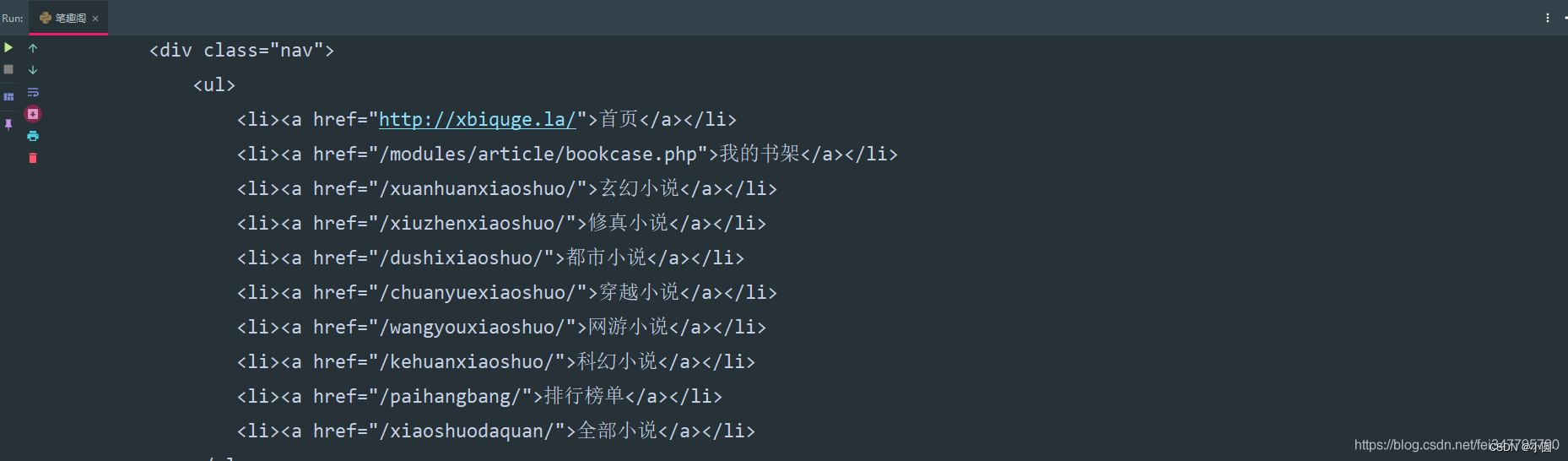

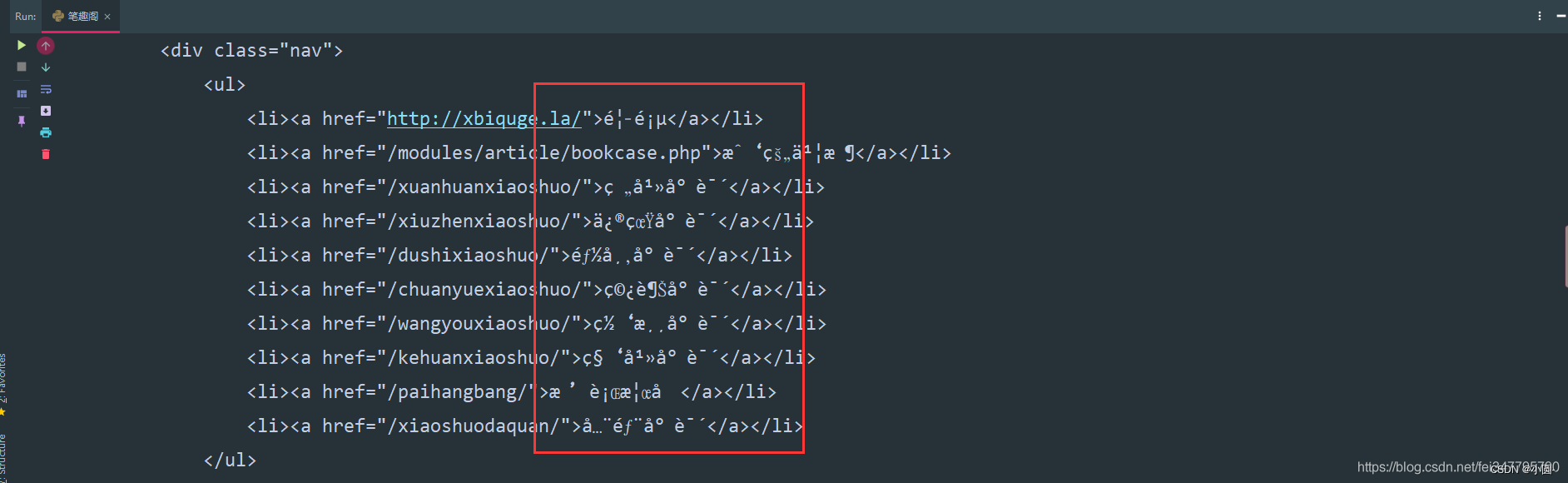

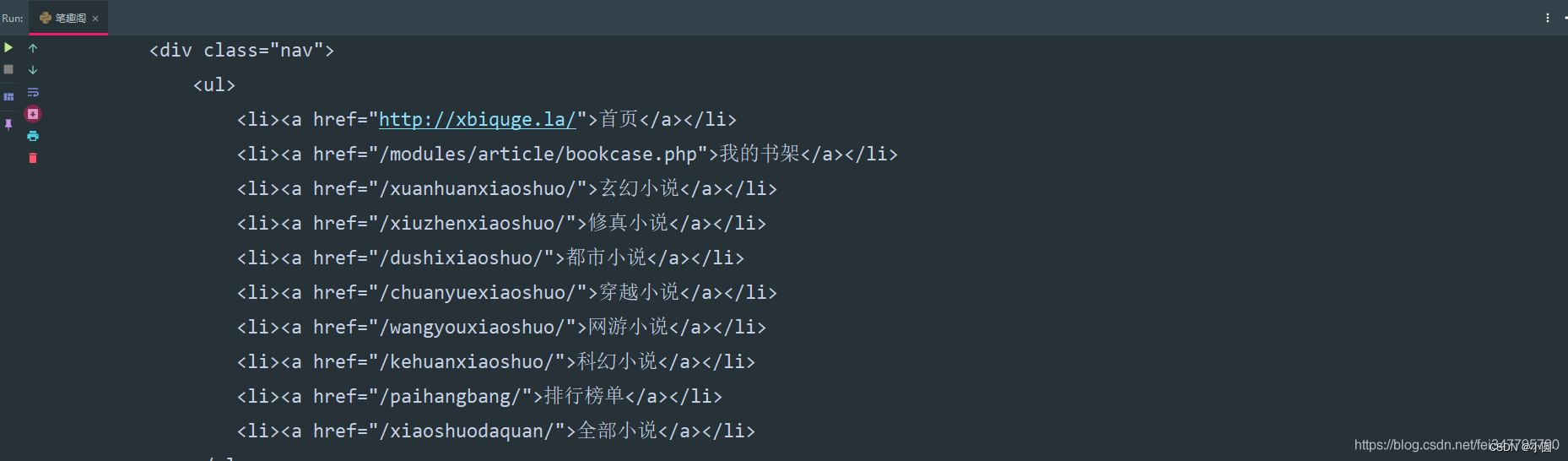

请求网页返回的数据中出现了乱码,这就需要我们转码了。 请求网页返回的数据中出现了乱码,这就需要我们转码了。

加一行代码自动转码。

response.encoding = response.apparent_encoding

解析数据

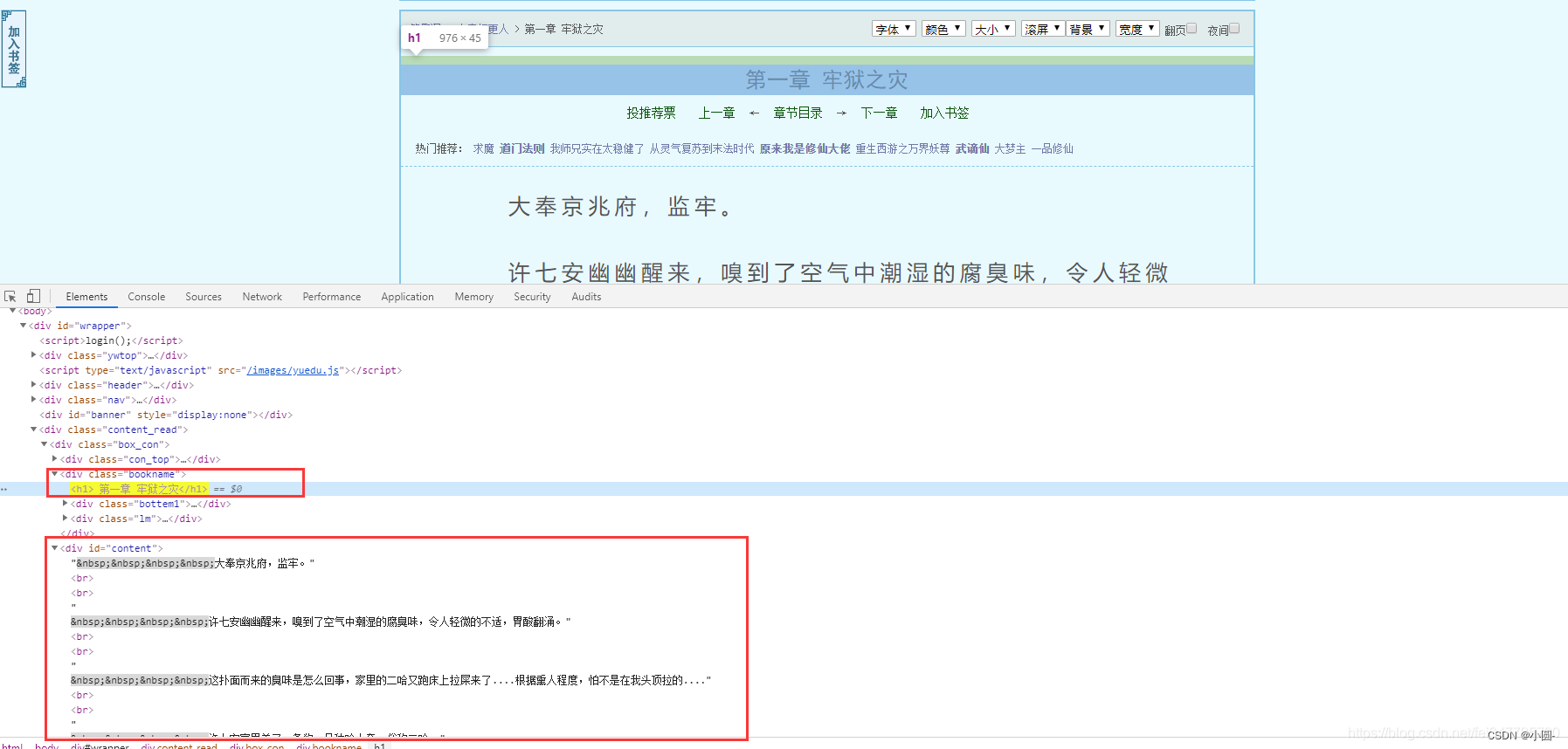

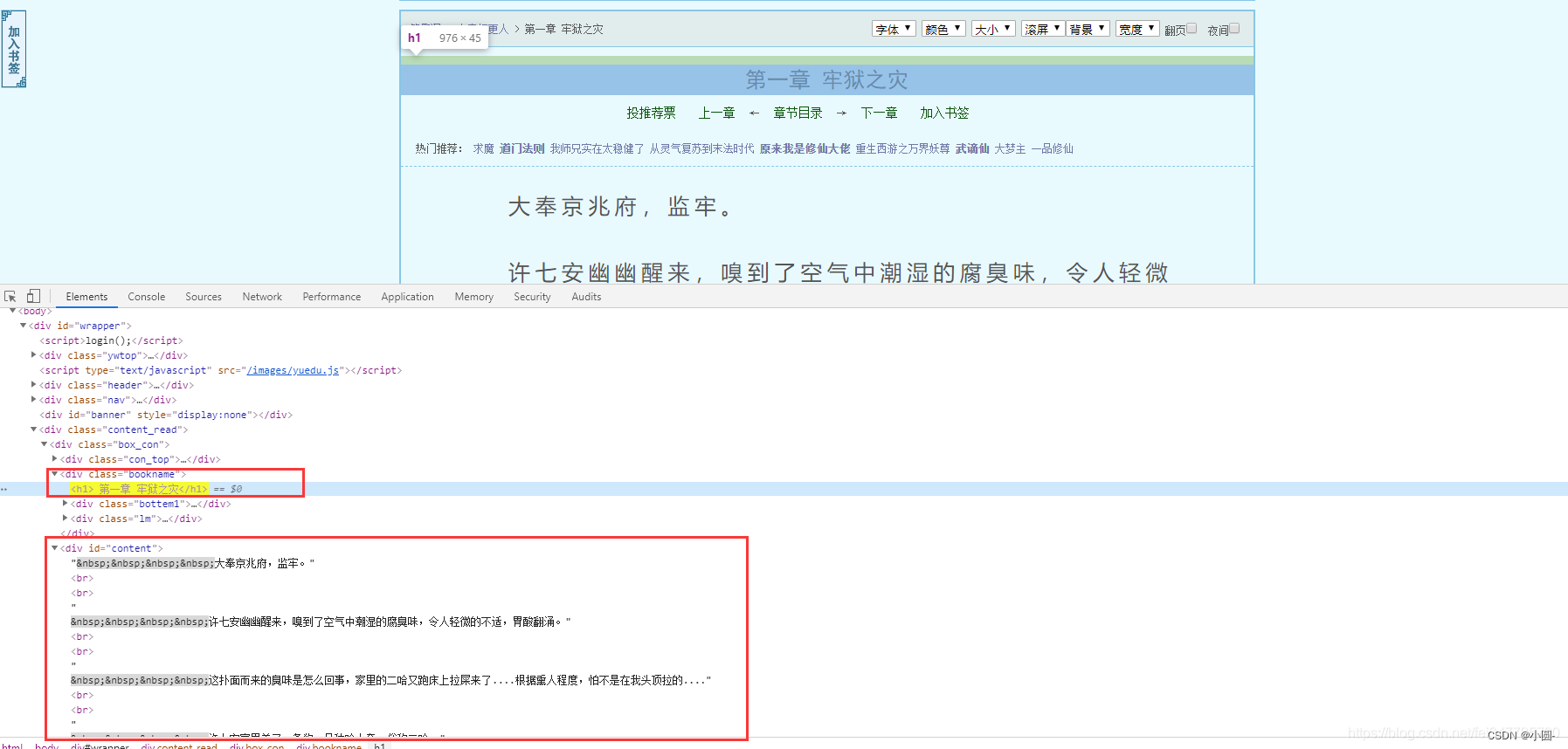

根据css选择器可以直接提取小说标题以及小说内容。 根据css选择器可以直接提取小说标题以及小说内容。

def get_one_novel(html_url):

# 调用请求网页数据函数

response = get_response(html_url)

# 转行成selector解析对象

selector = parsel.Selector(response.text)

# 获取小说标题

title = selector.css('.bookname h1::text').get()

# 获取小说内容 返回的是list

content_list = selector.css('#content::text').getall()

# ''.join(列表) 把列表转换成字符串

content_str = ''.join(content_list)

print(title, content_str)

if __name__ == '__main__':

url = 'http://www.biquges.com/52_52642/25585323.html'

get_one_novel(url)

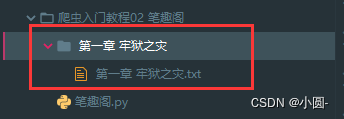

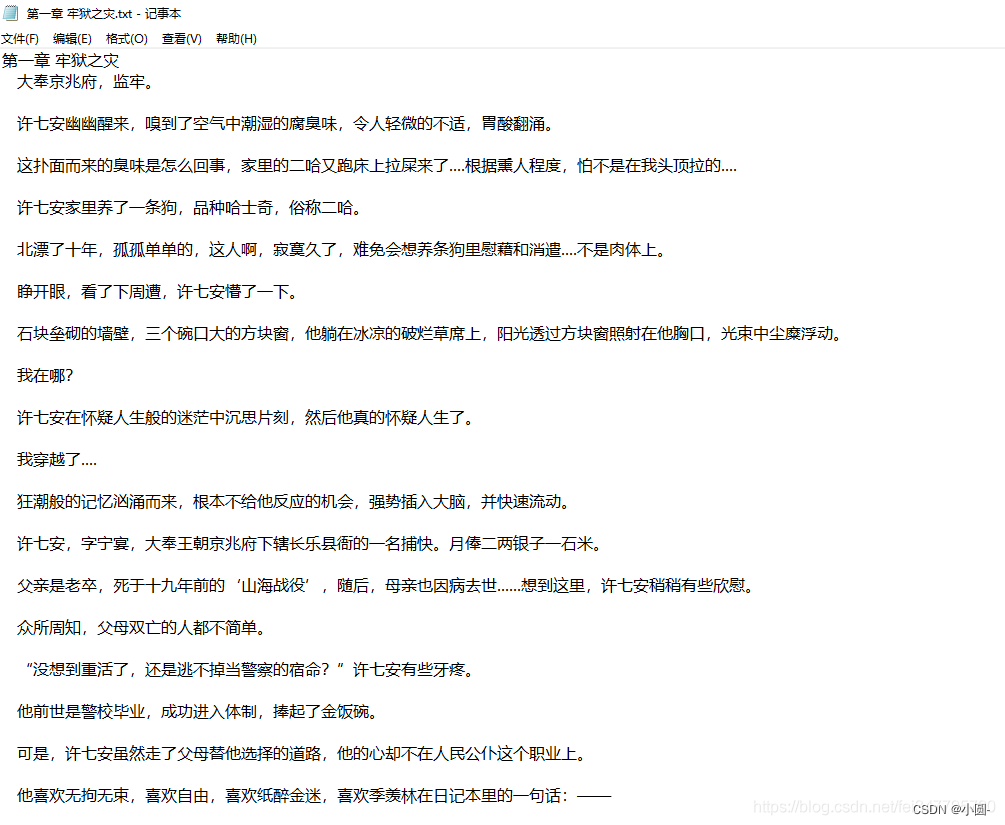

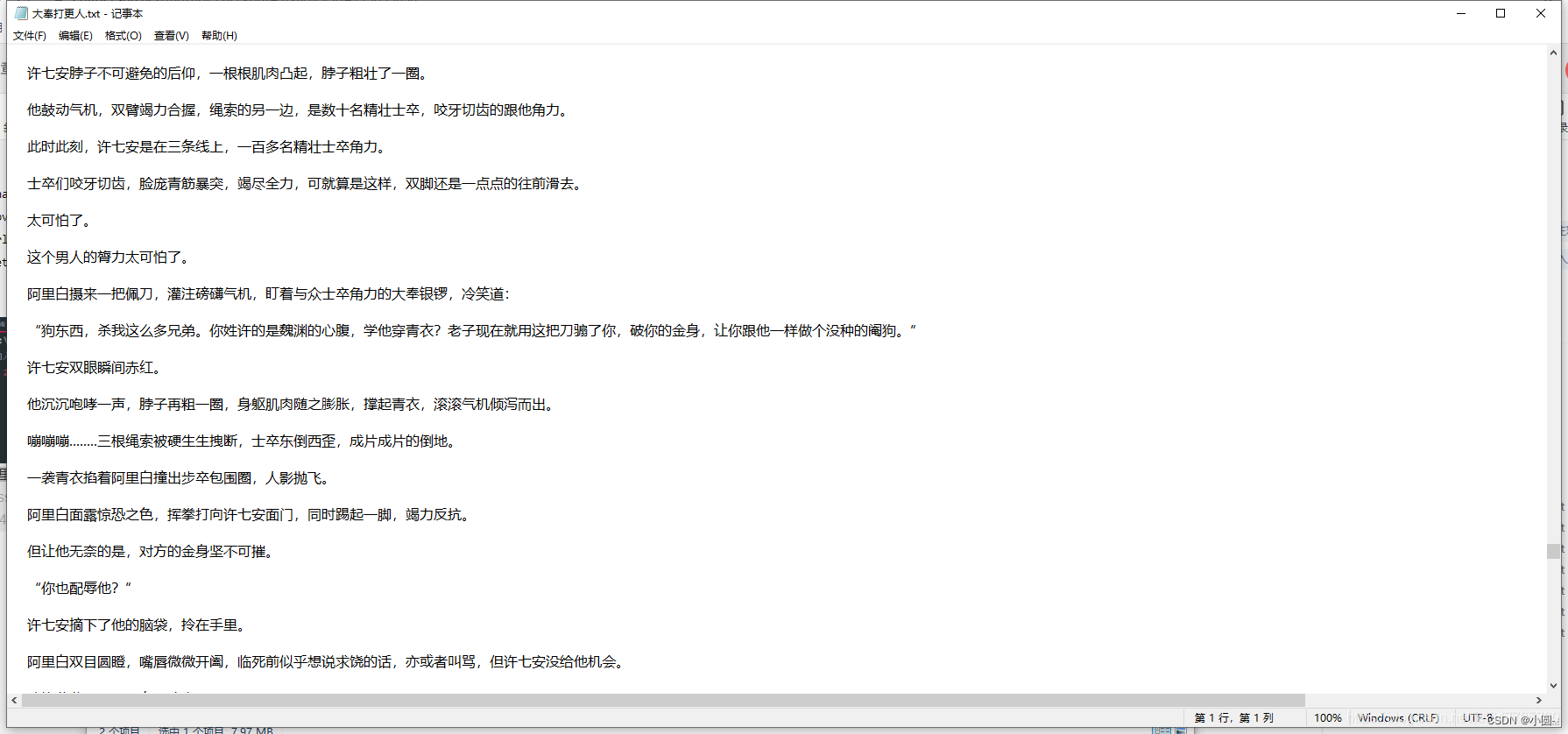

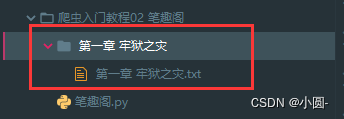

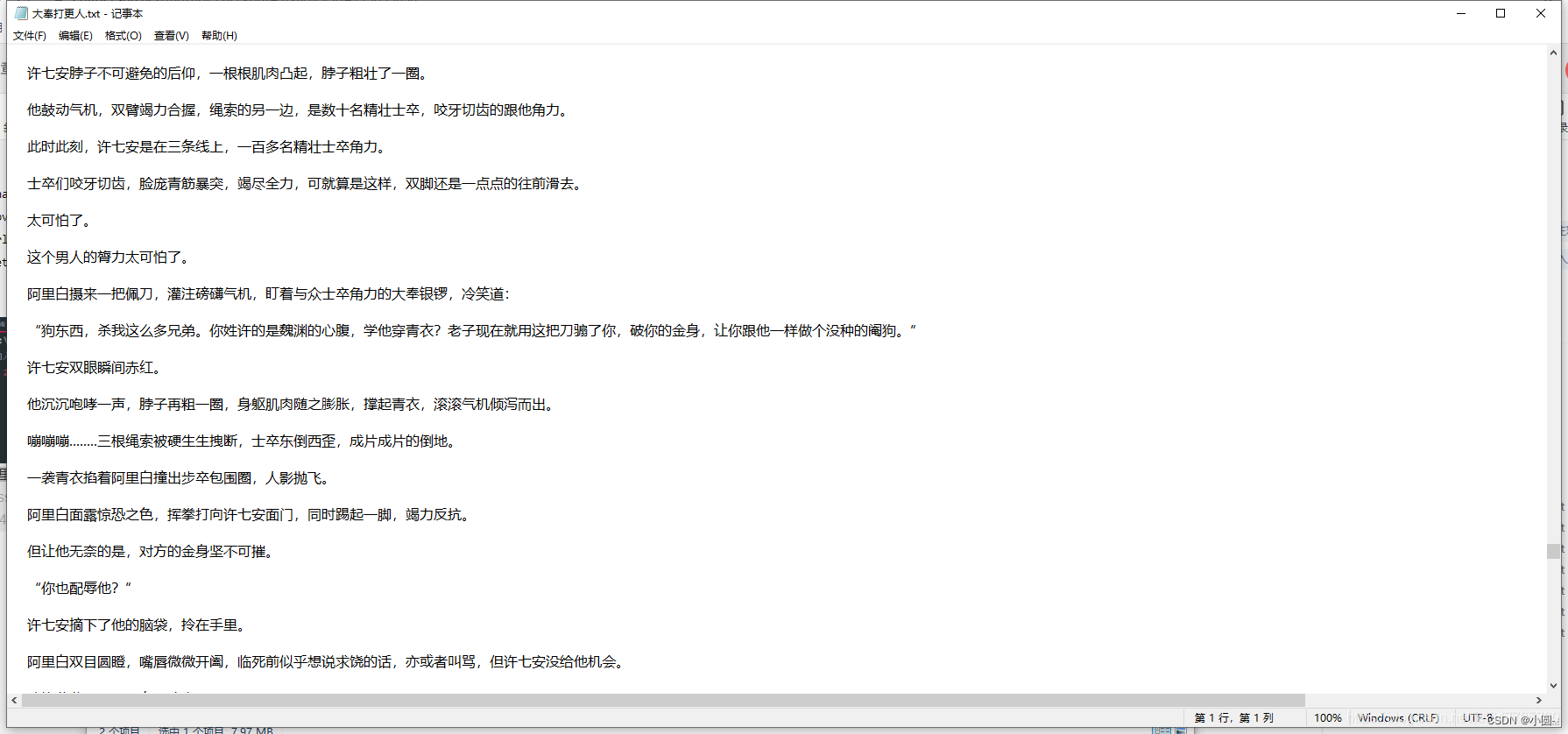

保存数据(数据持久化)

使用常用的保存方式: with open

def save(title, content):

"""

保存小说

:param title: 小说章节标题

:param content: 小说内容

:return:

"""

# 路径

filename = f'{title}\\'

# os 内置模块,自动创建文件夹

if os.makedirs(filename):

os.mkdir()

# 一定要记得加后缀 .txt mode 保存方式 a 是追加保存 encoding 保存编码

with open(filename + title + '.txt', mode='a', encoding='utf-8') as f:

# 写入标题

f.write(title)

# 换行

f.write('\n')

# 写入小说内容

f.write(content)

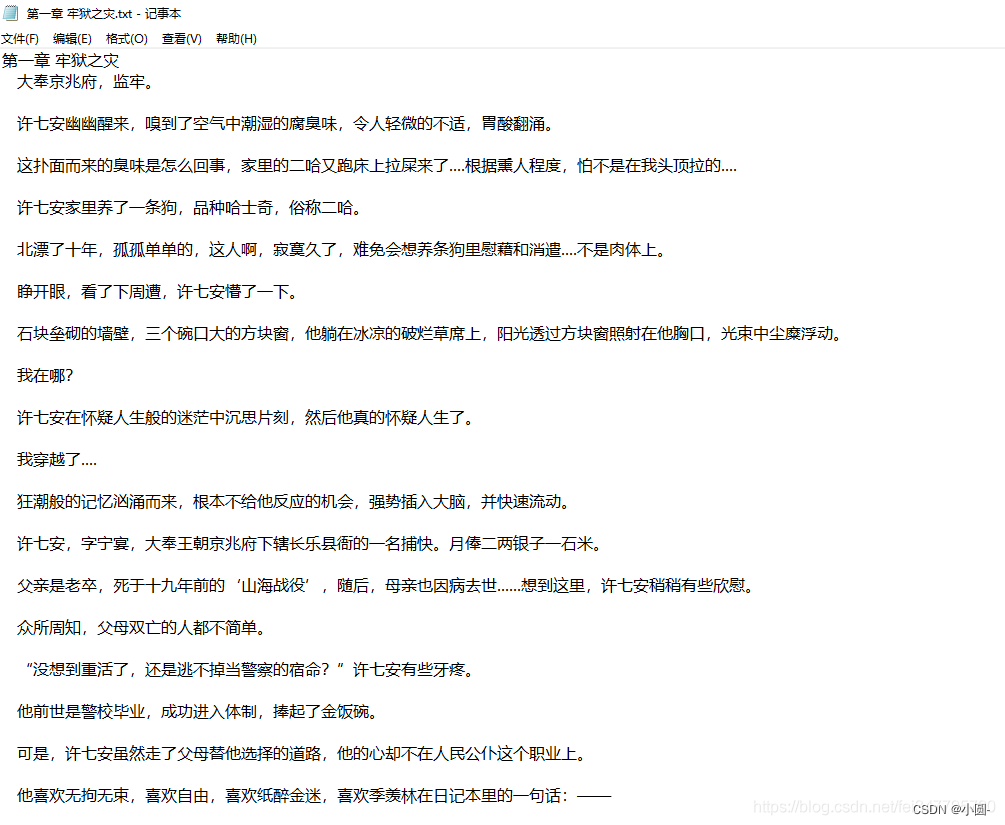

保存一章小说,就这样写完了,如果想要保存整本小说呢? 保存一章小说,就这样写完了,如果想要保存整本小说呢?

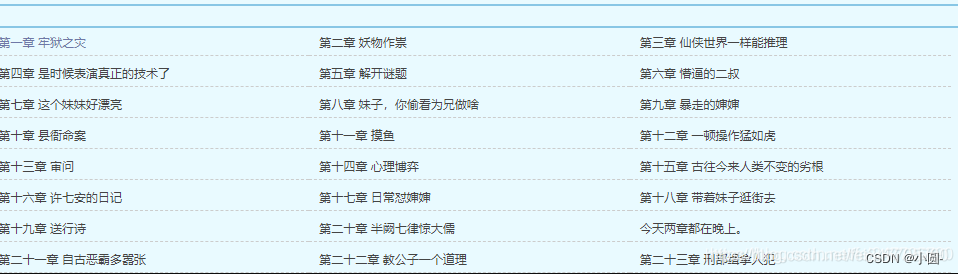

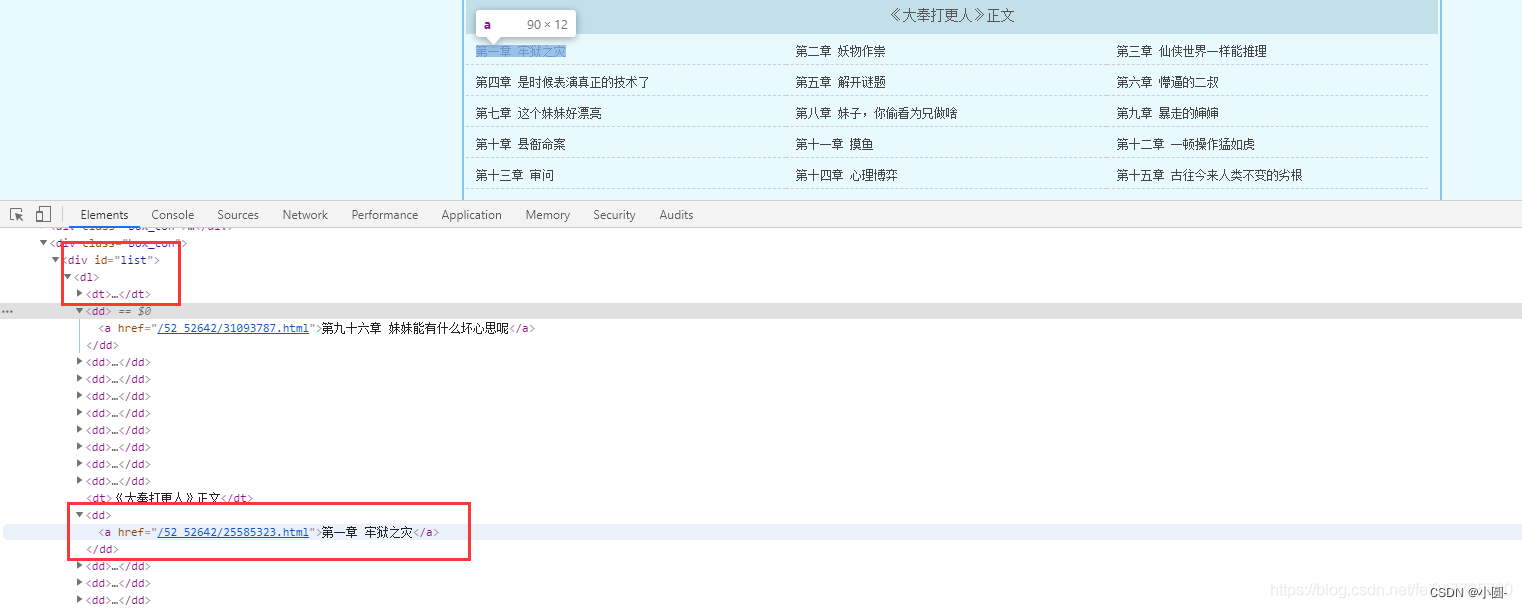

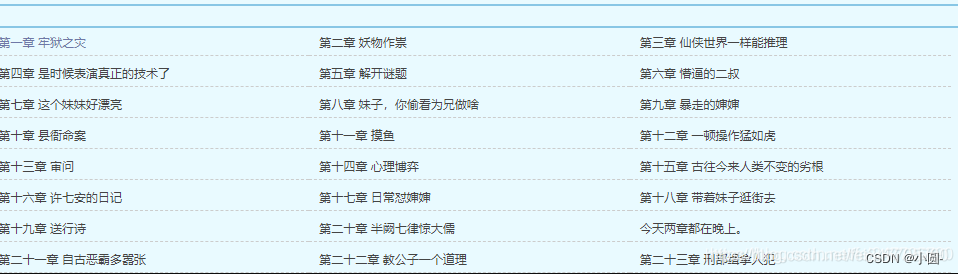

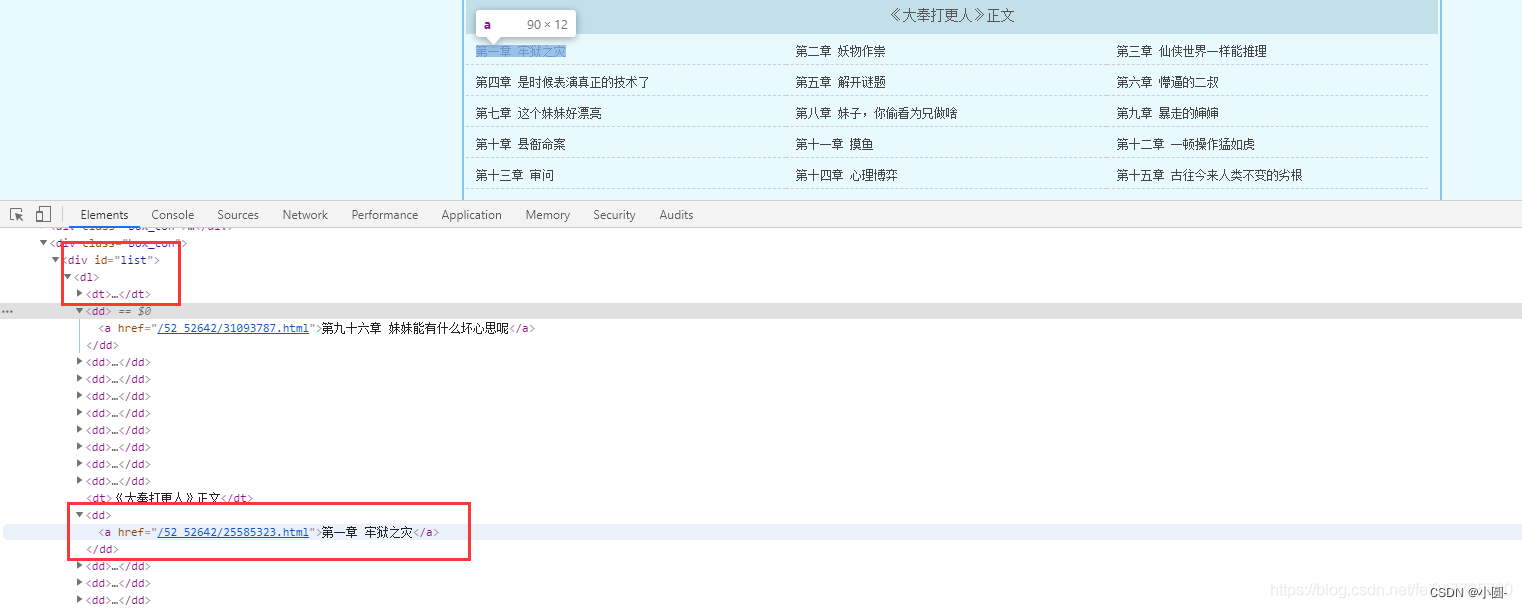

整本小说爬虫

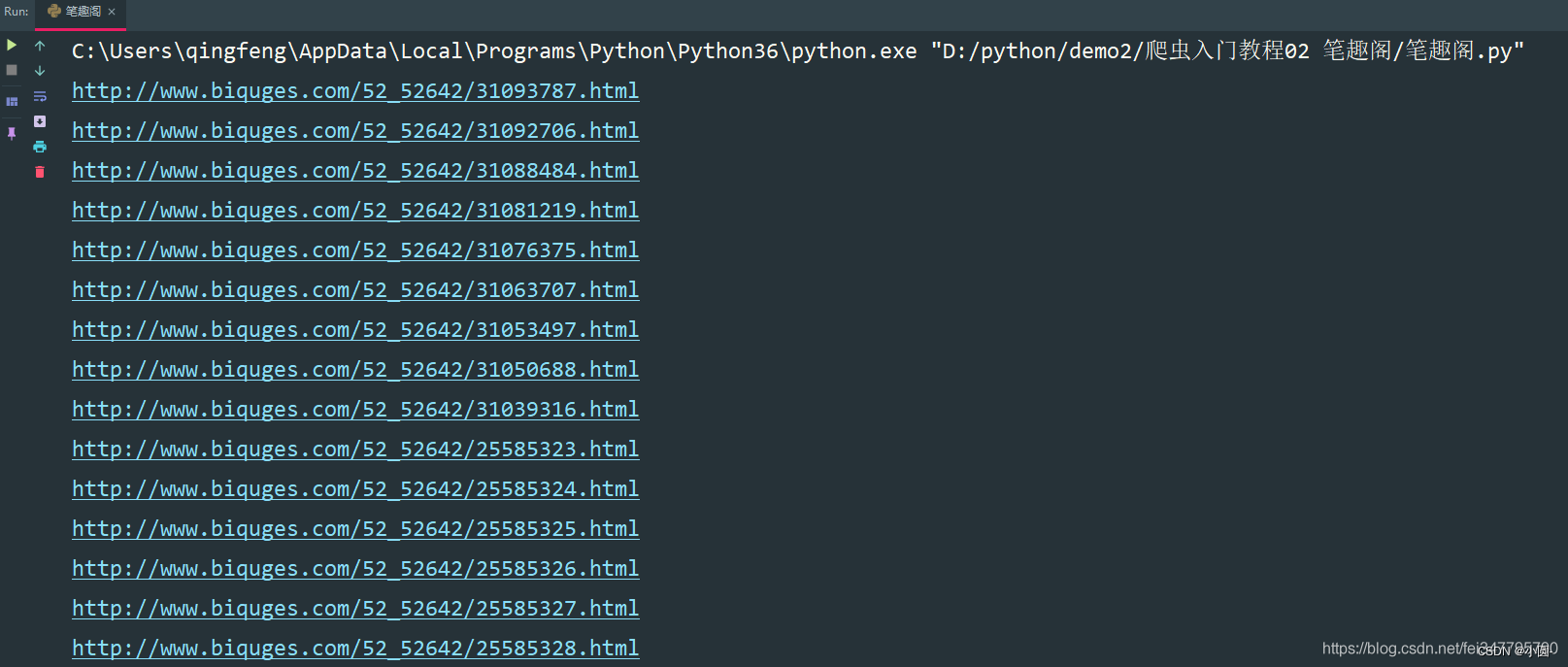

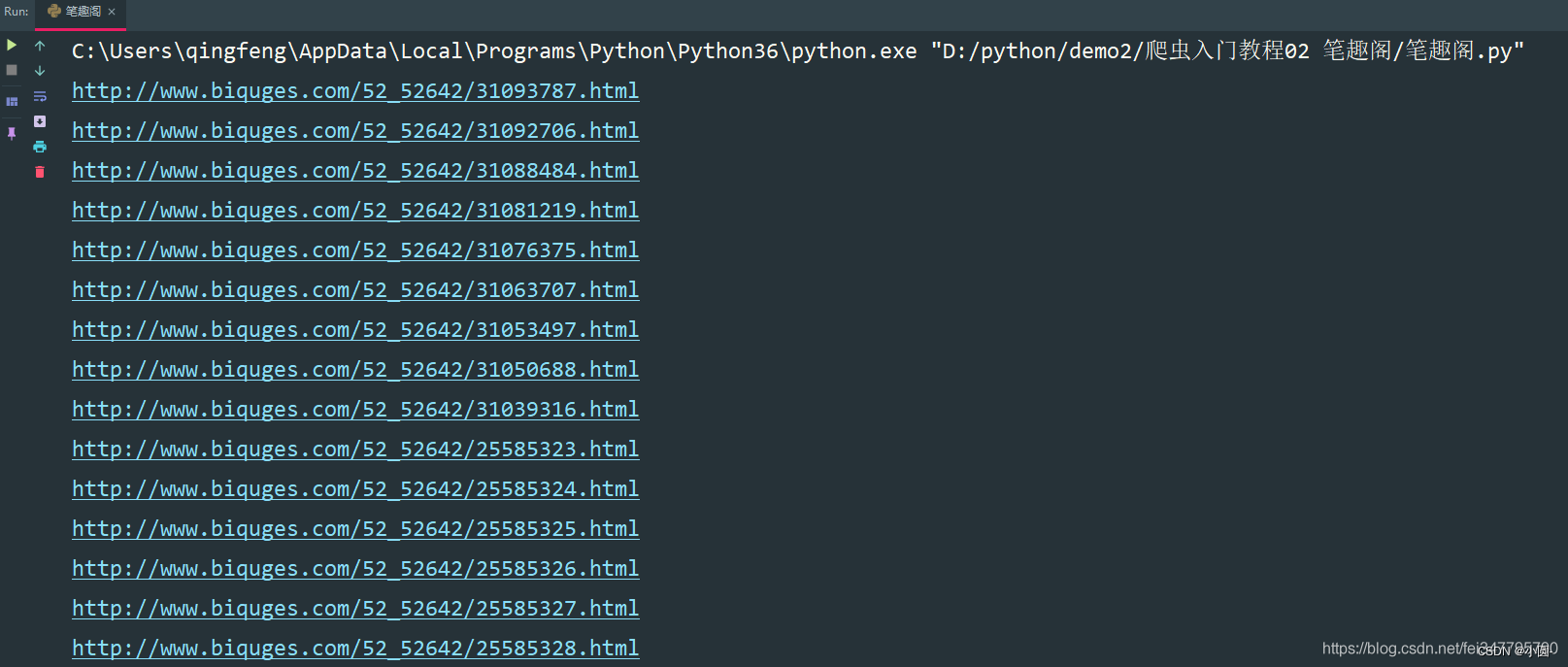

既然爬取单章小说知道怎么爬取了,那么只需要获取小说所有单章小说的url地址,就可以爬取全部小说内容了。  所有的单章的url地址都在 dd 标签当中,但是这个url地址是不完整的,所以爬取下来的时候,要拼接url地址。 所有的单章的url地址都在 dd 标签当中,但是这个url地址是不完整的,所以爬取下来的时候,要拼接url地址。

def get_all_url(html_url):

# 调用请求网页数据函数

response = get_response(html_url)

# 转行成selector解析对象

selector = parsel.Selector(response.text)

# 所有的url地址都在 a 标签里面的 href 属性中

dds = selector.css('#list dd a::attr(href)').getall()

for dd in dds:

novel_url = 'http://www.平台原因自己打.com' + dd

print(novel_url)

if __name__ == '__main__':

url = 'http://www.平台原因自己打.com/52_52642/index.html'

get_all_url(url)

这样就获取了所有的小说章节url地址了。 这样就获取了所有的小说章节url地址了。

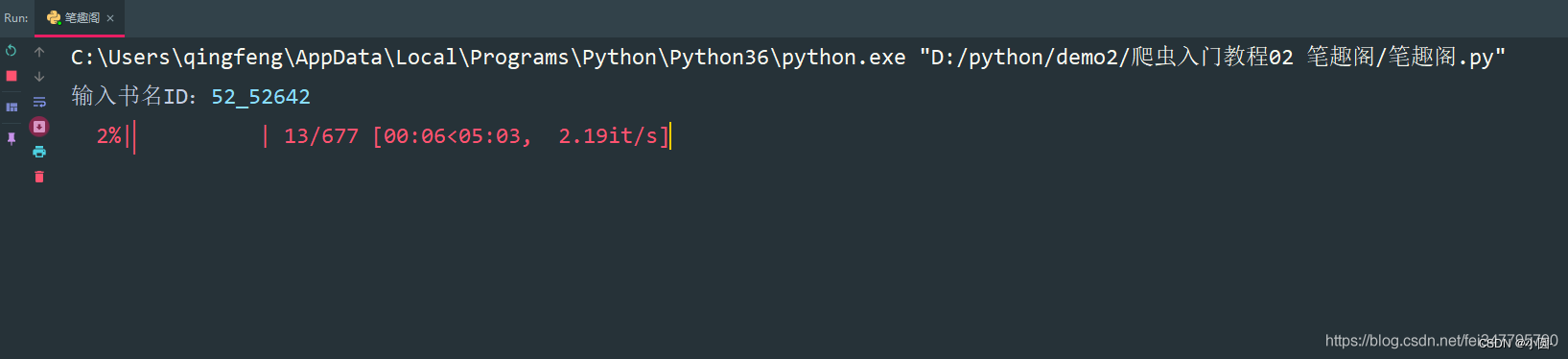

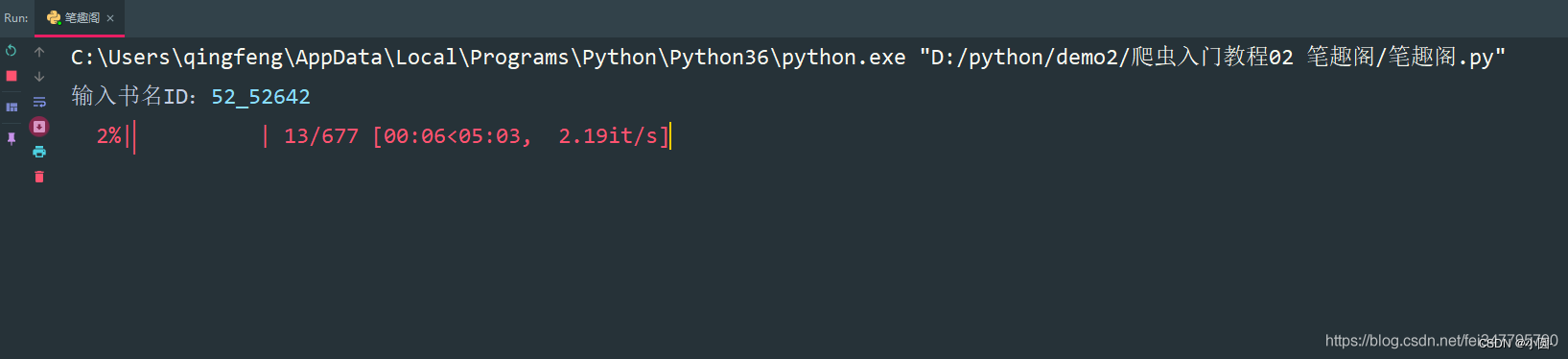

爬取全本完整代码

import requests

import parsel

from tqdm import tqdm

def get_response(html_url):

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36'

}

response = requests.get(url=html_url, headers=headers)

response.encoding = response.apparent_encoding

return response

def save(novel_name, title, content):

"""

保存小说

:param title: 小说章节标题

:param content: 小说内容

:return:

"""

filename = f'{novel_name}' + '.txt'

# 一定要记得加后缀 .txt mode 保存方式 a 是追加保存 encoding 保存编码

with open(filename, mode='a', encoding='utf-8') as f:

# 写入标题

f.write(title)

# 换行

f.write('\n')

# 写入小说内容

f.write(content)

def get_one_novel(name, novel_url):

# 调用请求网页数据函数

response = get_response(novel_url)

# 转行成selector解析对象

selector = parsel.Selector(response.text)

# 获取小说标题

title = selector.css('.bookname h1::text').get()

# 获取小说内容 返回的是list

content_list = selector.css('#content::text').getall()

# ''.join(列表) 把列表转换成字符串

content_str = ''.join(content_list)

save(name, title, content_str)

def get_all_url(html_url):

# 调用请求网页数据函数

response = get_response(html_url)

# 转行成selector解析对象

selector = parsel.Selector(response.text)

# 所有的url地址都在 a 标签里面的 href 属性中

dds = selector.css('#list dd a::attr(href)').getall()

# 小说名字

novel_name = selector.css('#info h1::text').get()

for dd in tqdm(dds):

novel_url = 'http://www.biquges.com' + dd

get_one_novel(novel_name, novel_url)

if __name__ == '__main__':

novel_id = input('输入书名ID:')

url = f'http://www.biquges.com/{novel_id}/index.html'

get_all_url(url)

好了,分享到这里就结束了,感兴趣的朋友赶紧去试试吧! 好了,分享到这里就结束了,感兴趣的朋友赶紧去试试吧!

|

一、明确需求 爬取小说内容保存到本地

一、明确需求 爬取小说内容保存到本地 请求网页返回的数据中出现了乱码,这就需要我们转码了。

请求网页返回的数据中出现了乱码,这就需要我们转码了。

根据css选择器可以直接提取小说标题以及小说内容。

根据css选择器可以直接提取小说标题以及小说内容。

保存一章小说,就这样写完了,如果想要保存整本小说呢?

保存一章小说,就这样写完了,如果想要保存整本小说呢? 所有的单章的url地址都在 dd 标签当中,但是这个url地址是不完整的,所以爬取下来的时候,要拼接url地址。

所有的单章的url地址都在 dd 标签当中,但是这个url地址是不完整的,所以爬取下来的时候,要拼接url地址。 这样就获取了所有的小说章节url地址了。

这样就获取了所有的小说章节url地址了。

好了,分享到这里就结束了,感兴趣的朋友赶紧去试试吧!

好了,分享到这里就结束了,感兴趣的朋友赶紧去试试吧!