|

这里写自定义目录标题

环境配置准备自己的数据集(voc格式)训练模型模型测试模型推理模型优化

环境配置

本教程所用环境:代码是最新的版本V6.0,源码下载地址:https://github.com/ultralytics/yolov5.git Pytorch:1.7.1 Cuda:10.1 Python:3.6 官方要求Python>=3.8 and PyTorch>=1.6. 通过git clone https://github.com/ultralytics/yolov5.git将YOLOv5源码下载到本地,创建好虚拟环境,并通过pip install -r requirements.txt安装依赖包。

准备自己的数据集(voc格式)

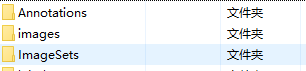

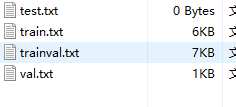

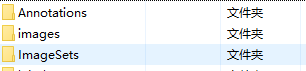

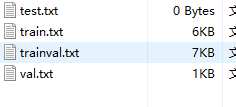

1.在yolov5目录下创建paper_data文件夹(名字可以自定义)将之前labelImg标注好的xml文件和图片放到对应目录下,目录结构如下: paper_data ——images # 存放图片 ——Annotations # 存放图片对应的xml文件 ——ImageSets/Main #之后会在Main文件夹内自动生成train.txt,val.txt,test.txt和trainval.txt四个文件,存放训练集、验证集、测试集图片的名字(无后缀.jpg)

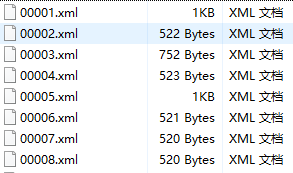

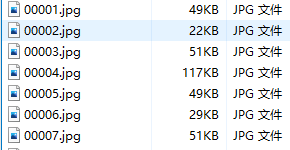

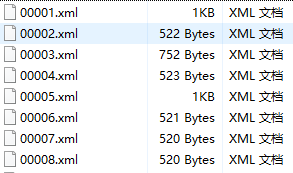

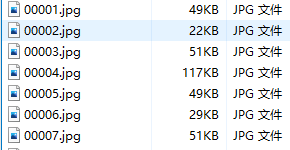

示例如下: paper_data文件夹下内容如下:  Annotations文件夹下面为xml文件(标注工具采用labelImage),内容如下: Annotations文件夹下面为xml文件(标注工具采用labelImage),内容如下:  images主要存放数据集的图片,内容如下: images主要存放数据集的图片,内容如下:

ImageSets文件夹下面有个Main子文件夹,其下面存放训练集、验证集、测试集的划分,通过脚本生成,可以在该路径下创建一个split.py文件,代码内容如下: ImageSets文件夹下面有个Main子文件夹,其下面存放训练集、验证集、测试集的划分,通过脚本生成,可以在该路径下创建一个split.py文件,代码内容如下:

# coding:utf-8

import os

import random

import argparse

parser = argparse.ArgumentParser()

#xml文件的地址,根据自己的数据进行修改 xml一般存放在Annotations下

parser.add_argument('--xml_path', default='paper_data/Annotations', type=str, help='input xml label path')

#数据集的划分,地址选择自己数据下的ImageSets/Main

parser.add_argument('--txt_path', default='ImageSets/Main', type=str, help='output txt label path')

opt = parser.parse_args()

trainval_percent = 1.0

train_percent = 0.9

xmlfilepath = opt.xml_path

txtsavepath = opt.txt_path

total_xml = os.listdir(xmlfilepath)

if not os.path.exists(txtsavepath):

os.makedirs(txtsavepath)

num = len(total_xml)

list_index = range(num)

tv = int(num * trainval_percent)

tr = int(tv * train_percent)

trainval = random.sample(list_index, tv)

train = random.sample(trainval, tr)

file_trainval = open(txtsavepath + '/trainval.txt', 'w')

file_test = open(txtsavepath + '/test.txt', 'w')

file_train = open(txtsavepath + '/train.txt', 'w')

file_val = open(txtsavepath + '/val.txt', 'w')

for i in list_index:

name = total_xml[i][:-4] + '\n'

if i in trainval:

file_trainval.write(name)

if i in train:

file_train.write(name)

else:

file_val.write(name)

else:

file_test.write(name)

file_trainval.close()

file_train.close()

file_val.close()

file_test.close()

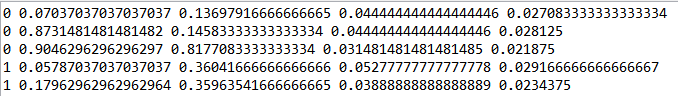

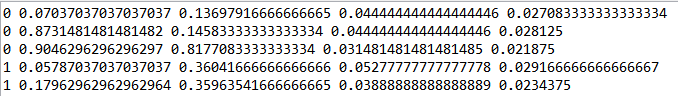

运行代码后,在Main文件夹下生成下面四个txt文档,分别存放了各自数据集的图片名称。  2.接下来将voc格式数据集转换为yolo格式,准备labels,即将每个xml标注提取bbox信息为txt格式(这种数据集格式成为yolo_txt格式),每个图像对应一个txt文件,文件每一行为一个目标的信息,包括class, x_center, y_center, width, height格式。格式如下: 2.接下来将voc格式数据集转换为yolo格式,准备labels,即将每个xml标注提取bbox信息为txt格式(这种数据集格式成为yolo_txt格式),每个图像对应一个txt文件,文件每一行为一个目标的信息,包括class, x_center, y_center, width, height格式。格式如下:  创建voc_label.py文件,将训练集、验证集、测试集生成label标签(训练中要用到),同时将数据集路径导入txt文件中,代码内容如下: 创建voc_label.py文件,将训练集、验证集、测试集生成label标签(训练中要用到),同时将数据集路径导入txt文件中,代码内容如下:

# -*- coding: utf-8 -*-

import xml.etree.ElementTree as ET

import os

from os import getcwd

sets = ['train', 'val', 'test']

classes = [ "car"] # 改成自己的类别

abs_path = os.getcwd()

print(abs_path)

def convert(size, box):

dw = 1. / (size[0])

dh = 1. / (size[1])

x = (box[0] + box[1]) / 2.0 - 1

y = (box[2] + box[3]) / 2.0 - 1

w = box[1] - box[0]

h = box[3] - box[2]

x = x * dw

w = w * dw

y = y * dh

h = h * dh

return x, y, w, h

def convert_annotation(image_id):

in_file = open ('/home/train/src_repo/yolov5/paper_data/Annotations/%s.xml' % (image_id), encoding='UTF-8')

out_file = open('/home/train/src_repo/yolov5/paper_data/labels/%s.txt' % (image_id), 'w')

tree = ET.parse(in_file)

root = tree.getroot()

size = root.find('size')

w = int(size.find('width').text)

h = int(size.find('height').text)

for obj in root.iter('object'):

# difficult = obj.find('difficult').text

if obj.find('difficult'):

difficult = float(obj.find('difficult').text)

else:

difficult = 0

cls = obj.find('name').text

if cls not in classes or int(difficult) == 1:

continue

cls_id = classes.index(cls)

xmlbox = obj.find('bndbox')

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text),

float(xmlbox.find('ymax').text))

b1, b2, b3, b4 = b

# 标注越界修正

if b2 > w:

b2 = w

if b4 > h:

b4 = h

b = (b1, b2, b3, b4)

bb = convert((w, h), b)

out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

wd = getcwd()

for image_set in sets:

if not os.path.exists('/home/train/src_repo/yolov5/paper_data/labels/'):

os.makedirs('/home/train/src_repo/yolov5/paper_data/labels/')

image_ids = open('/home/train/src_repo/yolov5/paper_data/ImageSets/Main/ImageSets/Main/%s.txt' % (image_set)).read().strip().split()

list_file = open('/home/train/src_repo/yolov5/paper_data/%s.txt' % (image_set), 'w')

for image_id in image_ids:

list_file.write(abs_path + 'paper_data/images/%s.jpg\n' % (image_id))

convert_annotation(image_id)

list_file.close()

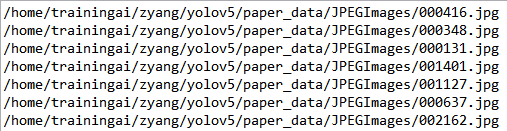

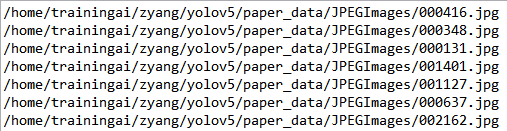

运行后会生成如下labels文件夹和三个包含数据集的txt文件,其中labels中为不同图像的标注文件,三个txt文件为划分后图像所在位置的绝对路径,如train.txt就含有所有训练集图像的绝对路径。

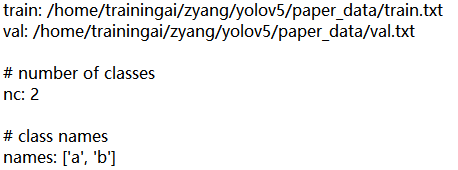

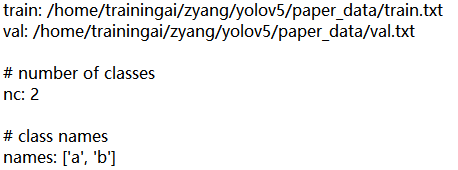

三个txt文件里面的内容如下:  3.配置文件 1)数据集的配置 在yolov5目录下的data文件夹下新建一个ab.yaml文件(可以自定义命名),用来存放训练集和验证集的划分文件(train.txt和val.txt),这两个文件是通过运行voc_label.py代码生成的,然后是目标的类别数目和具体类别列表,ab.yaml内容如下: 3.配置文件 1)数据集的配置 在yolov5目录下的data文件夹下新建一个ab.yaml文件(可以自定义命名),用来存放训练集和验证集的划分文件(train.txt和val.txt),这两个文件是通过运行voc_label.py代码生成的,然后是目标的类别数目和具体类别列表,ab.yaml内容如下:  注意:冒号后面需要加空格,否则会被认为是字符串而不是字典 注意:冒号后面需要加空格,否则会被认为是字符串而不是字典

2)编辑模型的配置文件

在yolov5目录下的model文件夹下存放着模型的配置文件,这边提供了s、m、l、x版本,逐渐增大(随着架构的增大,训练时间也是逐渐增大),如果采用yolov5s.yaml,只用修改一个参数,把nc改成自己的类别数;如果anchors是重新生成的,也需要修改,根据anchors.txt 中的 Best Anchors 修改,需要取整(可选) 如下:

训练模型

1.下载预训练模型 源码中在yolov5目录下的weights文件夹下提供了下载四种预训练模型的脚本----download_weights.sh,执行这个shell脚本就可以下载,也可以去官网自行下载相应的预训练模型

2.训练 在train.py进行以下几处参数的修改:  以上参数解释如下: epochs:指的就是训练过程中整个数据集将被迭代多少次,显卡不行你就调小点。 batch-size:一次看完多少张图片才进行权重更新,梯度下降的mini-batch,显卡不行你就调小点。 cfg:存储模型结构的配置文件 data:存储训练、测试数据的文件 img-size:输入图片宽高,显卡不行你就调小点。 rect:进行矩形训练 resume:恢复最近保存的模型开始训练 nosave:仅保存最终checkpoint notest:仅测试最后的epoch evolve:进化超参数 bucket:gsutil bucket cache-images:缓存图像以加快训练速度 weights:权重文件路径 name: 重命名results.txt to results_name.txt device:cuda device, i.e. 0 or 0,1,2,3 or cpu adam:使用adam优化 multi-scale:多尺度训练,img-size +/- 50% single-cls:单类别的训练集 以上参数解释如下: epochs:指的就是训练过程中整个数据集将被迭代多少次,显卡不行你就调小点。 batch-size:一次看完多少张图片才进行权重更新,梯度下降的mini-batch,显卡不行你就调小点。 cfg:存储模型结构的配置文件 data:存储训练、测试数据的文件 img-size:输入图片宽高,显卡不行你就调小点。 rect:进行矩形训练 resume:恢复最近保存的模型开始训练 nosave:仅保存最终checkpoint notest:仅测试最后的epoch evolve:进化超参数 bucket:gsutil bucket cache-images:缓存图像以加快训练速度 weights:权重文件路径 name: 重命名results.txt to results_name.txt device:cuda device, i.e. 0 or 0,1,2,3 or cpu adam:使用adam优化 multi-scale:多尺度训练,img-size +/- 50% single-cls:单类别的训练集

之后直接运行训练命令如下:

python train.py

训练好的模型会被保存在yolov5目录下的runs/exp0/weights/last.pt和best.pt,详细训练数据保存在runs/exp0/results.txt文件中。

3.训练过程可视化 利用tensorboard可视化训练过程,训练开始会在yolov5目录生成一个runs文件夹,利用tensorboard打开即可查看训练日志,命令如下:

tensorboard --logdir=runs

模型测试

评估模型好坏就是在有标注的测试集或者验证集上进行模型效果的评估,在目标检测中最常使用的评估指标为mAP。在test.py文件中指定数据集配置文件和训练结果模型,如下:  通过下面的命令进行模型测试: 通过下面的命令进行模型测试:

python test.py --data data/ab.yaml --weights runs/exp1/weights/best.pt --augment

模型测试效果如下:

模型推理

最后,模型在没有标注的数据集上进行推理,在detect.py文件中指定测试图片和测试模型的路径,其他参数(img_size、置信度object confidence threshold、IOU threshold for NMS)可自行修改,如下:

使用下面的命令(该命令中save_txt选项用于生成结果的txt标注文件,不指定则只会生成结果图像),其中,weights使用最满意的训练模型即可,source则提供一个包含所有测试图片的文件夹路径即可。 使用下面的命令(该命令中save_txt选项用于生成结果的txt标注文件,不指定则只会生成结果图像),其中,weights使用最满意的训练模型即可,source则提供一个包含所有测试图片的文件夹路径即可。

python detect.py --weights runs/exp1/weights/best.pt --source inference/images/ --device 0 --save-txt

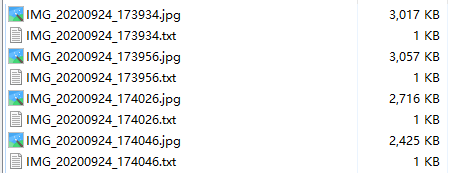

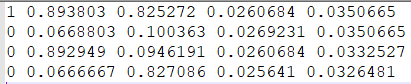

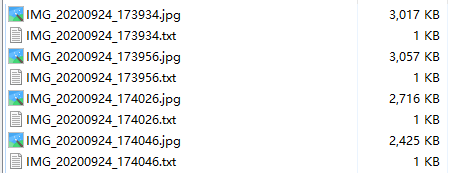

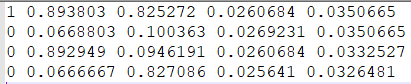

测试完毕后,每个测试图片会在指定的inference/output输出文件夹中生成结果图片和同名的txt文件,如下:  每个txt会生成一行一个目标的信息,信息包括类别序号、xcenter ycenter w h,后面四个为bbox位置,均为归一化数值,如下图: 每个txt会生成一行一个目标的信息,信息包括类别序号、xcenter ycenter w h,后面四个为bbox位置,均为归一化数值,如下图:  在进行模型推理时,无论是加载模型的速度还是对测试图片的推理速度,都能明显感觉到YOLOv5比YOLOv3速度快,尤其是加载模型的速度,因为同样的数据集训练出来的模型YOLOv5更加轻量级,模型大小减小为YOLOv3的将近四分之一。 在进行模型推理时,无论是加载模型的速度还是对测试图片的推理速度,都能明显感觉到YOLOv5比YOLOv3速度快,尤其是加载模型的速度,因为同样的数据集训练出来的模型YOLOv5更加轻量级,模型大小减小为YOLOv3的将近四分之一。

至此YOLOv5训练自己的数据集整个过程:制作数据集----模型训练----模型测试----模型推理阶段已全部完成。

模型优化

1)模型选择 根据数据集大小和数据的特点,可以选择合适的预训练模型,因为我的数据集数量比较多,为了提高训练效率,选择了模型结构较为简单的yolov5s模型。 选择hyp.scratch.yaml配置文件作为参数,并且修改了其中数据增强方式,主要将参数mosaic: 1.0 # image mosaic (probability) 数值修改为0.5。如下图所示:  因为在数据集中小目标较少,不需要每次都进行mosaic。并且不采用裁剪、复制粘贴、旋转、mixup。因为我觉得数据量其实已经足够训练yolov5s网络了。并且为了加快训练速度,输入图像改为512大小,能多训练几个epoch。优化器选择SGD优化器即可。并且这里需要采用官方的yolov5s.pt作为预训练模型,能加速模型的收殓。 因为在数据集中小目标较少,不需要每次都进行mosaic。并且不采用裁剪、复制粘贴、旋转、mixup。因为我觉得数据量其实已经足够训练yolov5s网络了。并且为了加快训练速度,输入图像改为512大小,能多训练几个epoch。优化器选择SGD优化器即可。并且这里需要采用官方的yolov5s.pt作为预训练模型,能加速模型的收殓。

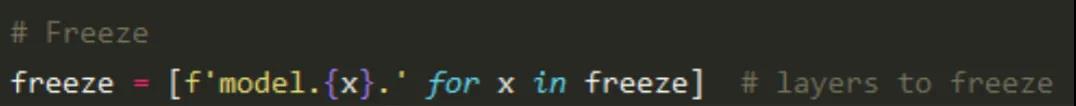

2)冻结策略

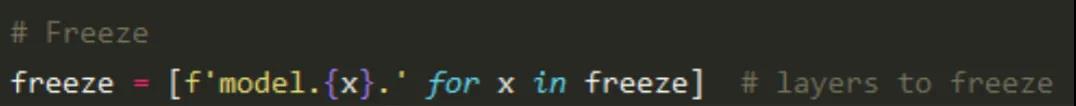

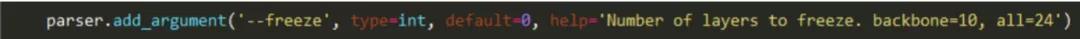

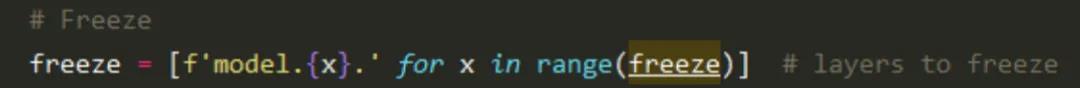

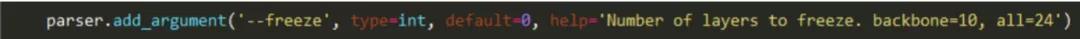

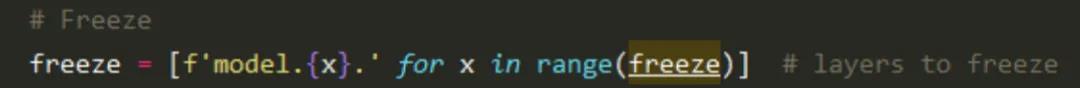

采用冻结训练策略,并且训练图像大小修改为640。Yolov5冻结参数也十分方便,只需要传递参数即可。我们将backbone以及neck+head轮流冻结。并且直接采用hyp.scratch-med.yaml进行最后的训练。

这里需要对源码进行修改,主要是因为在neck+head冻结时,yolov5只能顺序冻结。这里需要修改,修改方式如下。修改后便可以冻结任意层。 ①train.py修改前:  train.py修改后: train.py修改后:  ②train.py修改前: ②train.py修改前:  train.py修改后: train.py修改后:

|  Annotations文件夹下面为xml文件(标注工具采用labelImage),内容如下:

Annotations文件夹下面为xml文件(标注工具采用labelImage),内容如下:  images主要存放数据集的图片,内容如下:

images主要存放数据集的图片,内容如下: ImageSets文件夹下面有个Main子文件夹,其下面存放训练集、验证集、测试集的划分,通过脚本生成,可以在该路径下创建一个split.py文件,代码内容如下:

ImageSets文件夹下面有个Main子文件夹,其下面存放训练集、验证集、测试集的划分,通过脚本生成,可以在该路径下创建一个split.py文件,代码内容如下: 2.接下来将voc格式数据集转换为yolo格式,准备labels,即将每个xml标注提取bbox信息为txt格式(这种数据集格式成为yolo_txt格式),每个图像对应一个txt文件,文件每一行为一个目标的信息,包括class, x_center, y_center, width, height格式。格式如下:

2.接下来将voc格式数据集转换为yolo格式,准备labels,即将每个xml标注提取bbox信息为txt格式(这种数据集格式成为yolo_txt格式),每个图像对应一个txt文件,文件每一行为一个目标的信息,包括class, x_center, y_center, width, height格式。格式如下:  创建voc_label.py文件,将训练集、验证集、测试集生成label标签(训练中要用到),同时将数据集路径导入txt文件中,代码内容如下:

创建voc_label.py文件,将训练集、验证集、测试集生成label标签(训练中要用到),同时将数据集路径导入txt文件中,代码内容如下: 3.配置文件 1)数据集的配置 在yolov5目录下的data文件夹下新建一个ab.yaml文件(可以自定义命名),用来存放训练集和验证集的划分文件(train.txt和val.txt),这两个文件是通过运行voc_label.py代码生成的,然后是目标的类别数目和具体类别列表,ab.yaml内容如下:

3.配置文件 1)数据集的配置 在yolov5目录下的data文件夹下新建一个ab.yaml文件(可以自定义命名),用来存放训练集和验证集的划分文件(train.txt和val.txt),这两个文件是通过运行voc_label.py代码生成的,然后是目标的类别数目和具体类别列表,ab.yaml内容如下:  注意:冒号后面需要加空格,否则会被认为是字符串而不是字典

注意:冒号后面需要加空格,否则会被认为是字符串而不是字典

以上参数解释如下: epochs:指的就是训练过程中整个数据集将被迭代多少次,显卡不行你就调小点。 batch-size:一次看完多少张图片才进行权重更新,梯度下降的mini-batch,显卡不行你就调小点。 cfg:存储模型结构的配置文件 data:存储训练、测试数据的文件 img-size:输入图片宽高,显卡不行你就调小点。 rect:进行矩形训练 resume:恢复最近保存的模型开始训练 nosave:仅保存最终checkpoint notest:仅测试最后的epoch evolve:进化超参数 bucket:gsutil bucket cache-images:缓存图像以加快训练速度 weights:权重文件路径 name: 重命名results.txt to results_name.txt device:cuda device, i.e. 0 or 0,1,2,3 or cpu adam:使用adam优化 multi-scale:多尺度训练,img-size +/- 50% single-cls:单类别的训练集

以上参数解释如下: epochs:指的就是训练过程中整个数据集将被迭代多少次,显卡不行你就调小点。 batch-size:一次看完多少张图片才进行权重更新,梯度下降的mini-batch,显卡不行你就调小点。 cfg:存储模型结构的配置文件 data:存储训练、测试数据的文件 img-size:输入图片宽高,显卡不行你就调小点。 rect:进行矩形训练 resume:恢复最近保存的模型开始训练 nosave:仅保存最终checkpoint notest:仅测试最后的epoch evolve:进化超参数 bucket:gsutil bucket cache-images:缓存图像以加快训练速度 weights:权重文件路径 name: 重命名results.txt to results_name.txt device:cuda device, i.e. 0 or 0,1,2,3 or cpu adam:使用adam优化 multi-scale:多尺度训练,img-size +/- 50% single-cls:单类别的训练集

通过下面的命令进行模型测试:

通过下面的命令进行模型测试:

使用下面的命令(该命令中save_txt选项用于生成结果的txt标注文件,不指定则只会生成结果图像),其中,weights使用最满意的训练模型即可,source则提供一个包含所有测试图片的文件夹路径即可。

使用下面的命令(该命令中save_txt选项用于生成结果的txt标注文件,不指定则只会生成结果图像),其中,weights使用最满意的训练模型即可,source则提供一个包含所有测试图片的文件夹路径即可。 每个txt会生成一行一个目标的信息,信息包括类别序号、xcenter ycenter w h,后面四个为bbox位置,均为归一化数值,如下图:

每个txt会生成一行一个目标的信息,信息包括类别序号、xcenter ycenter w h,后面四个为bbox位置,均为归一化数值,如下图:  在进行模型推理时,无论是加载模型的速度还是对测试图片的推理速度,都能明显感觉到YOLOv5比YOLOv3速度快,尤其是加载模型的速度,因为同样的数据集训练出来的模型YOLOv5更加轻量级,模型大小减小为YOLOv3的将近四分之一。

在进行模型推理时,无论是加载模型的速度还是对测试图片的推理速度,都能明显感觉到YOLOv5比YOLOv3速度快,尤其是加载模型的速度,因为同样的数据集训练出来的模型YOLOv5更加轻量级,模型大小减小为YOLOv3的将近四分之一。 因为在数据集中小目标较少,不需要每次都进行mosaic。并且不采用裁剪、复制粘贴、旋转、mixup。因为我觉得数据量其实已经足够训练yolov5s网络了。并且为了加快训练速度,输入图像改为512大小,能多训练几个epoch。优化器选择SGD优化器即可。并且这里需要采用官方的yolov5s.pt作为预训练模型,能加速模型的收殓。

因为在数据集中小目标较少,不需要每次都进行mosaic。并且不采用裁剪、复制粘贴、旋转、mixup。因为我觉得数据量其实已经足够训练yolov5s网络了。并且为了加快训练速度,输入图像改为512大小,能多训练几个epoch。优化器选择SGD优化器即可。并且这里需要采用官方的yolov5s.pt作为预训练模型,能加速模型的收殓。 train.py修改后:

train.py修改后:  ②train.py修改前:

②train.py修改前:  train.py修改后:

train.py修改后: