|

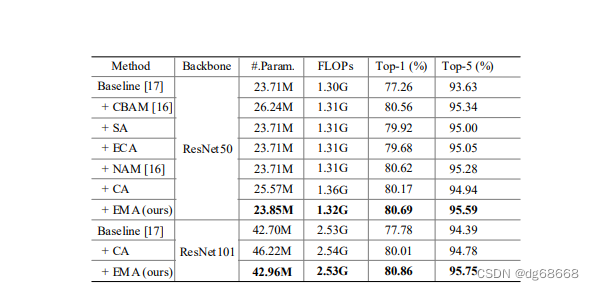

显著的渠道或空间有效性注意力产生机制更加可辨特征表示用各种计算机进行了说明视觉任务。然而,跨通道建模关系与通道降维可能在提取深度视觉表征时带来副作用。本文提出了一种新的高效多尺度注意力(EMA)方法。模块提出。专注于保留信息每个通道上,并减少计算在上方,我们将部分通道重塑为批处理尺寸并将通道尺寸分组为多个子特征构成空间语义特性在每个特性组中分布良好。具体来说,除了将全局信息编码到重新校准每个平行通道的权重支路,两个并联支路的输出特征为的跨维度交互进一步聚合捕获像素级成对关系。我们的行为广泛的消融研究和图像实验分类和目标检测任务很受欢迎基准测试(例如CIFAR-100, ImageNet-1k, MS COCO)和VisDrone2019),以评估其性能。代码网址:https://github.com/YOLOonMe/EMAattention-module 显著的渠道或空间有效性注意力产生机制更加可辨特征表示用各种计算机进行了说明视觉任务。然而,跨通道建模关系与通道降维可能在提取深度视觉表征时带来副作用。本文提出了一种新的高效多尺度注意力(EMA)方法。模块提出。专注于保留信息每个通道上,并减少计算在上方,我们将部分通道重塑为批处理尺寸并将通道尺寸分组为多个子特征构成空间语义特性在每个特性组中分布良好。具体来说,除了将全局信息编码到重新校准每个平行通道的权重支路,两个并联支路的输出特征为的跨维度交互进一步聚合捕获像素级成对关系。我们的行为广泛的消融研究和图像实验分类和目标检测任务很受欢迎基准测试(例如CIFAR-100, ImageNet-1k, MS COCO)和VisDrone2019),以评估其性能。代码网址:https://github.com/YOLOonMe/EMAattention-module

本文以yolov7tiny.yaml为基础网络结构进行修改,

第一步:在models/common.py中添加以下代码:

import torch

from torch import nn

class EMA(nn.Module):

def __init__(self, channels, factor=8):

super(EMA, self).__init__()

self.groups = factor

|