谷歌发布史上最大「通才」AI 模型,可让机器人更自主,具有哪些意义?应用前景如何? |

您所在的位置:网站首页 › ai智能优化图片 › 谷歌发布史上最大「通才」AI 模型,可让机器人更自主,具有哪些意义?应用前景如何? |

谷歌发布史上最大「通才」AI 模型,可让机器人更自主,具有哪些意义?应用前景如何?

|

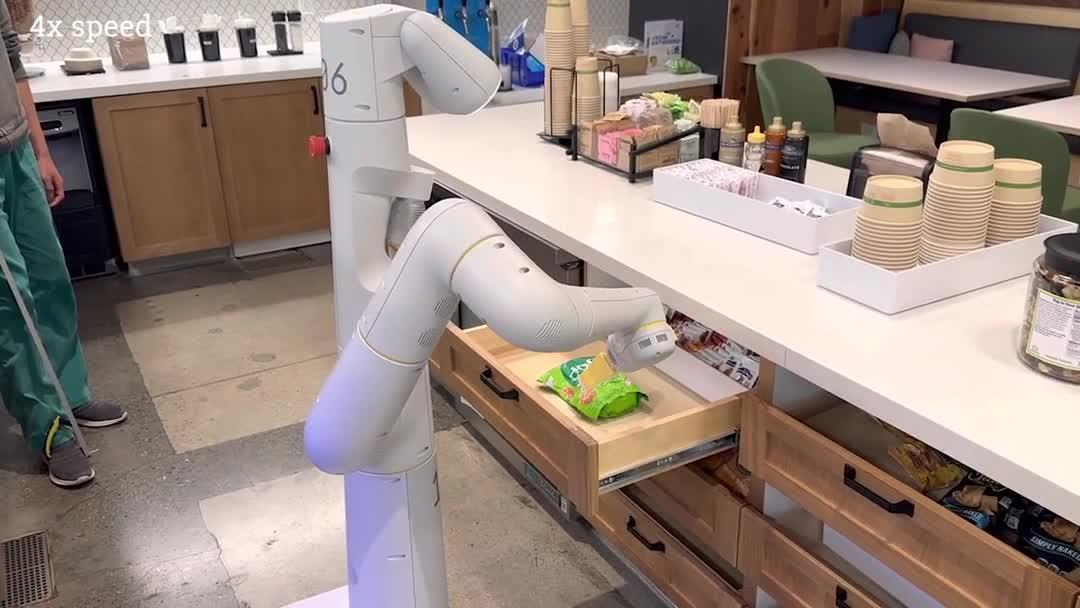

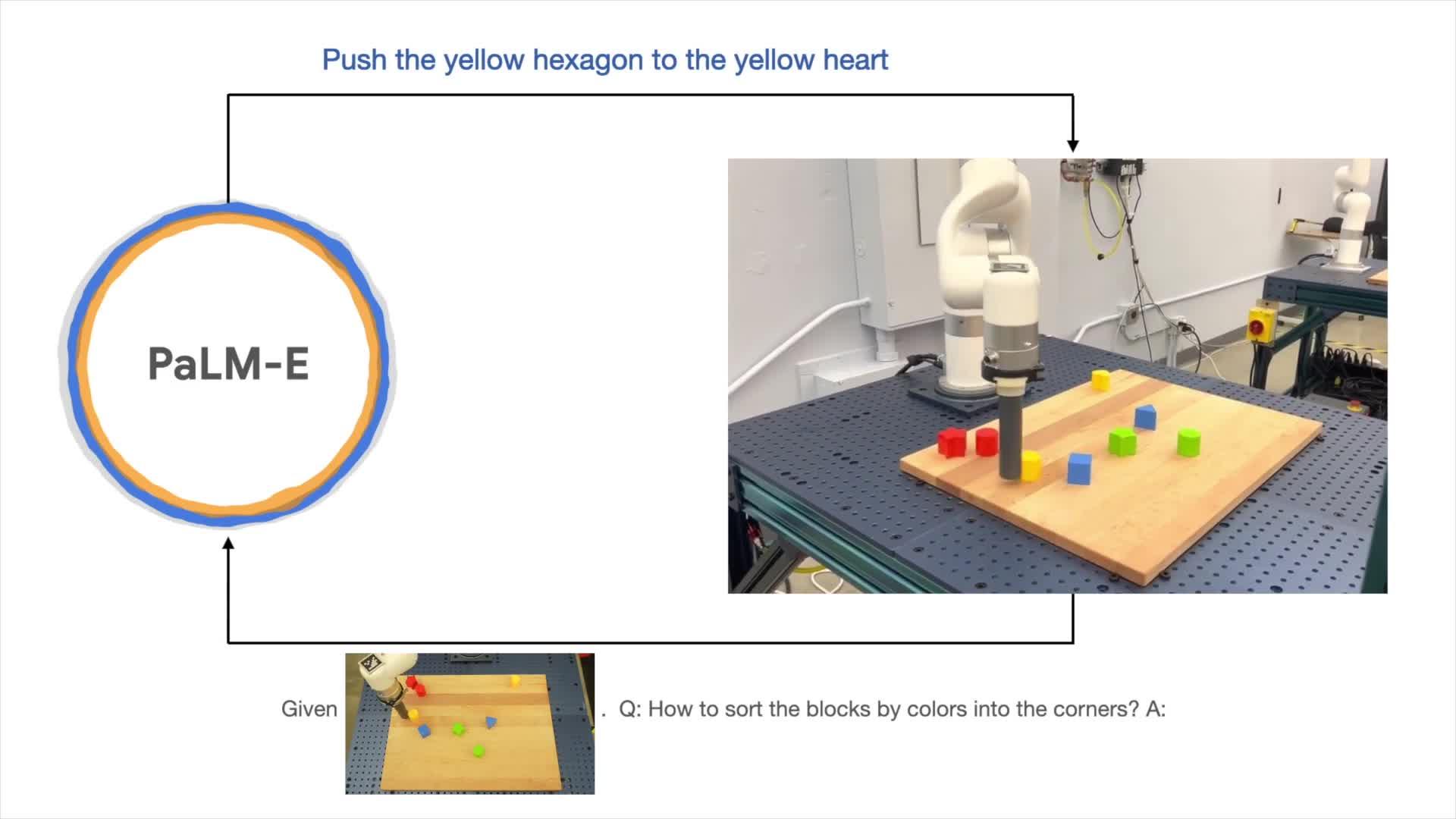

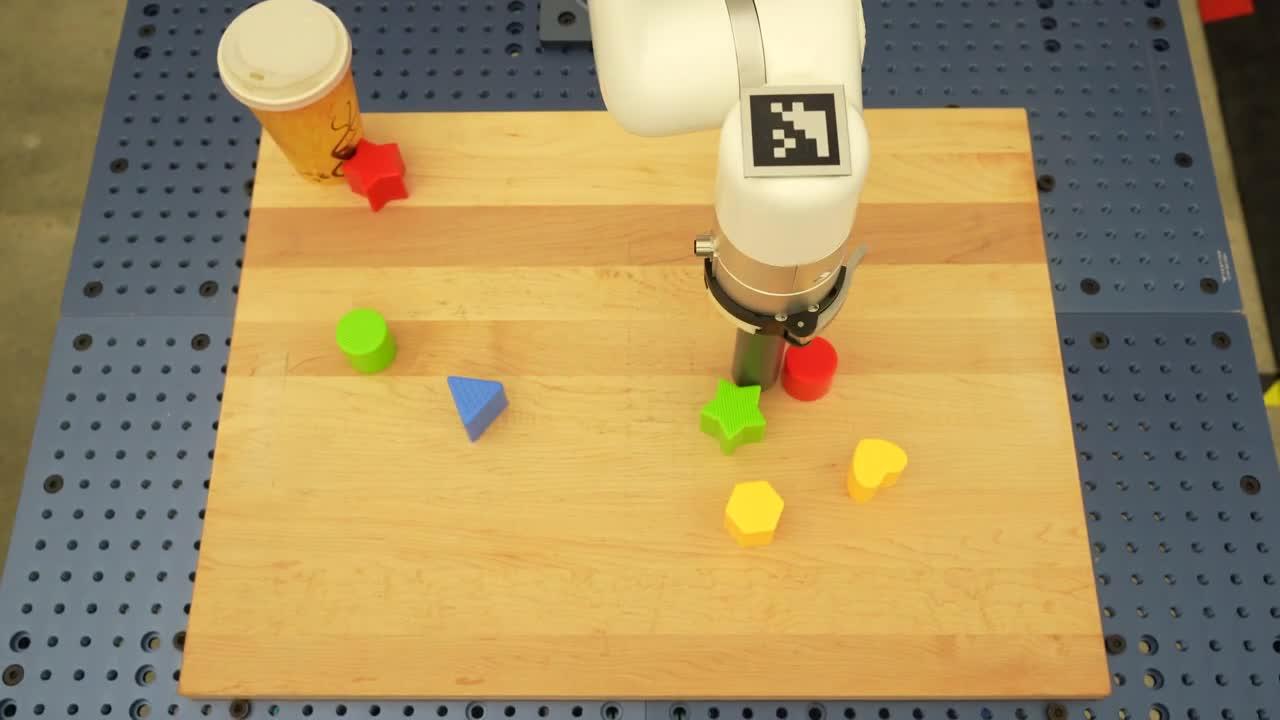

说实话,如果说 ChatGPT 给我的感觉是惊艳,那这篇论文演示的内容就有点惊吓了。 我开始期待有生之年究竟能看到什么样的科技飞升了。大厂们卷起来太狠了。 (我搬运其中几段演示视频[1]) 我们展示了一些示例视频,展示了如何使用PaLM-E在两个不同的真实实施例上计划和执行长距离任务。请注意,所有这些结果都是使用在所有数据上训练的相同模型获得的。 在第一个视频中,我们执行了一个长距离指令“从抽屉里拿出米片”,其中包括多个计划步骤以及来自机器人摄像头的视觉反馈。 最后,在同一个机器人上展示另一个例子,其中的指令是“给我一颗绿色的星星”。绿星是这个机器人没有直接接触的物体。 https://www.zhihu.com/video/1616884878167031808 https://www.zhihu.com/video/1616884878167031808 https://www.zhihu.com/video/1616884910739836928 https://www.zhihu.com/video/1616884910739836928 https://www.zhihu.com/video/1616885018143186945 https://www.zhihu.com/video/1616885018143186945 https://www.zhihu.com/video/1616885157658505216 https://www.zhihu.com/video/1616885157658505216562B 的参数集成了 540B 的 PALM 和 22B 的 ViT,作为比较,GPT-3.5 的参数规模是 175B,ChatGPT 用的应该是百亿(10B)规模,Meta 开源的 LLaMA 则是 65B。 之前我就认为,ChatGPT 最大意义是给大厂们证明了「力大砖飞」的效果,让大厂们愿意不计成本地继续砸资源进去;同时带来的结果也是,大部分小机构很难有机会在大模型训练上做出成绩了。 大厂们马上都要把参数卷到上千 B 了,实验室那么穷怎么玩。 从这个角度上讲,接下来会有越来越多模型训练方向和人机交互方式的变化。 过去做模型,大家分着方向,你做 NLP,我做 CV,他做 ASR、STT 或者 TTS。大家各自做出了模型,再往一起集成耦合,做出各种产品。 以后多模态的融合是必然的。甚至有没有可能将来直接大模型一把梭,管你是文字、图片还是语音,直接扔到一起一锅乱炖,炼出个全能模型。 然后是人机交互方式的变化。 其实 ChatGPT 出来以后,已经有人在讨论 LUI(language user interface)了,激进派甚至认为,在未来几年,LUI 类产品会替代掉传统的 GUI 应用。其实想想也是,如果真的直接畅想机器人,我们总不会再拿个遥控器或者装个 App,对话式的产品会越来越多,不会再有那么多 UI 上的设计和门槛。 过去我们很少用 LUI,其实主要是因为产品没有足够的理解能力。HomePod 用 Siri 调节音量就是个经典例子,它永远不理解你想要的音量大小,你必须精确地告诉他调节音量的百分比。 但是即便是当前程度的人工智能,我也完全适应且习惯了用小爱同学开灯、关灯,调节空调温度,定闹钟等等操作。虽然有时偶尔智障,或者不那么精确,但说一句话就能完成的操作真的比找遥控器或者打开 App 点击几层菜单爽太多了。 总结一下: 1、融合的视觉语言模型,参数量本身很大; 2、多模态融合是方向; 3、人机交互方式会发生变化。 至于具体的实际效果,我期待尽快能够体验。 以上。 参考^https://palm-e.github.io/ |

【本文地址】