CM |

您所在的位置:网站首页 › agent重启 › CM |

CM

|

一、启动

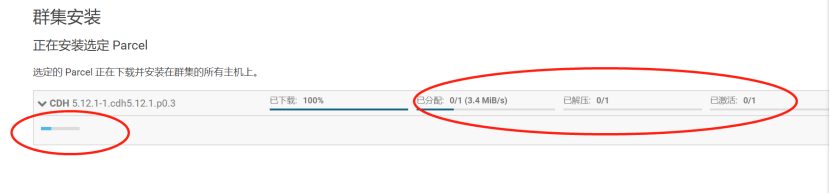

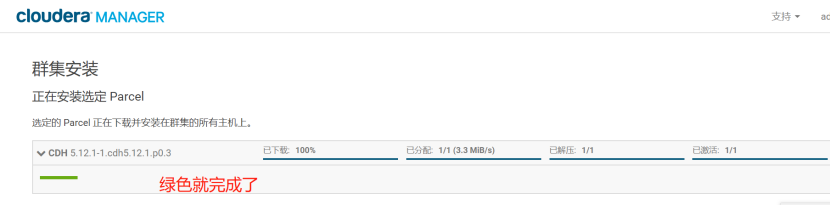

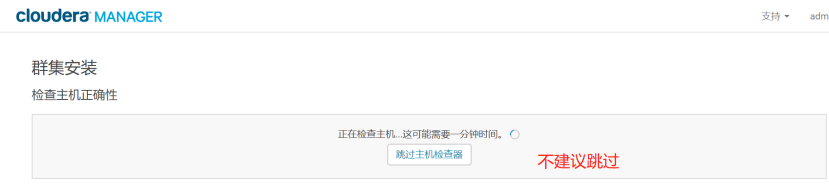

1.服务节点:bigdata111-主节点操作:

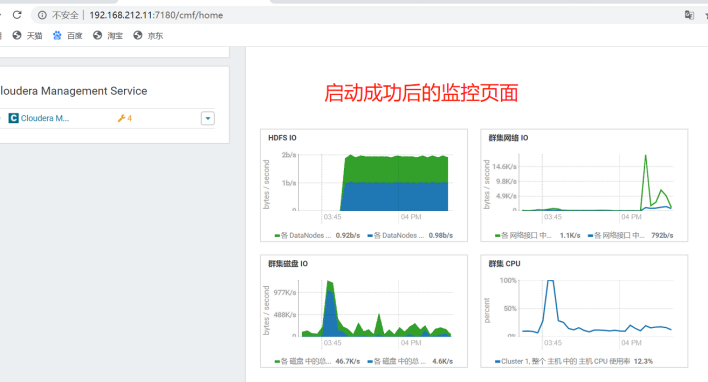

[root@cdh init.d]# /opt/cm-5.12.1/etc/init.d/cloudera-scm-server start Starting cloudera-scm-server: [确定] 2.工作节点操作:bigdata111\bigdata112\bigdata113[root@cdh init.d]# /opt/cm-5.12.1/etc/init.d/cloudera-scm-agent start 正在启动 cloudera-scm-agent: [ok] [root@cdh2 module]# /opt/cm-5.12.1/etc/init.d/cloudera-scm-agent start 正在启动 cloudera-scm-agent: [ok] [root@cdh3 module]# /opt/cm-5.12.1/etc/init.d/cloudera-scm-agent start 正在启动 cloudera-scm-agent: [确定] ***************************************************** 我的是单节点的,所以只启动主节点的server和agent即可:[root@cdh opt]# /opt/cm-5.12.1/etc/init.d/cloudera-scm-server start [root@cdh opt]# /opt/cm-5.12.1/etc/init.d/cloudera-scm-agent start 注意:启动过程非常慢,Manager 启动成功需要等待一段时间,过程中会在数据库中创建对应的表需要耗费一些时间。 3.查看端口7180是否打开了(多试几次,需要时间):[root@cdh init.d]# netstat -anp | grep 7180 tcp 0 0 0.0.0.0:7180 0.0.0.0:* LISTEN 5498/java

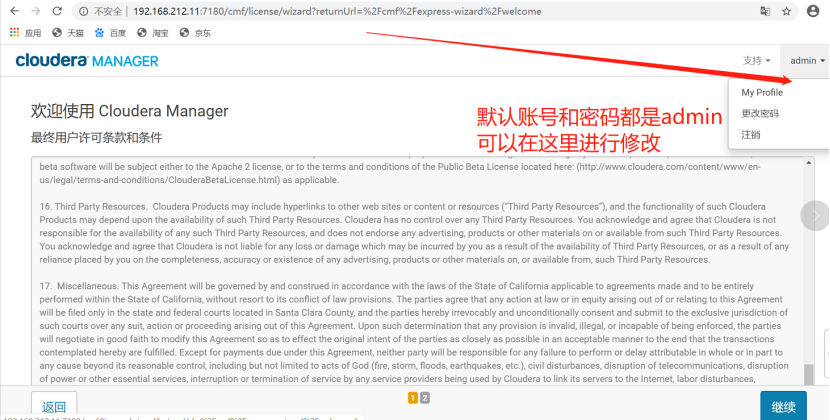

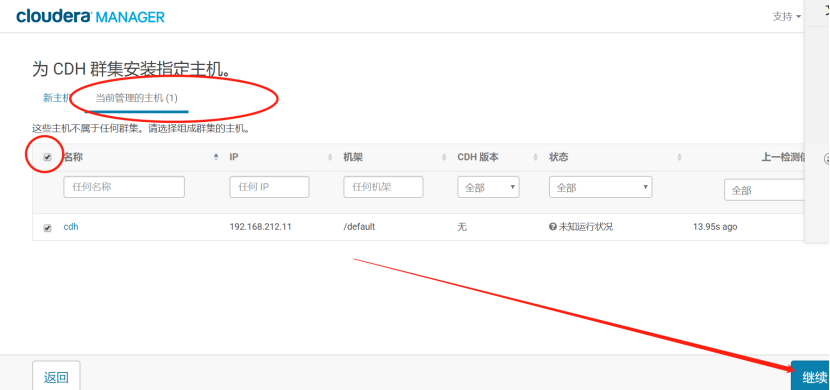

查看被占用则表示安装成功了!!! 如果发现netstat命令没找到,解决: -bash: netstat: command not found [root@cdh3 cloudera]# yum install net-tools -y 二、初次访问如访问http://cdh:7180,(用户名、密码:admin)

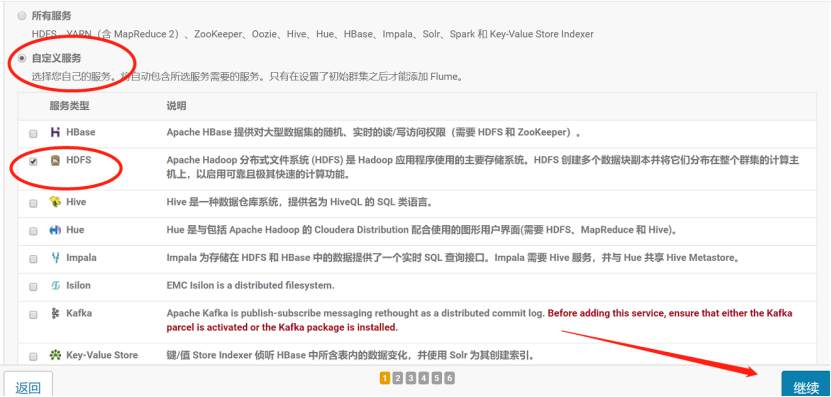

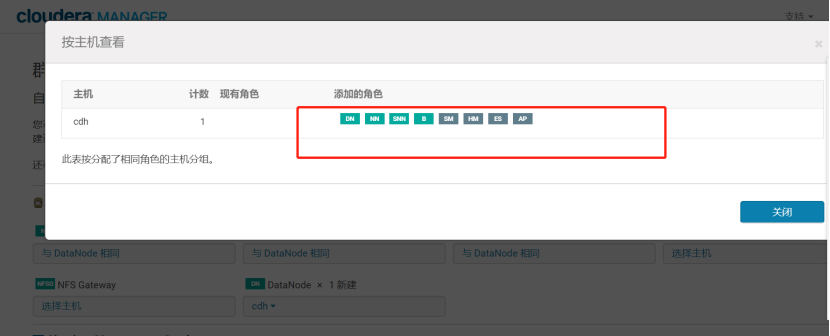

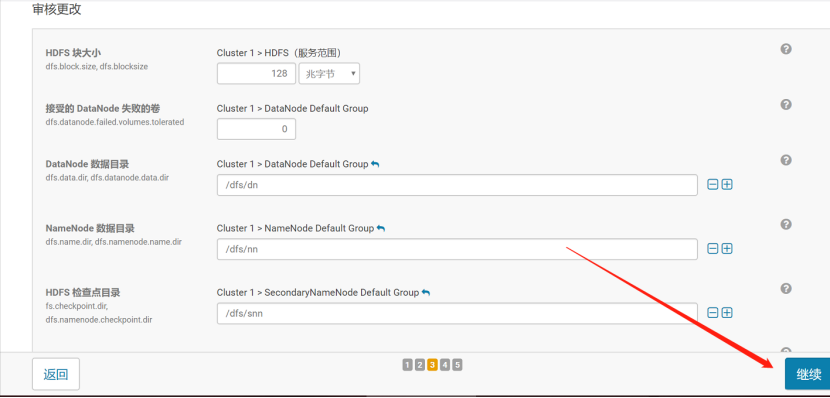

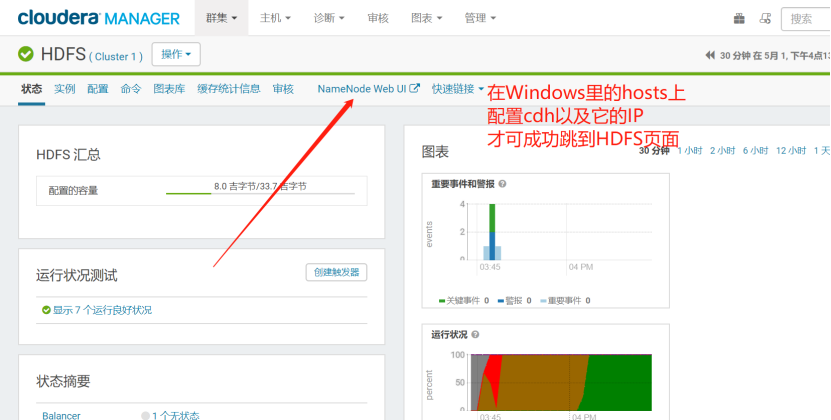

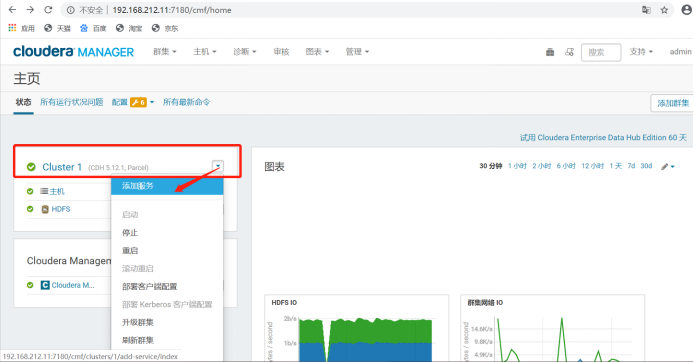

到此CDH集群就安装完成了。 下面添加角色: 这里先选择HDFS-几乎总是能用上,其他的需要的时候再添加。 初始的话是默认分配的:

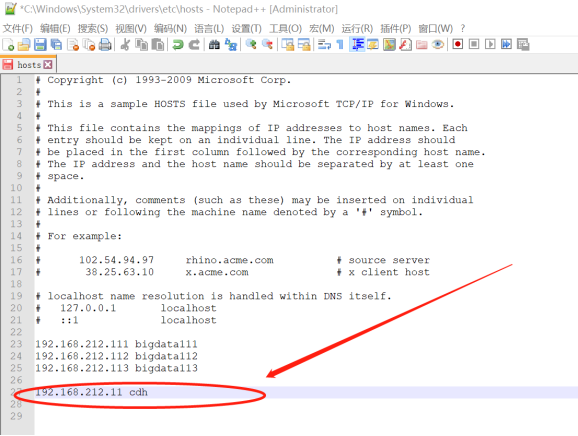

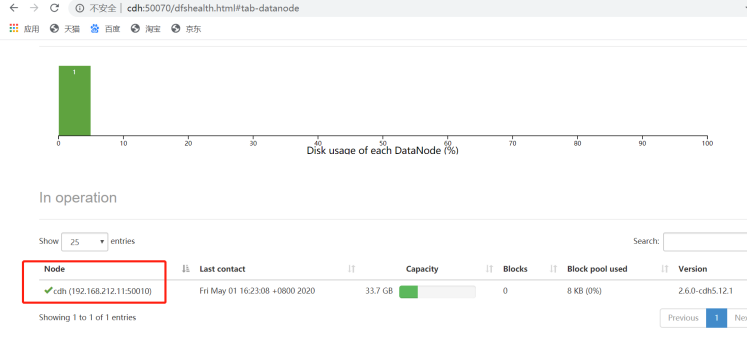

或者直接在谷歌浏览器上搜索:192.168.212.11:50070也可。 下面可以为该集群增加一个Yarn服务:

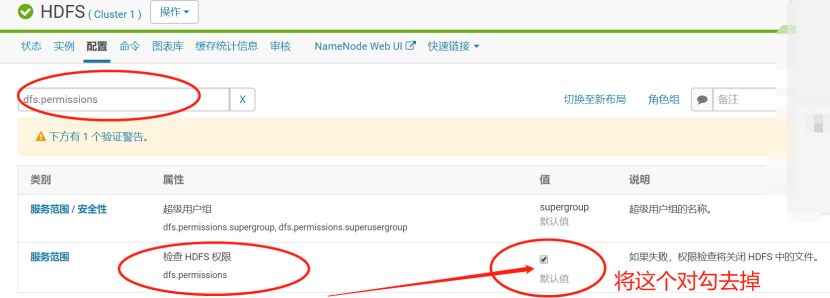

三、操作集群 接下来创建一个test目录、再创键一个words文件: [root@cdh test]# pwd /opt/test [root@cdh test]# cat words aa ccc dd gggg f 上传该文件到HDFS根目录下面: 该Hadoop是自带环境变量的 [root@cdh test]# hdfs dfs -put words / put: Permission denied: user=root, access=WRITE, inode="/":hdfs:supergroup:drwxr-xr-x 出现权限不够的问题-默认使用HDFS用户才能上传 HDFS-》配置-》切换至经典布局-》搜索:dfs.permissions 参数dfs.permissions 在Hadoop搭建里配置文件hdfs-site.xml中: dfs.permissions false

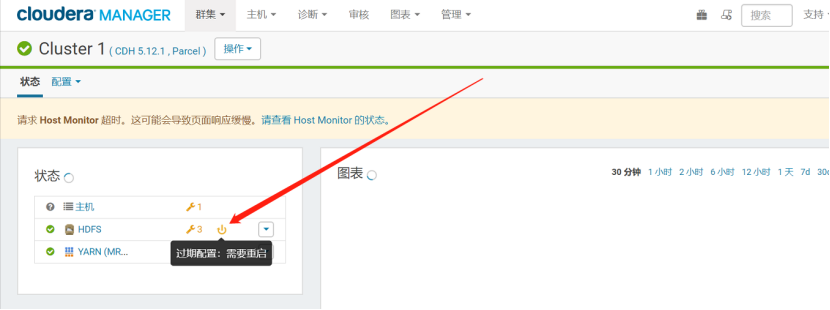

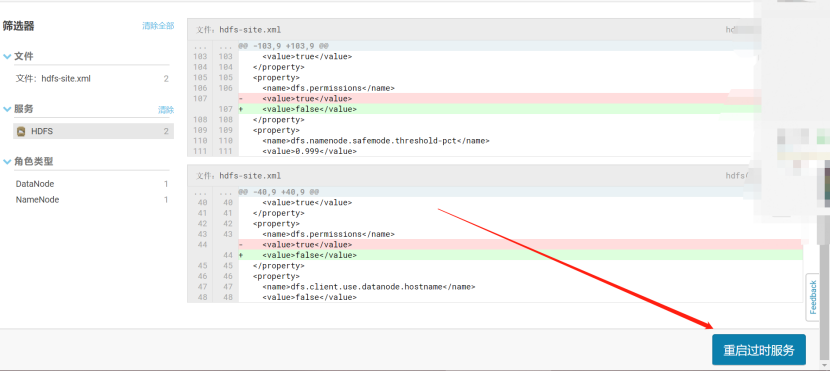

然后右上角蓝色标签“保存更改” 之后会弹出一个警告--》重启:

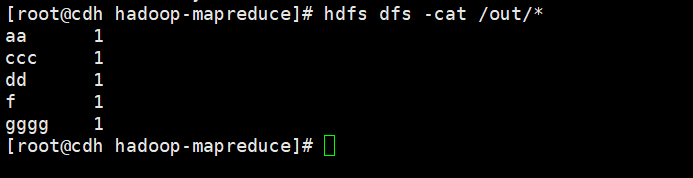

重启成功之后,继续上传文件 [root@cdh test]# hdfs dfs -put words / 查找 CDH安装的都在该目录下面: /opt/cloudera/parcels/CDH-5.12.1-1.cdh5.12.1.p0.3/ 找到要运行的官方给的jar包: hadoop-mapreduce-examples-2.6.0-cdh5.12.1.jar 位置是: /opt/cloudera/parcels/CDH-5.12.1-1.cdh5.12.1.p0.3/lib/hadoop-mapreduce 现在开始运行-计算个数 [root@cdh hadoop-mapreduce]# hadoop jar hadoop-mapreduce-examples-2.6.0-cdh5.12.1.jar wordcount /words /out 运行HDFS上/words文件,将结果存放于/out目录下。

四、关闭 首先在CDH集群上依次关闭Yarn、HDFS、输入命令停止:agent、server 所有工作节点:cdh、cdh2、cdh3 [root@cdh init.d]# /opt/cm-5.12.1/etc/init.d/cloudera-scm-agent stop Stopping cloudera-scm-agent: [ok] 服务节点-主节点: cdh [root@cdh init.d]# /opt/cm-5.12.1/etc/init.d/cloudera-scm-server stop 停止 cloudera-scm-server: [ok] 之后再停掉其他进程-在cdh主节点上

[root@cdh hadoop-mapreduce]# jps3537 Main3538 Main3177 AlertPublisher3468 EventCatcherService13182 Jps

[root@cdh hadoop-mapreduce]# cd /tmp/

[root@cdh tmp]# cd hsperfdata_cloudera-scm[root@cdh hsperfdata_cloudera-scm]# lltotal 128-rw------- 1 cloudera-scm cloudera-scm 32768 May 12 00:36 3177-rw------- 1 cloudera-scm cloudera-scm 32768 May 12 00:36 3468-rw------- 1 cloudera-scm cloudera-scm 32768 May 12 00:36 3537-rw------- 1 cloudera-scm cloudera-scm 32768 May 12 00:36 3538[root@cdh hsperfdata_cloudera-scm]# cd ..[root@cdh tmp]# rm hsperfdata_cloudera-scm/*rm: remove regular file ‘hsperfdata_cloudera-scm/3177’? yrm: remove regular file ‘hsperfdata_cloudera-scm/3468’? yrm: remove regular file ‘hsperfdata_cloudera-scm/3537’? yrm: remove regular file ‘hsperfdata_cloudera-scm/3538’? y[root@cdh tmp]# jps13204 Jps 五、总结 1.今后再启动CDH集群的话,启动顺序: Host Monitor-->Service-->CDH-->HDFS-->Yarn 2.集群搭建内存考虑像我这里之启动了一个节点-伪CDH集群,而且只给它分配了7G,会出现这个问题: 主机 cdh 上的内存被调拨过度。总内存分配额是 5.7 GiB 个字节,但是 RAM 只有 6.6 GiB 个字节(其中的 1.3 GiB 个字节是保留给系统使用的)。如需获得分配详细信息,请访问“主机”页面上的“资源”选项卡。重新配置主机上的角色以降低总内存分配额。请注意:Java 最大堆大小乘以 1.3 等于近似的 JVM 开销。

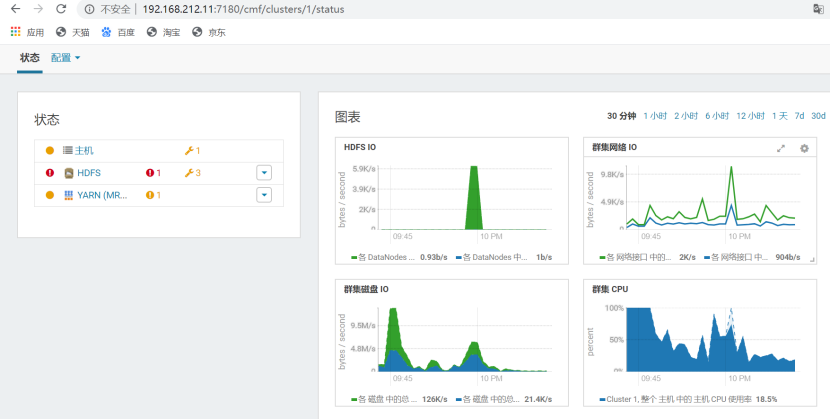

由此看来,CDH真的很吃内存,单个节点给了7G运行MR案例的时候还是运行不动。 但至少HDFS、Yarn、图表看起来问题不大,之前给6G的时候图标都展示不出,各个服务也是忽好忽坏。 看来还是得至少遵从8、4、4原则,能大就大吧,要不然真的是卡的要死,真的运行不起来。 |

【本文地址】

今日新闻 |

推荐新闻 |