EMC VNX5200 评测 |

您所在的位置:网站首页 › EMC存储是什么 › EMC VNX5200 评测 |

EMC VNX5200 评测

|

EMC 的 VNX5200 存储控制器是该公司 VNX2 产品的入口点,具有块存储以及可选文件和统一存储功能。 VNX5200 最多可管理 125 个 2.5 英寸或 3.5 英寸 SAS 和 NL-SAS 硬盘驱动器和 SSD,并采用 EMC 的 MCx 多核架构构建。 StorageReview 企业测试实验室主任 Kevin O'Brien 最近前往位于马萨诸塞州霍普金顿的 EMC 数据中心进行了一些实际操作和 VNX5200 基准测试。

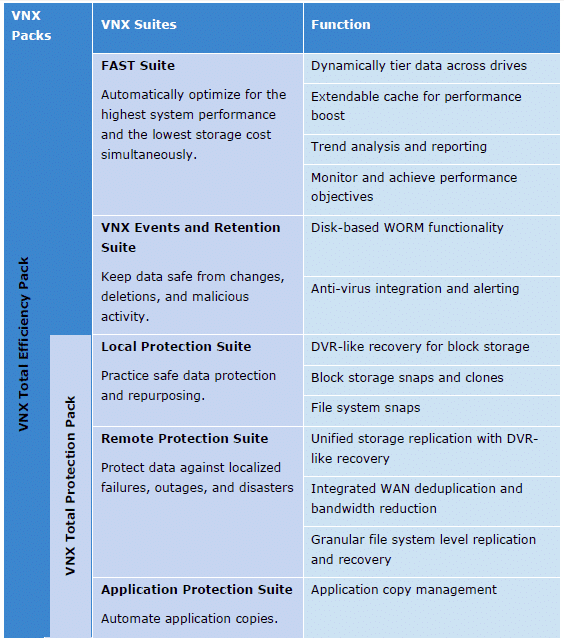

In 去年九月, EMC 更新了他们流行的 VNX 系列统一存储阵列,具有显着的硬件增强功能。 其结果是 VNX2 系列,具有增强功能,例如从 PCIe 2.0 迁移到 PCIe 3.0 和新的 MCx 架构(包括多核 RAID、多核缓存和多核 FAST Cache)以更好地利用存储处理器中的多个 CPU 内核。 其中许多增强功能侧重于使 VNX 平台能够在存储管理员继续转向混合阵列配置时更好地利用闪存。 根据 EMC 的说法,近 70% 的 VNX2 系统现在都采用混合闪存配置,这一转变也更加重视 EMC 的 FAST 套件在缓存和分层方面的作用。

而较小的 我们之前评测过的 VNXe3200 VNX2 还使用 VNX5200 技术进行了更新,专为需要在总部使用主存储系统的中端市场客户以及比 VNXe3200 更强大的远程/分支机构需求而设计。 VNX5200 可以针对数据块、文件或统一存储进行配置,并使用 3U、25x 2.5 英寸 EMC 磁盘处理器机箱 (DPE) 机箱。 VNX5200 的存储处理器单元采用 1.2GHz 四核 Xeon E5 处理器和 16GB RAM,最多可管理 125 个具有 FC、iSCSI、FCoE 和 NAS 连接的驱动器。

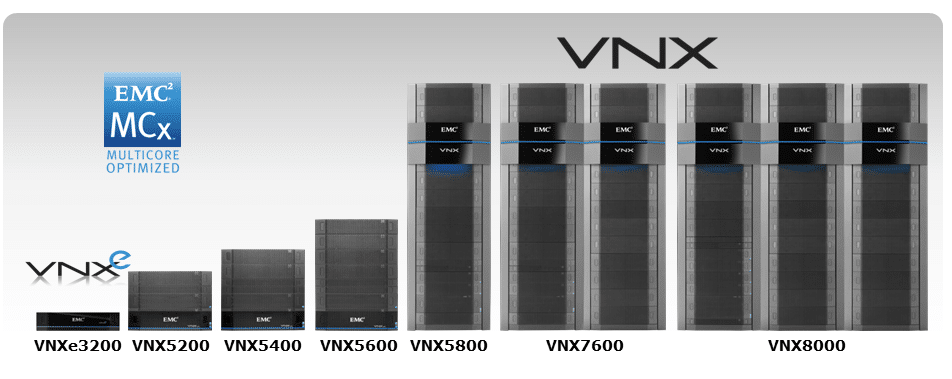

VNX2 系列目前还包括五个存储系统,专为比 VNXe3200 和 VNX5200 更大的规模而设计。 VNX5400:1 个驱动器中高达 250PB 的原始容量、高达 1TB 的 SSD FAST 缓存以及每个阵列多达 8 个 UltraFlex I/O 模块 VNX5600:2 个驱动器中高达 500PB 的原始容量、高达 2TB 的 SSD FAST 缓存以及每个阵列多达 10 个 UltraFlex I/O 模块 VNX5800:3 个驱动器中高达 750PB 的原始容量、高达 3TB 的 SSD FAST 缓存以及每个阵列多达 10 个 UltraFlex I/O 模块 VNX7600:4 个驱动器中高达 1,000PB 的原始容量、高达 4.2TB 的 SSD FAST 缓存以及每个阵列多达 10 个 UltraFlex I/O 模块 VNX8000:6 个驱动器中高达 1,500PB 的原始容量、高达 4.2TB 的 SSD FAST 缓存以及每个阵列多达 22 个 UltraFlex I/O 模块

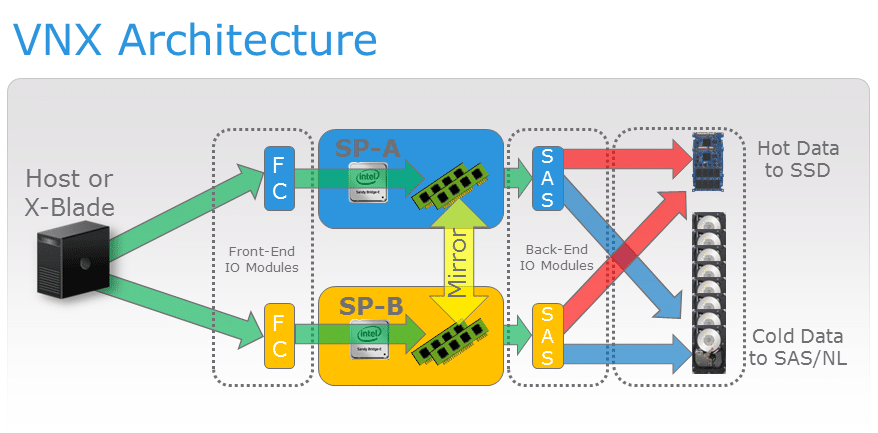

VNX5200 块存储由具有 6Gb SAS 驱动器拓扑的双 VNX 存储处理器提供支持。 VNX2 部署可以使用一个或多个 Data Mover 和一个控制器单元来提供 NAS 服务。 与 VNX 系列的其他成员一样,VNX5200 将 UltraFlex I/O 模块用于其 Data Mover 和块存储处理器。 VNX5200 最多支持三个 Data Mover,每个 Data Mover 最多支持三个 UltraFlex 模块。 MCx 多核功能 VNX 早于广泛使用的多核处理器技术,并且该平台的前几代并非构建在可以利用动态 CPU 扩展的基础之上。 VNX1 和 CLARiiON CX 操作环境 FLARE 确实允许包括 RAID 在内的服务在特定的 CPU 核心上运行,但 FLARE 的单线程范例意味着许多核心功能都绑定到第一个 CPU 核心。 例如,所有传入的 I/O 进程在被委托给其他核心之前都由核心 0 处理,从而导致出现瓶颈情况。 MCx 实现了 EMC 所描述的水平多核系统扩展,允许所有服务分布在所有内核上。 在 VNX2 和 VNXe3200 上都可用的这种新架构下,传入 I/O 进程不太可能成为瓶颈,因为例如,前端光纤通道端口可以均匀分布在多个处理器内核中。 MCx 还通过其首选核心概念实现 I/O 核心亲和性。 每个端口,前端和后端,都有一个首选核心和一个备用核心分配。 系统服务主机请求与发起请求的前端核心相同,以避免在核心之间交换缓存和上下文。 新的 MCx 架构的一个主要优势是支持对称的主动/主动 LUN,这使主机能够通过阵列中的两个存储处理器同时访问 LUN。 与 FLARE 的非对称实施不同,对称主动/主动模式允许两个 SP 直接写入 LUN,而无需将更新发送到主存储处理器。 目前,VNX2 系统支持经典 RAID 组 LUN 的对称主动/主动访问,但不支持私有池 LUN 的主动/主动访问,而是可以使用非对称主动/主动模式。 如果专用池 LUN 或“经典 LUN”使用 VNX RecoverPoint 拆分器以外的数据服务,则它们当前无法使用对称主动/主动模式。 VNX5200 在 MCx 体系结构和闪存媒体存储之间的引人注目的协同作用之一是系统对 EMC FAST Suite 的支持,它允许管理员利用闪存存储媒体来提高异构驱动器的阵列性能。 FAST Suite 将两种使用闪存来加速存储性能的方法(缓存和分层)结合到一个集成解决方案中。 FAST Suite 的 VNX2 更新包括四倍更好的分层粒度和对新 eMLC 闪存驱动器的支持。 VNX FAST Cache 允许使用多达 4.2TB 的 SSD 存储,以便为高度活跃的数据提供服务并动态调整以适应工作负载峰值,尽管 VNX5200 的缓存大小上限为 600GB。 随着数据老化并随着时间的推移变得不那么活跃,FAST VP 根据管理员定义的策略以 256MB 的增量将数据从高性能驱动器分层到高容量驱动器。 EMC VNX5200 规格 阵列机箱:3U 磁盘处理器机箱 驱动器外壳: 2.5 英寸 SAS/闪存 (2U),25 个驱动器 3.5 英寸 SAS/闪存 (3U),15 个驱动器 最大 SAN 主机数:1,024 最小/最大驱动器:4/125 最大 FAST 缓存:600GB 每个阵列的 CPU/内存:2 个 Intel Xeon E5-2600 4 核 1.2GHz/32GB RAID: 0/1/10/3/5/6 最大原始容量:500TB 协议:FC、FCoE、NFS、CIFS、iSCSI、 存储类型:统一、SAN、NAS、对象 驱动器类型:闪存 SSD、SAS、NL-SAS 容量优化:精简配置、块重复数据删除、块压缩、文件级重复数据删除和压缩 性能:MCx、FAST VP、FAST Cache 管理:EMC Unisphere 虚拟化支持:VMware vSphere、VMware Horizon View、Microsoft Hyper-V、Citrix XenDesktop 每个阵列的最大块 UltraFlex I/O 模块:6 每个阵列的最大总端口数:28 2/4/8Gb/s FC 每个阵列的最大端口数:24 1GBASE-T iSCSI 每个阵列的最大总端口数:16 每个阵列的最大 FCoE 端口数:12 每个阵列的 10GbE iSCSI 最大总端口数:12 控制站:1 或 2 支持的最大 LUN:1,000(池) 最大 LUN 大小:256TB(虚拟池 LUN) 最大文件系统大小:16TB 文件数据移动器数量:1、2 或 3 每个数据移动器的 CPU/内存:Intel Xeon 5600/6GB 用于块的 UltraFlex I/O 扩展模块: 4 端口 2/4/8Gb/s 光纤通道 4 端口 1Gb/s(铜线)iSCSI 2 端口 10Gb/s(光学)iSCSI 2 端口 10GBASE-T(铜线)iSCSI 2 端口 10GbE(光纤或双轴)FCoE 用于文件的 UltraFlex I/O 扩展模块: 4 端口 1GBASE-T 4 端口 1GBASE-T 和 1GbE(光纤) 2 端口 10GbE(光纤) 2 端口 10GBASE-T(铜线)设计与建造 在 VNX 术语中,存储部署由多个集成机架组件组成。 控制器组件是不包含驱动器托架的存储处理器机柜 (SPE),或者与此 VNX5200 一样,是提供内部存储的磁盘处理器机柜 (DPE)。 VNX 磁盘阵列存储模块 (DAE) 可用于合并额外的存储容量。

除了双 SAS 模块、双电源和风扇组之外,SPE 还集成了 VNX 存储处理器。 磁盘处理器机柜 (DPE) 包括机柜、磁盘模块、存储处理器、双电源和四个风扇组。 通过使用 DAE 添加额外的存储可以通过使用带有双 SAS 链路控制卡和双电源的 15x 3.5 英寸、25x 2.5 英寸或 60x 3.5 英寸驱动器托架来完成。

无论它们是存储处理器机箱还是磁盘处理器机箱的一部分,VNX 存储处理器都提供对外部主机的数据访问,并将阵列的块存储与可选的 VNX2 文件存储功能连接起来。 VNX5200 可以利用各种 EMC 的 UltraFlex IO 模块来定制其连接性。 UltraFlex 块 IO 模块选项: 四端口 8Gb/s 光纤通道模块,带有光纤 SFP 和 OM2/OM3 电缆,可连接到 HBA 或 FC 交换机。 四端口 1Gb/s iSCSI 模块,带有 TCP 卸载引擎和四个 1GBaseT Cat6 端口。 双端口 10Gb/s 可选 iSCSI 模块,带有 TCP 卸载引擎、两个 10Gb/s 以太网端口和一个 SFP+ 光学连接或一个到以太网交换机的双轴铜连接。 双端口 10GBaseT iSCSI 模块,带有 TCP 卸载引擎和两个 10GBaseT 以太网端口 双端口 10GbE FCoE 模块,带有两个 10Gb/s 以太网端口和一个 SFP+ 光纤连接或双轴铜缆连接 四端口 6Gb/s SAS V2.0 模块,用于后端连接到 VNX 块存储处理器。 对于 6Gb/s 的标称吞吐量,每个 SAS 端口有四个通道,速度为 24Gb/s。 该模块专为 PCIe 3 连接而设计,可配置为 4x4x6 或 2x8x6。为了将 VNX5200 配置为文件存储或统一存储,它必须与一个或多个 Data Mover 单元串联使用。 VNX Data Mover 机柜 (DME) 的大小为 2U,用于容纳 Data Mover。 Data Mover 使用 2.13GHz 四核 Xeon 5600 处理器,每个 Data Mover 具有 6GB RAM,并且每个 Data Mover 可以管理 256TB 的最大存储容量。 数据移动器机柜可以与一个、两个或三个数据移动器一起运行。 控制站大小为 1U,为数据移动器提供管理功能,包括故障转移控制。 控制台可以与辅助控制台一起部署以实现冗余。 UltraFlex 文件 IO 模块选项包括: 四端口 1GBase-T IP 模块,带有四个用于 Cat45 电缆的 RJ-6 端口 双端口 10GbE Opt IP 模块,带有两个 10Gb/s 以太网端口,可选择 SFP+ 光纤连接或双芯铜缆连接到以太网交换机 双端口 10 GBase-T IP 模块,通过铜缆连接到以太网交换机 四端口 8Gb/s 光纤通道模块,带有光学 SFP 和 OM2/OM3 电缆,可直接连接到固定阵列并提供 NDMP 磁带连接管理和数据服务

Unisphere 合并了快照功能,其中包括自动删除策略的配置选项,该策略在 (1) 指定时间后或 (2) 一旦快照存储空间超过存储容量的指定百分比时删除快照。 VNX 快照可以利用 EMC 的自动精简配置和重定向写入技术来提高速度并降低存储快照的存储要求。 VNX 使用专为相对不活跃的 LUN 和文件设计的块和文件压缩算法,允许其压缩和重复数据消除操作在后台执行,同时降低性能开销。 VNX 的固定块重复数据删除以 8KB 粒度构建,适用于虚拟机、虚拟桌面和测试/开发环境等场景,可以从重复数据删除中获益良多。 可以在池 LUN 级别设置重复数据删除,精简、密集和已删除重复的 LUN 可以存储在单个池中。 Unisphere Central 为多达数千个 VNX 和 VNXe 系统(例如部署在远程和分支机构的系统)提供集中式多机监控。 Unisphere 套件还包括用于存储利用率和工作负载模式的 VNX 监控和报告软件,以促进问题诊断、趋势分析和容量规划。 在虚拟化环境中,VNX5200 可以部署 EMC 的 Virtual Storage Integrator for VMware vSphere 5,用于配置、管理、克隆和重复数据删除。 对于 VMware,VNX5200 为 VAAI 和 VASA 提供 API 集成,在 Hyper-V 环境中,它可以配置为卸载数据传输和文件卸载复制。 EMC Storage Integrator 为 Hyper-V 和 SharePoint 提供配置功能。 EMC Site Recovery Manager 软件也可以在灾难恢复情况下管理故障转移和故障恢复。 从 VNX2 到 VNX5200 的 VNX8000 阵列提供 EMC 新的基于控制器的静态数据加密,名为 D@RE,它在驱动器级别加密所有用户数据。 D@RE 使用 AES 256 加密,并且正在等待 FIPS-140-2 级别 1 合规性验证。 新的支持 D@RE 的 VNX 阵列附带加密硬件,现有的 VNX2 系统可以现场升级以支持 D@RE 并作为后台任务对现有存储进行无中断加密。

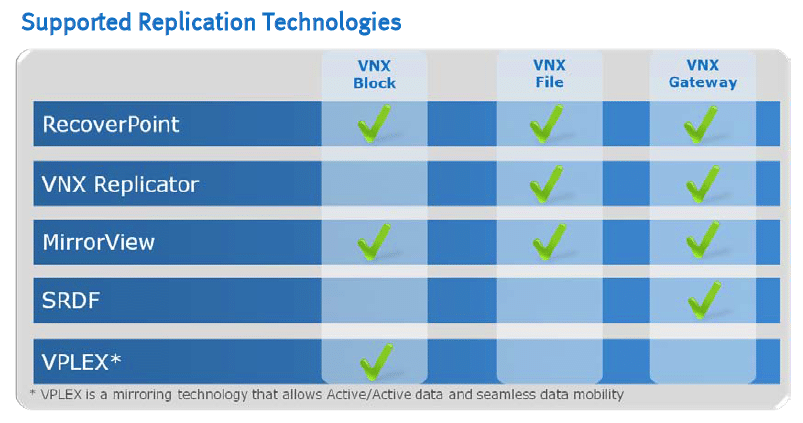

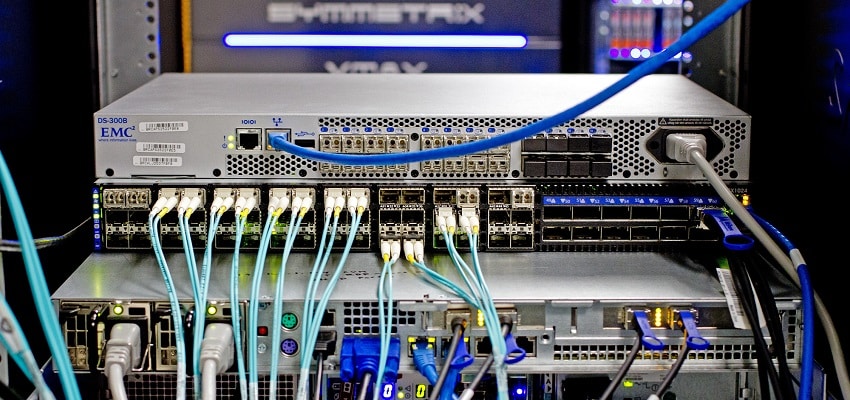

D@RE 使用常规数据路径协议对写入阵列的所有数据进行加密,每个磁盘具有唯一密钥。 如果出于任何原因从阵列中移除驱动器,则驱动器上的信息将无法理解。 D@RE 还包含加密擦除功能,因为它的加密密钥会在删除 RAID 组或存储池时被删除。 VNX2 提供镜像写入缓存功能,其中每个存储处理器都包含其 LUN 的主要缓存数据和对等存储处理器的缓存辅助副本。 RAID 级别 0、1、1/0、5 和 6 可以在同一阵列中共存,系统的主动热备份功能进一步增强了数据保护。 该系统使用集成电池备份单元提供高速缓存降级和其他考虑因素,以便在电源故障期间有序关闭。 本地保护可通过 Unisphere 的时间点快照功能获得,而连续数据保护可通过 RecoverPoint 本地复制获得。 EMC 的 VPLEX 可用于在数据中心内部和跨数据中心扩展连续可用性。 根据 EMC 的说法,它使用电视 DVR 作为其 RecoverPoint Continuous Remote Replication 软件的灵感来源。 Replication Manager 和 AppSync 通过 EMC 备份和恢复解决方案(包括 Data Domain、Avamar 和 Networker)提供应用程序一致的保护,以缩短备份窗口和恢复时间。 测试背景和存储介质 我们发布一个 我们实验室环境的清单,一个 实验室网络能力概述,以及有关我们测试协议的其他详细信息,以便管理员和负责设备采购的人员可以公平地衡量我们取得公布结果的条件。 为了保持我们的独立性,我们的评论都不是由我们正在测试的设备制造商支付或管理的。 与我们通常评估设备的方式相比,EMC VNX5200 评估作为一种相当独特的测试方法脱颖而出。 在我们的标准审查流程中,供应商将平台发送给我们,然后我们将其连接到我们的固定测试平台以进行性能基准测试。 对于 VNX5200,尺寸和复杂性以及初始设置促使我们改变了这种方法并将我们的审核人员和设备飞到 EMC 的实验室。 EMC 准备了一个 VNX5200,其中包含 iSCSI 和 FC 测试所需的设备和选件。 EMC 提供了他们自己的专用 8Gb FC 交换机,而我们带来了我们的 Mellanox 10/40Gb SX1024 交换机之一用于以太网连接。 为了强调系统,我们利用了 EchoStreams OSS1A-1U 服务器,超过了我们在传统实验室环境中使用的硬件规格。 EchoStreams OSS1A-1U 产品规格: 2 个 Intel Xeon E5-2697 v2(2.7GHz,30MB 缓存,12 核) 英特尔 C602A 芯片组 内存 – 16GB (2x 8GB) 1333MHz DDR3 Registered RDIMM Windows Server标准2012 R2的 引导固态硬盘:100GB 美光 RealSSD P400e 2 个 Mellanox ConnectX-3 双端口 10GbE NIC 2 个 Emulex LightPulse LPe16002 Gen 5 光纤通道(8GFC、16GFC)PCIe 3.0 双端口 HBA

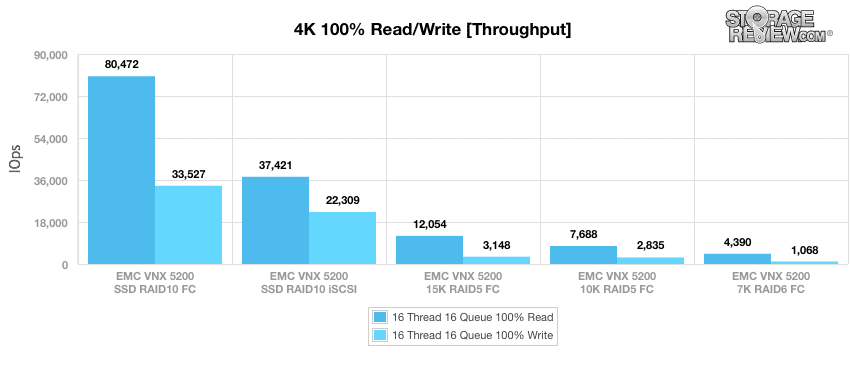

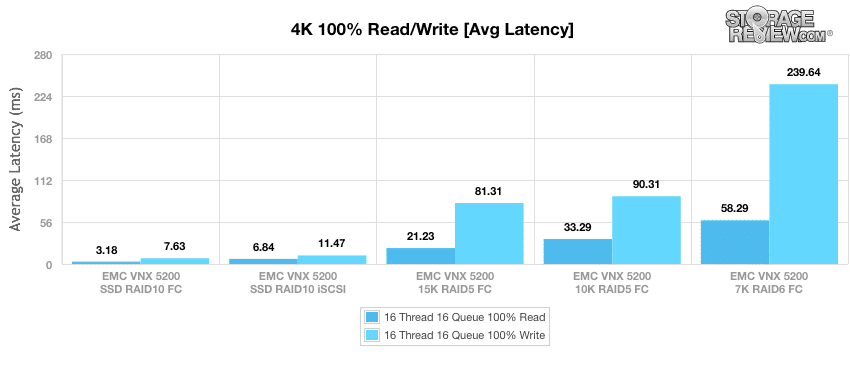

我们对 VNX5200 的评估将比较其在五种配置的综合基准测试中的性能,这些配置反映了 EMC 客户如何在生产环境中部署 VNX2 系统。 每个配置利用 8 个 LUN,大小为 25GB。 由具有光纤通道连接的 SSD 介质组成的 RAID10 阵列 由具有 iSCSI 连接的 SSD 介质组成的 RAID10 阵列 一个 RAID6 阵列,由具有光纤通道连接的 7k HDD 介质组成 一个 RAID5 阵列,由具有光纤通道连接的 10k HDD 介质组成 一个 RAID5 阵列,由具有光纤通道连接的 15k HDD 介质组成。每个配置包含 24 个驱动器,并使用在生产环境中最常见的 RAID 配置。

企业综合工作负载分析 在启动每个 fio 综合基准,我们的实验室在 16 个线程的重负载下将设备预处理到稳定状态,每个线程有 16 个未完成队列。 然后使用多个线程/队列深度配置文件以设定的时间间隔测试存储,以显示轻度和重度使用情况下的性能。 预处理和初级稳态测试: 吞吐量(读+写 IOPS 聚合) 平均延迟(读+写延迟一起平均) 最大延迟(峰值读取或写入延迟) 延迟标准偏差(读+写标准偏差一起平均)该综合分析包含四种配置文件,这些配置文件广泛用于制造商规范和基准测试: 4k 随机 – 100% 读取和 100% 写入 8k 顺序 – 100% 读取和 100% 写入 8k 随机 – 70% 读取/30% 写入 128k 顺序 – 100% 读取和 100% 写入在针对 4k 工作负载进行预处理后,我们对 VNX5200 进行了初步测试。 因此,当配置 SSD 并通过光纤通道访问时,它发布了 80,472 IOPS 读取和 33,527 IOPS 写入。 在 RAID10 中使用相同的 SSD(虽然这次使用我们的 iSCSI 块级测试),VNX5200 实现了 37,421 IOPS 读取和 22,309 IOPS 写入。 使用光纤通道连接切换到 RAID15 中的 5K HDD 显示 12,054 IOPS 读取和 3,148 IOPS 写入,而 10K HDD 配置达到 7,688 IOPS 读取和 2,835 IOPS 写入。 在相同连接类型的 RAID7 配置中使用 6K HDD 时,VNX5200 发布了 4,390 IOPS 读取和 1,068 IOPS 写入。

结果在平均延迟方面大致相同。 当在 RAID10 中配置 SSD 并使用光纤通道连接时,它显示读取时间为 3.18 毫秒,写入时间为 7.63 毫秒。 在我们的 iSCSI 块级测试中使用相同的 SSD,VNX5200 拥有 6.84 毫秒的读取时间和 11.47 毫秒的写入时间。 使用光纤通道连接切换到 RAID15 中的 5K HDD 显示平均延迟为 21.23ms 读取和 81.31ms 写入,而 10K HDD 配置显示 33.29ms 读取和 90.31ms 写入。 在相同连接类型的 RAID7 配置中切换到 6K HDD 时,VNX5200 读取时间为 58.29 毫秒,写入时间为 239.64 毫秒。

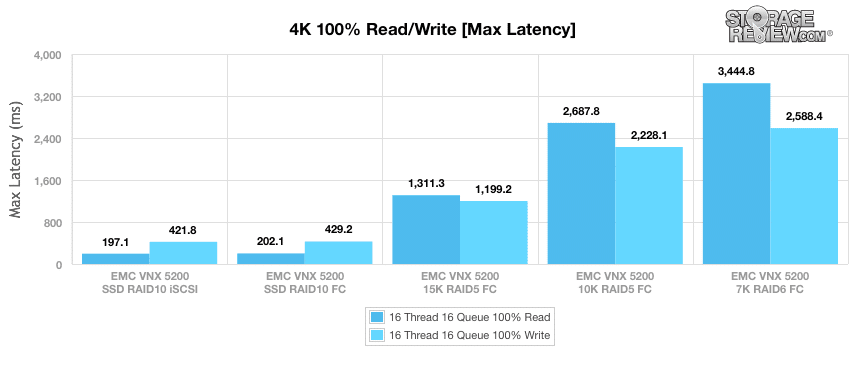

接下来,我们转到最大延迟基准。 当在 RAID10 中配置 SSD 并使用我们的 iSCSI 块级测试时,它显示读取时间为 197 毫秒,写入时间为 421.8 毫秒。 使用相同的 SSD,虽然这次是光纤通道连接,但 VNX5200 拥有 202.1 毫秒的读取时间和 429.2 毫秒的写入时间。 使用光纤通道连接切换到 RAID15 中的 5K HDD 时,读取时间为 1,311.3ms,写入时间为 1,199.2ms,而 10K HDD 配置的读取时间为 2,687.8ms,写入时间为 2,228.1ms。 在相同连接类型的 RAID7 配置中切换到 6K HDD 时,VNX5200 读取时间为 3,444.8 毫秒,写入时间为 2,588.4 毫秒。

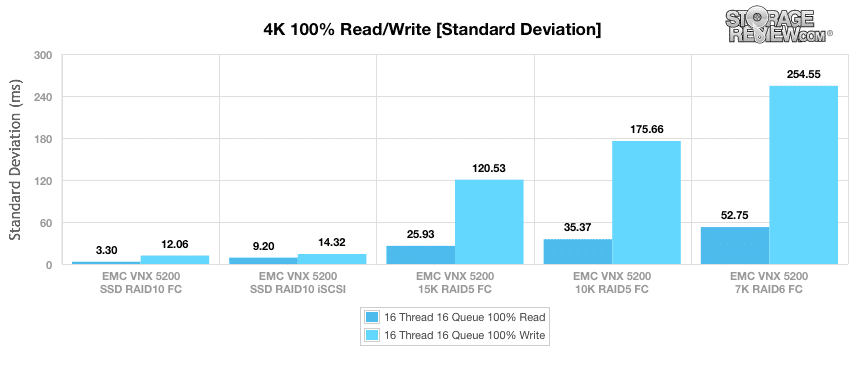

我们最后的 4K 基准是标准差,它衡量的是画面的一致性 VNX5200的性能. 当使用我们的 iSCSI 块级测试在 RAID10 中配置 SSD 时, VNX5200 发布 3.30ms 读取和 12.06ms 写入。 使用具有光纤通道连接的相同 SSD 显示读取时间为 9.20 毫秒,写入时间为 14.32 毫秒。 切换到具有光纤通道连接的 RAID15 中的 5K HDD 记录了 25.93ms 读取和 120.53ms 写入,而 10K HDD 配置记录了 35.37ms 读取和 175.66ms 写入。 使用相同连接类型的 7K HDD RAID6 配置时,VNX5200 的读取时间为 52.75 毫秒,写入时间为 254.55 毫秒。

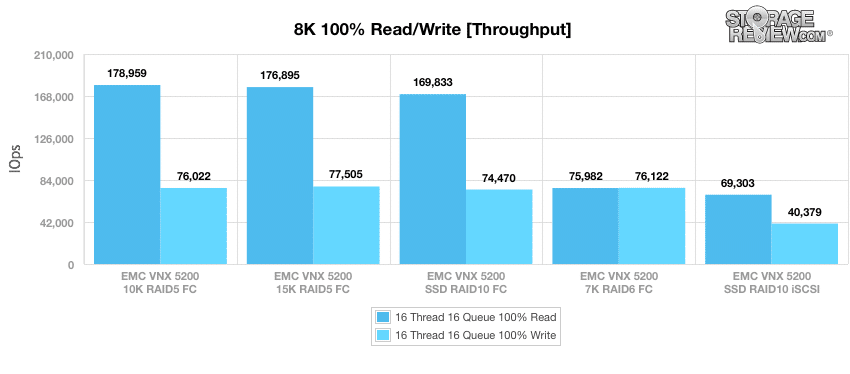

我们的下一个基准测试使用由 100% 读取操作和 100% 写入操作组成的顺序工作负载,传输大小为 8k。 此处,当在 RAID5200 光纤通道连接中配置 178,959K HDD 时,VNX76,022 读取 IOPS 为 10,写入 IOPS 为 5。 在具有光纤通道连接的 RAID15 中使用 5K HDD 显示 176,895 IOPS 读取和 77,505 IOPS 写入。 使用光纤通道连接切换到 RAID10 中的 SSD 记录了 169,833 IOPS 读取和 74,470 IOPS 写入,而 SSD iSCSI 块级测试显示 69,303 IOPS 读取和 40,379 IOPS 写入。 在具有光纤通道连接的 RAID7 配置中使用 6K HDD 时,VNX5200 发布了 75,982 IOPS 读取和 76,122 IOPS 写入。

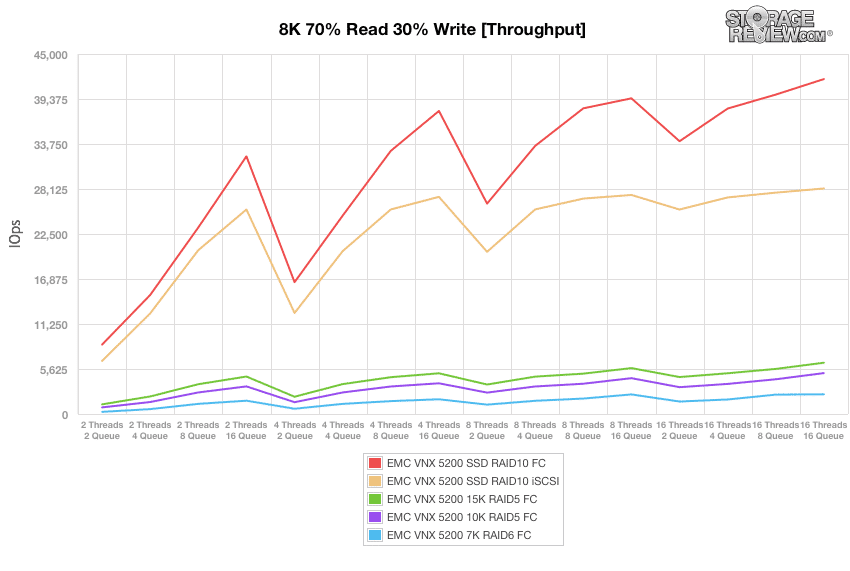

我们的下一系列工作负载由 8k 读取 (70%) 和写入 (30%) 操作混合组成,最多 16 个线程 16 个队列,我们的第一个是吞吐量。 当使用光纤通道连接在 RAID10 中配置 SSD 时,VNX5200 发布了一系列 8,673 IOPS 至 41,866T/16Q 16 IOPS. 在我们的 iSCSI 块级测试期间使用相同的 SSD 显示了一系列 6,631 IOPS 至 28,193 IOPS. 在 RAID15 中切换到具有光纤通道连接的 5K HDD 记录了一系列 1,204 IOPS 和 6,411 IOPS,而 10K HDD 配置在 826T/5,113Q 下发布了 16 IOPS 和 16 IOPS。 当使用相同连接类型的 7K HDD RAID6 配置时,VNX5200 公布了 267 IOPS 到 2,467 IOPS 的范围。

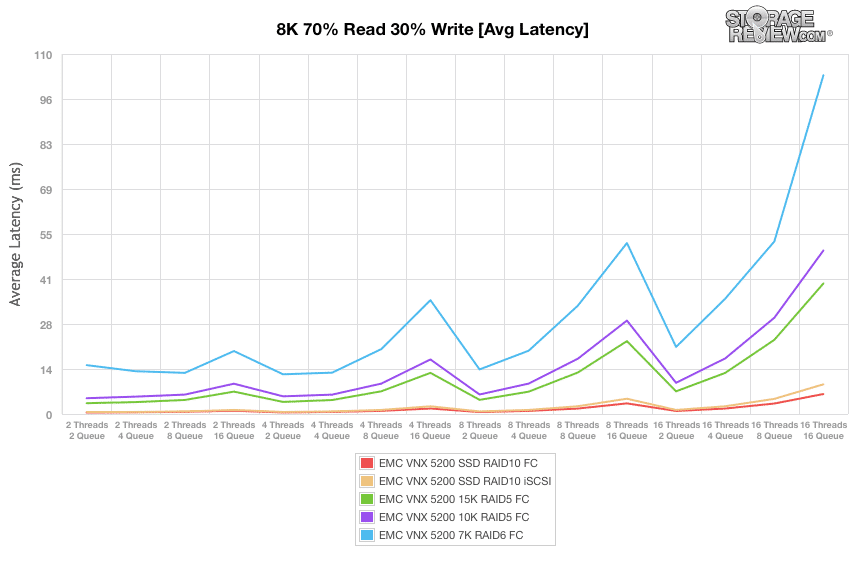

接下来,我们查看了平均延迟。 当使用光纤通道连接在 RAID10 中配置 SSD 时,VNX5200 发布的 0.45T/6.11Q 范围为 16 毫秒至 16 毫秒。 在我们的 iSCSI 块级测试期间使用相同的 SSD 显示范围为 0.59 毫秒到 9.07 毫秒。 在具有光纤通道连接的 RAID15 中切换到 5K HDD 记录的范围为 3.31ms 和 39.89ms,而 10K HDD 配置最初为 4.83ms,49.97T/16Q 为 16ms。 使用相同连接类型的 7K HDD RAID6 配置时,VNX5200 发布的范围为 14.93 毫秒至 103.52 毫秒。

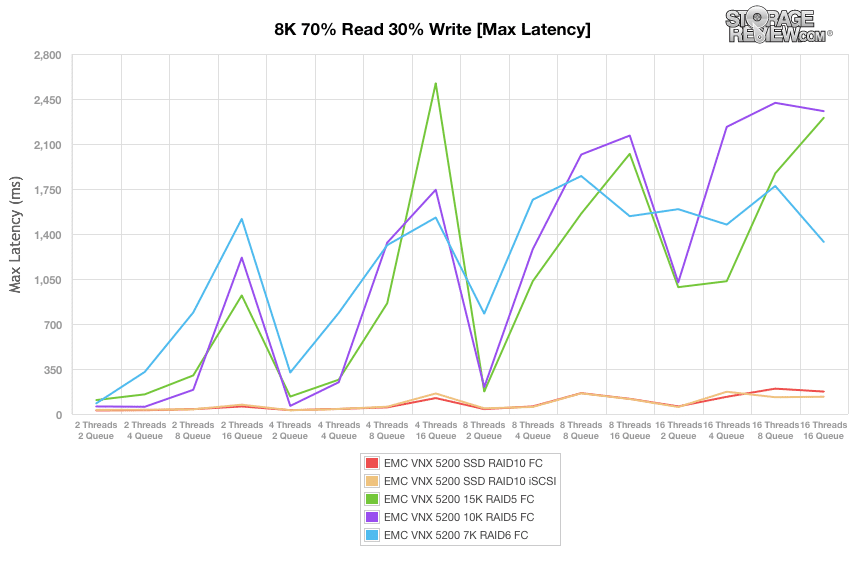

查看其最大延迟结果,当使用光纤通道连接在 RAID10 中配置 SSD 时,VNX5200 的 27.85T/174.43Q 范围为 16 毫秒至 16 毫秒。 在我们的 iSCSI 块级测试期间使用相同的 SSD 显示最大延迟范围为 31.78 毫秒至 134.48 毫秒。 在具有光纤通道连接的 RAID15 中切换到 5K 硬盘驱动器记录的范围为 108.48 毫秒和 2,303.72 毫秒,而 10K 硬盘驱动器配置显示 58.83T/2,355.53Q 为 16 毫秒和 16 毫秒。 使用相同连接类型的 7K HDD RAID6 配置时,VNX5200 发布的最大延迟范围为 82.74 毫秒至 1,338.61 毫秒。

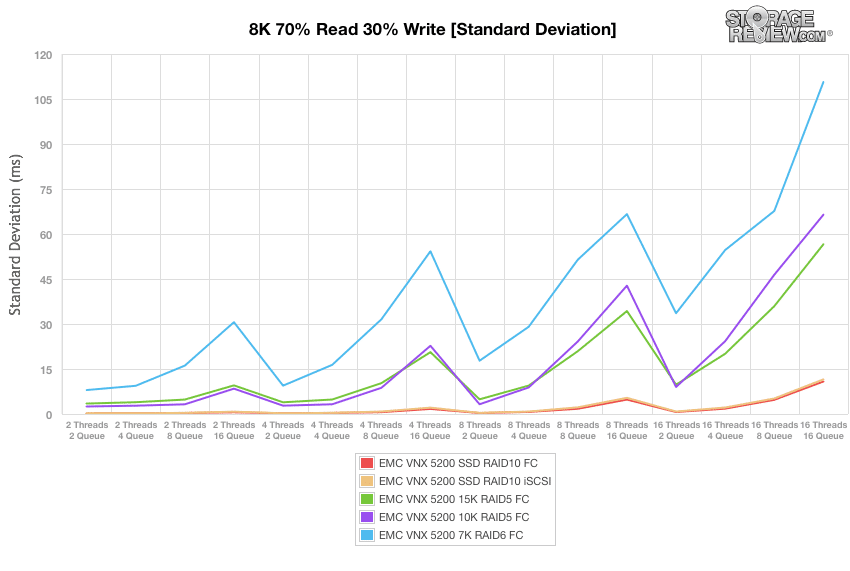

我们的下一个工作负载分析 8k 70% 读取和 30% 写入操作的标准偏差。 在使用光纤通道连接的 RAID10 中使用 SSD,VNX5200 通过 0.18T/10.83Q 公布的范围仅为 16 毫秒至 16 毫秒。 在我们的 iSCSI 块级测试期间使用相同的 SSD 显示延迟一致性的相似范围为 0.21 毫秒到 11.54 毫秒。 在具有光纤通道连接的 RAID15 中切换到 5K 硬盘记录了 3.48 毫秒到 56.58 毫秒的范围,而 10K 硬盘配置最初显示为 2.5 毫秒,66.44T/16Q 为 16 毫秒。 当使用相同连接类型的 7K HDD RAID6 配置时,VNX5200 发布的标准偏差范围为 7.98 毫秒至 110.68 毫秒。

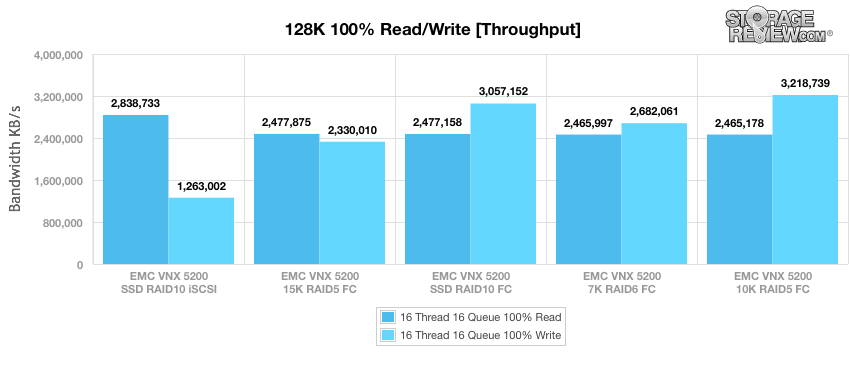

我们最终的综合基准测试使用顺序 128k 传输和 100% 读取和 100% 写入操作的工作负载。 在此场景中,在使用我们的 iSCSI 块级测试配置 SSD 时,VNX5200 的读取速度为 2.84GB/s,写入速度为 1.26GB/s。 在具有光纤通道连接的 RAID15 中使用 5K HDD 显示 2.48GB/s 读取和 2.33GB/s 写入。 切换回 RAID10 中的 SSD(这次使用光纤通道连接),它记录了 2.48GB/s 的读取速度和 3.06GB/s 的写入速度。 当在具有光纤通道连接的 RAID7 配置中使用 6K HDD 时,VNX5200 的读取速度为 2.47GB/s,写入速度为 2.68GB/s,而 10K HDD 配置的读取速度为 2.47GB/s,写入速度为 3.22GB/s。

结论 EMC 的 VNX 生态系统在企业存储市场中已经确立,但 VNX2 反映了该公司彻底改革 VNX 架构以充分利用处理器、闪存和网络技术的进步的意愿。 很像 VNXe3200,面向较小的部署,VNX5200 还表明 EMC 正在关注中端市场公司和远程/分支机构,它们可能无法证明 VNX 系列中大型系统的费用是合理的,但仍希望获得所有企业优势.

与 FAST Suite 结合使用,VNX5200 能够同时提供闪存缓存和分层,这是 EMC 同行难以与之竞争的组合。 在我们的测试中,我们打破了常见的存储层和配置,以通过有限的测试套件说明用户对 5200 的期望。测试涵盖 7K HDD 和 SSD,说明系统具有的灵活性,提供容量、性能、或两者都通过各种接口选项。 最终,VNX2 平台几乎可以处理任何问题; 正是这种灵活性赢得了每天的 EMC 交易。 考虑到存储选项、IO 模块和 NAS 支持的混合,系统能够管理组织可能需要的几乎所有内容。 当然,有些用例超出了我们在这里测试的 5200。 VNX 系列扩展了很多(使用 VNXe3200 也缩小了一些)以满足这些需求,无论是使用更多的计算能力、闪存分配还是磁盘架。 优点 通过 UltraFlex I/O 模块提供多种连接选项 支持块、文件、统一存储场景的配置 访问强大的 VNX 管理工具和第三方集成生态系统缺点 最大 600GB 的 FAST Cache底线 EMC VNX5200 是其新一波统一存储阵列的重要成员,这些阵列的架构旨在利用闪存存储、多核 CPU 和现代数据中心网络环境。 它的经济性、配置灵活性以及对 VNX2 管理软件和第三方集成的访问权限为中端市场打造了一个强大的整体包。 EMC VNX5200 产品页面 讨论这篇评论 |

【本文地址】

今日新闻 |

推荐新闻 |

EMC 的 VNX5200 存储控制器是该公司 VNX2 产品的入口点,具有块存储以及可选文件和统一存储功能。 VNX5200 最多可管理 125 个 2.5 英寸或 3.5 英寸 SAS 和 NL-SAS 硬盘驱动器和 SSD,并采用 EMC 的 MCx 多核架构构建。 StorageReview 企业测试实验室主任 Kevin O'Brien 最近前往位于马萨诸塞州霍普金顿的 EMC 数据中心进行了一些实际操作和 VNX5200 基准测试。

EMC 的 VNX5200 存储控制器是该公司 VNX2 产品的入口点,具有块存储以及可选文件和统一存储功能。 VNX5200 最多可管理 125 个 2.5 英寸或 3.5 英寸 SAS 和 NL-SAS 硬盘驱动器和 SSD,并采用 EMC 的 MCx 多核架构构建。 StorageReview 企业测试实验室主任 Kevin O'Brien 最近前往位于马萨诸塞州霍普金顿的 EMC 数据中心进行了一些实际操作和 VNX5200 基准测试。

VNX 系列使用 EMC 的 Unisphere 管理软件。 我们对 Unisphere 的总体印象是,它提供了一个干净且组织良好的界面,IT 通才可以访问它,同时还允许经验丰富的存储管理员访问系统的全部功能。

VNX 系列使用 EMC 的 Unisphere 管理软件。 我们对 Unisphere 的总体印象是,它提供了一个干净且组织良好的界面,IT 通才可以访问它,同时还允许经验丰富的存储管理员访问系统的全部功能。